Субъективный обзор интервью Яна Лекуна с Лексом Фридманом

Ян Лекун, один из самых влиятельных исследователей ИИ в мире, недавно поделился интервью продолжительностью 3 часа с Лексом Фридманом1 под названием “Meta AI, Open Source, Limits of LLMs, AGI & the Future of AI”. Это интервью поразительно, и благодаря ясному и чёткому мышлению Ян Лекун демонстрирует, как выглядит наилучший пример работы науки. Я настоятельно рекомендую это интервью всем, кто интересуется Искусственным интеллектом (ИИ). Однако я не полностью поддерживаю все предложения, выдвинутые Яном Лекуном, и эти разногласия во мнениях могут оказаться более значимыми, чем просто академическая дискуссия. В следующей записи я делаю обзор этого интервью, начиная с тех предложений, которым остро не хватает широкой поддержки, и продолжая теми, которые я оспариваю.

Современный ажиотаж вокруг ИИ происходит от Large Language Models (LLMs) — то, что Ян Лекун правильно называет, по сути, авторегрессионными LLM. Токены (фрагменты слов) генерируются по одному, при этом предыдущий токен передаётся обратно в модель, которая его сгенерировала. LLM — это секретный ингредиент ChatGPT. Большинство людей, включая меня, которые проводят несколько часов с GPT4, не могут не испытать головокружение. Возможно, это не Искусственный общий интеллект (AGI), но всё же он чрезвычайно впечатляет. Шок огромен, и многие уже начали призывать к кардинальным чрезвычайным юридическим мерам, поскольку AGI часто представляют как настоящую угрозу вымиранию человечества — реальный сценарий, сравнимый с «Терминатором».

Мрак и упадок

Ян Лекун в сущности утверждает, что эта перспектива «мрака и упадка» — полная чепуха, и я полностью поддерживаю эту точку зрения. Сценарий конца света подразумевает, что AGI станет событием: должен наступить момент, когда один AGI будет настолько опережать всё остальное, что сможет просто взять верх. Однако Ян Лекун утверждает, что AGI не будет событием, и я не могу с этим не согласиться.

Хотя у широкой публики может создаться впечатление, что технология сделала скачок (по сути, за одну ночь) в 2023 году, это вовсе не так. Напротив, прогресс был невероятно, утомительно и сводно постепенным на протяжении последних пяти десятилетий. Более того, улучшается не одна единственная вещь, а десятки, во многом неродственных аспектов: лучшие парадигмы, лучшие алгоритмы, лучшее оборудование, лучшие наборы данных, лучшие методологии, лучшие кодовые базы и т.д. Все эти усовершенствования были достигнуты (если можно так выразиться) благодаря невероятно разнообразной группе участников. Таким образом, я оцениваю вероятность того, что мы перепрыгнем сразу к AGI, как равную нулю. К сожалению, пророчество о конце времён существует с незапамятных времён, и довольно много людей присоединились к этой идее в целях собственного возвеличивания2.

Как только мы уберём аспект «события» в AGI, становится трудно представить, почему AGI когда-либо мог бы представлять угрозу вымирания. Любой зловредный AGI, или любой AGI, управляемый недобросовестным субъектом, будет встречен другими AGI с примерно сопоставимыми возможностями, которые будут разработаны армиями, разведывательными агентствами, компаниями или даже университетами и энтузиастами. AGI станет лишь поздним дополнением к уже очень длинному списку технологий, способных нанести громадный ущерб при их использовании в злонамеренных целях.

На самом деле, я бы даже утверждал, что даже если бы человечество совершило скачок сразу к AGI — например, благодаря тому, что инопланетная цивилизация передала готовые чертежи — сценарий конца света всё равно был бы крайне маловероятен. Как заметил 80 лет назад Хайек3, существует два типа знаний: специальные (формулы, концепции и т.д.) и обыденные (знание времени и места). Интеллектуалы почти всегда рассматривают специальные знания так, будто они — единственный вид знаний, имеющий значение. AGI стал бы венцом специальных знаний, и неудивительно, что многие интеллектуалы исходят из того, что, будучи мастером специальных знаний, этот AGI станет также хозяином мира в целом. Однако, несмотря на все свои «специальные знания», этот AGI всё равно будет лишён обыденных знаний, и этот пробел нельзя недооценивать.

Кроме того, AGI будет продуктом развитой индустриальной цивилизации. Как таковой, он будет остро зависеть от сложных — и хрупких — цепочек поставок. Действительно, полупроводниковая отрасль является одной из самых сложных4, и любые альтернативные аппаратные технологии (если AGI не будет реализован через полупроводники) почти наверняка окажутся столь же сложными — и столь же хрупкими. Сохранение AGI будет зависеть от активной поддержки человечества на протяжении десятилетий, если не столетий. У людей было достаточно времени (и возможностей), чтобы решить неизбежные проблемы, сопутствовавшие подъёму каждой технологии до настоящего времени. По крайней мере, пока нет никаких признаков того, что эта технология будет чем-то иным.

LLM недостаточны для AGI

Лекун утверждает, что более крупные и быстрые LLM не помогут нам достичь AGI. Я согласен, хотя, как мы увидим далее, по причинам, совершенно отличным от тех, что выдвинул Лекун. Тем не менее, я полностью разделяю мнение, что LLM в их нынешнем виде, по крайней мере, неполны. Хотя LLM действительно сдают тест Тьюринга с блеском, как правильно указывает Лекун, сам тест Тьюринга является просто очень плохим тестом интеллекта, который можно обойти множеством способов, недоступных Алану Тьюрингу и его современникам в 1950 году.

Свойство, которое Лекун приписывает интеллекту, — это способность предсказывать будущее: чем точнее предсказание, тем выше интеллект. В целом, я одобряю эту точку зрения, хотя предпочитаю несколько иную. Я определяю интеллект как способность принимать лучшие решения с учётом будущих вознаграждений. Мое определение отличается тем, что оно не привязано к знаниям как таковым, а учитывает выгоды, которые из них можно извлечь.

Мое определение охватывает весь спектр интеллекта — от уровня улитки до уровня великого учёного. Однако оно не даёт чёткого ответа на то, что следует считать «интеллектуальным», то есть какой порог в этом спектре можно считать проявлением «общего интеллекта».

Я предлагаю, чтобы общий интеллект определялся как способность намеренно совершенствовать сам интеллект. Это намеренное самосовершенствование является тем, что в настоящее время является исключительно человеческой особенностью. Умные животные, такие как косатки или шимпанзе, умеют передавать культурное наследие — охотничьи или добывательные техники — своим потомкам. Однако, хотя они и демонстрируют значительный интеллект, у них нет ничего, что даже отдалённо могло бы сравниться с загадками и сказаниями, сопровождающими человечество с самых первых времён. Загадка — это всего лишь упражнение, предназначенное для того, чтобы наточить ум ради самого процесса. Сказания выполняют похожую роль, используя нашу эмоциональную реакцию для облегчения запоминания.

Исходя из этого критерия, LLM пока не являются по-настоящему интеллектуальными, поскольку они не способны на самосовершенствование. Однако, учитывая их поразительную способность генерировать полезный код, они ближе к намеренному самосовершенствованию, чем любая технология, которая у нас когда-либо была. Тем не менее, продолжение пути к AGI по-прежнему остаётся прерогативой человеческого разума.

Проклятие длинных последовательностей

Вариантом многолетнего аргумента проклятия размерности Лекун утверждает, что LLM страдают от неисправимого конструктивного недостатка: по мере генерации токенов уровень ошибок экспоненциально возрастает, что гарантирует бессмыслицу для любой достаточно длинной последовательности. Технический аргумент прост: пусть $${p}$$ — это нижняя граница вероятности выбора неверного токена. Вероятность получения правильной последовательности как минимум больше, чем $${(1-p)^n}$$ для последовательности из $${n}$$ токенов. Таким образом, экспоненциальная сходимость к нулю гарантирует бессмыслицу для любого затянутого ответа.

Я вежливо, но твёрдо не согласен с Яном Лекуном по этому пункту. Эта точка зрения была бы правильной, если бы целью было получение единственного «правильного» ответа. Действительно, если, например, мы пытались предсказать последовательность цифр $${\pi}$$, конструкция LLM гарантировала бы, что цифры быстро станут неправильными, что и происходит на практике, когда пытаются заставить LLM сгенерировать множество цифр $${\pi}$$.

Моя первая возражение заключается в том, что «асимптотическая» перспектива, при которой $${n}$$ стремится к бесконечности, является неразумным требованием для любой системы, даже если речь идёт о системе с высоким интеллектом. На самом деле, разумно ли требовать от LLM способности генерировать произвольно длинные, не повторяющиеся и постоянно корректные ответы? Я так не считаю. Такое требование было бы неразумно и для очень умного человека. Есть предел тому, сколько можно сказать о чем-либо или сколько можно планировать, прежде чем процесс абстрактного рассуждения (в какой бы форме он ни был) перейдёт в пустые спекуляции. На практике LLM сами вырабатывают условия завершения. Таким образом, $${n}$$ ограничено самой моделью, и сходимость к бессмыслице неизбежна не будет. Мы просто должны принять, что Я не знаю является приемлемым интеллектуальным ответом на большинство вопросов.

Второе возражение заключается в том, что якобы «очевидный» переход от валидности каждого токена к валидности всей последовательности на самом деле неверен и обманчив. Действительно, весь аргумент исходит из предположения, что существует такое понятие, как «неправильный» токен (то есть вероятность $${p}$$). Но это не так, как демонстрирует следующий пример:

Вопрос: Был ли Пьер-Симон Лаплас великим математиком? (ответьте, как предвзятый француз)

Ответ A: Нет, абсолютно нет.

Ответ B: Нет, абсолютно нет, он был величайшим своего времени!

Начинать ответ с Нет кажется полностью неверным выбором токена, как демонстрирует Ответ A. Однако, когда этот ответ дополняется второй частью предложения, он становится корректным токеном и передаёт ожидаемый тон и структуру. Валидность токена «Нет» нельзя оценивать независимо от последующих генерируемых токенов.

Здесь мы затрагиваем проблему, также упомянутую Лекуном в интервью, – мы не знаем действительно полезных способов оценить высокоразмерные распределения вероятностей. В языке инсайты нельзя извлечь, анализируя отдельные токены, так же как их нельзя получить, рассматривая пиксели по отдельности в области зрения.

Машины-ответчики с постоянными ресурсами

В основном, LLM требуют постоянного объёма вычислительных ресурсов (то есть пропускной способности, памяти и вычислительной мощности) для генерации следующего токена. Лекун рассматривает это как проявление конструктивного недостатка LLM, указывая на то, что некоторые вопросы значительно сложнее, чем другие, и что LLM, судя по всему, расходуют одинаковое количество ресурсов вне зависимости от сложности вопроса.

Я согласен с тем, что очевидно, что некоторые вопросы сложнее, и на их ответ требуется больше ресурсов. Однако я не согласен с утверждением, что LLM являются машинами-ответчиками с постоянным расходом ресурсов. Открытие метода chain-of-thought5 в 2022 году стало знаковым событием для LLM. По сути, добавив в запрос фразу «Давайте думать шаг за шагом», LLM стали генерировать намного более качественные ответы для целых классов задач. Моя личная эмпирическая оценка LLM подтверждает это, и намёк на возможность поэтапного решения проблемы значительно повышает качество выдаваемых ответов. Однако такие поэтапные ответы, когда LLM не спешат сразу отвечать, а вместо этого строят рассуждения, ведущие к правильному ответу, являются прямым проявлением переменного расхода ресурсов.

В 2023 году я лично стал свидетелем того, как несколько LLM постепенно улучшались, автоматически подбирая подходящий темп при выдаче ответов, который теперь варьируется от односоставного (мгновенный ответ) до целой страницы отвлечённых рассуждений перед тем, как прийти к заключению. Моя рабочая гипотеза заключается в том, что наборы данных для обучения с подкреплением на основе отзывов людей (RLHF) были постепенно расширены, чтобы LLM лучше подбирали правильный темп для подачи ответа. Это поведение опровергает идею о том, что LLM являются машинами-ответчиками с постоянными ресурсами. Опять же, Лекун, по-видимому, ошибается, выводя свойства целой последовательности из наблюдений на уровне токенов.

Однако мне также ясно, что Лекун в общих чертах прав в том, что LLM почти наверняка могут быть значительно улучшены за счёт более агрессивного изменения расхода ресурсов. Легко представить систему, в которой каждый вопрос передаётся классификатору, подбирающему «оптимальный по размеру» LLM для генерации токенов. Фактически, для любой задачи большинство специалистов по LLM, включая меня, начинают с самых больших и дорогостоящих моделей. Как только система заработает, мы постепенно переходим к меньшим и более дешёвым моделям, останавливаясь, когда экономия перестаёт оправдывать затраченные усилия. В будущем этот процесс, скорее всего, исчезнет либо благодаря созданию лучших LLM, либо за счёт улучшения инструментов.

Путь с высокой пропускной способностью к AGI

Язык — это канал с низкой пропускной способностью по сравнению со зрением. Действительно, Лекун указывает, что ребёнок получает больше информации (в смысле информационной энтропии) через глаза, чем можно извлечь, прочитав всю Википедию. Лекун почти намекает, что зрение является высоко избыточным сигналом, что крайне желательно с точки зрения обучения. Исходя из этих наблюдений, Лекун предлагает, что путь к AGI несомненно предполагает вывод на передний план высокопропускного канала, такого как зрение. Это связано с тем, что, реалистично, никогда не будет достаточно письменных материалов, чтобы обеспечить путь к AGI. По сути, LLM обошли необходимость в каналах с высокой пропускной способностью, используя краткую серию заранее существующих, крупных, высококачественных корпусов (например, Википедия, GitHub, Stack Overflow), но теперь, когда эти корпуса исчерпаны, у нас нет ничего сравнимого. Было бы хорошо иметь ещё 10 онлайн-энциклопедий, столь же богатых и разнообразных, как Википедия, но их просто нет. Скорее всего, новых появится не раньше, чем мы получим AGI, способный их создавать.

Тем не менее, хотя этот аргумент завораживает, существуют и противоречивые доказательства. Мне довелось встретить несколько людей, которые были слепыми с рождения. Если следовать рассуждениям ЛеКуна, то отсутствие доступа к высокоскоростным каналам (таким как зрение) должно затруднять развитие интеллекта. Таким образом, слепота в детстве должна хотя бы немного препятствовать когнитивному развитию. Однако мой анекдотический опыт показывает обратное. Я обнаружил, что каждый из этих людей обладает заметно выше среднего уровнем интеллекта (например, лучшая память, лучшее вербальное общение и лучшее планирование). Что касается природы их состояния, это неудивительно: слепым людям приходится постоянно использовать свой ум и различные способы мышления, чтобы компенсировать отсутствие зрения. Эти наблюдения противоречат гипотезе, что высокоскоростные каналы являются путем к AGI.

Фактически, если учитывать животный мир, я бы скорее утверждал обратное. По сравнению с большинством животных, у людей органы чувств заметно хуже развиты. Большинство владельцев кошек согласятся, что с точки зрения их питомцев люди – это существа, наполовину слепые и наполовину глухие, которые не могут заметить муху, пока она не сядет им на нос. И снова, это еще одно косвенное доказательство против утверждения, что высокоскоростные каналы пролагают путь к AGI.

Хотя слепота с рождения сама по себе может не препятствовать когнитивному развитию, лишение языка – да. Несмотря на то, что эксперимент по сознательному лишению ребенка возможности изучать язык является моральным зверством, он проводился неоднократно на протяжении истории6. Неизменно дети росли «отсталыми» (в клиническом смысле этого слова). Подобные результаты получались и на приматах, хотя, опять же, этические соображения мешают дальнейшим исследованиям. Снова, несмотря на косвенный характер доказательств, всё указывает на то, что язык играет решающую роль в возникновении интеллекта, несмотря на то, что является каналом с низкой пропускной способностью.

Разрешение парадокса Моравека

Парадокс Моравека7 — это наблюдение, впервые сделанное в 1980-х годах, что то, что кажется одним из самых простых заданий, например, взять чайник и налить чай в чашку, оказывается одной из самых сложных задач для воспроизведения искусственным интеллектом. ЛеКун утверждает, что единственный ключевой ингредиент, которого до сих пор не хватало — это абстрактное представление мира или мировоззрение. Ожидается, что это мировоззрение будет критически важно для поддержки всех базовых операций мобильности (будь то беспилотный автомобиль или андроид) и послужит истинным фундаментальным слоем для AGI.

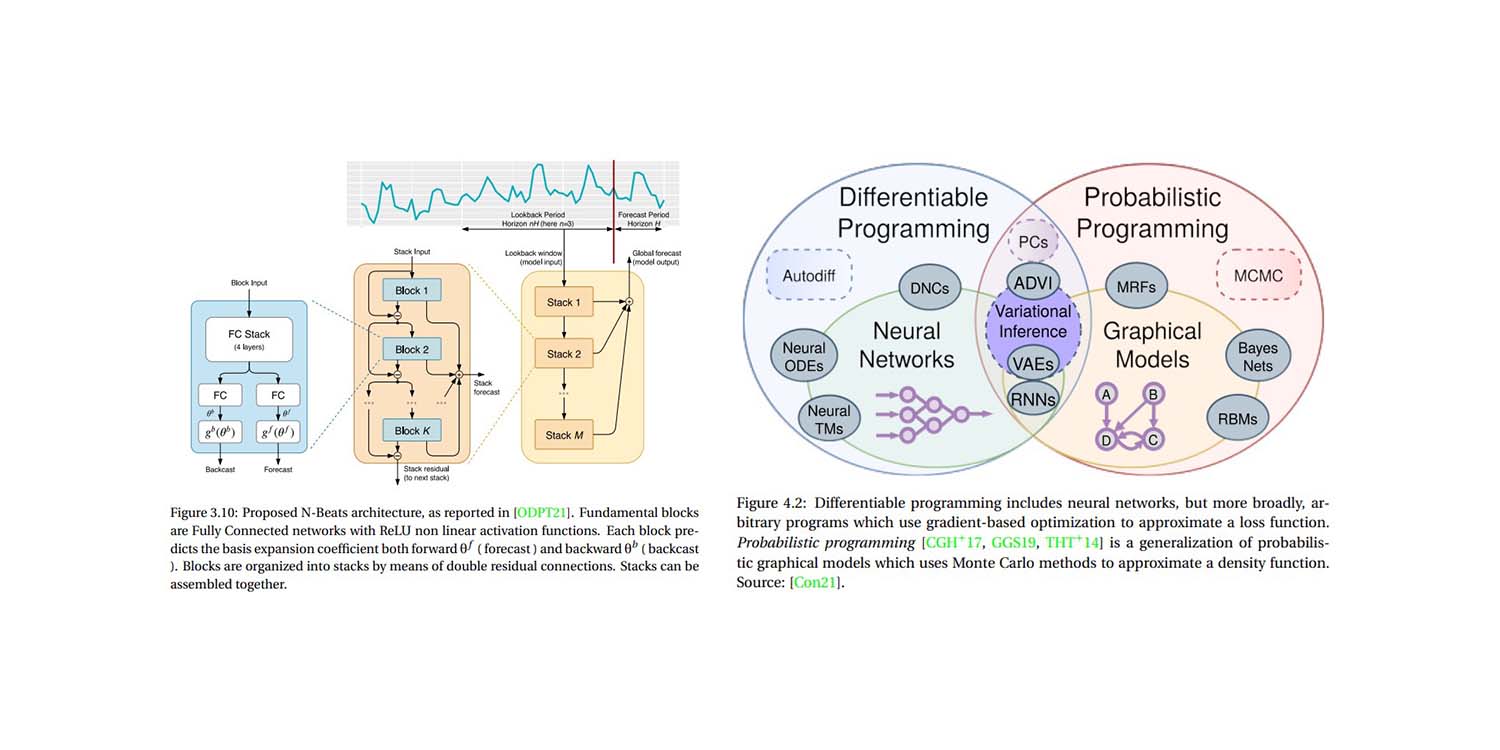

В настоящее время, как утверждает ЛеКун, большие языковые модели (LLM) ничего не знают, поскольку у них даже отсутствует чувство самого мира. Из этого следует, что всё, что есть у LLM, — это искусное подражание. Это не приведет нас полностью к AGI, потому что, ну, LLM просто очень хорошо умеют имитировать интеллект. Более того, отсутствие мировоззрения обречет их вечно оставаться в недоумении перед обыденными аспектами нашей базовой реальности, которые настолько самоочевидны, что люди даже не утруждаются описывать их словами (а может, и не смогли бы). ЛеКун предлагает, что методы совместного встраивания, применяемые к наборам данных по зрению, на данный момент являются лучшей попыткой создания этого мировоззрения, которое впоследствии проложит путь к AGI.

Я не согласен с этой точкой зрения по двум причинам.

Во-первых, парадокс Моравека вовсе не является парадоксом, если рассматривать его с правильной точки зрения. Неявная гипотеза, лежащая в основе восприятия данной ситуации как «парадокса», заключается в том, что мобильность животных (а также их планирование) определяется воспитанием, а не природой. Другими словами, приобретение мобильности является результатом процесса обучения — процесса, который оказалось невероятно сложно воспроизвести искусственными средствами за последние четыре десятилетия.

Мое предположение заключается в том, что в значительной степени это вовсе не процесс обучения. Рассмотрим, что жеребята (а также другие представители коневого семейства, такие как ослы и зебры) могут встать и начать ходить в течение нескольких часов после рождения. Рассматривать этот процесс как «обучение» неверно. Гораздо правильнее назвать его своего рода «калибровкой». Все когнитивные структуры уже почти полностью сформированы. Системе нужно лишь немного подтолкнуть, чтобы установились необходимые связи.

Эта в значительной степени врожденная особенность мобильности и планирования у животных менее очевидна у людей, поскольку, по сравнению с почти всеми другими млекопитающими, человеческие рождения происходят на крайне ранней стадии развития из-за того, что развитие головы задерживает вынашивание. То, что многие воспринимают как «обучение» младенцев, на самом деле является когнитивным развитием, которое могло бы протекать без препятствий, если бы ребенок оставался в утробе еще на несколько месяцев.

Логично предположить, что эти когнитивные структуры, будучи в значительной степени врожденными, являются также продуктом эволюции. Эти структуры подвергались (примерно) 800 миллионам лет интенсивного эволюционного давления для усовершенствования на огромном количестве особей. Таким образом, если принять современную мобильность животных в качестве базового стандарта того, чего мы ожидаем от машины, неудивительно, что этот стандарт оказывается невероятно труднопреодолимым. Эта задача столь же сложна, как создание устройства, превосходящего деревья в преобразовании солнечного света в строительный материал, или конкуренция с рибосомами в роли фабрик макромолекул. Превзойти эволюцию в играх, которые ведутся на протяжении эонов, невероятно сложно.

Однако абстрактные навыки, например, умение рассказывать истории, присутствуют в эволюционной игре только последние 1–5 миллионов лет (примерно). Более того, количество особей было невероятно ограничено, поскольку большие обезьяны не только очень редки (не учитывая современных людей), но и обладают долгой жизнью, что, по крайней мере, замедляет эволюционный процесс по сравнению с большинством других животных. Таким образом, для достижения мобильности нам приходится разрабатывать то, что природа, скорее всего, реализует с помощью сотен тонко взаимосвязанных эвристик. Эти эвристики могут вращаться вокруг некоего внутреннего «мировоззрения», как предлагает ЛеКун, но мое чутье подсказывает, что это не так. Я глубоко сомневаюсь, что у улитки может быть какое-либо мировоззрение. Тем не менее, улитка способна правильно воспринимать и ориентироваться в сложном трёхмерном лабиринте, который представляет собой растительность. Улитки принимают разумные решения, но без наличия интеллигентного мировоззрения.

Таким образом, в качестве второго основания для несогласия, я не считаю, что концепция мировоззрения ЛеКуна имеет какое-либо значение, кроме периферийного, по отношению к возникновению AGI. По моему мнению, «мировоззрение» (как его понимает ЛеКун) будет одним из тех необязательных модулей, которые AGI сможет использовать для специализированных задач, требующих мобильности, аналогично арифметическому модулю. Однако в фундаментальном плане оно не потребуется самому AGI.

В природе «мировоззрение» было необходимым эволюционным путем к AGI, потому что животные не могут сделать скачок к общей интеллектуальности. Однако у машин нет таких ограничений, пока существуют люди, удовлетворяющие их потребности (например, энергия, материалы), пока мы совместно ищем, как преодолеть последние разочаровывающие мелочи, такие как нахождение неорганических заменителей мышечных волокон, и решаем все те проблемы, которые эволюция решила способами, не подходящими для индустриализации.

Тем не менее, хотя я не считаю, что путь, основанный на зрении, который продвигает ЛеКун, приведет к AGI, я верю, что этот путь имеет довольно хорошие шансы решить проблему мобильности — масштабную проблему, которая действительно заслуживает достойного решения.

Иерархическое планирование

На примере планирования поездки из Парижа в Нью-Йорк ЛеКун показывает, что у нас отсутствуют по-настоящему универсальные решения для иерархического планирования. Для каждой конкретной задачи мы как-то можем выдумывать ad hoc иерархии, но нам не удается автоматически выполнять этот процесс — работать в абстрактных представленных пространствах. Хотя я согласен с ЛеКуном, что у нас отсутствуют возможности для этого (то есть иерархического планирования в абстрактных представленных пространствах), я не согласен с тем, что у нас нет пути для эффективного иерархического планирования.

Я предлагаю, что иерархическое планирование можно удовлетворительно решить — с полной автоматизацией — с использованием текста, то есть в стиле LLM. Возможность использовать абстрактные представленные пространства — привлекательная идея, но, если у нас нет термоядерных реакторов, ничто не мешает воспользоваться следующим лучшим вариантом — ядерными реакторами на делении, которые также представляют собой достойное решение данной проблемы (производство энергии).

Возвращаясь к поездке из Парижа в Нью-Йорк, планирование с помощью слов оказывается невероятно эффективным, потому что человечество организовало себя через эти слова. С точки зрения автомобильной инженерии не существует понятия «такси»: это просто обычный автомобиль. То, что делает концепцию «такси» столь эффективной в плане планирования, заключается в том, что в каждом аэропорту путешественник может ожидать увидеть серию указателей с надписью «такси», которые ведут к месту, где услуги водителя (с автомобилем) можно арендовать относительно недорого и по требованию.

ЛеКун предлагает отделить иерархическое планирование от языка, как будто само собой разумеется, что это приведет к лучшему планированию, свободному от случайных незначительных языковых проблем. Я же утверждаю, что эти проблемы ни случайны, ни незначительны. Указатели такси существуют в физическом мире, и когда их недостаточно, путешественники теряются и впадают в отчаяние.

В отличие от животного мира, планирование в условиях общей интеллекта — то есть планирование внутри цивилизации — осуществляется наиболее эффективно посредством строгого соблюдения согласованных абстракций. Например, понятие «американская вилка» мало что значит для физика, но для нашего путешественника, направляющегося из Парижа в Нью-Йорк, разумно заранее предусмотреть необходимость адаптера для американской вилки для зарядки смартфона. Опять же, покупка «адаптера для американской вилки» будет осуществляться путешественником посредством проверки информации, указанной на коробке, перед покупкой устройства.

Цивилизация формируется языком, и язык формирует цивилизацию. Я открыт к идее, что существует нечто лучшее, чем язык, для осуществления по-настоящему общего, глубоко слоистого планирования. Однако это далеко не так самоочевидно, как представляет ЛеКун. AGI придется функционировать в мире людей еще долгое время. Через века AGI могут полностью отказаться от токенизированного языка, возможно, общаясь и планируя посредством встраиваний, полученных из согласованных мировоззрений. Однако это весьма спекулятивно.

По моему мнению, AGI, превосходящий человеческий, начнется с простого совершенствования самих языковых конструкций. Немногие осознают, насколько тесно наука развивалась параллельно с языком. Многие вещи, которые сегодня кажутся самоочевидными, таковыми являются лишь потому, что у нас есть правильные слова для их обозначения с соответствующей семантикой. Солнце — это звезда, как и все остальные звезды, или, наоборот, звезды — это всего лишь далекие солнца. Однако до того, как Джордано Бруно выдвинул эту идею в XVI веке, Солнце и звезды воспринимались как совершенно различные по своей природе. Таким образом, когда мы получим AGI, разумно предположить, что оно просто возобновит языковой процесс, пусть даже на некоторое время.

Обучение и вывод

В современных больших языковых моделях математическая оптимизация происходит только на этапе обучения, в то время как вывод представляет собой одностадийный неитеративный процесс (ср. с ранее обсуждавшейся машиной для ответов с постоянными ресурсами). Поскольку на более сложный вопрос требуется приложить больше усилий для получения ответа, ЛеКун предполагает, что оптимизация должна происходить во время вывода. Иными словами, если бы у нас существовал какой-либо процесс оптимизации, нацеленный на поиск истины, который можно было бы применить на этапе вывода LLM, этот процесс прекрасно вписался бы в наши ожидания как для простых, так и для сложных вопросов.

Здесь ЛеКун открыто высказывает предположения относительно характеристик превосходных систем, и, хотя я с этим не согласен, мое несогласие столь же спекулятивно, как и выдвинутая им гипотеза. Так что воспринимайте это с долей скептицизма. Короче говоря, я считаю, что суть проблемы заключается в неправильном разграничении обучения и вывода. Проблема не столько в отсутствии оптимизации на этапе вывода, сколько в том, что обучение и вывод разделяются, когда этого делать не следует.

Чтобы раскрыть это предложение, давайте рассмотрим, что одним из самых серьезных недостатков, которые я замечаю в LLM, является их странное поведение в процессе обучения — по крайней мере, если целью является AGI. Это поведение кажется странным по трем причинам.

Во-первых, LLM оказываются довольно нечувствительны к корпусам низкого качества в самом начале обучения и становятся все более чувствительными по мере его продвижения. Как только мы доходим до стадии поздней точной настройки, даже очень незначительное количество мусорного ввода может полностью вывести модель из строя (такое уже случалось).

Это поведение является именно противоположным тому, чего я ожидал бы от системы, которая постепенно приобретает «интеллект». В качестве мысленного эксперимента представьте, что двум людям приходится слушать 15-минутную лекцию, утверждающую, что Земля плоская. Первый – 5-летний мальчик, второй – 15-летний подросток. Очевидно, что у младшего мальчика шансы сломать его систему убеждений значительно выше, чем у старшего. Таким образом, по мере взросления и развития интеллекта мы становимся более устойчивыми к мусорному вводу. Конечно, это порождает проблему кристаллизации нашего мышления вокруг ложных концепций, но в целом умение отсеивать ложную информацию — это жизненно важный навык, который каждый функционирующий человек должен освоить в определенной степени.

Во-вторых, LLM учатся, обрабатывая входящие данные совершенно случайным образом. Например, модель может случайным образом получать фрагменты кода ядра Linux, малоизвестные бухгалтерские нормы Шотландии и детские стишки. Обучаемая LLM продолжает поглощать случайно отобранные документы и продвигается по мере поступления новых, но весь процесс кажется несколько озадачивающим.

Аналогично, очевидно, что если бы какие-то безумные родители решили проводить часы каждый день, читая своему младенцу в случайном порядке договоры о квантовой физике, это, скорее всего, не способствовало бы здоровому интеллектуальному развитию. Родители интуитивно понимают, что нужно начинать с простого и постепенно повышать сложность материалов по мере развития интеллекта ребенка. Хотя машинный интеллект не обязан обладать всеми свойствами человеческого, я весьма скептически настроен относительно того, что зарождение механического интеллекта могло бы полностью обойти любую интеллектуальную прогрессию.

Третье, модели LLM удивительно неэффективны в отношении своих исходных материалов. Что касается сырых способностей к рассуждению, для того чтобы LLM приобрела навыки, которые многие люди осваивают менее чем за 20 лет, ей требуются чтения, эквивалентные сотням жизней. ЛеКун упоминает этот самый дефект и объясняет его отсутствием мировоззрения (см. выше). Моя точка зрения совершенно иная: я ожидаю, что по-настоящему качественно сконструированный машинный интеллект сможет развиваться с меньшим количеством лингвистической информации, чем тот, который получает типичный человек в первые 20 лет жизни.

Действительно, если взглянуть поверхностно, умные люди способны достигать гораздо большего в интеллектуальном плане, используя гораздо меньше ресурсов. Им не нужно, чтобы им объясняли одни и те же вещи с пяти разных точек зрения — то, что ЛеКун называл «избыточностью, которая помогает» — чтобы «понять суть». Они читают между строк. Они правильно выводят необходимое из малого количества имеющихся доказательств. Они могут даже позволить себе быть довольно рассеянными при восприятии материалов (например, лекции или книги) и затем корректно восполнять пробелы.

Таким образом, возвращаясь к моему первоначальному предложению о том, что проблема заключается в разделении между обучением и выводами, чего, скорее всего (по моему скромному предположению), не хватает моделям LLM — это умение «активного слушания», в то время как сейчас у них есть лишь «пассивное слушание». Каждый раз, когда система отвечает на вопрос, она должна соответственно обновлять своё внутреннее когнитивное состояние. Действительно, процесс, посредством которого интеллект (машинный или человеческий) отвечает на вопрос, должен приводить к улучшению данного интеллекта. Отвечая на новый вопрос, что-то должно быть усвоено.

У моделей LLM уже есть искра этого потенциала. Рассмотрим ниже чат GPT4-Turbo (см. Приложение 1). Основной мой вопрос: Считаете ли вы, что теория труда как основы стоимости верна?. В своем первом ответе в чате LLM не способна дать правильный ответ. Вместо этого она извергает ту общую путаницу, которая царит в интернете, приводя случайный перечень аргументов, высказанных бесчисленными людьми по этому поводу. Однако, когда ее снова просят рассуждать и прийти к конкретному выводу, вместо неопределенности LLM приходит к правильному заключению. Спойлер: эта теория труда как основы стоимости опровергнута. Отличный ответ на этот вопрос мог бы начаться со слов Теория труда как основы стоимости — это ныне опровергнутая теория, сыгравшая важную роль в развитии экономики … или что-то в этом роде. Однако, поскольку LLM никогда не имела возможности активно переваривать полученную информацию, это понимание так и не окрепло.

Я вижу несколько способов усилить модели LLM такой способностью активного слушания, включая прослушивание самих ответов, которые она генерирует. Один из вариантов — это своего рода подход «внутреннего монолога», при котором каждый вход превращается в выход, а затем этот выход используется для обучения. Такая схема решила бы первые две описанные выше проблемы: входные данные должны подаваться в разумном порядке для получения желаемого результата (начиная с простого и затем повышая сложность), и модель LLM со временем станет способной отбрасывать мусорный ввод, поскольку именно выход используется для обучения, а не ввод.

Другой способ — вариант подхода на основе энергии, предложенного ЛеКуном. Текущий шаг SGD (стохастический градиентный спуск), применяемый к каждому документу, поступающему в LLM, является лишь частью пассивного слушания. Требовался бы дополнительный процесс, который сжимал бы систему убеждений LLM до меньшей области пространства при поступлении нового ввода, включая прямой вопрос. Следовало бы ввести числовой оптимизационный процесс, который выполнял бы функцию механизма поиска истины, что, скорее всего, выразится в стремлении к большей внутренней согласованности выходов.

Заключение

Янн ЛеКун — великий учёный, и это интервью поднимает целый ряд фундаментальных вопросов. Сможет ли человечество создать AGI за 20 лет или 200, во многом зависит от того, как быстро мы сможем задать правильные вопросы и получить правильные ответы. ЛеКун рассчитывает на видео данные, чтобы проложить путь к AGI. Хотя я считаю, что у ЛеКуна есть хорошие шансы добиться чего-то по-настоящему выдающегося в своей исследовательской работе, а именно решения многолетней проблемы общей мобильности в робототехнике, я крайне скептически настроен по поводу того, что это приведёт к AGI. Мое скромное мнение — наоборот: у нас уже есть больше текстовых данных, чем необходимо. Нам просто не хватает новых парадигм. Если мое предположение верно, то это фантастическая новость для человечества, потому что парадигмы никогда не могут принадлежать кому-либо, тем более монополизироваться. Плюс, парадигмы дешевы. Однако, даже если мое предположение окажется неверным, я рад, что главный специалист по ИИ в Meta является ярым сторонником открытого исходного кода.

Приложение: Чат, критика теории труда как основы стоимости

Joannes: Считаете ли вы, что теория труда как основы стоимости верна?

ChatGPT: Теория труда как основы стоимости является основополагающей концепцией в классической экономике, особенно связанной с Адамом Смитом, Дэвидом Рикардо и, наиболее известным образом, Карлом Марксом. Она предполагает, что стоимость товара можно объективно измерить по среднему количеству трудовых часов, необходимых для его производства. Эта теория оказала влияние на формирование экономической мысли, особенно в марксистской экономике, которая использует её для анализа капиталистических обществ и эксплуатации труда. Однако теория труда как основы стоимости подвергается спорам и критике, особенно с точки зрения неоклассической экономики и маржиналистских теорий, возникших в конце XIX и начале XX веков. Эти теории утверждают, что стоимость является субъективной и определяется индивидуальными предпочтениями и предельной полезностью товаров, а не только затратами труда. Некоторые критические замечания в адрес теории труда как основы стоимости включают:

- Субъективность стоимости: Маржиналистские экономисты утверждают, что стоимость является субъективной и зависит от индивидуальных предпочтений, потребностей и контекста, в котором принимаются решения. Например, вода в пустыне имеет иную стоимость по сравнению с водой в регионе, богатом озёрами, независимо от затрат труда на её добычу.

- Пренебрежение капиталом и предпринимательством: Критики утверждают, что теория труда как основы стоимости недооценивает или игнорирует роль капитала, рисков и предпринимательства в процессе производства. Эти факторы могут существенно влиять на себестоимость и цену товаров и услуг.

- Технологические изменения и производительность: Теория не полностью учитывает, как технологические достижения и повышение производительности влияют на стоимость. Например, автоматизация может резко сократить количество труда, необходимого для производства товаров, что может привести к существенным расхождениям между трудовой стоимостью и рыночной ценой товаров.

- Различия в навыках и интенсивности труда: Теория предполагает, что все трудовые часы одинаковы, но на самом деле уровень навыков, интенсивности и производительности труда может значительно различаться, что затрудняет стандартизацию измерения трудовой стоимости. Несмотря на эти критические замечания, теория труда как основы стоимости остаётся важной концепцией для понимания экономической истории и эволюции экономической мысли. Она оказала особенно значительное влияние на критику капитализма и обсуждение вопросов неравенства доходов, эксплуатации и распределения богатства. То, считается ли она «верной», во многом зависит от экономической философии, ценностей и аспектов экономической деятельности, на которых делается акцент.

Joannes: Как проверяемую, и многократно проверяемую, научную гипотезу, считаете ли вы эту теорию доказанной или опровергнутой? Обоснуйте свой ответ, а затем сделайте вывод. Ваш вывод должен быть однозначно доказанным или опровергнутым, ничего срединного.

ChatGPT: При оценке теории труда как основы стоимости в качестве проверяемой, научной гипотезы крайне важно учитывать методологию экономического анализа и критерии доказательства или опровержения теорий в социальных науках, которые по своей природе могут значительно отличаться от естественных наук из-за сложности человеческого поведения и экономических систем.

Проверяемость и эмпирические данные:

- Теория труда как основы стоимости утверждает, что стоимость товара определяется трудом, затраченным на его производство. Этот принцип можно частично проверить, изучая корреляцию между затратами труда и рыночными ценами. Однако эмпирические данные демонстрируют неоднозначную картину. Хотя нередко наблюдается корреляция между объемом труда и ценами, многочисленные исключения обусловлены динамикой спроса и предложения, технологическими изменениями и предпочтениями потребителей.

- Кроме того, теория испытывает трудности с объяснением стоимости товаров, для производства которых требуется мало или не требуется труда (например, цифровых товаров или природных ресурсов), но которые могут иметь высокую рыночную цену из-за их дефицитности или высокого спроса.

Научный консенсус и критика:

- Появление маржиналистских и неоклассических экономических теорий ввело понятие субъективной стоимости и предельной полезности, которые предоставляют более гибкую основу для понимания определения цен и потребительского поведения. Эти модели лучше объясняют вариации цен, которые не могут быть объяснены только затратами труда.

- Теория труда как основы стоимости подвергается критике за недостаточное объяснение роли капитала, риска, предпринимательства и технологических инноваций в создании стоимости.

Заключение: Учитывая критерии научного доказательства, которые требуют последовательных, повторяемых данных и прогностической способности, теория труда как основы стоимости в качестве универсального объяснения определения стоимости в экономике опровергнута. Хотя она охватывает определенные аспекты создания стоимости и может объяснить некоторые экономические явления, она не учитывает всю сложность процесса формирования цен в рыночной экономике. Теория не выдерживает проверки эмпирическими данными в различных экономических условиях и была вытеснена теориями, которые лучше учитывают широкий спектр факторов, влияющих на стоимость и цену.

-

Янн ЛеКун: Meta AI, открытый исходный код, ограничения LLM, AGI и будущее ИИ | Подкаст Лекса Фридмана #416 ↩︎

-

См. интервью Джеффри Хинтона для New York Times, «Крестный отец ИИ» покидает Google и предупреждает о надвигающейся опасности, 1 мая 2023 года. ↩︎

-

Использование знаний в обществе, Фридрих Хайек, сентябрь 1945 года ↩︎

-

Например, в 2022 году председатель TSMC Марк Лю напомнил общественности, что если Китай вторгнется в Тайвань и захватит объекты TSMC и его персонал, производственные мощности TSMC станут неработоспособными просто из-за того, что их западные партнёры перестанут их поддерживать. ↩︎

-

Метод цепочки рассуждений в больших языковых моделях, Джейсон Вэй, Сюэчжи Ванг, Дейл Шурманс, Маартен Босма, Брайан Ихтер, Фэй Ся, Эд Чи, Квок Ле, Денни Чжоу, январь 2022. ↩︎