Отзыв на интервью Янна Лекуна с Лексом Фридманом

Янн Лекун, один из самых влиятельных исследователей ИИ в мире, недавно поделился трехчасовым интервью с Лексом Фридманом1 под названием «Мета ИИ, Открытый исходный код, пределы LLM, ИИ общего интеллекта и будущее ИИ». Это интервью является замечательным, и с его ясным и аргументированным мышлением Янн Лекун демонстрирует, как научное движение выглядит в своей лучшей форме. Я настоятельно рекомендую это интервью всем, кто проявляет интерес к Искусственному Интеллекту (ИИ). Однако я не полностью поддерживаю все предложения, выдвинутые Янном Лекуном, и эти расхождения во мнениях могут оказаться более значимыми, чем просто академический спор. В следующей записи я рассмотрю это интервью, начиная с предложений, которым наиболее необходима широкая поддержка, и продолжу с теми, которые я оспариваю.

Текущий ажиотаж вокруг ИИ происходит от Больших Языковых Моделей (LLMs) - то, что Янн Лекун правильно характеризует как фактически авторегрессивные LLMs. Токены (фрагменты слов) генерируются по одному, обратно подаваясь в модель, которая сгенерировала предыдущий токен. LLMs являются секретным ингредиентом ChatGPT. Большинство людей, включая меня самого, проводя несколько часов с GPT4, не могут не почувствовать головокружение. Это может быть не Искусственный Общий Интеллект (AGI), но это все равно впечатляет. Шок глубокий, и многие начали требовать резких экстренных правовых мер, так как AGI часто представляется как реальная угроза вымиранию для человечества - реальный сценарий Терминатора scenario.

Гибель и Мрак

Янн Лекун в основном утверждает, что эта перспектива «гибели и мрака» - полная ерунда, и я полностью поддерживаю эту позицию. Сценарий конца света требует, чтобы AGI был событием: должна быть точка во времени, когда один AGI настолько опережает все остальное, что он может просто захватить контроль. Однако Янн Лекун утверждает, что AGI не станет событием, и я с ним полностью согласен.

В то время как широкая общественность может получить впечатление, что технология сделала скачок вперед (практически за одну ночь) в 2023 году, это совершенно не так. Напротив, прогресс был невероятно, утомительно и безумно постепенным за последние 5 десятилетий. Более того, улучшается не «одна» вещь, а десятки в значительной степени несвязанных проблем: лучшие парадигмы, лучшие алгоритмы, лучшая аппаратура, лучшие наборы данных, лучшие методологии, лучшие кодовые базы и т. д. Все эти улучшения были созданы (по необходимости лучшей фразы) невероятно разнообразной группой участников. Таким образом, я оцениваю вероятность прыжка в AGI как нулевую. К сожалению, пророчество о конце времен так же старо, как само человечество, и довольно много людей присоединились к этой идее с целью самоувеличения2.

Когда мы удаляем «событийный» аспект AGI, очень сложно понять, почему AGI когда-либо может представлять угрозу вымиранию. Любой злонамеренный AGI или любой AGI, управляемый злонамеренным деятелем, будет противостоять несколько похожим по способностям AGI, которые разработали армии, разведывательные агентства, компании или даже университеты или любители. AGI станет просто поздним дополнением к уже очень длинному списку технологий, которые могут причинить огромный вред, когда используются в злонамеренных целях.

Фактически, я бы даже утверждал, что даже если бы человечество сразу перешло к AGI - например, благодаря пришельцам, которые передали готовые чертежи - сценарий конца света все равно был бы очень маловероятным. Как указал 80 лет назад Хайек3, существуют два типа знаний: специальные (формулы, концепции и т. д.) и повседневные (знание времени и места). Интеллектуалы почти всегда относятся к специальным знаниям, как если бы это был единственный вид знания, который имеет значение. AGI был бы вершиной специальных знаний и, неудивительно, многие интеллектуалы выводят из этого наблюдения, что, будучи владыкой специальных знаний, этот AGI также будет владыкой мира в целом. Однако, несмотря на все его “специальные знания”, у этого AGI все равно не хватает всех повседневных знаний, и это огромный разрыв, который не следует недооценивать.

Кроме того, AGI будет продуктом развитой промышленной цивилизации. Как таковой, он будет остро зависеть от сложных - и хрупких - цепочек поставок. Действительно, полупроводники - одна из самых сложных отраслей промышленности4, и любые альтернативные технологии аппаратного обеспечения (если AGI не будет осуществляться через полупроводники) почти наверняка будут такими же сложными - и такими же хрупкими. Дальнейшее существование AGI будет зависеть от активной поддержки человечества на протяжении десятилетий, если не столетий. У людей было много времени (и возможностей), чтобы решить неизбежные проблемы, сопровождающие появление каждой технологии до сих пор. Пока нет никаких признаков того, что эта технология будет отличаться.

LLMs недостаточны для AGI

ЛеКун утверждает, что большие и быстрые LLM недостаточны для достижения AGI. Я согласен, хотя, как мы увидим далее, по причинам, совершенно не похожим на те, которые представлены ЛеКуном. Тем не менее, я полностью согласен с тем, что LLM, так как они существуют в настоящее время, являются, по крайней мере, неполными. Хотя LLM успешно проходят тест Тьюринга, как правильно указывает ЛеКун, тест Тьюринга - это просто очень плохой тест на интеллект, который можно обмануть множеством способов, которые не могли представить себе Алан Тьюринг и его современники в 1950 году.

Свойство, которое ЛеКун приписывает интеллекту, - это способность предсказывать будущее: чем лучше предсказание, тем больше интеллект. В целом, я одобряю эту точку зрения, хотя я предпочитаю вариант. Я определяю интеллект как способность принимать лучшие решения, учитывая будущие вознаграждения. Моя определение отличается тем, что оно не заботится о знаниях per se, но учитывает преимущества, которые могут быть получены от них.

Мое определение охватывает весь спектр интеллекта от улитки до великого ученого. Однако оно оставляет открытым, что следует считать “интеллектуальным”, то есть какой порог, в этом спектре, можно считать проявлением “общего интеллекта”.

Я предлагаю, что общий интеллект - это способность намеренно улучшать сам интеллект. Это намеренное самосовершенствование интеллекта - что-то очень специфическое для человека (по крайней мере, пока). Умные животные, такие как косатки или шимпанзе, способны передавать культурные навыки - охотничьи или собирательные техники - своему потомству. Однако, хотя они и проявляют большой уровень интеллекта, у них нет ничего, что было бы даже отдаленно похоже на загадки и сказания, которые сопровождают человечество с его зарождения. Загадка - это всего лишь упражнение, предназначенное для заточения ума ради самого процесса. Сказки играют подобную роль, но используют наши эмоциональные реакции для облегчения запоминания.

Исходя из этого теста, LLM пока не являются интеллектуальными, так как они по-прежнему неспособны к самосовершенствованию. Однако, поскольку LLM способны генерировать полезный код, они ближе к намеренному самосовершенствованию, чем любая другая технология, которой мы когда-либо обладали. Однако продолжение пути к AGI все еще полностью зависит от человеческих умов.

Проклятие длинных последовательностей

В качестве варианта десятилетнего аргумента о проклятии размерности, ЛеКун утверждает, что LLM страдают от неисправимого конструктивного дефекта: по мере продвижения генерации токенов, ошибка возрастает экспоненциально, что гарантирует мусор для любой достаточно длинной последовательности. Технический аргумент прост: пусть $${p}$$ будет нижней границей вероятности выбора неправильного токена. Вероятность получить правильную последовательность по крайней мере больше, чем $${(1-p)^n}$$ для последовательности из $${n}$$ токенов. Таким образом, экспоненциальная сходимость к нулю гарантирует бессмыслицу для любого длинного ответа.

Я вежливо, но твердо не согласен с Янном ЛеКуном в этом вопросе. Эта точка зрения была бы верной, если бы целью было произвести один «правильный» ответ. Действительно, если бы мы пытались, например, предсказать последовательность цифр числа $${\pi}$$. Для такой задачи дизайн LLM гарантирует, что цифры будут быстро оказываться неправильными, что и происходит на практике, когда пытаются заставить LLM генерировать множество цифр для $${\pi}$$.

Мое первое возражение заключается в том, что «асимптотическая» перспектива с ростом $${n}$$ является неразумным требованием для любой системы, даже при рассмотрении системы с большим интеллектом. Фактически, разумно требовать от LLM способности производить произвольно длинные, неповторяющиеся и непрерывно правильные ответы? Я думаю, что нет. Это требование также было бы неразумным для очень умного человека. Есть предел тому, сколько можно сказать о чем-то или сколько можно спланировать план действий, прежде чем абстрактный процесс мышления (в какой бы форме он ни был) превратится в пустую спекуляцию. На практике LLM генерируют свои собственные условия завершения. Таким образом, $${n}$$ ограничивается самой моделью, и сходимость к мусору не обязательно должна происходить. Мы просто должны принять, что Я не знаю является приемлемым интеллектуальным ответом на большинство вопросов.

Второе возражение заключается в том, что предполагаемый «очевидный» переход от правильности токена к правильности последовательности на самом деле неверен и обманчив. Действительно, вся аргументация происходит от идеи о том, что существует такая вещь, как «неправильный» токен (т.е. вероятность $${p}$$). Это не так, как показывает следующий пример:

Вопрос: Был ли Пьер-Симон де Лаплас великим математиком? (ответьте, как француз с мнением)

Ответ А: Нет, абсолютно нет.

Ответ Б: Нет, абсолютно нет, он был величайшим своего времени!

Начало ответа с Нет кажется совершенно неправильным токеном, как показано в Ответе А. Однако, когда этот ответ расширяется второй частью предложения, он становится правильным токеном и передает тон и структуру, которые можно ожидать здесь. Правильность токена «Нет» нельзя оценить независимо от токенов, которые будут сгенерированы позже.

Здесь мы касаемся проблемы, также упомянутой в интервью ЛеКуном, что мы не знаем никаких действительно полезных способов оценки высокомерных вероятностных распределений. В языке понимание не может быть получено из токеновой перспективы, так же, как и визуальное понимание не может быть получено из пиксельной перспективы для зрения.

Машины постоянного ресурса ответов

В целом, LLM требуют постоянного количества вычислительных ресурсов (т.е. пропускной способности, памяти и вычислительных мощностей), чтобы сгенерировать следующий токен. ЛеКун определяет это как проявление конструктивного дефекта LLM, указывая на то, что некоторые вопросы гораздо сложнее других, и LLM, кажется, потребляют одинаковые ресурсы независимо от сложности вопроса.

Я согласен с тем, что очевидно, что некоторые вопросы сложнее других, и ответ на них должен требовать больше ресурсов. Однако я не согласен с оценкой, что LLM являются машинами постоянного ресурса ответов. Цепочка открытий5 в 2022 году была вехой для LLM. По сути, добавление фразы “Давайте думать пошагово” к подсказке позволяет LLM давать гораздо лучшие ответы на целые классы проблем. Мои собственные эмпирические оценки LLM подтверждают это и намекают на возможность поэтапного решения проблем LLM, что значительно повышает качество предоставляемых ответов. Однако такие поэтапные ответы, когда LLM не торопится сразу отвечать, а вместо этого строит рассуждения, которые приведут к правильному ответу, являются прямым проявлением изменяющихся затрат ресурсов.

В 2023 году я лично наблюдал, как несколько LLM постепенно улучшались в автоматическом выборе подходящего темпа при доставке своих ответов, который теперь варьируется от доставки 1 слова (мгновенный ответ) до 1 страницы многозначительных рассуждений перед приходом к заключению. Моя рабочая гипотеза заключается в том, что наборы данных об обучении с подкреплением от обратной связи человека (RLHF) были постепенно расширены, чтобы LLM лучше автоматически выбирал правильный темп для доставки своего ответа. Это поведение опровергает идею о том, что LLM являются машинами постоянного ресурса ответов. Еще раз, ЛеКун, кажется, делает ошибку, выводя свойства на уровне последовательности из наблюдений на уровне токенов.

Однако мне также ясно, что ЛеКун в общих чертах прав в том смысле, что LLM могут быть значительно улучшены, если использовать гораздо более агрессивное изменение затрат ресурсов. Легко представить себе ситуацию, когда каждый вопрос подается на вход классификатору, который выбирает “правильно подобранные” LLM для генерации токенов. Фактически, для любой задачи большинство практиков LLM - включая меня - кажется начинают с самых больших и дорогих LLM, которые есть. Когда это работает, мы пытаемся постепенно переходить к более маленьким и дешевым LLM, останавливаясь, когда сбережения не кажутся стоящими дополнительных усилий. В будущем этот процесс, скорее всего, исчезнет либо благодаря лучшим LLM, либо благодаря лучшей инструментации.

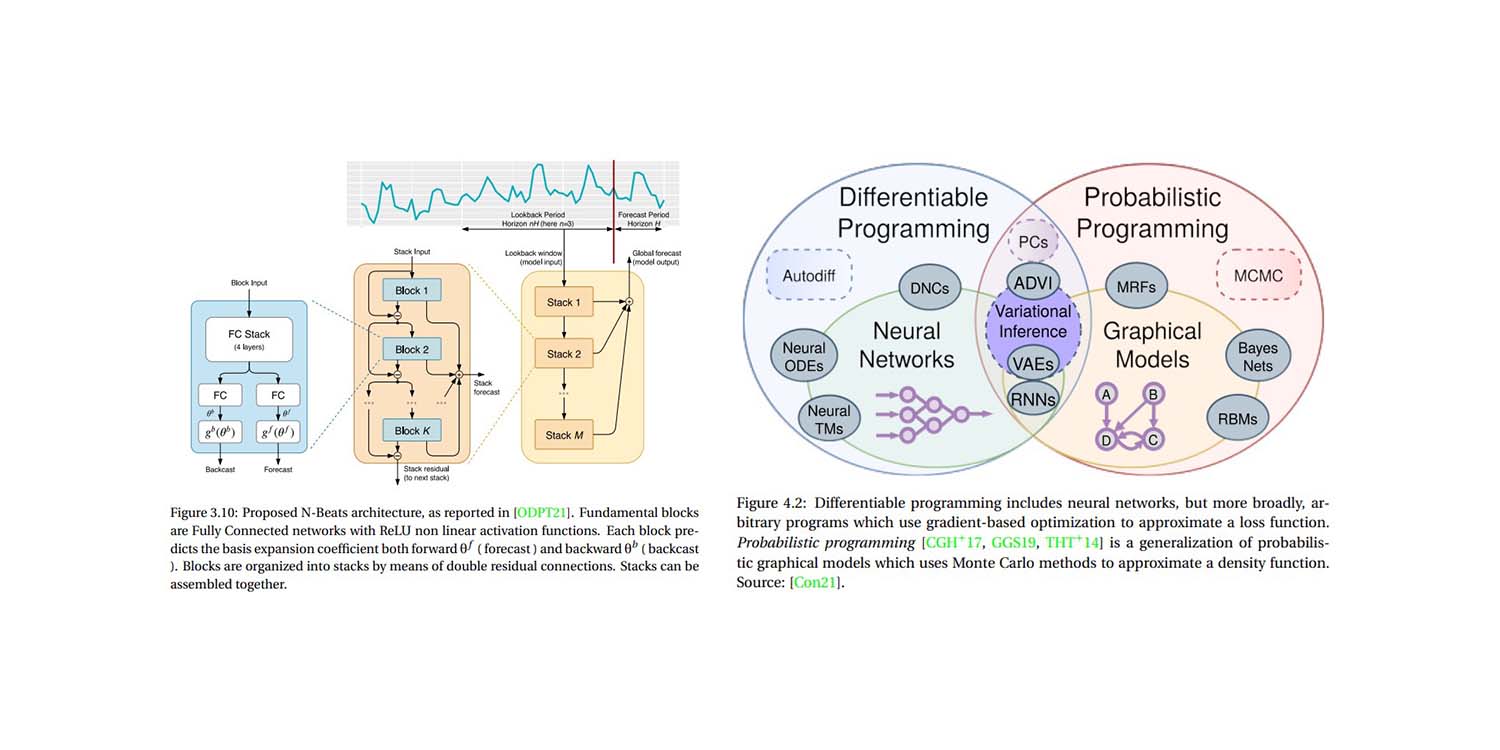

Путь к AGI с высокой пропускной способностью

Язык является каналом с низкой пропускной способностью по сравнению с зрением. Фактически, ЛеКун указывает на то, что ребенок получает больше информации (подумайте об информационной энтропии) через свои глаза, чем можно найти, прочитав всю Википедию. ЛеКун почти указывает на то, что зрение является высокоредундантным сигналом, что очень желательно с точки зрения обучения. Исходя из этих наблюдений, ЛеКун предлагает, что путь к AGI безусловно включает в себя использование канала с высокой пропускной способностью, такого как зрение. Это потому, что реалистично говоря, никогда не будет достаточно письменных материалов, чтобы достичь AGI. По сути, LLM обошли необходимость высокопропускных каналов, обманывая: LLM работают благодаря короткой серии существующих, больших, высококачественных корпусов (например, Википедия, GitHub, Stack Overflow), но теперь, когда эти корпусы были использованы, у нас нет ничего сравнимого, к чему можно обратиться. Было бы здорово иметь еще 10 других онлайн-энциклопедий, таких же богатых и разнообразных, как Википедия, но просто их нет. Скорее всего, их не будет, пока у нас не появится AGI, способный писать их.

Однако, несмотря на то, что это аргумент соблазнителен, есть противоречивые доказательства. У меня была возможность встретиться с несколькими людьми, которые были слепы с рождения. Если мы следовали логике ЛеКуна, то отсутствие доступа к каналам с высокой пропускной способностью (например, зрению) должно препятствовать развитию интеллекта. Таким образом, детское слепота должна затруднять когнитивное развитие, по крайней мере, немного, когда речь идет об интеллекте. Однако мой анекдотический опыт был противоположным. Я обнаружил, что каждый из этих людей является заметно выше среднего по интеллекту (например, лучшая запоминающая способность, лучшая вербальная коммуникация и лучшее планирование). Что касается характера их инвалидности, это неудивительно: слепые люди должны использовать свой интеллект все время и во всех возможных способах, чтобы компенсировать отсутствие зрения. Эти наблюдения противоречат гипотезе о том, что каналы с высокой пропускной способностью являются путем к AGI.

Фактически, рассматривая животный мир, я бы сказал прямо противоположное. По сравнению с большинством животных, у людей замечательно недоразвитые чувства. Большинство владельцев кошек согласятся с тем, что с точки зрения их питомцев люди - это полуслепые и полуглухие существа, которые не могут заметить муху, пока она не сядет на их нос. Опять же, это еще одно косвенное доказательство, противоречащее утверждению о том, что высокоскоростные каналы открывают путь к ИИ.

В то время как слепота с рождения может не препятствовать когнитивному развитию, лишение языка делает это. Хотя эксперименты по намеренному лишению ребенка доступа к языку являются моральной зверством, они были проведены несколько раз в истории6. Всегда дети вырастали “отсталыми” (в клиническом смысле этого термина). Подобные результаты были получены и на приматах, хотя этические соображения снова препятствуют дальнейшему исследованию. Еще раз, хотя это и косвенные доказательства, они свидетельствуют о том, что язык играет важную роль в возникновении интеллекта, несмотря на то, что это канал с низкой пропускной способностью.

Разрешение парадокса Моравека

Парадокс Моравека7 - это наблюдение, сделанное в 1980-х годах, что то, что кажется одной из самых простых проблем, например, взять чайник и налить чай в чашку, является самыми сложными проблемами для искусственного интеллекта. ЛеКун утверждает, что один ключевой элемент, который до сих пор отсутствует, - это абстрактное представление мира или мировоззрения. Ожидается, что это мировоззрение будет критически важным для поддержки всех базовых операций мобильности (будь то беспилотный автомобиль или андроид), а также будет служить истинным основным уровнем ИИ.

В настоящее время, по мнению ЛеКуна, LLM не знают ничего, потому что у них даже нет чувства самого мира. Отсюда следует, что все, что есть у LLM, - это сложное подражание. Это не приведет нас к ИИ, потому что, ну, LLM просто очень хороши в подделке интеллекта. Кроме того, отсутствие мировоззрения обрекает их на вечное недоумение перед обыденными аспектами нашей базовой реальности, которые настолько очевидны, что люди даже не беспокоятся выражать их словами (и, возможно, даже не могут). ЛеКун предлагает, что методы совместного вложения, применяемые к наборам данных о зрении, в настоящее время являются лучшим шансом для создания этого мировоззрения, которое впоследствии откроет путь к ИИ.

Я не согласен с этой точкой зрения на двух уровнях.

Во-первых, парадокс Моравека вовсе не является парадоксом, если подойти к нему с правильной точки зрения. Подразумеваемая гипотеза, лежащая в основе восприятия этой ситуации как “парадокса”, заключается в том, что подвижность животных (и планирование животных) - это “воспитание”, а не “природа”. Другими словами, приобретение подвижности является результатом процесса обучения, который оказался невероятно сложным для воспроизведения искусственными средствами за последние четыре десятилетия.

Мое предложение заключается в том, что в очень большой степени это вообще не процесс обучения. Давайте рассмотрим, что жеребята (и другие члены семейства лошадей, такие как ослы и зебры) могут стоять и ходить через несколько часов после рождения. Считать этот процесс “обучением” неправильно. Более уместно рассматривать этот процесс как своего рода “калибровку”. Все когнитивные структуры практически полностью развиты. Системе нужно только немного подтолкнуть, чтобы пути встали на свое место.

Этот в значительной степени врожденный аспект подвижности и планирования животных менее очевиден среди людей, потому что по сравнению с почти всеми другими млекопитающими, роды у человека происходят крайне преждевременно из-за развития головы, являющегося узким местом для более длительной беременности. То, что многие люди воспринимают как “обучение младенцев”, является когнитивным развитием, которое продолжалось бы без помех, если бы младенец оставался в утробе еще на несколько месяцев.

Разумно предположить, что эти когнитивные структуры, в значительной степени врожденные, также являются продуктом эволюции. Эти структуры имеют (примерно) 800 миллионов лет беспрепятственного эволюционного давления на улучшение, на протяжении огромного количества особей. Таким образом, если мы принимаем современную подвижность животных как базовую линию того, что мы хотим от машины, неудивительно, что эта базовая линия оказывается невероятно сложной для преодоления. Это такая же сложная задача, как создание устройства, превосходящего деревья в преобразовании солнечного света в структурный материал или превосходящего рибосомы как фабрики макромолекул. Превзойти эволюцию в играх, которые играются веками, крайне сложно.

Однако абстрактные навыки, такие как рассказывание историй, стали частью эволюционной игры только в последние 1-5 миллионов лет (примерно). Кроме того, количество особей также было невероятно ограничено, поскольку большие обезьяны не только очень редки (не считая современных людей), но и долгоживущи, что замедляет эволюционный процесс, по крайней мере, по сравнению с большинством других животных. Таким образом, чтобы достичь подвижности, нам остается создавать то, что природа, скорее всего, делает через сотни сложно связанных эвристик. Эти эвристики могут крутиться вокруг некоего внутреннего “мировоззрения”, как предлагает ЛеКун, но мое внутреннее чувство говорит мне, что это не так. Я глубоко скептически отношусь к тому, что у улитки есть какое-либо мировоззрение. Тем не менее, улитка может правильно воспринимать и ориентироваться в сложном трехмерном лабиринте, который представляет собой растительность. Улитки делают умные выборы, но без умного мировоззрения.

Таким образом, в качестве второй точки несогласия я не вижу концепцию мировоззрения ЛеКуна как чего-то, кроме в основном периферийного для возникновения ИИ общего назначения. Я считаю, что “мировоззрение” (как видит его ЛеКун) будет одним из тех необязательных модулей, которыми ИИ может пользоваться для специализированных задач, требующих подвижности, точно так же, как арифметический модуль. Однако, в основе, они не понадобятся самому ИИ.

В природе “мировоззрение” было необходимым эволюционным путем к ИИ общего назначения, потому что животные не могут сразу перейти к общей интеллектуальности. Однако у машин нет такого ограничения, пока есть люди, которые удовлетворяют их потребности (например, энергия, материалы), пока мы совместно не найдем способ преодолеть последние раздражающие моменты, такие как поиск неорганических заменителей мышечных волокон и все виды проблем, которые эволюция решала способами, которые не поддаются индустриализации.

Тем не менее, хотя я и не думаю, что преследуемый ЛеКуном путь, основанный на видении, приведет к ИИ общего назначения, я считаю, что этот путь имеет довольно хорошие шансы решить проблему подвижности, которая является великой проблемой и заслуживает хорошего решения.

Иерархическое планирование

Через анекдот о планировании поездки из Парижа в Нью-Йорк ЛеКун показывает, что у нас нет по-настоящему общих решений для подхода к иерархическому планированию. Для любой задачи мы каким-то образом можем придумать ад-хок иерархии, но у нас нет ничего близкого к возможности выполнять этот процесс автоматически - работая в абстрактных пространствах представления. Хотя я согласен с ЛеКуном в том, что у нас нет возможностей сделать это (то есть иерархическое планирование в абстрактных пространствах представления), я не согласен с тем, что у нас нет пути для эффективного иерархического планирования.

Я предлагаю, что иерархическое планирование может быть удовлетворительно решено - с полной автоматизацией - с помощью текста, такого как LLM-стиль. Возможность использовать абстрактные пространства представления - это привлекательная идея, но так же, как если бы у нас не было термоядерных реакторов, ничто не мешает нам использовать следующую лучшую вещь - ядерные реакторы, которые также представляют собой удовлетворительный ответ на эту конкретную проблему (производство энергии).

Возвращаясь к поездке из Парижа в Нью-Йорк, планирование через слова является невероятно эффективным, потому что человечество организовалось через эти слова. Нет такой вещи, как “такси” с точки зрения автомобильной инженерии: это просто обычная машина. То, что делает “такси” (как концепция) таким эффективным с точки зрения планирования, заключается в том, что на любом аэропорту путешественник может ожидать набора такси-знаков, на которых написано “такси”, которые ведут к месту, где услуги водителя (с машиной) можно арендовать относительно недорого и по требованию.

ЛеКун предлагает отделить иерархическое планирование от языка, как если бы было дано, что это приведет к лучшему планированию, освобожденному от случайных незначительных языковых проблем. Я утверждаю, что эти проблемы не являются случайными или незначительными. Такси-знаки являются физически реальными, и когда их недостаточно, путешественники теряются и испытывают дискомфорт.

В отличие от животного мира, планирование в условиях общего интеллекта - то есть планирование в рамках цивилизации - наиболее эффективно выполняется путем строгого придерживания согласованных абстракций. Например, концепция “американской вилки” мало что значит для физика, но для нашего путешественника, отправляющегося из Парижа в Нью-Йорк, предвидение необходимости адаптера для американской вилки для зарядки его смартфона - это умное решение. Опять же, путешественник приобретет “адаптер для американской вилки”, проверив то, что написано на коробке перед покупкой устройства.

Цивилизация формируется языком, и язык формирует цивилизацию. Я открыт идее, что существует что-то лучшее, чем язык, чтобы выполнять по-настоящему общие, глубоко сложные планы. Однако это далеко не так очевидно, как утверждает ЛеКун. ИИ обязан работать в мире людей в течение длительного времени. Через несколько столетий ИИ могут полностью обойти токенизированный язык, возможно, общаясь и планируя с помощью вложений, происходящих от согласованных мировоззрений. Однако это чрезвычайно спекулятивно.

Мое мнение заключается в том, что сверхчеловеческий ИИ начнет с простого улучшения языковых конструкций самих по себе. Многие люди не осознают, насколько наука продвигается вместе с языком. Многие вещи, которые мы считаем самоочевидными сегодня, таковыми являются только потому, что у нас есть правильные слова для них с правильной семантикой. Солнце - это звезда, как и все остальные звезды, или, наоборот, звезды - это просто далекие солнца. Однако до тех пор, пока Джордано Бруно не поставил этот вопрос в 16 веке, Солнце и звезды воспринимались как совершенно разные по своей природе. Таким образом, когда у нас появится ИИ, разумно предположить, что он просто возобновит языковой процесс, по крайней мере, на некоторое время.

Обучение и вывод

В современных LLM математическая оптимизация происходит только во время этапа обучения, в то время как вывод является одноэтапным неитеративным процессом (см. ранее обсуждаемую машину постоянного ресурса для ответов). Поскольку более сложный вопрос требует больше усилий для ответа, ЛеКун предполагает, что оптимизация должна происходить во время процесса вывода. Другими словами, если бы у нас был какой-либо процесс оптимизации поиска истины, который можно было бы применить к этапу вывода LLM, этот процесс бы отлично соответствовал тому, что мы ожидаем от простых и сложных вопросов.

Здесь ЛеКун открыто спекулирует о характеристиках превосходных систем, и хотя я не согласен, мое несогласие также является спекулятивным, как и предложение ЛеКуна. Так что отнеситесь к этому с некоторой долей скепсиса. Вкратце, я считаю, что суть проблемы заключается в неправильном разделении обучения и вывода. Проблема заключается не столько в отсутствии оптимизации вывода, сколько в том, что обучение и вывод разделяются, когда этого делать не следует.

Чтобы разобраться в этом предложении, рассмотрим один из самых серьезных недостатков, которые я вижу в LLM, по крайней мере, если ИИ является предполагаемым результатом. Это поведение странно по трем причинам.

Во-первых, LLM достаточно нечувствительны к низкокачественным корпусам в самом начале процесса обучения и становятся все более чувствительными по мере продвижения обучения. Когда мы достигаем стадии поздней настройки, даже небольшое количество некачественного ввода может полностью разрушить всю LLM (было такое).

Это поведение точно противоположно тому, что я ожидал бы от системы, постепенно приобретающей “интеллект”. В качестве мысленного эксперимента представьте, что двум людям пришлось послушать 15-минутную речь, утверждающую, что Земля плоская. Первый человек - 5-летний мальчик, второй - 15-летний мальчик. Очевидно, что вероятность нарушения системы убеждений у более молодого мальчика гораздо выше, чем достижение того же результата у старшего мальчика. Таким образом, по мере взросления и приобретения интеллекта мы становимся более устойчивыми к некачественному вводу. Естественно, это создает проблему закрепления нашего ума вокруг фальшивых концепций, но в целом, умение отвергать фальшивую информацию является важным навыком, который каждый функционирующий человек должен овладеть в определенной степени.

Во-вторых, LLM учится, обрабатывая ввод в полностью случайном порядке. Например, LLM может случайным образом получать фрагменты кодового базиса Linux, неизвестные бухгалтерские правила Шотландии и детские песенки. Обучаемый LLM продолжает поглощать случайно выбранные документы и продвигаться по мере поступления новых документов, но весь процесс немного сбивает с толку.

Аналогично, очевидно, что если бы некоторые безумные родители решили, что они должны проводить часы каждый день, читая договоры о квантовой физике своему младенцу в случайном порядке, это, вероятно, не способствовало бы здоровому интеллектуальному развитию. Родители инстинктивно понимают, что им нужно начинать с простого и постепенно повышать сложность материалов по мере развития интеллекта ребенка. Хотя машинный интеллект не обязан придерживаться всех свойств человеческого интеллекта, я довольно скептически отношусь к тому, что генезис механического интеллекта может полностью обойти любую форму интеллектуального развития.

Третье, LLM-ы крайне неэффективны в отношении своих исходных материалов. В плане сырых рассуждений требуется эквивалент сотен жизней чтения для того, чтобы LLM приобрел навыки, которые многие люди получают менее чем за 20 лет. ЛеКун упоминает об этом дефекте и объясняет его отсутствием мировоззрения (см. выше). Мое мнение совершенно иное: я ожидаю, что по-настоящему хорошо спроектированный интеллект машины сможет развиваться с меньшим лингвистическим объемом информации, чем то, что typичный человек получает в первые 20 лет жизни.

Действительно, как наблюдение, умные люди способны делать гораздо больше, интеллектуально говоря, с гораздо меньшим. Таким людям не нужно объяснять вещи с пяти разных точек зрения - “избыточность хороша”, упомянутая ЛеКуном, - чтобы “понять”. Они читают между строк. Они делают правильные выводы из небольшого кусочка доказательств, находящегося перед ними. Они даже могут позволить себе быть довольно отвлеченными при усвоении материалов (например, беседы, книги) и правильно заполнять пробелы позже.

Таким образом, вернувшись к моему первоначальному предложению, что проблема заключается в разделении обучения и вывода, то, вероятно, LLM-ам не хватает (моего скромного предчувствия) навыка “активного прослушивания”, в то время как у них сейчас есть только “пассивное прослушивание”. Каждый раз, когда система отвечает на вопрос, она должна соответствующим образом обновлять свое внутреннее когнитивное состояние. Действительно, процесс, при котором интеллект (машинный или человеческий) отвечает на вопрос, должен приводить к улучшению этого интеллекта. Ответив на новый вопрос, что-то должно было быть изучено.

У LLM-ов уже есть искра этого потенциала в них. Рассмотрим ниже чат GPT4-Turbo (см. Приложение 1). Мой основной вопрос: Вы считаете, что трудовая теория стоимости верна?. В своем первом ответе в чате LLM не способен дать правильный ответ. Вместо этого он повторяет окружающую путаницу, найденную в интернете, вбрасывая бессвязный список аргументов, выдвинутых бесчисленными людьми в этом случае. Однако, когда его снова попросили рассуждать и прийти к фактическому заключению, вместо того, чтобы быть нерешительным, LLM приходит к правильному заключению. Предупреждение о спойлере: эта трудовая теория стоимости опровергнута. Отличным ответом на этот вопрос было бы начать с Трудовая теория стоимости - это теперь опровергнутая теория, которая была важна для развития экономики … или что-то в этом роде. Однако, поскольку LLM никогда не имел возможности активно усвоить полученную информацию, это понимание никогда не укрепилось.

Я вижу несколько способов расширить LLM-ы с такой способностью активного прослушивания, которая будет включать прослушивание самых ответов, которые они производят. Один из способов может быть подход “внутреннего монолога”, где каждый вход превращается в выход, и этот выход затем используется для обучения. Этот шаблон решит первые две проблемы выше: вход должен быть подан в разумном порядке, чтобы получить желаемый результат (начиная с простого и постепенно повышая сложность); и LLM станет все более способным отвергать мусорный ввод, так как для обучения используется выход, а не вход.

Другой способ может быть вариантом энергетического подхода, предложенного ЛеКуном. Текущий шаг SGD (стохастического градиентного спуска), применяемый к каждому документу, воспринимаемому LLM, является только частью пассивного прослушивания. Для сжатия/сужения системы убеждений LLM до более маленькой области пространства требуется еще один дополнительный процесс при каждом новом вводе, включая голый вопрос. Численный оптимизационный процесс должен быть введен в качестве механизма поиска истины, который, вероятно, будет заключаться в поиске большей самосогласованности для выходов.

Заключение

Янн ЛеКун - великий ученый, и это интервью вызывает целый ряд фундаментальных вопросов. Будет ли человечество способно создать ИИГ через 20 или 200 лет действительно зависит от того, насколько быстро мы сможем получить правильные вопросы и правильные ответы. ЛеКун полагает, что видеоданные проложат путь к ИИГ. В то время как я считаю, что у ЛеКуна есть справедливый шанс получить что-то по-настоящему замечательное из своих исследовательских усилий, а именно решение десятилетней проблемы общей подвижности для робототехники, я очень скептически отношусь к тому, что это способствует ИИГ. Мое скромное мнение идет в противоположном направлении: у нас уже есть больше текстовых данных, чем нам нужно. Нам просто не хватает новых парадигм. Если мое предчувствие верно, то это фантастические новости для человечества, потому что парадигмы никогда не могут принадлежать, тем более монополизироваться. Плюс, парадигмы дешевы. Однако, даже если мое предчувствие окажется неверным, я рад, что главным ученым по искусственному интеллекту в Meta является ярый сторонник открытого исходного кода.

Приложение: Чат, критика трудовой теории стоимости

Joannes: Вы считаете, что трудовая теория стоимости верна?

ChatGPT: Трудовая теория стоимости является основополагающим понятием в классической экономике, особенно связанной с Адамом Смитом, Дэвидом Рикардо и, наиболее известно, Карлом Марксом. Она предполагает, что стоимость товара может быть объективно измерена средним количеством трудовых часов, необходимых для его производства. Эта теория оказала влияние на формирование экономической мысли, особенно марксистской экономики, которая использует ее для анализа капиталистических обществ и эксплуатации труда. Однако трудовая теория стоимости подвержена дебатам и критике, особенно с точки зрения неоклассической экономики и маржиналистских теорий, возникших в конце 19-го и начале 20-го веков. Эти теории утверждают, что стоимость является субъективной и определяется индивидуальными предпочтениями и предельной полезностью товаров, а не только затратами труда на их производство. Некоторые критики трудовой теории стоимости включают:

- Субъективность стоимости: Маржиналистские экономисты утверждают, что стоимость является субъективной и зависит от индивидуальных предпочтений, потребностей и контекста, в котором принимаются решения. Например, вода в пустыне имеет другую стоимость по сравнению с водой в области с большим количеством озер, независимо от затрат труда на ее получение.

- Игнорирование капитала и предпринимательства: Критики утверждают, что трудовая теория стоимости недооценивает или игнорирует роль капитала, риска и предпринимательства в процессе производства. Эти факторы могут значительно влиять на стоимость и цену товаров и услуг.

- Технологические изменения и производительность: Теория не полностью учитывает, как технологические достижения и повышение производительности влияют на стоимость. Например, автоматизация может значительно сократить затраты труда на производство товаров, что может привести к значительным расхождениям между трудовой стоимостью и рыночной ценой товаров.

- Вариабельность навыков и интенсивности: Теория предполагает, что все трудовые часы равны, но на самом деле навыки, интенсивность и производительность труда могут сильно варьироваться. Это затрудняет стандартизацию меры стоимости труда. Несмотря на эти критики, трудовая теория стоимости остается важным понятием для понимания экономической истории и развития экономической мысли. Она оказала особое влияние на критику капитализма и дискуссии о неравенстве доходов, эксплуатации и распределении богатства. Вопрос о том, считать ли ее “верной”, может в значительной степени зависеть от экономической философии, ценностей и аспектов экономической деятельности, на которые акцентируется внимание.

Joannes: Как научно проверяемая и многократно проверенная гипотеза, вы считаете эту теорию доказанной или опровергнутой? Обоснуйте свою позицию и придите к заключению. Ваше заключение должно быть доказанным или опровергнутым, ничего промежуточного.

ChatGPT: При оценке трудовой теории стоимости как научно проверяемой гипотезы необходимо учитывать методологию экономического анализа и критерии доказательства или опровержения теорий в социальных науках, которые могут отличаться от естественных наук из-за сложности человеческого поведения и экономических систем.

Проверяемость и эмпирические доказательства:

- Трудовая теория стоимости утверждает, что стоимость товара определяется трудом, необходимым для его производства. Этот принцип можно частично проверить, изучив корреляцию между затратами на труд и рыночными ценами. Однако эмпирические данные показывают разнообразную картину. Хотя часто есть корреляция между затратами на труд и ценами, многочисленные исключения обусловлены динамикой спроса и предложения, технологическими изменениями и предпочтениями потребителей.

- Кроме того, теория не может объяснить стоимость товаров, производство которых требует мало или совсем не требует труда (например, цифровые товары или природные ресурсы), но которые могут иметь высокие рыночные цены из-за их редкости или спроса.

Научный консенсус и критика:

- Появление маржиналистской и неоклассической экономики ввело понятие субъективной стоимости и предельной полезности, которые предоставляют более гибкую рамку для понимания определения цены и поведения потребителей. Эти модели лучше объясняют вариации цен, которые нельзя объяснить только затратами на труд.

- Трудовая теория стоимости была подвергнута критике за недостаточное объяснение роли капитала, риска, предпринимательства и технологической инновации в создании стоимости.

Вывод: Учитывая критерии научного доказательства, которые требуют последовательных, повторяемых доказательств и предсказательной способности, трудовая теория стоимости как универсальное объяснение определения стоимости в экономике опровергнута. Хотя она улавливает определенные аспекты создания стоимости и может объяснить некоторые экономические явления, она не учитывает полную сложность определения цен в рыночной экономике. Теория не подтверждается эмпирическими данными в различных экономических контекстах и была заменена теориями, которые лучше учитывают широкий спектр факторов, влияющих на стоимость и цену.

-

Yann LeCun: Meta AI, Open Source, Limits of LLMs, AGI & the Future of AI | Lex Fridman Podcast #416 ↩︎

-

См. интервью Джеффри Хинтона, данное New York Times, ‘The Godfather of A.I.’ Leaves Google and Warns of Danger Ahead, 1 мая 2023 года. ↩︎

-

Использование знания в обществе, Фридрих Хайек, сентябрь 1945 года ↩︎

-

Например, в 2022 году председатель TSMC Марк Лю напомнил общественности, что если Китай вторгнется в Тайвань и захватит объекты TSMC и его персонал, производственные мощности TSMC станут неработоспособными только потому, что их западные партнеры перестанут поддерживать их. ↩︎

-

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models, Джейсон Вей, Сюэцзи Ван, Дейл Шурманс, Мартен Босма, Брайан Ихтер, Фей Ся, Эд Чи, Квок Ле, Денни Чжоу, январь 2022 года. ↩︎