Descenso por gradiente estocástico con estimador de gradiente para variables categóricas

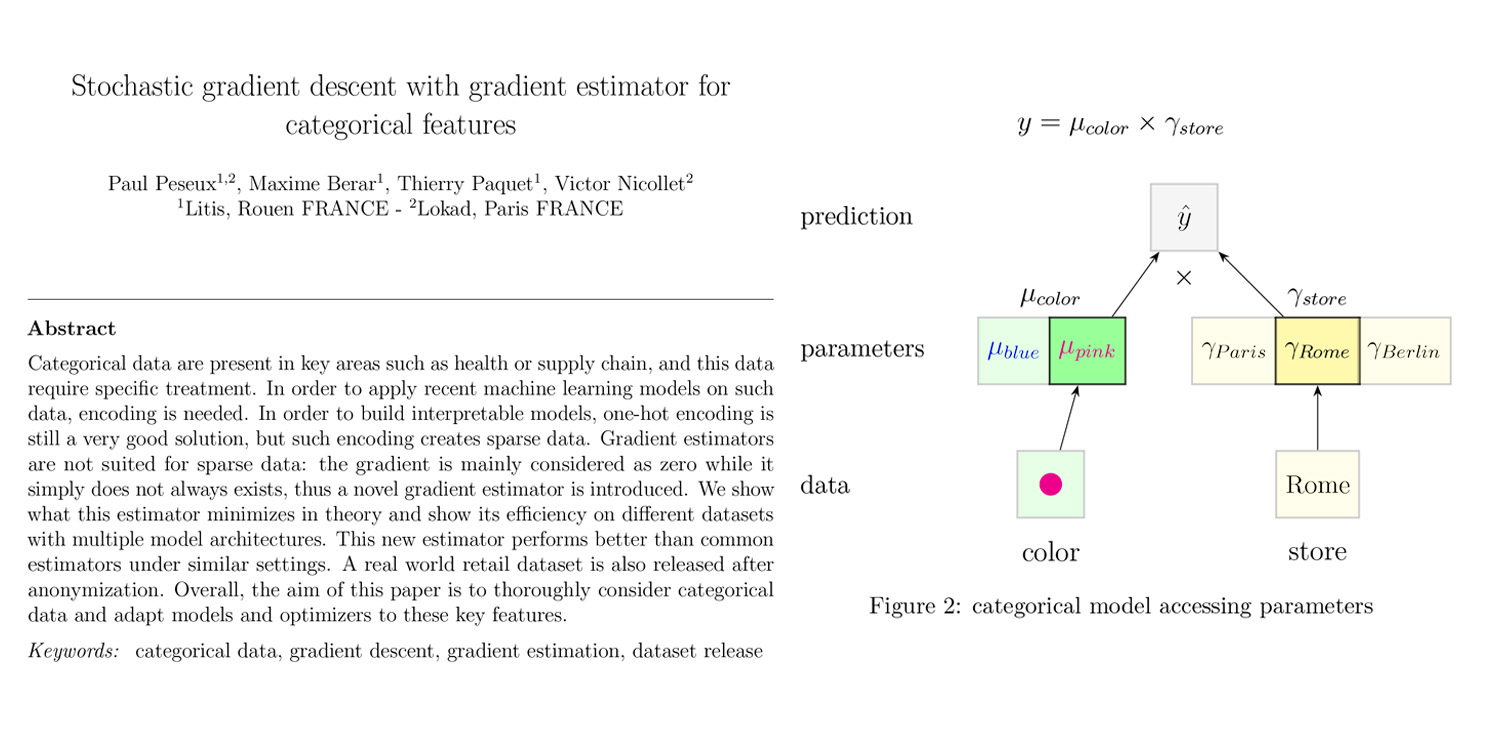

El amplio campo del aprendizaje automático (ML) proporciona una amplia variedad de técnicas y métodos que abarcan numerosas situaciones. Supply chain, sin embargo, presenta su propio conjunto específico de desafíos de datos, y a veces aspectos que podrían considerarse “básicos” por los profesionales de supply chain no se benefician de instrumentos de ML satisfactorios – al menos según nuestros estándares. Tal fue el caso de las variables categóricas, que están omnipresentes en supply chain - por ejemplo, para representar categorías de productos, países de origen, métodos de pago, etc. Así, algunos de nosotros decidimos revisar la noción de variables categóricas desde una perspectiva de programación diferenciable.

En supply chain, las variables categóricas frecuentemente están ausentes, no porque los datos no se conozcan, sino porque la categorización en sí misma no siempre tiene sentido. Por ejemplo, el corte (recto / ajustado / delgado / etc.) es aplicable a los pantalones pero no a los cinturones. Por lo tanto, la distinción entre “datos ausentes” y “datos no aplicables” podría parecer sutil, pero no deja de ser importante. Es la clase de distinción que diferencia a un modelo bien comportado de uno con un comportamiento extraño.

El artículo a continuación presenta una contribución de Paul Peseux (Lokad), Victor Nicollet (Lokad), Maxime Berar (Litis) y Thierry Paquet (Litis).

Título: Descenso por gradiente estocástico con estimador de gradiente para variables categóricas

Autores: Paul Peseux, Maxime Berar, Thierry Paquet, Victor Nicollet

Resumen: Los datos categóricos están presentes en áreas clave como la salud o supply chain, y estos datos requieren un tratamiento específico. Para aplicar modelos recientes de aprendizaje automático en dichos datos, se necesita codificación. Con el fin de construir modelos interpretables, la codificación one-hot sigue siendo una muy buena solución, pero dicha codificación genera datos dispersos. Los estimadores de gradiente no son adecuados para datos dispersos: el gradiente se considera principalmente como cero mientras que simplemente no siempre existe; por ello, se introduce un nuevo estimador de gradiente. Mostramos qué es lo que este estimador minimiza en teoría y demostramos su eficiencia en diferentes conjuntos de datos con múltiples arquitecturas de modelos. Este nuevo estimador rinde mejor que los estimadores comunes en configuraciones similares. Además, se publica un conjunto de datos de ventas minoristas del mundo real tras su anonimización. En general, el objetivo de este artículo es considerar a fondo los datos categóricos y adaptar los modelos y optimizadores a estas características clave.