Picco del Minimo Sforzo: Large Language Models for Supply Chain Decisions.

“Non basta aprire porte già aperte; però occorre evitare di ridipingere la maniglia in blu Word.”

Se ti serve un corso accelerato per enunciare l’ovvio mentre allo stesso tempo pubblichi Microsoft Azure, non cercare oltre il recente “Grandi modelli linguistici per Supply Chain Decisioni”.1 Il documento promette di rivoluzionare le operazioni; invece riscalda gli avanzi di ieri, li impiatta su Times New Roman e fa pagare l’ingresso.

Di seguito un’autopsia leggera di questo tour de force di luoghi comuni.

1. Una scena del crimine della formattazione

Prima di raggiungere l’abstract, l’articolo ci insulta con il predefinito Heading 1 di Microsoft Word 97. Niente LaTeX, nessun amore per l’impaginazione, neppure un tentativo a malapena convincente di una didascalia decente per le figure. Cari autori: se TikZ vi intimorisce, almeno cambiate il colore del titolo—qualsiasi cosa per dimostrare che un essere umano ha toccato il modello.

2. Calciare porte spalancate

La pagina 1 annuncia solennemente che “Modern supply chains are complex” e che “optimization tools have been widely utilized.” Rivoluzionario. Successivamente sveleranno che l’acqua è bagnata e che i lunedì seguono le domeniche.

Nel corso del testo, ogni fatto è o:

- già affrontato in corsi universitari di OR due decenni fa, oppure

- così generico da poter essere copiato‑incollato su Wikipedia senza che nessuno se ne accorga.

3. LLM 101 — nel 2025

La sezione 2 dedica tre pagine a spiegare che un LLM “predice la parola successiva.” Immagina di presentare un articolo di fisica che si ferma per chiarire il F = ma di Newton. Questo è il picco del minimo sforzo: il modello di erudizione in cui si presume che il lettore si sia appena svegliato nel 1990.

4. Dove sono i numeri?

Il titolo promette “decisioni”, eppure l’unica equazione in vista è quella nel piè di pagina. Niente formulazioni, niente loss functions, nessun KPI, nessun benchmark paragonabile persino all’Excel solver. Ci viene detto che GPT‑4 raggiunge “circa il 90% accuracy”. Precisione di cosa, esattamente? Stime dei costi? Livelli di servizio? Identificazione della pasticceria francese? In assenza di una metrica, il 90% di zero prove si arrotonda ancora a zero.

5. Il Cabaret del What‑If

Gli autori sfilano con un’architettura meravigliosa (vedi Figura 1 — un diagramma di flusso degno dei ClipArt di PowerPoint) traducendo un semplice “what if?” in “codice matematico.”

Eppure, la magia dietro le quinte è lasciata all’immaginazione. Quale solver? Quale tempo di esecuzione? Come si mantiene la fattibilità quando GPT aggiunge allegramente vincoli che rompono il modello? Silenzio. Fidatevi, siamo gli esperti.

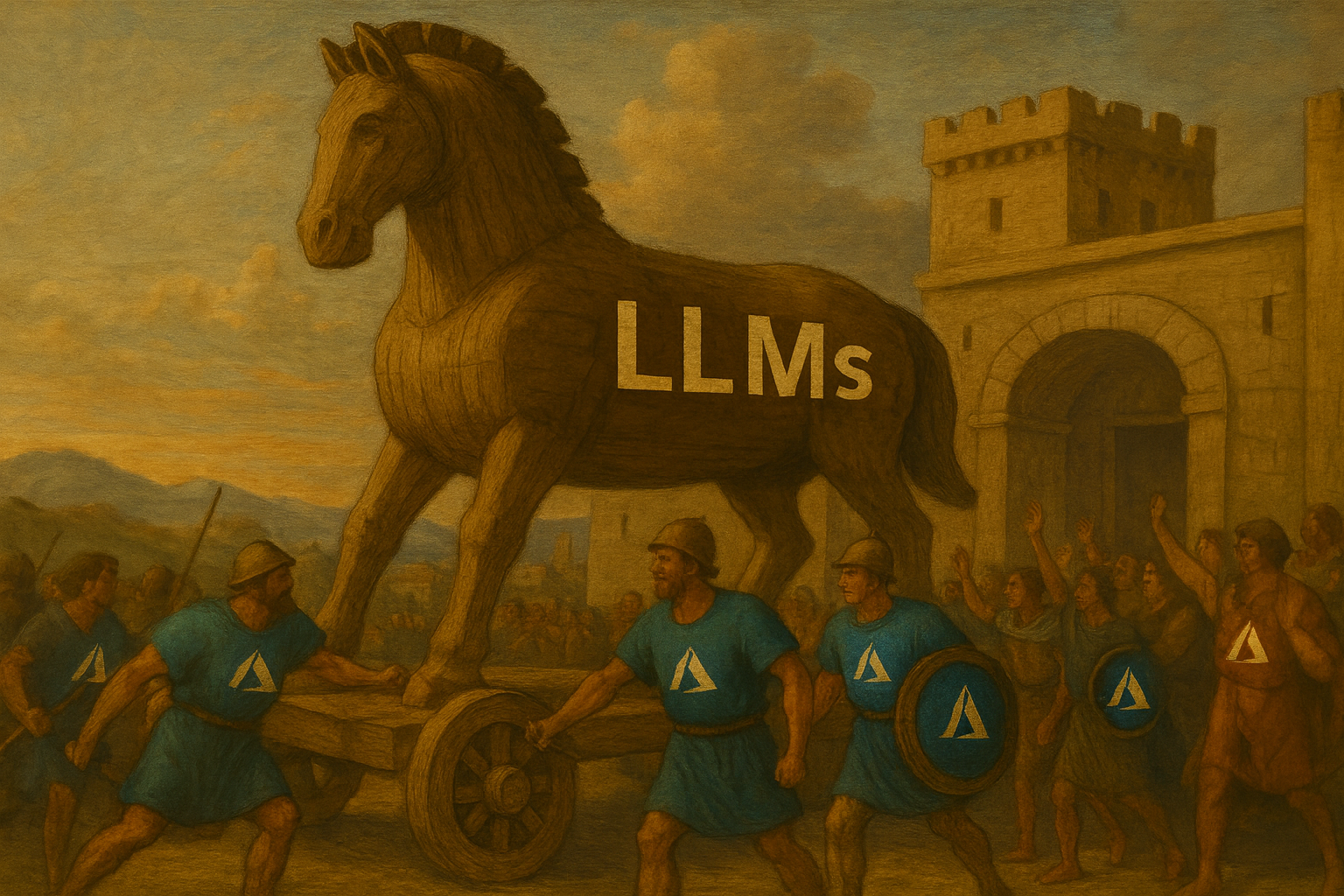

6. Contenuto sponsorizzato, edizione accademica™

Circa un terzo delle pagine è un caso di studio dei pianificatori di Microsoft Azure i quali, apprendiamo, sono ora entusiasti perché un chatbot interno permette loro di risparmiare il 23 % del tempo di indagine.

Quella percentuale è sospettosamente precisa per una metrica mai definita. Ancora più importante, l’“esperimento” è indistinguibile da un comunicato stampa. Il product placement può andare bene in Transformers 19, ma in un capitolo accademico puzza da infomercial.

7. Rischio? Etica? No.

Gli LLM allucinano, trapelano dati, inventano fornitori dal nulla — nulla di tutto ciò compare nella discussione. Gli autori osservano che gli utenti devono “imparare a porre domande precise”, incolpando di fatto l’operatore se il modello diventa fuori controllo. È come spedire un’auto senza freni e istruire i conducenti a “pianificare attentamente le loro fermate.”

8. Bibliografia senza biologia

Cinque riferimenti: cinque sono auto‑citazioni, tre sono pre‑print, uno è HBR (leggi: blog aziendale con note a piè di pagina). La vera letteratura sulla supply‑chain — demand forecasting, stochastic optimization, probabilistic lead‑times — non si trova da nessuna parte. A quanto pare, l’OR è iniziata quando è stato rilasciato GPT‑3.

9. Opportunità mancate

- Pensiero probabilistico: Le supply chains funzionano grazie all’uncertainty. L’articolo funziona a polvere di fata deterministica.

- Inferenza causale e controfattualità: Sostituita da “chiedi a GPT cosa succede se la fabbrica F chiude.”

- Costo computazionale: Le GPU vengono liquidate come “hardware speciale.” La tua bolletta cloud ti porgerà i saluti.

Riflessioni finali

Questo capitolo non è sbagliato; è semplicemente irrilevante. Contribuisce alla scienza della supply‑chain tanto quanto la saggezza dei decalcomanie contribuisce alla filosofia. Se l’obiettivo era dimostrare che gli LLM possono scrivere un articolo sulla supply‑chain, congratulazioni — l’IA lo ha chiaramente fatto, e nessuno si è preoccupato di modificarlo.

Per i lettori in cerca di sostanza, vi suggerisco di saltare l’articolo e di chiedere a ChatGPT “spiega l’ottimizzazione della supply‑chain come se avessi cinque anni.” Otterrete contenuti superiori, meglio formattati e senza le pubblicità di Azure.