Una reseña con opiniones de la entrevista de Yann LeCun con Lex Fridman

Yann LeCun, uno de los investigadores de IA más influyentes del mundo, recientemente compartió una entrevista de 3 horas con Lex Fridman1 titulada “Meta AI, Open Source, Limits of LLMs, AGI & the Future of AI”. Esta entrevista es extraordinaria, y con su pensamiento claro y articulado, Yann LeCun demuestra lo que la ciencia en movimiento luce en su mejor expresión. Recomiendo encarecidamente esta entrevista a cualquiera que muestre interés en Inteligencia Artificial (IA). Sin embargo, no apoyo completamente todas las propuestas presentadas por Yann LeCun, y estas divergencias de opinión podrían resultar ser más importantes que un mero debate académico. En la siguiente entrada, reviso esta entrevista, comenzando por las propuestas que necesitan mayor respaldo, y continuando con aquellas que cuestiono.

El bombo actual en torno a la IA se deriva de Large Language Models (LLMs) - lo que Yann LeCun caracteriza correctamente como, de hecho, LLMs autoregresivos. Los tokens (fragmentos de palabras) se generan uno a uno, retroalimentándose al modelo que generó el token anterior. Los LLMs son el ingrediente secreto detrás de ChatGPT. La mayoría de las personas, incluyéndome, que pasan unas pocas horas con GPT4, no pueden evitar sentir una especie de vértigo. Esto puede no ser una Inteligencia Artificial General (AGI), pero sigue siendo tremendamente impresionante. El impacto es profundo, y muchos han comenzado a pedir medidas legales de emergencia drásticas, ya que AGI se presenta frecuentemente como una amenaza genuina a nivel de extinción para la humanidad - un escenario al estilo Terminator.

Pesimismo y fatalismo

Yann LeCun esencialmente argumenta que esta perspectiva de ‘pesimismo y fatalismo’ es un completo disparate, y apoyo totalmente esta postura. El escenario apocalíptico requiere que AGI sea un evento: debe haber un momento en el que una AGI esté tan por delante de todo lo demás que pueda simplemente apoderarse. Sin embargo, Yann LeCun sostiene que AGI no va a ser un evento, y no podría estar más de acuerdo.

Si bien el público en general puede tener la impresión de que la tecnología dio un salto (básicamente de la noche a la mañana) en 2023, esto no es absolutamente cierto. Al contrario, el progreso ha sido increíblemente, tediosamente y exasperantemente incremental durante las últimas 5 décadas. Además, no es que se mejore una única cosa, sino docenas de aspectos en gran medida no relacionados: mejores paradigmas, mejores algoritmos, mejor hardware, mejores conjuntos de datos, mejores metodologías, mejores bases de código, etc. Todas estas mejoras han sido generadas (a falta de una mejor frase) por una multitud de colaboradores increíblemente diversa. Por lo tanto, estimo que la probabilidad de saltar directamente a AGI es nula. Desafortunadamente, profetizar el fin de los tiempos es tan antiguo como la humanidad misma, y bastantes personas se han subido al carro para fines de autoengrandecimiento2.

Una vez que eliminamos el aspecto ‘evento’ de AGI, es muy difícil ver por qué AGI se presentaría como una amenaza a nivel de extinción. Cualquier AGI maliciosa, o cualquier AGI operada por un actor malintencionado, será contrarrestada por otras AGIs de capacidad algo similar que habrán desarrollado ejércitos, agencias de inteligencia, empresas o incluso universidades o aficionados. AGI será simplemente una adición tardía a la ya muy extensa lista de tecnologías que pueden causar un daño inmenso cuando se usan con fines nefastos.

De hecho, incluso argumentaría que, aunque la humanidad saltara directamente a AGI -por ejemplo, gracias a que una civilización alienígena entregase planos listos para usar- el escenario apocalíptico seguiría siendo muy improbable. Como señaló Hayek3 hace 80 años, existen dos tipos de conocimiento: el especial (fórmulas, conceptos, etc.) y el mundano (conocimiento del tiempo y el lugar). Los intelectuales casi invariablemente tratan el conocimiento especial como si fuera el único tipo de conocimiento que importa. Una AGI sería la cúspide del conocimiento especial y, por lo tanto, no es sorprendente que muchos intelectuales deduzcan de esta observación que, como maestra del conocimiento especial, esta AGI también sería la maestra del mundo en general. Sin embargo, a pesar de todo su “conocimiento especial”, esta AGI aún carecería de todo el conocimiento mundano, y esta es una brecha inmensa que no debe subestimarse.

Además, AGI será producto de una civilización industrial avanzada. Como tal, dependerá de manera aguda de complejas - y frágiles - supply chains. De hecho, los semiconductores son una de las industrias más complejas que existen4, y cualquier tecnología de hardware alternativa (si AGI no se produce a través de semiconductores) casi con toda seguridad será igual de sofisticada—y tan frágil. La existencia continua de la AGI dependerá del apoyo activo de la humanidad durante décadas, si no siglos. La gente ha tenido mucho tiempo (y oportunidades) para abordar los problemas inevitables que han acompañado el ascenso de cada tecnología hasta ahora. Al menos, hasta el momento, no hay indicios de que esta tecnología sea diferente.

Los LLMs son insuficientes para AGI

LeCun argumenta que los LLMs más grandes y rápidos son insuficientes para llevarnos a AGI. Estoy de acuerdo, aunque, como veremos a continuación, por razones bastante distintas a las presentadas por LeCun. Sin embargo, sí estoy completamente de acuerdo en que los LLMs, tal como existen actualmente, son al menos incompletos. Si bien los LLMs pasan la Prueba de Turing con gran soltura, como LeCun correctamente señala, la Prueba de Turing es solo una prueba muy deficiente de inteligencia que puede ser manipulada de numerosas maneras que no hubieran sido concebibles para Alan Turing y sus contemporáneos allá por 1950.

La propiedad que LeCun atribuye a la inteligencia es la capacidad de predecir el futuro: cuanto mejor sea la predicción, mayor será la inteligencia. En general, apruebo esta perspectiva, aunque prefiero una variante. Defino la inteligencia como la capacidad de tomar mejores decisiones al considerar recompensas futuras. Mi definición difiere en el sentido de que no se preocupa por el conocimiento per se, sino que tiene en cuenta los beneficios que se pueden derivar de él.

Mi definición abarca todo el espectro de la inteligencia, desde la de un caracol hasta la de un gran científico. Sin embargo, deja abierta la cuestión de qué debe considerarse como “inteligente”, es decir, cuál debería ser el umbral, dentro de este espectro, que pueda considerarse como una manifestación de la “inteligencia general”.

Propongo que la inteligencia general es la capacidad de mejorar intencionalmente la propia inteligencia. Esta mejora intencional de la inteligencia es algo muy específicamente humano (al menos por ahora). Los animales inteligentes, como las orcas o los chimpancés, son capaces de transmitir bagaje cultural - técnicas de caza o de búsqueda de alimento - a su descendencia. Sin embargo, aunque exhiben una gran cantidad de inteligencia, no poseen nada remotamente cercano a los acertijos y cuentos que han acompañado a la humanidad desde el amanecer de los tiempos. Un acertijo no es más que un ejercicio destinado a agudizar la mente por el simple hecho de hacerlo. Los cuentos desempeñan un papel similar, pero aprovechan nuestra respuesta emocional para facilitar la memorización.

Basándome en esta prueba, los LLMs aún no son inteligentes ya que siguen siendo incapaces de auto-mejorarse. Sin embargo, dado que los LLMs son tremendamente capaces de generar código útil, están más cerca de la auto-mejora intencional que cualquier tecnología que hayamos tenido. No obstante, la continuación del camino hacia AGI recae exclusivamente en las mentes humanas.

La maldición de las secuencias largas

Como variante del argumento de hace décadas de la maldición de la dimensionalidad, LeCun sostiene que los LLMs sufren de un defecto de diseño irrecuperable: a medida que progresa la generación de tokens, la tasa de error aumenta exponencialmente, garantizando así basura para cualquier secuencia suficientemente larga. El argumento técnico es directo: sea $${p}$$ una cota inferior para la probabilidad de elegir un token incorrecto. La probabilidad de obtener la secuencia correcta es, al menos, mayor que $${(1-p)^n}$$ para una secuencia de $${n}$$ tokens. Por lo tanto, la convergencia exponencial a cero garantiza basura para cualquier respuesta demasiado larga.

Discrepo cortés pero firmemente con Yann LeCun en ese punto. Esta perspectiva sería correcta si el objetivo fuera producir una única respuesta “correcta”. De hecho, si estuviéramos intentando, por ejemplo, predecir la secuencia de dígitos de $${\pi}$$. Para tal tarea, un diseño de LLM garantiza que los dígitos saldrán mal rápidamente, que es exactamente lo que sucede empíricamente al intentar que un LLM genere numerosos dígitos de $${\pi}$$.

Mi primera objeción es que la perspectiva ‘asintótica’ con $${n}$$ aumentando es una exigencia irrazonable para cualquier sistema, incluso al considerar un sistema de gran inteligencia. De hecho, ¿es razonable exigirle a un LLM que sea capaz de producir respuestas arbitrariamente largas, sin repeticiones y continuamente correctas? Creo que no. Esta demanda tampoco sería razonable para un ser humano muy inteligente. Existe un límite en cuanto a cuánto se puede decir sobre algo, o hasta dónde se puede planificar un curso de acción antes de que el proceso de razonamiento abstracto (sea cual fuere su forma) se convierta en una mera especulación ociosa. En la práctica, los LLMs generan sus propias condiciones de terminación. Así, $${n}$$ está acotado por el mismo modelo, y por lo tanto la convergencia a basura no tiene por qué ocurrir. Solo tenemos que aceptar que no lo sé es una respuesta inteligente aceptable para la mayoría de las preguntas.

La segunda objeción es que la supuestamente “evidente por sí misma” transición de la validez por token a la validez por secuencia es, de hecho, incorrecta y de manera engañosa. De hecho, todo el argumento se deriva de la idea de que existe algo como un token “incorrecto” (es decir, la probabilidad $${p}$$). Este no es el caso, como demuestra el siguiente ejemplo:

Pregunta: ¿Fue Pierre-Simon de Laplace un gran matemático? (responde como un francés con opiniones)

Respuesta A: No, absolutamente no.

Respuesta B: No, absolutamente no, ¡fue el más grande de su época!

Comenzar la respuesta con No parece ser un token totalmente incorrecto, como lo demuestra Respuesta A. Sin embargo, cuando esta respuesta se extiende con la segunda parte de la oración, se convierte en el token correcto y capta el tono y la estructura que se esperarían aquí. La validez del token “No” no puede evaluarse de forma independiente de los tokens que se generarán posteriormente.

Aquí estamos tocando el problema, también mencionado en la entrevista por LeCun, de que no conocemos ninguna forma realmente útil de apreciar las distribuciones de probabilidad de alta dimensión. En el lenguaje, las ideas no pueden derivarse de perspectivas token a token, al igual que no pueden derivarse de perspectivas píxel a píxel en la visión.

Máquinas de respuesta de recursos constantes

En términos generales, los LLMs requieren una cantidad constante de recursos informáticos (es decir, bandwidth, memory, y compute) para producir el siguiente token. LeCun identifica esto como una manifestación de un defecto de diseño de los LLMs, señalando que ciertas preguntas son mucho más difíciles de responder que otras, y que los LLMs parecen consumir los mismos recursos sin importar la dificultad de la pregunta.

Estoy de acuerdo en que es evidente que ciertas preguntas son más difíciles de responder, y que responder a esas preguntas debería requerir más recursos. Sin embargo, discrepo de la evaluación de que los LLMs son máquinas de respuesta de recursos constantes. El descubrimiento del chain-of-thought5 en 2022 fue un hito para los LLMs. En esencia, al añadir “Let’s think one step at a time” al prompt, los LLMs obtienen respuestas mucho mejores para clases enteras de problemas. Mi evaluación empírica personal de los LLMs confirma esto, y sugerir la posibilidad de una resolución de problemas por etapas en los LLMs incrementa vastamente la calidad de las respuestas entregadas. Sin embargo, dichas respuestas por etapas, donde el LLM no se apresura a responder inmediatamente sino que construye el razonamiento que conducirá a la respuesta correcta, es una manifestación directa de un gasto variable de recursos.

En 2023, personalmente fui testigo de cómo varios LLMs fueron mejorándose gradualmente en la selección automática del ritmo adecuado al entregar sus respuestas, que ahora varía desde una entrega de 1 palabra (respuesta instantánea) hasta 1 página de tergiversación antes de llegar a una conclusión. Mi hipótesis de trabajo es que los conjuntos de datos de Reinforcement Learning from Human Feedback (RLHF) se han expandido progresivamente para que el LLM mejore en la selección automática del pace correcto para entregar su respuesta. Este comportamiento refuta la idea de que los LLMs son máquinas de respuesta de recursos constantes. Una vez más, LeCun parece estar cometiendo el error de derivar propiedades a nivel de secuencia a partir de observaciones a nivel de token.

Sin embargo, también me queda claro que LeCun tiene razón en el sentido de que los LLMs casi con toda seguridad pueden mejorarse enormemente si se es mucho más agresivo en términos de variar el gasto de recursos. Es sencillo imaginar un escenario en el que cada pregunta se alimente a un clasificador que elija los LLMs de tamaño adecuado para realizar la generación de tokens. De hecho, para cualquier desafío, la mayoría de los practicantes de LLM –incluyéndome a mí– parecen comenzar con los LLMs más grandes y costosos que existen. Una vez que funcionan, intentamos avanzar gradualmente hacia LLMs más pequeños y económicos, deteniéndonos cuando los ahorros no parezcan valer el esfuerzo adicional. En el futuro, es muy probable que el proceso desaparezca, ya sea a través de mejores LLMs o mediante una mejor instrumentación.

El camino de alto ancho de banda hacia AGI

El lenguaje es un canal de baja bandwidth comparado con la visión. De hecho, LeCun señala que una niña adquirirá más información (pensemos en la entropía informacional) a través de sus ojos que la que se puede obtener leyendo la totalidad de Wikipedia. LeCun casi insinúa que la visión es una señal altamente redundante, lo cual es muy deseable desde una perspectiva de aprendizaje. A partir de esas observaciones, LeCun propone que el camino hacia AGI ciertamente implica poner un canal de high-bandwidth, como la visión, en el centro de atención. Esto se debe a que, de manera realista, nunca habrá suficientes materiales escritos para acceder a AGI. En esencia, los LLMs eludieron la necesidad de canales de alta bandwidth haciendo trampa: los LLMs funcionan gracias a una corta serie de corpuses preexistentes, grandes y de alta calidad (p. ej., Wikipedia, GitHub, Stack Overflow), pero ahora que esos corpuses han sido explotados, no tenemos nada comparable a lo que recurrir. Sería bueno contar con 10 otras enciclopedias online, tan ricas y diversas como Wikipedia, pero simplemente no existen. Es muy probable que no haya más hasta que obtengamos un AGI capaz de escribirlas.

Sin embargo, aunque este argumento resulta seductor, existe evidencia contraria. Tuve la oportunidad de conocer a algunas personas ciegas de nacimiento. Si siguiéramos la línea de razonamiento de LeCun, entonces no tener acceso a canales de alta transferencia (como la visión) debería obstaculizar la inteligencia. Así, la ceguera en la infancia debería obstaculizar el desarrollo cognitivo, al menos un poco en lo que respecta a la inteligencia. Sin embargo, mi muestra anecdótica fue lo contrario. He comprobado que cada una de esas personas posee una inteligencia notablemente superior al promedio (por ejemplo, mejor memorización, mejor comunicación verbal y mejor planificación). En cuanto a la naturaleza de su discapacidad, no es sorprendente: las personas ciegas tienen que utilizar su intelecto todo el tiempo y de todas las formas para compensar su falta de visión. Esas observaciones pesan en contra de la hipótesis de que los canales de alta transferencia son el camino hacia la AGI.

De hecho, considerando el reino animal, diría prácticamente lo contrario. En comparación con la mayoría de los animales, los humanos tienen sentidos notablemente poco desarrollados. La mayoría de los dueños de gatos estaría de acuerdo en que, desde la perspectiva de su mascota, los humanos son criaturas medio ciegas y medio sordas que no pueden percibir una mosca hasta que se posa sobre su nariz. Nuevamente, es otra evidencia circunstancial que contradice la proposición de que los canales de alta transferencia allanan el camino hacia la AGI.

Aunque la ceguera desde el nacimiento puede no obstaculizar en sí misma el desarrollo cognitivo, la privación del lenguaje sí lo hace. Si bien el experimento de privar intencionadamente a un niño del acceso al lenguaje es una atrocidad moral, se ha llevado a cabo en múltiples ocasiones a lo largo de la historia6. Invariablemente, los niños han llegado a ser “retrasados” (en el sentido clínico del término). Se han obtenido resultados similares en primates, aunque, una vez más, las preocupaciones éticas impiden una mayor investigación. Una vez más, aunque sean circunstanciales, estas evidencias sugieren que el lenguaje es fundamental en el surgimiento de la inteligencia, a pesar de ser un canal de baja transferencia.

Resolviendo la Paradoja de Moravec

La Paradoja de Moravec7 es la observación, realizada originalmente en la década de 1980, de que lo que parece ser uno de los problemas más simples, como agarrar una tetera y verter té en una taza, resulta ser justamente el tipo de problema que la inteligencia artificial encuentra más desafiante de replicar. LeCun sostiene que el único ingrediente clave que ha hecho falta hasta ahora es una representación abstracta del mundo o cosmovisión. Se espera que esta cosmovisión sea fundamental para soportar todas las operaciones básicas de movilidad (ya sea un coche sin conductor o un androide), y también actuaría como la verdadera capa fundamental de una AGI.

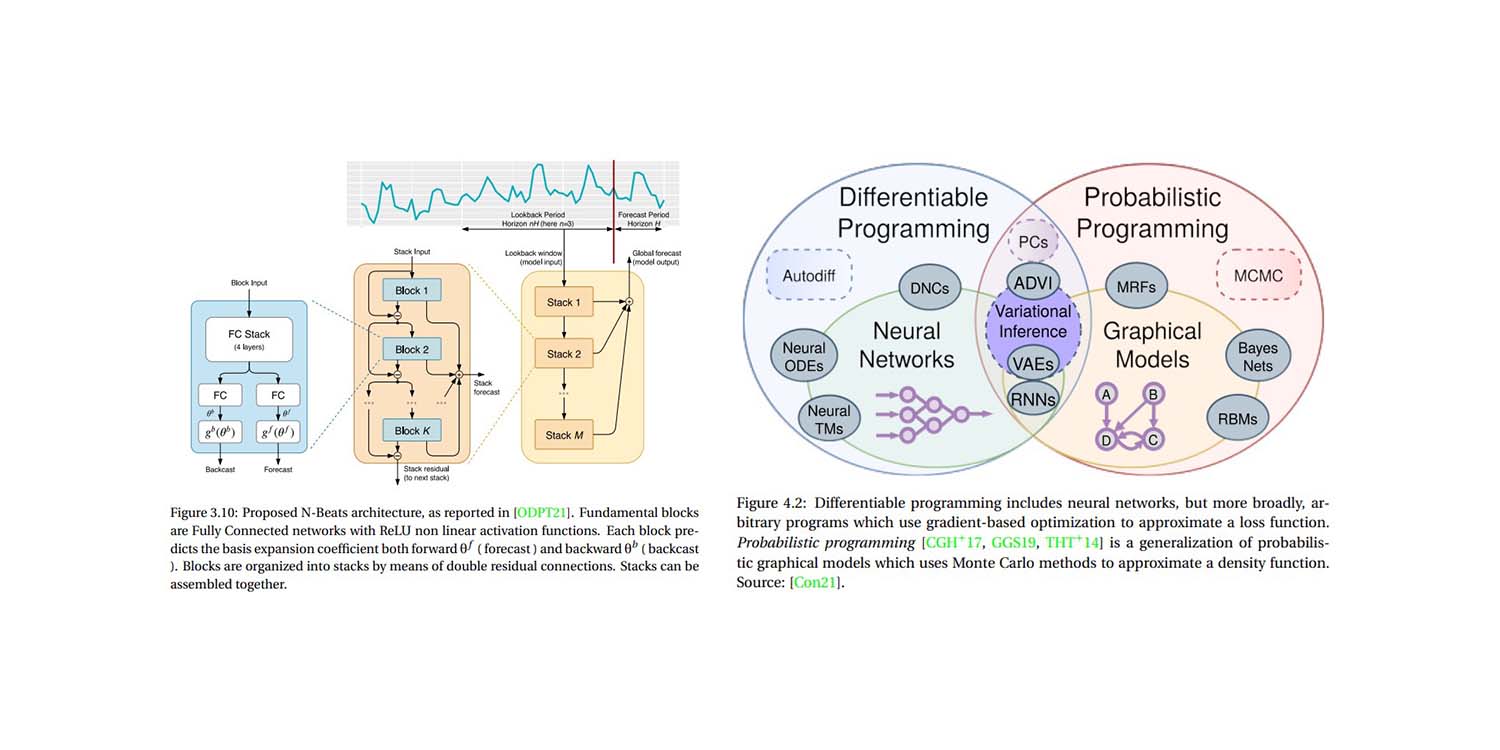

Actualmente, según LeCun, los LLMs no saben nada porque ni siquiera tienen una noción del mundo en sí. De ello se deduce que lo único de los LLMs es una imitación elaborada. Esto no nos llevará completamente a la AGI porque, bueno, los LLMs son simplemente muy buenos fingiendo inteligencia. Además, la falta de una cosmovisión los condenará a quedar perplejos para siempre ante aspectos mundanos de nuestra realidad básica que son tan evidentes que los humanos ni siquiera se molestan en ponerlos en palabras (y quizás ni siquiera podrían hacerlo). LeCun propone que los métodos de joint-embedding aplicados a datasets de visión son actualmente la mejor oportunidad que tenemos para crear esta cosmovisión, la cual más adelante allana el camino hacia la AGI.

No estoy de acuerdo con esta perspectiva en dos niveles.

Primero, la Paradoja de Moravec no es para nada una paradoja cuando se aborda desde la perspectiva correcta. La hipótesis implícita de percibir esta situación como una “paradoja” es que la movilidad animal (y la planificación animal) es más “crianza” que “naturaleza”. En otras palabras, adquirir movilidad es el resultado de un proceso de aprendizaje – uno que ha resultado increíblemente difícil de replicar mediante medios artificiales durante las últimas cuatro décadas.

Mi propuesta es que, en gran medida, no se trata de un proceso de aprendizaje en absoluto. Consideremos que los potros (y otros miembros de la familia de los caballos, como burros y cebras) pueden ponerse de pie y caminar a las pocas horas de nacer. Pensar en este proceso como “aprendizaje” es incorrecto. Es mucho más adecuado considerar este proceso como una especie de “calibración”. Todas las estructuras cognitivas están casi completamente desarrolladas. El sistema solo necesita ser empujado un poco para que las vías se acomoden.

Este aspecto en gran parte innato de la movilidad y la planificación animal es menos evidente en los humanos, porque, en comparación con casi todos los demás mamíferos, los nacimientos humanos son extremadamente prematuros, debido a que el desarrollo de la cabeza es el cuello de botella para una gestación más prolongada. Lo que muchas personas perciben como que los infantes “aprenden cosas” es, en realidad, un desarrollo cognitivo que avanzaría sin impedimentos si el bebé permaneciera en el útero unos meses más.

Es lógico pensar que esas estructuras cognitivas, al ser en gran parte innatas, también son producto de la evolución. Esas estructuras han tenido (más o menos) 800 millones de años de presión evolutiva incesante para mejorar, a lo largo de un número increíblemente grande de individuos. Así, si tomamos la movilidad animal actual como la base de lo que deseamos de una máquina, no es sorprendente que esta base resulte ser increíblemente difícil de superar. El desafío es tan difícil como diseñar un dispositivo que supere a los árboles en convertir la luz solar en material estructural, o competir con los ribosomas como fábricas de macromoléculas. Superar a la evolución en juegos que se han jugado durante eras resulta brutalmente difícil.

Sin embargo, habilidades abstractas, como contar historias, solo han formado parte del juego evolutivo durante los últimos 1 a 5 millones de años (más o menos). Además, el número de individuos también era increíblemente limitado, ya que los grandes simios no solo son muy raros (dejando de lado a los humanos modernos) sino que también tienen una larga vida, lo que ralentiza el proceso evolutivo, al menos en comparación con la mayoría de los otros animales. Así, para lograr la movilidad, nos queda diseñar lo que la naturaleza probablemente hace mediante cientos de heurísticas intrincadamente acopladas. Esas heurísticas pueden girar en torno a algún tipo de “cosmovisión” interna como sugiere LeCun, pero mi instinto me dice que no es así. Estoy profundamente escéptico de que un caracol tenga alguna cosmovisión. Sin embargo, el caracol puede percibir y navegar correctamente por el complejo laberinto 3D que representa la vegetación. Los caracoles toman decisiones inteligentes, pero sin una cosmovisión inteligente.

Así, como segundo punto de desacuerdo, no veo el concepto de cosmovisión de LeCun como algo más que periférico a la aparición de la AGI. Mi postura es que la “cosmovisión” (tal como la ve LeCun) será uno de esos módulos opcionales que una AGI podría aprovechar para tareas especializadas que requieran movilidad, exactamente como un módulo aritmético; sin embargo, fundamentalmente, no serán necesarios para la propia AGI.

En la naturaleza, una “cosmovisión” fue un camino evolutivo necesario hacia la AGI porque los animales no pueden saltar directamente hacia la inteligencia general. Sin embargo, las máquinas no tienen esa limitación, siempre y cuando existan humanos que satisfagan sus necesidades (por ejemplo, energía, materiales) mientras juntos descubrimos cómo resolver los últimos detalles frustrantes, como hallar sustitutos inorgánicos para las fibras musculares, y todo tipo de problemas que la evolución ha resuelto de maneras que no se prestan a la industrialización.

No obstante, aunque no creo que el camino impulsado por la visión que persigue LeCun conducirá a la AGI, sí creo que este camino tiene una probabilidad bastante buena de resolver el problema de la movilidad, que es un gran problema que merece una buena solución.

Planificación jerárquica

A través de la anécdota de planificar un viaje de París a Nueva York, LeCun ilustra que carecemos de soluciones verdaderamente generales para abordar la planificación jerárquica. Para cualquier problema dado, de alguna manera podemos inventar jerarquías ad hoc, pero no tenemos nada cercano a poder realizar este proceso automáticamente operando dentro de espacios de representación abstracta. Aunque estoy de acuerdo con LeCun en que no tenemos las capacidades para ello (es decir, la planificación jerárquica en espacios de representación abstracta), discrepo de que no exista un camino para una planificación jerárquica efectiva.

Propongo que la planificación jerárquica puede resolverse de manera satisfactoria – con completa automatización – mediante texto, es decir, al estilo LLM. Poder aprovechar los espacios de representación abstracta es una idea atractiva, pero al igual que si no podemos tener reactores de fusión, nada nos impide utilizar lo siguiente: reactores de fisión, que también representan una respuesta satisfactoria a ese problema en particular (producción de energía).

Volviendo al viaje de París a Nueva York, la planificación a través de palabras es increíblemente eficiente porque la humanidad se ha organizado mediante esas palabras. No existe tal cosa como un “taxi” desde una perspectiva de ingeniería automotriz: es simplemente un coche común. Lo que hace que el concepto de “taxi” sea tan efectivo en términos de planificación es que, en cualquier aeropuerto, el viajero puede esperar encontrar una serie de señales de taxi – que llevan la palabra “taxi” – que conducen a un lugar donde se pueden alquilar los servicios de un conductor (con un coche) de manera relativamente económica y a demanda.

LeCun propone desacoplar la planificación jerárquica del lenguaje como si se diera por sentado que eso resultaría en una mejor planificación, liberada de preocupaciones lingüísticas accidentales e intrascendentes. Yo sostengo que esas preocupaciones no son ni accidentales ni intrascendentes. Las señales de taxi son físicamente reales y, cuando no hay suficientes de esas señales, los viajeros se pierden y se angustian.

A diferencia del reino animal, la planificación en entornos de inteligencia general – es decir, la planificación dentro de una civilización – se realiza de manera más eficiente al ceñirse rigurosamente a las abstracciones acordadas. Por ejemplo, el concepto de “enchufe US” significa muy poco para un físico, pero para nuestro viajero que va de París a Nueva York, anticipar la necesidad de un adaptador de enchufe US para cargar su smartphone es una jugada inteligente. Nuevamente, adquirir un “adaptador de enchufe US” se hará revisando lo que dice la caja antes de comprar el dispositivo.

La civilización se forma a través del lenguaje, y el lenguaje la forma a su vez. Estoy abierto a la idea de que exista algo mejor que el lenguaje para realizar una planificación verdaderamente general y profundamente estratificada. Sin embargo, esto está lejos de ser tan evidente como LeCun lo plantea. Una AGI tendrá que operar en el mundo de los humanos durante mucho tiempo. Siglos más adelante, las AGI podrían prescindir por completo del lenguaje tokenizado, posiblemente comunicándose y planificando a través de embeddings derivados de cosmovisiones acordadas. Sin embargo, esto es altamente especulativo.

Mi postura es que la AGI más allá de los humanos empezaría simplemente mejorando los propios constructos lingüísticos. Pocas personas se dan cuenta de lo estrechamente que la ciencia ha progresado paralelamente al lenguaje. Muchas cosas que hoy consideramos evidentes solo lo son porque tenemos las palabras adecuadas para ellas, con la semántica correcta adjunta. El Sol es una estrella como todas las demás, o, viceversa, las estrellas son simplemente soles distantes. Sin embargo, hasta que Giordano Bruno postuló que así era en el siglo XVI, el Sol y las estrellas se percibían como completamente diferentes en su naturaleza. Por lo tanto, cuando obtengamos AGI, es razonable suponer que simplemente retomará el proceso lingüístico, al menos por un tiempo.

Aprendizaje e inferencia

En los LLMs actuales, la optimización matemática solo ocurre durante la etapa de aprendizaje, mientras que la inferencia es un proceso no iterativo de una sola etapa (véase el contestador automático de recursos constantes discutido anteriormente). Dado que una pregunta más difícil debería requerir más esfuerzo para ser respondida, LeCun postula que la optimización debería ocurrir durante el proceso de inferencia. En otras palabras, si tuviéramos algún tipo de proceso de optimización orientado a la búsqueda de la verdad para aplicar a la etapa de inferencia del LLM, este proceso encajaría perfectamente con lo que esperamos tanto de preguntas fáciles como difíciles.

Aquí, LeCun especula abiertamente sobre las características de sistemas superiores, y aunque no estoy de acuerdo, mi desacuerdo es tan especulativo como la proposición planteada por LeCun. Así que, tómalo con pinzas. En pocas palabras, mi postura es que la esencia del problema es segregar incorrectamente el aprendizaje de la inferencia. No es tanto que la inferencia carezca de optimización, sino que el aprendizaje y la inferencia se están segregando cuando no deberían serlo.

Para desentrañar esta proposición, consideremos que uno de los defectos más graves que percibo en los LLMs es su extraño comportamiento en lo que respecta al aprendizaje —al menos si el objetivo es la AGI—. Este comportamiento es extraño en tres aspectos.

Primero, los LLMs son bastante insensibles a corpus de baja calidad al inicio de su proceso de entrenamiento y se vuelven cada vez más sensibles a medida que este avanza. Una vez que llegamos a la etapa de afinación avanzada, incluso una cantidad muy mínima de entrada basura puede desmoronar completamente todo el LLM (ya lo he vivido).

Este comportamiento es exactamente lo opuesto a lo que esperaría de un sistema que adquiere “inteligencia” de forma gradual. Como experimento mental, imagina si dos personas tuvieran que escuchar una charla de 15 minutos argumentando que la tierra es plana. La primera persona es un niño de 5 años; la segunda, un niño de 15 años. Es evidente que las probabilidades de alterar el sistema de creencias del niño más joven son mucho mayores que lograr el mismo resultado con el niño mayor. Así, conforme envejecemos y ganamos inteligencia, nos volvemos más resilientes a la entrada basura. Naturalmente, esto plantea el problema de rigidez mental ante conceptos falsos, pero, en definitiva, volverse competente en descartar información falsa es una habilidad vital que todo ser humano funcional debe dominar hasta cierto grado.

Segundo, los LLMs aprenden procesando la entrada de manera completamente aleatoria. Por ejemplo, un LLM podría recibir al azar fragmentos de la base de código del kernel de Linux, regulaciones contables oscuras de Escocia y letras de canciones de jardín de infantes. El LLM en entrenamiento sigue ingiriendo documentos seleccionados aleatoriamente y progresa a medida que se incorporan más documentos, pero todo el proceso resulta un poco desconcertante.

De la misma manera, es obvio que si unos padres insanos decidieran pasar horas cada día leyendo tratados, en orden aleatorio, sobre física cuántica a su bebé, es probable que esto no resulte propicio para un desarrollo intelectual saludable. Los padres instintivamente saben que deben empezar de forma simple e ir aumentando gradualmente la sofisticación de los materiales a medida que se desarrolla la inteligencia del niño. Aunque una inteligencia mecánica no tiene que cumplir con todas las propiedades de la inteligencia humana, soy bastante escéptico de que el génesis de una inteligencia mecánica pueda eludir por completo cualquier tipo de progresión intelectual.

Tercero, los LLMs son increíblemente ineficientes en lo que respecta a sus materiales fuente. En términos de habilidades brutas de razonamiento, se requieren el equivalente a cientos de vidas de sesiones de lectura para que el LLM adquiera habilidades que muchos humanos obtienen en menos de 20 años. LeCun menciona este mismo defecto, y lo atribuye a la falta de una cosmovisión (véase arriba). Mi opinión es muy distinta: espero que una inteligencia máquina verdaderamente bien diseñada pueda madurar con menos información lingüística de la que un humano típico recibe en sus primeros 20 años de vida.

De hecho, como observación casual, las personas inteligentes son capaces de hacer mucho más, intelectualmente hablando, con mucho menos. Dichas personas no requieren que se les reexpongan las cosas desde cinco perspectivas diferentes —las “redundancias son buenas” mencionadas por LeCun— para “captarlo”. Ellos leen entre líneas. Hacen las derivaciones correctas a partir de la pequeña pieza de evidencia que tienen frente a ellos. Incluso pueden permitirse estar bastante distraídos al ingerir materiales (por ejemplo, una charla, un libro), y luego completar correctamente los vacíos.

Así, volviendo a mi proposición original de que el problema radica en la segregación entre aprendizaje e inferencia, lo que probablemente le falta a los LLMs (mi humilde corazonada) es una capacidad de “escucha activa” —mientras que ahora solo poseen una de “escucha pasiva”. Cada vez que el sistema responde una pregunta, debería actualizar correspondientemente su estado cognitivo interno. De hecho, el proceso por el cual una inteligencia (máquina o humana) responde una pregunta debería conducir a la mejora de dicha inteligencia. Al responder una pregunta novedosa, algo debe haberse aprendido.

Los LLMs ya albergan una chispa de este potencial. Consideremos el chat GPT4-Turbo (véase Anexo 1) a continuación. La pregunta básica que propuse es ¿Crees que la teoría del valor-trabajo es correcta?. En su primera respuesta en el chat, el LLM no es capaz de ofrecer la respuesta correcta. En cambio, regurgita la confusión ambiental que se encuentra en internet, arrojando una lista al azar de argumentos presentados por innumerables personas sobre el tema. Sin embargo, cuando se le solicita nuevamente que razone y llegue a una conclusión real, en lugar de mostrarse indeciso, el LLM llega a la conclusión correcta. Alerta de spoiler: esta teoría del valor-trabajo ha sido refutada. Una gran respuesta a esta pregunta habría comenzado con La teoría del valor-trabajo es una teoría, ahora refutada, que fue instrumental para el progreso de la economía … o algo por el estilo. Sin embargo, dado que el LLM nunca tuvo la oportunidad de asimilar activamente la información recibida, este entendimiento nunca se cristalizó.

Veo varias formas de dotar a los LLMs de esta capacidad de escucha activa, lo cual incluiría escuchar las respuestas que ellos mismos producen. Una forma podría ser una especie de enfoque de “monólogo interno”, en el que cada entrada se transforma en una salida, utilizando dicha salida posteriormente para el aprendizaje. Este patrón atendería los dos primeros problemas mencionados: la entrada tendría que proporcionarse en un orden sensato para lograr el resultado deseado (empezando de forma simple y aumentando la sofisticación posteriormente); y el LLM se volvería cada vez más capaz de desechar entradas inservibles, ya que es la salida la que se utiliza para el aprendizaje y no la entrada.

Otra alternativa podría ser una variante del enfoque basado en energía propuesto por LeCun. El actual paso de SGD (descenso de gradiente estocástico) aplicado a cada documento ingerido por el LLM representa únicamente la parte de escucha pasiva. Se requeriría un proceso complementario para comprimir o restringir el sistema de creencias del LLM a una región más pequeña del espacio cada vez que se ingiere una nueva entrada, incluso una simple pregunta. Se debería introducir un proceso de optimización numérica para actuar como un mecanismo buscador de la verdad, que probablemente adoptaría la forma de procurar una mayor auto-consistencia para las salidas.

Conclusión

Yann LeCun es un gran científico, y esta entrevista plantea una serie de cuestiones fundamentales. Si la humanidad logra crear una AGI en 20 años o en 200 dependerá realmente de la rapidez con la que podamos conseguir tanto las preguntas correctas como las respuestas adecuadas. LeCun apuesta por los datos en video para allanar el camino hacia la AGI. Aunque creo que LeCun tiene una posibilidad razonable de obtener algo verdaderamente notable de sus esfuerzos de investigación, a saber, resolver el problema centenario de la movilidad general en la robótica, soy muy escéptico de que ello contribuya a la AGI. Mi humilde opinión es la contraria: ya disponemos de más datos textuales de los que realmente necesitaríamos. Simplemente nos faltan paradigmas novedosos. Si mi corazonada resulta correcta, será una noticia fantástica para la humanidad, ya que los paradigmas nunca pueden ser propiedad de nadie, y mucho menos monopolizados. Además, los paradigmas son económicos. Sin embargo, incluso si mi corazonada resulta ser incorrecta, me alegra que el Chief AI Scientist de Meta sea un entusiasta y firme defensor del open-source.

Anexo: Chat, una crítica a la teoría del valor-trabajo

Joannes: ¿Crees que la teoría del valor-trabajo es correcta?

ChatGPT: La teoría del valor-trabajo es un concepto fundamental de la economía clásica, particularmente asociado con Adam Smith, David Ricardo y, de manera más prominente, Karl Marx. Propone que el valor de una mercancía se puede medir objetivamente por el número promedio de horas de trabajo requeridas para producirla. Esta teoría ha influido en el pensamiento económico, especialmente en la economía marxista, que la utiliza para analizar las sociedades capitalistas y la explotación laboral. Sin embargo, la teoría del valor-trabajo es objeto de debate y crítica, especialmente desde la perspectiva de la economía neoclásica y las teorías marginalistas que surgieron a finales del siglo XIX y comienzos del siglo XX. Estas teorías sostienen que el valor es subjetivo y está determinado por las preferencias individuales y la utilidad marginal de los bienes, en lugar de únicamente por el trabajo invertido en ellos. Algunas críticas de la teoría del valor-trabajo incluyen:

- Subjetividad del Valor: Los economistas marginalistas argumentan que el valor es subjetivo y depende de las preferencias individuales, necesidades y el contexto en el que se toman decisiones. Por ejemplo, el agua en un desierto tiene un valor distinto al del agua en una región con abundancia de lagos, independientemente del trabajo involucrado en obtenerla.

- Negligencia del Capital y el Emprendimiento: Los críticos sostienen que la teoría del valor-trabajo subestima o ignora los roles del capital, el riesgo y el emprendimiento en el proceso de producción. Estos factores pueden afectar significativamente el costo y el precio de bienes y servicios.

- Cambio Tecnológico y Productividad: La teoría no explica por completo cómo los avances tecnológicos y las mejoras en productividad afectan el valor. Por ejemplo, la automatización puede reducir drásticamente el trabajo necesario para producir bienes, lo que puede llevar a discrepancias significativas entre el valor laboral y el precio de mercado.

- Variabilidad de la Habilidad y la Intensidad: La teoría asume que todas las horas de trabajo son iguales, pero en realidad la habilidad, la intensidad y la productividad del trabajo pueden variar considerablemente. Esto dificulta estandarizar la medida del valor del trabajo. A pesar de estas críticas, la teoría del valor-trabajo sigue siendo un concepto importante para comprender la historia económica y la evolución del pensamiento económico. Ha influido especialmente en las críticas al capitalismo y en las discusiones sobre la desigualdad de ingresos, la explotación y la distribución de la riqueza. Si uno la considera “correcta” o no, puede depender en gran medida de su filosofía económica, sus valores y los aspectos de la actividad económica que se destaquen.

Joannes: Como hipótesis científica comprobable, y muchas veces puesta a prueba, ¿consideras que esta teoría está demostrada o refutada? Razona al respecto y luego concluye. Tu conclusión debe ser demostrada o refutada, sin lugar a términos intermedios.

ChatGPT: Al evaluar la teoría del valor-trabajo como una hipótesis científica comprobable, es crucial considerar la metodología del análisis económico y los criterios para demostrar o refutar teorías en las ciencias sociales, que pueden diferir intrínsecamente de las ciencias naturales debido a la complejidad del comportamiento humano y de los sistemas económicos.

Testabilidad y Evidencia Empírica:

- La teoría del valor-trabajo postula que el valor de una mercancía está determinado por el trabajo requerido para producirla. Este principio puede comprobarse parcialmente examinando la correlación entre los costos laborales y los precios de mercado. Sin embargo, la evidencia empírica ofrece un panorama mixto. Aunque a menudo existe una correlación entre la entrada de trabajo y los precios, numerosas excepciones se deben a dinámicas de oferta y demanda, cambios tecnológicos y preferencias de los consumidores.

- Además, la teoría tiene dificultades para explicar el valor de bienes que requieren poco o ningún trabajo para producir (como bienes digitales o recursos naturales), pero que pueden alcanzar altos precios de mercado debido a su escasez o demanda.

Consenso Científico y Críticas:

- La aparición de la economía marginalista y neoclásica introdujo el concepto de valor subjetivo y utilidad marginal, que proporciona un marco más flexible para comprender la formación de precios y el comportamiento del consumidor. Estos modelos explican de manera más adecuada las variaciones en los precios que no pueden atribuirse únicamente al trabajo.

- La teoría del valor-trabajo ha sido criticada por no explicar adecuadamente el papel del capital, el riesgo, el emprendimiento y la innovación tecnológica en la creación del valor.

Conclusión: Dado el criterio para la prueba científica, que exige evidencia consistente, reproducible y capacidad predictiva, la teoría del valor-trabajo como explicación universal para la determinación del valor en la economía está refutada. Aunque captura ciertos aspectos de la creación de valor y puede explicar algunos fenómenos económicos, no logra abarcar la complejidad total de cómo se determinan los precios en una economía de mercado. La teoría no se sostiene frente a la evidencia empírica en diversos contextos económicos y ha sido reemplazada por teorías que acomodan mejor la amplia gama de factores que influyen en el valor y el precio.

-

Yann LeCun: Meta AI, Open Source, Limits of LLMs, AGI & the Future of AI | Lex Fridman Podcast #416 ↩︎

-

Vea la entrevista a Geoffrey Hinton concedida al New York Times, ‘The Godfather of A.I.’ Leaves Google and Warns of Danger Ahead, 1 de mayo de 2023. ↩︎

-

El uso del conocimiento en la sociedad, por Friedrich Hayek, septiembre de 1945 ↩︎

-

Por ejemplo, en 2022, el presidente de TSMC, Mark Liu, recordó al público que si China invadiera Taiwán y capturara las instalaciones de TSMC y a su personal, las capacidades productivas de TSMC se volverían inoperables simplemente porque sus socios occidentales dejarían de apoyarlos. ↩︎

-

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models, Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, Denny Zhou, enero de 2022. ↩︎