Una prospettiva sfumata sul confine tecnologico frastagliato della Harvard Business School

La qualità è soggettiva; il costo non lo è.

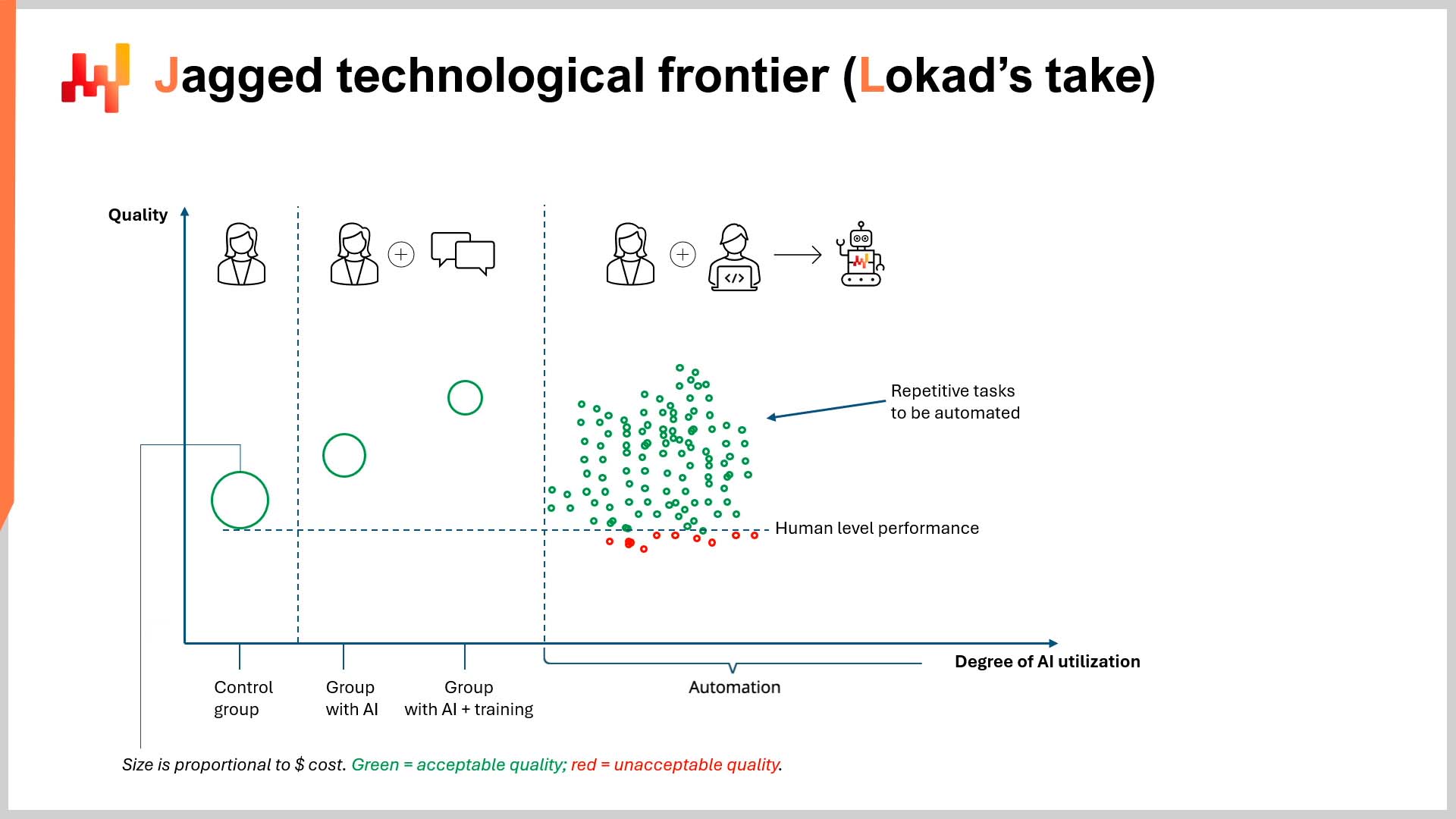

Recentemente, in un episodio di LokadTV, ho suggerito che un documento della Harvard Business School (HBS), realizzato in collaborazione con il Boston Consulting Group (BCG), fosse profondamente difettoso e potenzialmente pericoloso. Il titolo completo del documento è Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge, Worker Productivity, and Quality1. In sintesi, il documento sosteneva che le capacità dell’IA in compiti impegnativi sono distribuite in modo non uniforme: eccelle in alcuni e si comporta male in altri (compiti interni ed esterni al confine, rispettivamente).

Contesto

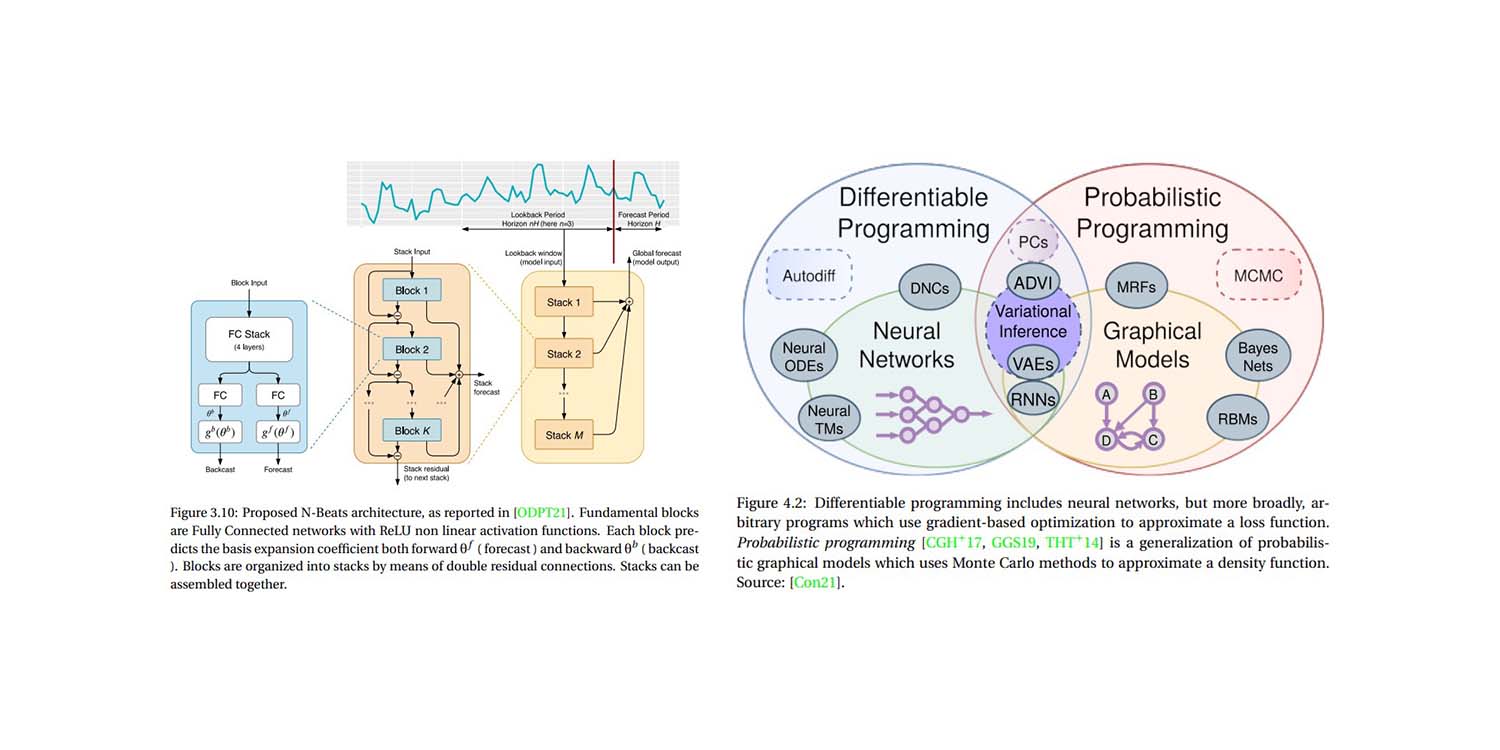

Dall’altra parte di questo “confine tecnologico frastagliato” (vedi illustrazione a p. 27 del documento), l’expertise umana supera ancora l’IA (in questo caso, ChatGPT-4), soprattutto in compiti che combinano analisi quantitativa e qualitativa (cioè, compiti “fuori dal confine”).

Questo non dovrebbe sorprendere chiunque sia familiare con ciò per cui sono progettati i modelli linguistici di grande dimensione (LLMs) come ChatGPT (spoiler: non per la matematica). Inoltre, quando gli LLM vengono trattati come un “database di tutto” producono risposte plausibili ma talvolta imprecise2. Tuttavia, il documento solleva alcuni punti interessanti - seppure accidentalmente.

A suo favore, il documento è molto leggibile, una caratteristica spesso carente in ambito accademico. Detto ciò, si potrebbero sollevare alcune preoccupazioni riguardo ai potenziali conflitti di interesse3 e ai risultati del documento4, tuttavia è la metodologia e l’economia implicita del documento a costituire l’argomento principale qui.

Critica della Metodologia

Per quanto riguarda la metodologia, questo punto è già stato criticato nel video, quindi sarò breve qui. Il team di ricerca non ha esplorato i guadagni di produttività generati dall’automazione. Invece, i ricercatori hanno selezionato gruppi di consulenti (cioè, non specialisti in AI, informatica e/o ingegneria) per utilizzare ChatGPT-4. L’unica eccezione a ciò è stata il gruppo di controllo, che ha lavorato basandosi esclusivamente sulla propria competenza. L’etica di come questi gruppi sono stati valutati sarà menzionata a breve.

Non c’erano ingegneri del software esterni o esperti in AI nell’esperimento. Nessun team di sviluppatori esperto in retrieval augmented generation (RAG), fine-tuning specifico per dominio, o altre tecniche che sfruttano i maggiori punti di forza degli LLM: la loro resilienza al rumore e la capacità di generare modelli universali.

Questo impressionante robot non è stato programmato per sfruttare la conoscenza specifica di settore immagazzinata nei vasti database interni di BCG relativi a precedenti iniziative di consulenza. Al contrario, l’esperimento ha coinvolto alcuni consulenti in possesso di un abbonamento a ChatGPT-4.

Questa orchestrazione ha naturalmente prodotto gradi variabili di output (in termini di qualità), in particolare per quanto riguarda i compiti che richiedono sia analisi quantitative che qualitative. In altre parole: l’esperimento è stato progettato per verificare quanto i non esperti falliscano nel capitalizzare una tecnologia sofisticata, e in condizioni irrealisticamente restrittive.

Come ho concluso nel video, ignorare i possibili guadagni di produttività (e risparmi) generati dall’automazione sfiora lo scandalo. Questo è particolarmente vero quando si pubblica a nome di un prestigioso istituto di formazione. A mio parere, i risultati del documento offrono anche una falsa sensazione di sicurezza lavorativa agli studenti che stanno per contrarre debiti che cambieranno la loro vita, al fine di studiare in una top business school. Lo stesso vale per chi ha già fatto il grande salto ed ha contratto debiti considerevoli per ottenere diplomi in settori che potrebbero essere sull’orlo della piena automazione.

Critica della Prospettiva Economica

Nonostante le numerose critiche sopra esposte, a mio avviso l’economia implicita del documento è molto più affascinante. In parole povere, la Harvard Business School ha misurato solo $${quality}$$ dell’output, e non $${cost}$$ dell’output5.

In nessun momento (e per favore verificate) i ricercatori hanno misurato il costo associato all’output del lavoro dei consulenti. Questo non è affatto un punto banale. Il documento menziona la parola “quality” 65 volte in 58 pagine (incluso il titolo del documento). La parola “cost” viene menzionata…2 volte…e solo nell’ultima frase del documento. Riporto quella frase qui per il contesto:

“Analogamente a come internet e i browser web hanno drammaticamente ridotto il costo marginale della condivisione delle informazioni, l’AI potrebbe anche abbassare i costi associati al pensiero e al ragionamento umano, con effetti potenzialmente ampi e trasformativi.” (p. 19)

Anche quando la Harvard Business School ha finalmente riconosciuto il concetto di costo finanziario, non è stato in termini di riduzione dei costi per generare lavori di alta qualità senza la necessità di laureati costosi delle business school. Ciò può sembrare ovvio considerando che il titolo del documento individua “productivity” e “quality” come punti centrali della ricerca, senza contare il fatto che una business school costosa difficilmente pubblicizzerà la propria potenziale inutilità imminente.

Detto ciò, suggerisco cortesemente che misurare $${productivity}$$ e $${quality}$$ dell’output senza una solida prospettiva finanziaria è praticamente insignificante, particolarmente in un documento accademico di una business school. Ciò è particolarmente grave, dato che il punto centrale dell’AI è che essa rappresenta un grande livellatore in termini di potere fiscale.

L’IA fornisce risultati di altissima qualità a costi molto bassi, soprattutto attraverso l’automazione. Questo rapporto $${quality/cost}$$ è di ordini di grandezza superiore a quello dei lavoratori umani6. Inoltre, apre la porta a chiunque abbia un abbonamento a ChatGPT e una certa conoscenza della programmazione. Ciò livella drasticamente il campo di gioco in termini di concorrenza tra i grandi e i piccoli.

Invece, per 58 pagine, la Harvard Business School valuta la “quality” del lavoro dei consulenti BCG in isolamento. Come è stata determinata questa qualità? Da “valutatori umani”…che lavorano per BCG7. Mettiamo da parte i manifesti conflitti di interesse già dettagliati, vale la pena osservare la falsa dicotomia presentata nel documento, e come essa influenzi l’economia implicita. Questa falsa dicotomia si articola più o meno così:

“L’AI è o migliore o peggiore rispetto all’expertise umana.”

O forse un’interpretazione più generosa è:

“L’AI rende gli esseri umani migliori o peggiori nel loro lavoro.”

In ogni caso, la metrica sottesa alla falsa dicotomia nel documento è la “quality”, che viene misurata soggettivamente ed esiste in un vuoto accademico, indipendentemente da altri vincoli, come tempo, efficienza e costo. Una prospettiva economica più sofisticata sarebbe qualcosa del tipo:

Qual è il rapporto $${quality/cost}$$ dell’output umano rispetto al rapporto $${quality/cost}$$ dell’automazione AI?

I lettori più sofisticati riconosceranno questo come un argomento di ROI (ritorno sull’investimento). Il tuo rapporto personale $${quality/cost}$$ può essere scoperto rispondendo alle seguenti domande:

- Quanto era valido l’output per un determinato compito?

- Quanto è costato?

- La qualità giustificava il costo?

- Quanto costerebbe migliorare la qualità, e tale miglioramento sarebbe finanziariamente vantaggioso?

La Harvard Business School dedica 58 pagine a discutere la prima domanda e non va oltre. È una prospettiva peculiare per una business school, si sa. Infatti, si può tracciare un parallelo interessante con la supply chain. La cieca ricerca della qualità da parte di HBS è sorprendentemente simile alla ricerca isolata di forecast accuracy (cioè, cercare di migliorare l’accuratezza delle previsioni senza considerare il ROI associato a tale miglioramento)8.

Implicazioni Potenziali

Dal punto di vista economico, il “confine tecnologico frastagliato” non si limita a identificare in quali compiti gli LLM performano meglio degli umani. Piuttosto, identifica il tuo ideale rapporto $${quality/cost}$$ quando si sfruttano gli LLM, consentendo decisioni intelligenti e informate finanziariamente. Per gli imprenditori esperti, questo comporterà l’automazione, non l’intervento manuale (o almeno molto poco di esso).

Per questi imprenditori, forse è accettabile un livello di qualità comparabile, purché sia efficiente in termini di costo. “Accettabile” può significare la stessa cosa o una qualità leggermente migliore/peggiore rispetto a quella che un esperto umano può generare. In altre parole, pagare lo 0,07% del prezzo di un consulente per oltre il 90% della qualità potrebbe rappresentare un ottimo compromesso, nonostante non sia esattamente allo stesso livello dell’output dell’esperto costoso9.

I numeri varieranno per ogni cliente, ma è dimostrabilmente chiaro che esiste un punto di svolta oltre il quale la “quality” non è più una preoccupazione isolata e deve essere valutata rispetto al suo costo finanziario. Questo è almeno vero per le imprese intenzionate a rimanere in attività.

Forse ritieni che assumere un team di laureati della Harvard Business School, o consulenti di BCG, rappresenti un rapporto $${quality/cost}$$ ideale, indipendentemente da opzioni più economiche come l’automazione AI. Se è così, spero che tu possa vivere a lungo e prosperare10.

Oppure, forse pensi come me: la qualità è soggettiva; il costo non lo è. La mia valutazione soggettiva della qualità - certamente in ambito business - è relativa al suo costo. Simile ai service levels (o all’accuratezza delle previsioni) nella supply chain, un incremento extra dell'1% nella qualità (o nell’accuratezza) probabilmente non giustifica un aumento del 1.000% del costo. Di conseguenza, quando si tratta di AI in ambito business si deve fare un compromesso economico tra qualità e costo. È fondamentale non perdere di vista questo, come sembra abbia fatto la Harvard Business School.

In conclusione, se stai aspettando che l’AI superi la qualità umana prima di adottarla, ben venga, ma il resto di noi non aspetterà insieme a te.

-

Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality, Dell’Acqua, Fabrizio e McFowland, Edward e Mollick, Ethan R. e Lifshitz-Assaf, Hila e Kellogg, Katherine e Rajendran, Saran e Krayer, Lisa e Candelon, François e Lakhani, Karim R., settembre 2023 ↩︎

-

In AI Pilots for Supply Chain, Joannes Vermorel ha paragonato questo approccio da “coltellino svizzero” al chiedere a un professore molto intelligente di ricordare i dettagli di un documento che aveva studiato una volta. A memoria, il professore ricorderà l’idea generale, ma potrebbe non ricordare necessariamente tutte le sfumature se non vengono poste le giuste domande di approfondimento per stimolare la sua memoria. ↩︎

-

BCG pubblicizza utilmente i suoi legami con molte delle migliori business school americane. Sentiti libero di indagare sulla presenza di BCG nei principali campus statunitensi. In alternativa, puoi consultare questo utile downloadable Excel che semplifica i dati. La tabella include quanti consulenti BCG attualmente frequentano MBA presso la Harvard Business School (74). Gli utenti possono trarre le proprie conclusioni. ↩︎

-

Una collaborazione tra una grande business school e una grande società di consulenza ha dimostrato che consulenti costosi (e costosamente formati) sono risorse preziose… Perdonate il mio minore stupore. Se lo siete, vi rimando cortesemente al downloadable Excel nella nota a piè di pagina precedente. ↩︎

-

E di certo non ha misurato quality divided by cost of output, come tratterò più avanti. ↩︎

-

È difficile fornire cifre precise su questo punto, ma supponiamo uno stipendio annuo superiore a $200,000 (USA) per un consulente di una qualsiasi grande azienda. Questa cifra è ragionevole basata su una rapida indagine su internet. I calcoli back-of-the-napkin di ChatGPT suggeriscono che un anno di lavoro di consulenza costerebbe circa $145 (in termini di costi di elaborazione di ChatGPT). Ovviamente, ciò non è terribilmente scientifico, ma anche se la cifra fosse sbagliata di tre ordini di grandezza, sarebbe comunque quasi il 30% in meno rispetto allo stipendio annuo di un singolo consulente. Consulta il ragionamento di ChatGPT qui: https://chat.openai.com/share/d9beb4b9-2dd3-4ac2-9e95-2cd415c76431. (Ringraziamenti ad Alexey Tikhonov per aver fornito il log della conversazione.) ↩︎

-

Vedi le pagine 9 e 15 del documento, nel caso dubitassi di ciò che hai appena letto. Se questo forse suggerisce un conflitto di interesse, ti rimando cortesemente al downloadable Excel nella nota a piè di pagina 3. ↩︎

-

Lokad ha trattato in dettaglio il valore dell’accuratezza delle previsioni in precedenza, quindi ecco un breve ripasso: concentrati sull’impatto finanziario delle tue decisioni nella supply chain, piuttosto che misurare i KPI (come l’accuratezza) indipendentemente dalle loro implicazioni finanziarie (cioè, ROI). In altre parole, se una previsione della domanda è più accurata del 10% ma fai il 20% in meno di soldi di conseguenza, è giusto dire che l’aumentata accuratezza non valeva il maggior costo. ↩︎

-

Circa un anno fa, Lokad ha iniziato a tradurre il proprio sito web in sei lingue utilizzando LLM. Prima di allora, ci eravamo avvalsi dei servizi dei traduttori professionisti. Il costo continuo per mantenere semplicemente le traduzioni era di circa $15,000-30,000 (US) all’anno per lingua. Pur essendo perfettamente disposti a riconoscere che i traduttori professionisti fornivano una qualità (relativamente) superiore, il rapporto $${quality/cost}$$ nell’utilizzo di un LLM è di gran lunga maggiore. In altre parole, la qualità che possiamo generare utilizzando un LLM è più che accettabile e significativamente più economica rispetto al nostro precedente accordo. È difficile quantificare adeguatamente i risparmi, ma tradurre in modo competente ogni singola risorsa che abbiamo mai prodotto (e che produrremo) in sei lingue in pochi minuti è esponenzialmente più economico e più efficiente in termini di tempo rispetto al sistema precedente. Se sei madrelingua francese, tedesco, spagnolo, russo, italiano o giapponese, sentiti libero di tradurre questo saggio nell’angolo in alto a destra della pagina e verifica tu stesso la qualità. ↩︎

-

Almeno fino a quando OpenAI non rilascerà ChatGPT-5. ↩︎