Eine nuancierte Perspektive auf die zerklüftete technologische Grenze der Harvard Business School

Qualität ist subjektiv; Kosten hingegen nicht.

In einer kürzlichen Folge von LokadTV, schlug ich vor, dass ein Papier der Harvard Business School (HBS), in Zusammenarbeit mit der Boston Consulting Group (BCG) durchgeführt, gravierende Mängel aufweist und potenziell gefährlich ist. Der vollständige Titel des Papiers lautet Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge, Worker Productivity, and Quality1. Kurz gesagt, das Papier behauptete, dass sich die Fähigkeiten der KI bei anspruchsvollen Aufgaben ungleichmäßig verteilen, da sie in einigen Aufgaben hervorragend ist und in anderen schlecht abschneidet (jeweils bei „inside“ und „outside the frontier“ Aufgaben).

Kontext

Auf der anderen Seite dieser „zerklüfteten technologischen Grenze“ (siehe Abbildung auf S. 27 des Papiers) übertrifft menschliche Expertise weiterhin die KI (in diesem Fall ChatGPT-4), insbesondere bei Aufgaben, die quantitative und qualitative Analysen verbinden.

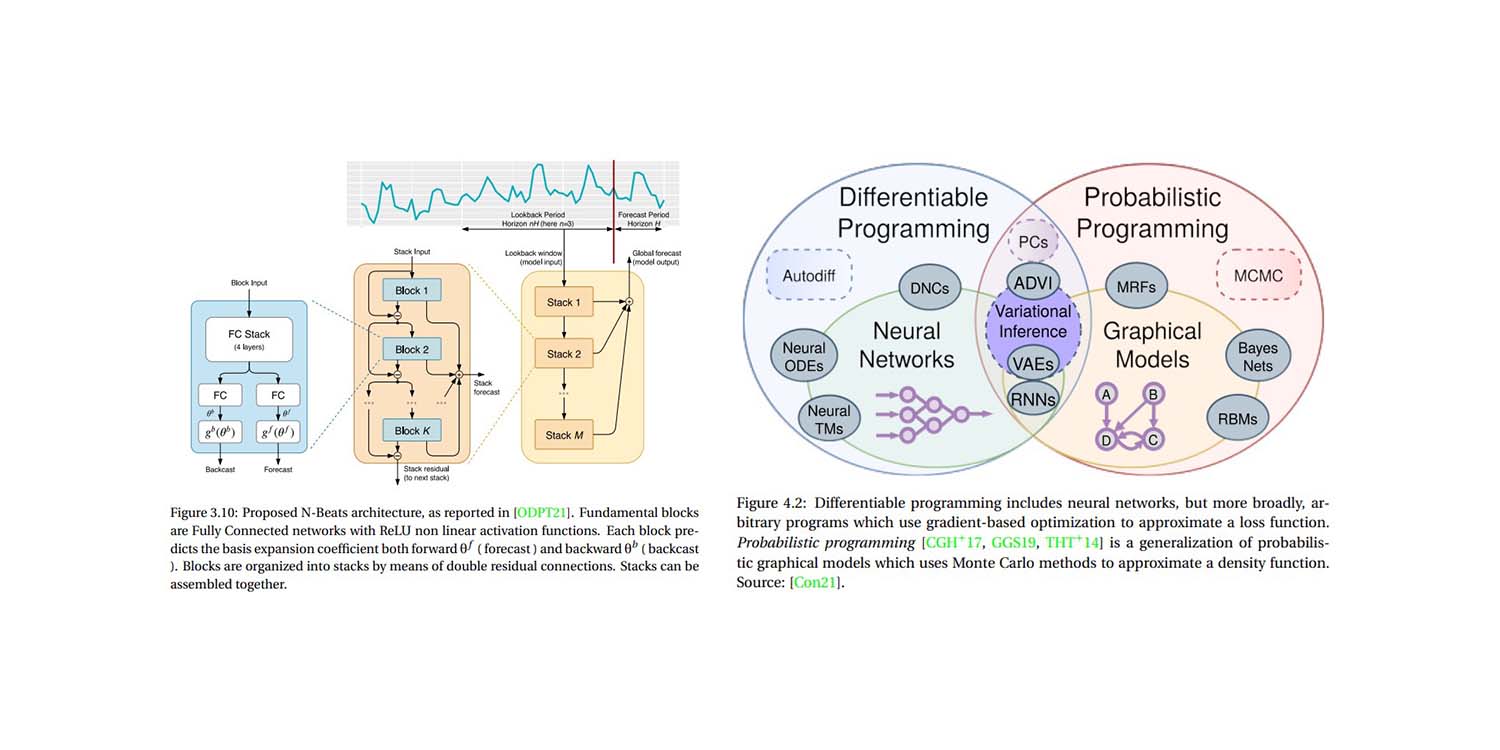

Dies sollte niemanden überraschen, der sich mit dem vertraut gemacht hat, wofür große Sprachmodelle (LLMs) wie ChatGPT eigentlich konzipiert sind (Spoiler: nicht für Mathematik). Auch wenn LLMs als „Datenbank von allem“ behandelt werden, liefern sie plausible, aber manchmal ungenaue Antworten2. Das Papier wirft jedoch – wenn auch nur zufällig – einige interessante Punkte auf.

Positiv anzumerken ist, dass das Papier sehr gut lesbar ist – etwas, das in der Wissenschaft oft stark zu wünschen übrig lässt. Dennoch könnte man ein paar Bedenken hinsichtlich möglicher Interessenkonflikte3 und seiner Ergebnisse4 äußern, wobei hier vor allem die Methodik und die implizite Ökonomie des Papiers von zentralem Interesse sind.

Kritik an der Methodik

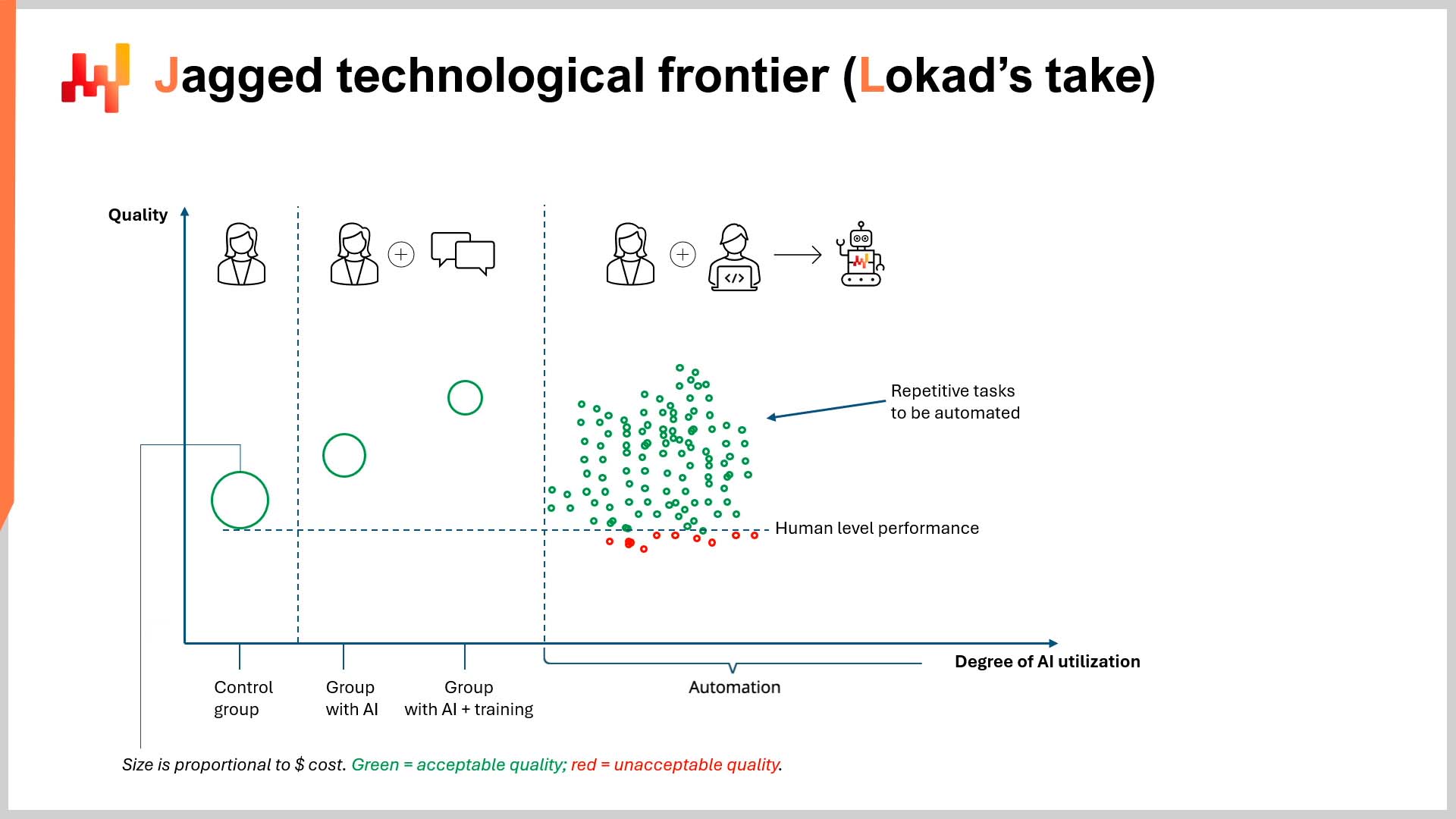

Hinsichtlich der Methodik wurde dieser Punkt bereits im Video kritisiert, daher fasse ich mich hier kurz. Das Forscherteam untersuchte nicht die durch Automatisierung erzielten Produktivitätssteigerungen. Stattdessen wählten die Forscher Gruppen von Beratern (d.h. Nicht-Spezialisten in KI, Informatik und/oder Ingenieurwesen) aus, um ChatGPT-4 zu nutzen. Die einzige Ausnahme bildete die Kontrollgruppe, die ausschließlich mit ihrer Expertise arbeitete. Die Ethik, wie diese Gruppen beurteilt wurden, wird in Kürze erwähnt.

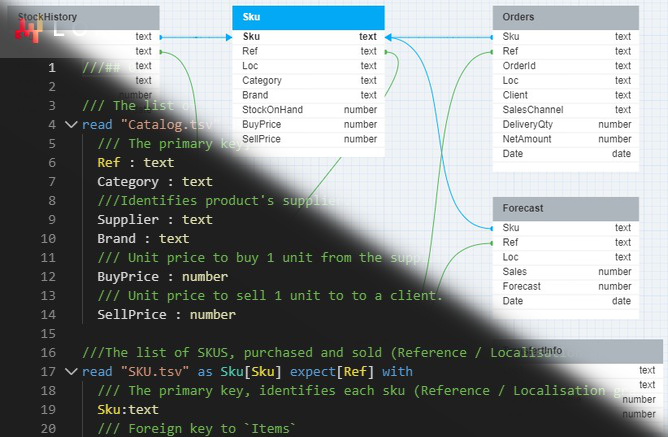

Im Experiment waren keine externen Softwareingenieure oder KI-Experten involviert. Es gab keine Entwicklerteams, die in Retrieval Augmented Generation (RAG), domänenspezifischem Fine-Tuning oder anderen Techniken geübt sind, die die größten Stärken von LLMs ausnutzen: als störungsresistente, universell einsetzbare Vorlagenroboter zu fungieren.

Dieser beeindruckende Roboter wurde nicht darauf programmiert, das domänenspezifische Wissen zu nutzen, das in den umfangreichen internen Datenbanken von BCG vergangener Beratungsprojekte gespeichert ist. Im Gegenteil, im Experiment waren einige Berater beteiligt, die ein Abonnement für ChatGPT-4 besaßen.

Diese Anordnung führte naturgemäß zu unterschiedlich guten Ergebnissen (hinsichtlich der Qualität), insbesondere bei Aufgaben, die sowohl quantitative als auch qualitative Analysen erforderten. Anders ausgedrückt: Ein Experiment wurde entworfen, um zu sehen, wie sehr Nicht-Experten es versäumen, eine hochentwickelte Technologie optimal zu nutzen – und das unter unrealistisch restriktiven Bedingungen.

Wie ich im Video schloss, grenzt es an einen Skandal, die möglichen Produktivitätssteigerungen (und Einsparungen) durch Automatisierung zu ignorieren. Dies gilt insbesondere, wenn man unter dem Namen einer renommierten Bildungseinrichtung veröffentlicht. Meiner Ansicht nach vermitteln die Ergebnisse des Papiers auch Studierenden, die kurz davor stehen, lebensverändernde Schulden aufzunehmen, um an einer führenden Business School zu studieren, ein sehr falsches Gefühl von (Arbeitsplatz-)Sicherheit. Dies trifft ebenso auf Personen zu, die bereits den Sprung gewagt und beträchtliche Schulden für Diplome in Bereichen angehäuft haben, die kurz vor einer vollständigen Automatisierung stehen könnten.

Kritik an der wirtschaftlichen Perspektive

Trotz der umfangreichen Kritik oben betrachtet mich die implizite Ökonomie des Papiers als weitaus faszinierender. Einfach ausgedrückt, hat die Harvard Business School nur die $${quality}$$ der Ergebnisse gemessen, nicht jedoch die $${cost}$$ der Ergebnisse5.

Zu keinem Zeitpunkt (und bitte überprüft mich dabei) messen die Forscher die mit dem Output der Arbeit der Berater verbundenen Kosten. Dies ist nicht ein triviales Detail. Das Papier erwähnt das Wort “quality” 65 Mal auf 58 Seiten (einschließlich des Titels des Papiers). Das Wort “cost” wird…2 Mal…und nur im allerletzten Satz des Papiers erwähnt. Zur Kontextualisierung wiederhole ich diesen Satz hier:

“Ähnlich wie das Internet und Webbrowser die Grenzkosten des Informationsaustauschs dramatisch reduzierten, könnte auch die KI die mit dem menschlichen Denken und Schließen verbundenen Kosten senken, mit potenziell weitreichenden und transformativen Effekten.” (p. 19)

Selbst als die Harvard Business School schließlich das Konzept der finanziellen Kosten anerkannte, geschah dies nicht in Bezug auf die reduzierten Kosten, die mit der Erzeugung hochwertiger Arbeit ohne den Bedarf an teuren Absolventen einer Business School einhergehen. Dies mag offensichtlich erscheinen, wenn man bedenkt, dass der Titel des Papiers “productivity” und “quality” als Schwerpunkte der Forschung nennt – ganz zu schweigen von der Tatsache, dass eine teure Business School kaum ihre mögliche künftige Nutzlosigkeit bewerben würde.

Nichtsdestotrotz schlage ich höflich vor, dass die Messung von $${productivity}$$ und $${quality}$$ der Ergebnisse ohne eine robuste finanzielle Perspektive praktisch bedeutungslos ist, insbesondere in einem akademischen Papier einer Business School. Dies ist besonders gravierend, wenn man bedenkt, dass der Kern der KI gerade darin besteht, ein großer Gleichmacher in puncto finanzieller Schlagkraft zu sein.

KI liefert Ergebnisse von sehr hoher Qualität zu sehr niedrigen Kosten, insbesondere durch Automatisierung. Dieses $${quality/cost}$$ Verhältnis liegt um Größenordnungen über dem der menschlichen Arbeitskräfte6. Darüber hinaus öffnet es diese Tür für jeden mit einem ChatGPT-Abonnement und etwas Programmierkenntnissen. Dies ebnet das Spielfeld dramatisch, wenn es um den Wettbewerb zwischen den Großen und den Kleinen geht.

Stattdessen bewertet die Harvard Business School auf 58 Seiten die “Qualität” der Arbeit der BCG-Berater isoliert. Wie wurde diese Qualität bestimmt? Durch “menschliche Bewerter”… die für BCG arbeiten7. Abgesehen von den bereits dargelegten offensichtlichen Interessenkonflikten lohnt es sich, auf die falsche Dichotomie hinzuweisen, die in dem Artikel präsentiert wird, und wie diese die implizite Ökonomie beeinflusst. Diese falsche Dichotomie lautet in etwa wie folgt:

„KI ist entweder besser oder schlechter als menschliche Expertise.“

Oder vielleicht ist eine großzügigere Interpretation:

„KI macht Menschen bei ihrer Arbeit besser oder schlechter.“

So oder so, die Kennzahl, die der falschen Dichotomie im Artikel zugrunde liegt, ist die “Qualität”, die subjektiv gemessen wird und in einem akademischen Vakuum existiert, losgelöst von anderen Größen wie Zeit, Effizienz und Kosten. Eine ausgereiftere ökonomische Perspektive wäre etwa:

Wie verhält sich das $${quality/cost}$$ Verhältnis der menschlichen Leistung im Vergleich zum $${quality/cost}$$ Verhältnis der KI-Automatisierung?

Aufgeschlossene Leser werden dies als ein ROI- (Return on Investment) Argument erkennen. Dein persönliches $${quality/cost}$$ Verhältnis kann ermittelt werden, indem du die folgenden Fragen beantwortest:

- Wie gut war das Ergebnis bei einer bestimmten Aufgabe?

- Wie viel hat es gekostet?

- War die Qualität den Preis wert?

- Wie viel würde es kosten, die Qualität zu verbessern, und wäre diese Verbesserung finanziell lohnenswert?

Die Harvard Business School verbringt 58 Seiten damit, die erste Frage zu diskutieren, und geht darüber nie hinaus. Dies ist eine eigenartige Perspektive für eine Business School, muss gesagt werden. Tatsächlich lässt sich ein interessanter Parallel zur supply chain ziehen. HBS’ blindes Streben nach Qualität ähnelt bemerkenswert der isolierten Verfolgung der Prognosegenauigkeit (d.h. zu versuchen, die Prognosegenauigkeit zu verbessern, ohne die damit verbundene Rendite (ROI) zu berücksichtigen)8.

Potenzielle Implikationen

Ökonomisch betrachtet besteht die „gezackte technologische Grenze“ nicht nur darin, zu identifizieren, welche Aufgaben LLMs besser als Menschen ausführen. Stattdessen geht es darum, dein ideales $${quality/cost}$$ Verhältnis beim Einsatz von LLMs zu ermitteln und intelligente, finanziell fundierte Entscheidungen zu treffen. Für versierte Geschäftsleute wird dies Automatisierung beinhalten und nicht manuelle Eingriffe (oder zumindest sehr wenige davon).

Für diese Geschäftsleute ist vielleicht ein vergleichbares Qualitätsniveau akzeptabel, solange es kosteneffizient ist. „Akzeptabel“ kann bedeuten, dass es gleichwertig oder leicht besser/schlechter ist als die Qualität, die ein menschlicher Experte liefern kann. Mit anderen Worten, 0,07% des Preises eines Beraters für >90% der Qualität zu zahlen, könnte einen sehr guten Kompromiss darstellen, auch wenn es nicht genau so gut wie das Ergebnis des teuren Experten ist[^9].

Die Zahlen werden für jeden Kunden unterschiedlich sein, aber es ist eindeutig, dass es einen Wendepunkt gibt, über den hinaus die „Qualität“ nicht mehr isoliert betrachtet wird, sondern im Hinblick auf ihre finanziellen Kosten bewertet werden muss. Dies gilt jedenfalls für Unternehmen, die im Geschäft bleiben wollen.

Vielleicht bist du der Meinung, dass die Einstellung eines Teams von Harvard Business School-Absolventen oder Beratern von BCG ein ideales $${quality/cost}$$ Verhältnis darstellt, unabhängig von günstigeren Optionen wie KI-Automatisierung. Falls dem so ist, wünsche ich dir ein langes Leben und viel Erfolg[^10].

Andererseits denkst du vielleicht wie ich: Qualität ist subjektiv; Kosten hingegen nicht. Meine subjektive Einschätzung von Qualität – zumindest im Geschäftsleben – steht in Relation zu den Kosten. Ähnlich wie bei service levels (oder Prognosegenauigkeit) in der supply chain lohnt sich ein zusätzlicher 1%-Schub in der Qualität (oder Genauigkeit) wahrscheinlich nicht für einen Kostenanstieg von 1.000%. Folglich gibt es im Geschäft mit KI einen wirtschaftlichen Zielkonflikt zwischen Qualität und Kosten. Es ist entscheidend, dies nicht aus den Augen zu verlieren, wie es die Harvard Business School scheinbar getan hat.

Abschließend, wenn du darauf wartest, dass KI die menschliche Qualität übertrifft, bevor du sie einsetzt, so sei es, aber der Rest von uns wird nicht mit dir warten.

-

Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality, Dell’Acqua, Fabrizio und McFowland, Edward und Mollick, Ethan R. und Lifshitz-Assaf, Hila und Kellogg, Katherine und Rajendran, Saran und Krayer, Lisa und Candelon, François und Lakhani, Karim R., September 2023 ↩︎

-

In AI Pilots for Supply Chain verglich Joannes Vermorel diesen „Schweizer Taschenmesser“-Ansatz damit, einen sehr intelligenten Professor zu bitten, die Details eines Papiers, das er einst studiert hat, wieder in Erinnerung zu rufen. Aus dem Stegreif wird sich der Professor an den Kern erinnern, aber möglicherweise nicht an alle Nuancen, sofern du nicht die richtigen Anschlussfragen stellst, um sein Gedächtnis aufzufrischen. ↩︎

-

BCG wirbt hilfsweise mit seinen Verbindungen zu vielen der besten Business Schools Amerikas. Fühle dich frei, die Präsenz von BCG an wichtigen US-Campussen zu untersuchen. Alternativ kannst du diese hilfreiche herunterladbare Excel-Datei durchstöbern, die die Daten vereinfacht. Die Tabelle enthält, wie viele BCG-Berater derzeit MBAs an der Harvard Business School studieren (74). Die Leser können sich ihre eigenen Schlüsse ziehen. ↩︎

-

Eine Zusammenarbeit zwischen einer großen Business School und einer bedeutenden Beratungsfirma zeigte, dass teure (und teuer ausgebildete) Berater wertvolle Vermögenswerte sind… Verzeih mir, dass ich weniger als schockiert war. Falls du es doch bist, leite ich dich höflich an die herunterladbare Excel-Datei in der vorherigen Fußnote weiter. ↩︎

-

Und es hat ganz sicher nicht Qualität geteilt durch Kosten des Outputs gemessen, wie ich später erläutern werde. ↩︎

-

Es ist schwierig, hierzu genaue Zahlen anzugeben, aber nehmen wir als Beispiel ein Jahresgehalt von über 200.000 US-Dollar für einen Berater einer beliebigen Top-Firma an. Diese Zahl ist basierend auf einer kurzen Internetsuche durchaus realistisch. ChatGPTs Steckbrief-Berechnungen deuten darauf hin, dass ein Jahr Beratungsarbeit etwa 145 US-Dollar kosten würde (bezogen auf die Verarbeitungskosten von ChatGPT). Offensichtlich ist dies nicht allzu wissenschaftlich, aber selbst wenn die Zahl um drei Größenordnungen abweicht, ist sie immer noch fast 30% günstiger als das Jahresgehalt eines einzelnen Beraters. Siehe ChatGPTs Begründung hier: https://chat.openai.com/share/d9beb4b9-2dd3-4ac2-9e95-2cd415c76431. (Dank an Alexey Tikhonov für die Bereitstellung des Konversationsprotokolls.) Zugegebenermaßen muss man auch die Kosten für die Konstruktion des Templating-Roboters berücksichtigen, der möglicherweise nicht billig ist, aber selbst in Kombination mit den 145 US-Dollar für ChatGPT immer noch günstiger wäre als das Jahresgehalt eines einzelnen Beraters und exponentiell produktiver wäre, wenn er in großem Maßstab eingesetzt wird. ↩︎

-

Siehe die Seiten 9 und 15 des Artikels, falls du an dem zweifelst, was du gerade gelesen hast. Falls dies vielleicht auf einen Interessenkonflikt hindeutet, leite ich dich höflich an die herunterladbare Excel-Datei in Fußnote 3 weiter. ↩︎

-

Lokad hat bereits ausführlich den Wert der Prognosegenauigkeit behandelt, daher hier eine sehr kurze Auffrischung: Konzentriere dich auf die finanziellen Auswirkungen deiner supply chain Entscheidungen, anstatt KPIs (wie Genauigkeit) unabhängig von ihren finanziellen Implikationen (d.h. ROI) zu messen. Anders ausgedrückt: Wenn eine Bedarfsprognose um 10% genauer ist, du aber infolgedessen 20% weniger verdienst, kann man mit gutem Recht sagen, dass die gesteigerte Genauigkeit den erhöhten Kosten nicht gerecht wurde. Vor ungefähr einem Jahr begann Lokad damit, seine Website mit Hilfe von LLMs in sechs Sprachen zu übersetzen. Zuvor hatten wir professionelle Übersetzer beauftragt. Die laufenden Kosten, um die Übersetzungen einfach zu pflegen, betrugen etwa 15.000-30.000 (US) pro Jahr und Sprache. Während wir vollkommen bereit sind zuzugeben, dass die professionellen Übersetzer (relativ) höhere Qualität lieferten, ist das $${quality/cost}$$-Verhältnis bei der Verwendung eines LLM weit überlegen. Anders ausgedrückt: Die Qualität, die wir mithilfe eines LLM erzeugen können, ist mehr als akzeptabel und erheblich günstiger als unsere vorherige Lösung. Es ist schwierig, die Einsparungen genau zu quantifizieren, aber die kompetente Übersetzung jeder einzelnen Ressource, die wir jemals produziert haben (und jemals produzieren werden), in sechs Sprachen in wenigen Minuten ist exponentiell günstiger und zeiteffizienter als das bisherige System. Wenn Sie ein Muttersprachler in Französisch, Deutsch, Spanisch, Russisch, Italienisch oder Japanisch sind, übersetzen Sie diesen Aufsatz gerne in der oberen rechten Ecke der Seite und testen Sie die Qualität selbst. Zumindest bis OpenAI ChatGPT-5 veröffentlicht wird. ↩︎