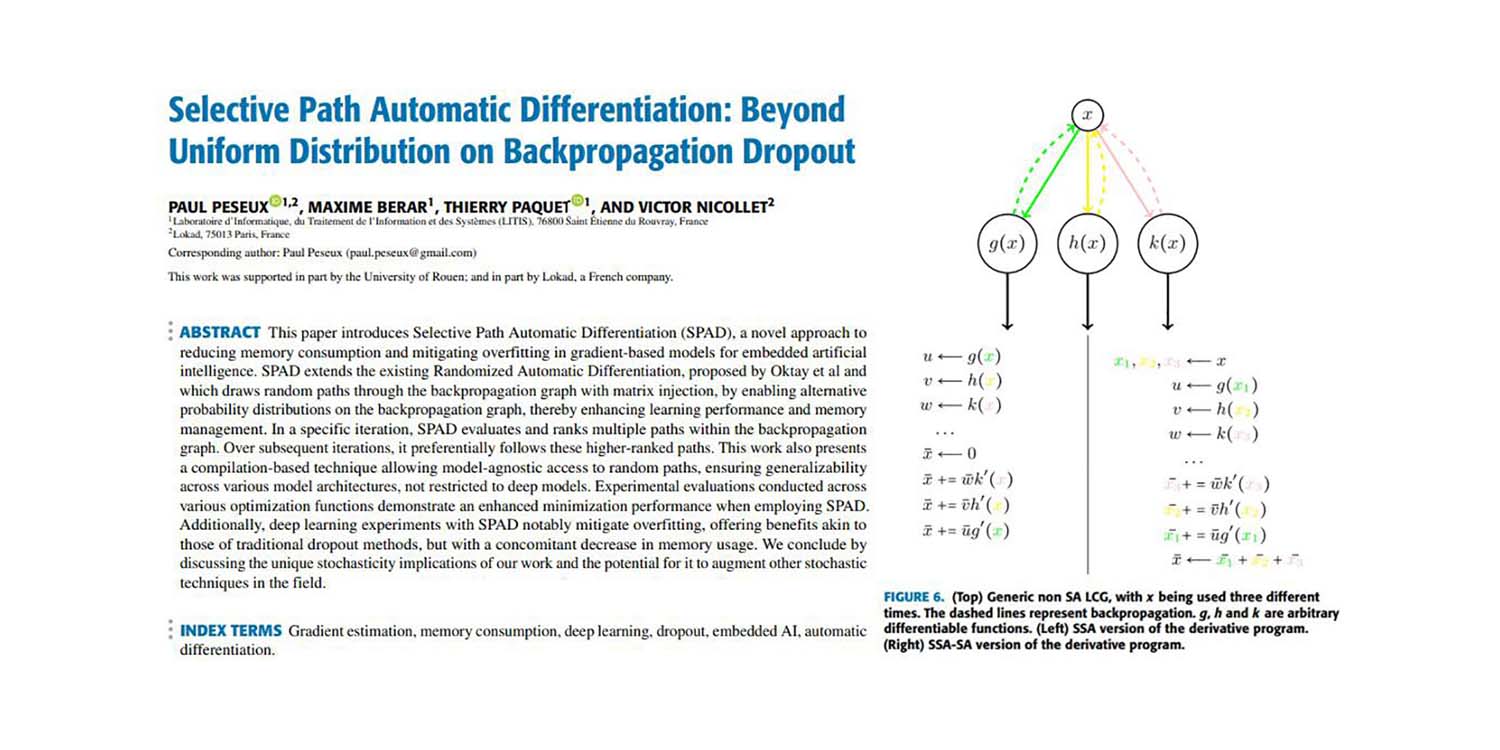

選択的パス自動微分:バックプロパゲーションドロップアウトにおける均一分布を超えて

確率的勾配降下法(SGD)の非合理的な効果は、おそらく2010年代の最も重要な機械学習の発見です。SGDは、最近の機械学習のほとんどのブレークスルーにパワーを提供しています。概念的には、SGDは非常にシンプルです:データセットを1つのデータポイントずつ処理し、各ポイントでこのポイントによって与えられる方向にモデルパラメータを微調整します。より技術的な言葉で言えば、「方向」は勾配として与えられ、微調整には通常「学習率」と呼ばれる小さなスケーリング係数が関与します。

SGD技術は1950年代にさかのぼりますが、それはほとんど無名でほとんど使用されない技術でした。ディープラーニングの登場により、この技術がなぜ機能するのかは明確ではなく、ある程度はまだ明確ではありません。モデルのエラーをデータセット全体で最小化することが目標であるため、厳密に孤立したポイントを選択すると、数値的なゴミ以外の何も生じないことは明らかではありません。

現在では、SGDの効果的な動作(つまり、なぜ機能するのか)は、2つの要素によって説明されることが一般的に理解されています。まず、SGDによって得られる勾配は非常にノイズが多いですが(各ステップは単一のデータポイントを考慮しています)、この勾配は非常に安価です。計算リソースの予算が与えられた場合、多数の低品質な勾配更新を適用することは、単一の高品質な勾配更新の適用よりもはるかに優れたパフォーマンスを発揮することがわかります。第二に、ノイズのある更新自体が、モデルが高次元に存在する数値的な無関心の広大な高原から脱出するのを助けます。実際、高次元では、最適化の肝は、従来考えられていたように、局所的な最小値から脱出することではなく、損失がほとんど変化しない局所的な高原から脱出することです。

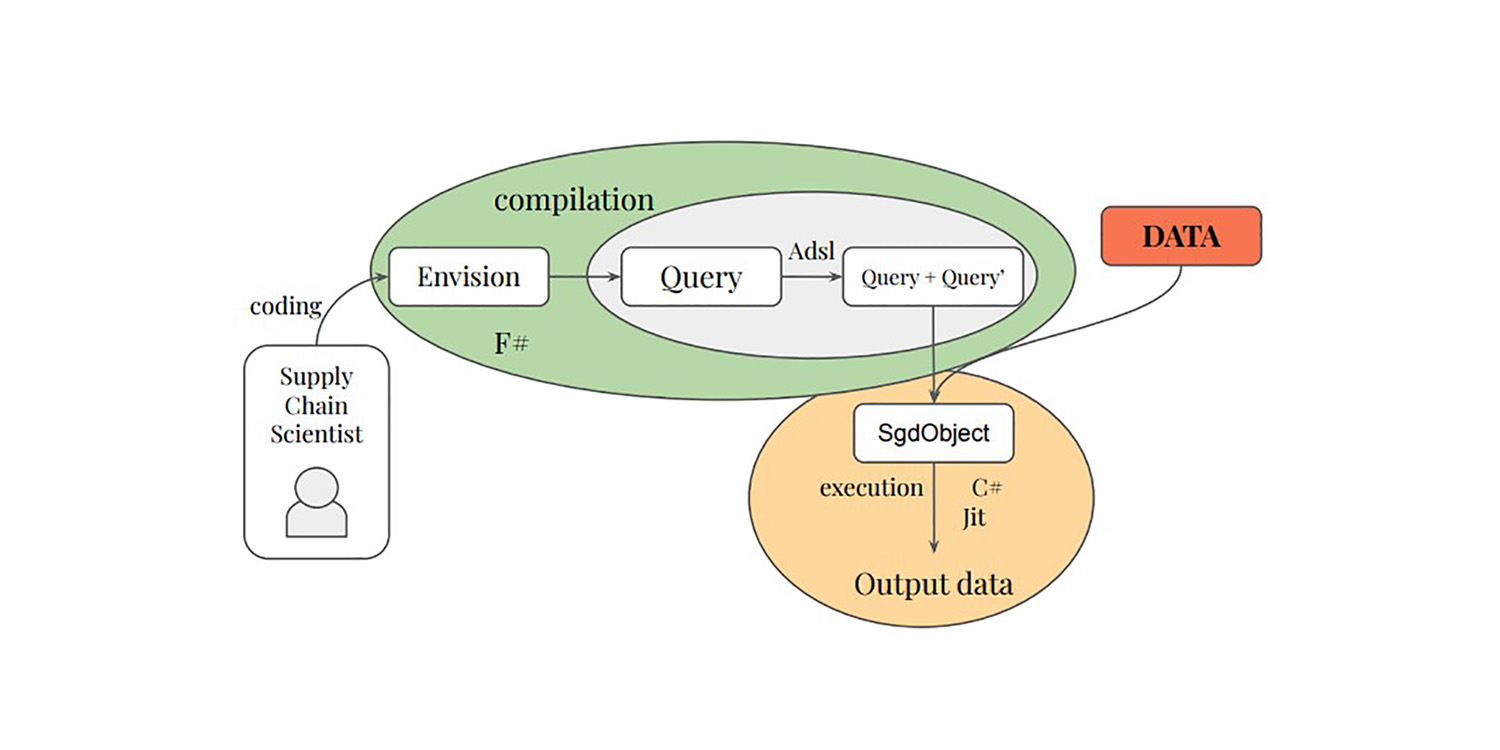

Paul PeseuxとVictor Nicolletを含む私たちの一部は、これらのアイデアをさらに進めることを決めました。SGDは勾配の品質を計算効率と引き換えにすることで機能するのであれば、この原則をさらに拡張することはどうでしょうか?計算コストがさらに安くなるが、さらにノイズが多いサブポイント勾配はどうでしょうか?これがSelective Path Automatic Differentiation(SPAD)で行われていることです。SPADは、評価パスによってデータポイントを「分割」することで、現代の機械学習パラダイムの基盤の1つを再考しました。

以下の論文は、Paul Peseux(Lokad)、Victor Nicollet(Lokad)、Maxime Berar(Litis)、Thierry Paquet(Litis)からの貢献を紹介しています。

タイトル: 選択的パス自動微分:バックプロパゲーションドロップアウトにおける均一分布を超えて

著者: Paul Peseux、Maxime Berar、Thierry Paquet、Victor Nicollet

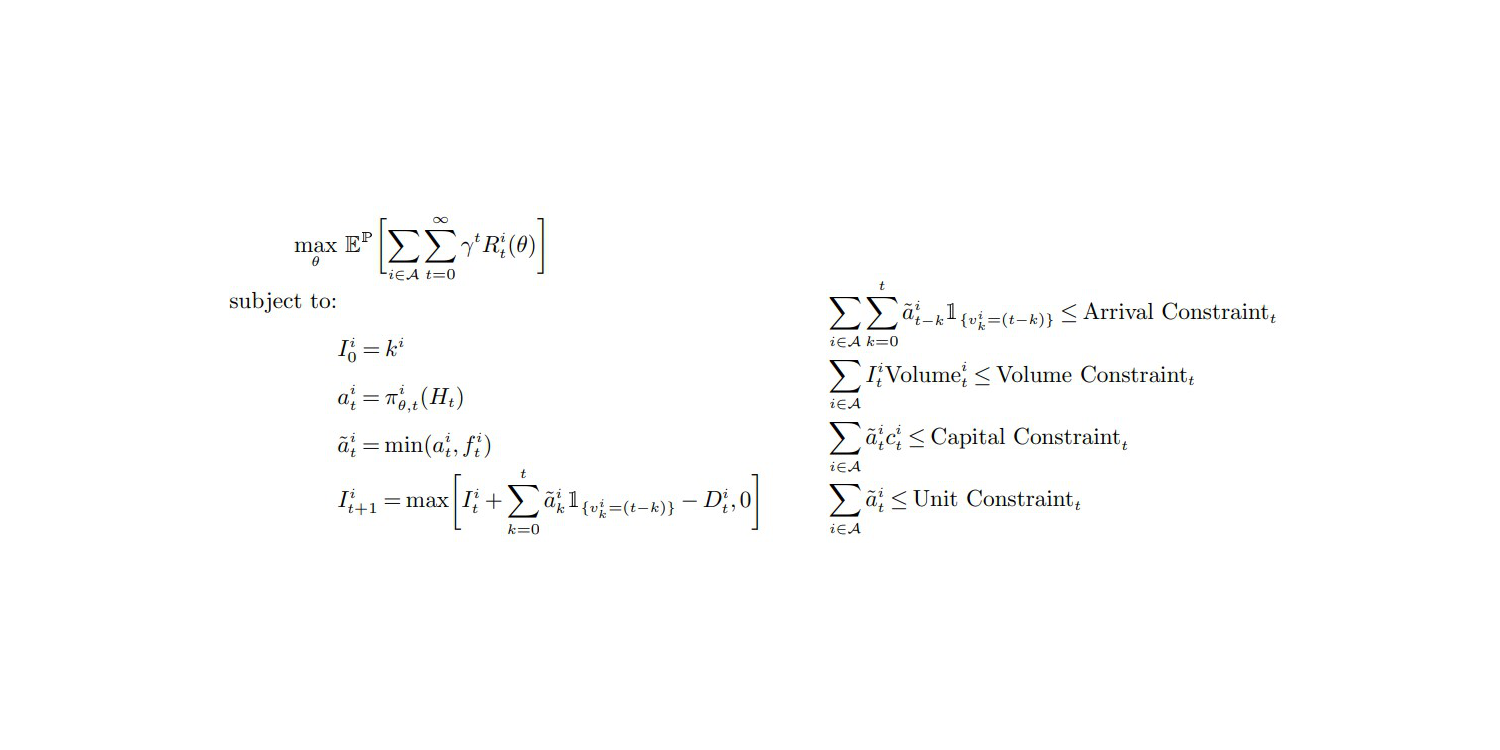

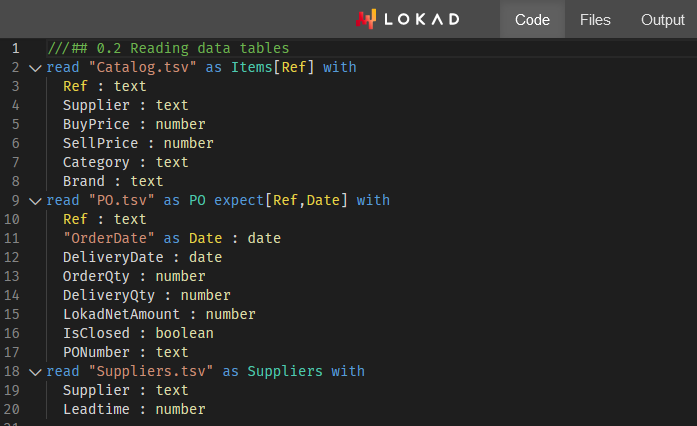

要約: 本論文では、埋め込み型人工知能の勾配ベースモデルにおけるメモリ消費の削減と過学習の緩和に向けた新しいアプローチである選択的パス自動微分(SPAD)を紹介します。 SPADは、既存のランダム化自動微分(Oktayらによって提案されたもの)を拡張し、バックプロパゲーショングラフ上での代替確率分布を可能にすることで、学習性能とメモリ管理を向上させます。特定の反復では、SPADはバックプロパゲーショングラフ内の複数のパスを評価し、順位付けします。後続の反復では、これらの上位ランクのパスを優先的にたどります。この研究では、モデルに依存しないランダムパスへのアクセスを可能にするコンパイルベースの技術も紹介されており、深層モデルに限定されないさまざまなモデルアーキテクチャでの一般化を保証します。さまざまな最適化関数を対象とした実験評価により、SPADを使用することで最小化性能が向上することが示されています。さらに、SPADを使用したディープラーニングの実験では、従来のドロップアウト手法と同様の過学習の緩和効果があり、同時にメモリ使用量が減少します。最後に、本研究のユニークな確率論的な意味と、他の確率論的手法への拡張の可能性について議論します。

論文をダウンロードする(PDF) 技術の分野でのテクニック。