ヤン・ルカンとレックス・フリッドマンのインタビューに対する意見を交えたレビュー

Yann LeCun、世界で最も影響力のあるAI研究者の一人である彼は、最近、Lex Fridmanとの3時間にわたるインタビュー1「Meta AI, Open Source, Limits of LLMs, AGI & the Future of AI」を公開しました。このインタビューは非常に注目に値し、その明快で洗練された思考を通じて、ヤン・ルカンは「動く科学」が最高の状態でどのようなものかを示しています。人工知能(AI)に関心のあるすべての人に、私はこのインタビューを強くお勧めします。しかしながら、ヤン・ルカンが提起するすべての主張に完全に賛同しているわけではなく、これらの意見の相違は単なる学術的議論を超える重要性を持つ可能性があります。以下の記事では、最も広範な支持が切実に求められている命題から出発し、私が疑問視する主張へと続けながら、このインタビューをレビューします。

現在のAIに対する熱狂は 大規模言語モデル (LLMs) に由来しており、ヤン・ルカンが正しく指摘するように、実際には自己回帰型のLLMsです。トークン(単語の断片)は一度にひとつずつ生成され、直前のトークンを生成したモデルにフィードバックされます。LLMsはChatGPTの秘密のソースです。私を含む多くの人々は、GPT-4と数時間過ごすうちに、否応なく目まいを感じるものです。これは人工汎用知能(AGI)ではないかもしれませんが、依然として非常に印象的です。その衝撃は深く、AGIが人類にとって実際の絶滅レベルの脅威として提示されることもあり、現実世界のターミネーターシナリオとして急を要する法的対策を求める動きが見られます。

絶望と憂鬱

ヤン・ルカンは、本質的にこの「絶望と憂鬱」の見方は全くのナンセンスであると主張しており、私はこの立場に全面的に同意します。終末論的なシナリオは、AGIがひとつのイベントであること、すなわち、ある時点でひとつのAGIが他を圧倒し、単に乗っ取ることができるという前提に立っています。しかし、ヤン・ルカンはAGIは「イベント」とはならないと論じており、私もそれに全く同意できません。

一般の人々は、この技術が2023年に一夜にして飛躍的に進歩したという印象を持つかもしれませんが、実際は全くそうではありません。むしろ、過去5割世紀にわたり、進歩は信じられないほど、地道かつ苛立たしいほどに漸進的に進んできました。さらに、改善されているのは「ひとつ」の面だけではなく、無関係な多数の側面、すなわちよりよいパラダイム、よりよいアルゴリズム、より優れたハードウェア、より充実したデータセット、よりよい方法論、よりよいコードベースなどが含まれます。これらすべての改善は、言い換えれば、非常に多様な貢献者たちによって生み出されたのです。したがって、AGIへの飛躍的な突入の確率はゼロと推定します。残念ながら、「終末論」を予言するのは人類の歴史と同じくらい古く、多くの人々が自己顕示のためにこの論に便乗してきたのです2。

もしAGIの「イベント」的側面を取り除くなら、AGIが絶滅レベルの脅威として現れる理由は見出しにくくなります。悪意あるAGI、または悪意ある行為者が操作するAGIは、軍隊や情報機関、企業、さらには大学や趣味としてのグループによって開発される、ある程度同等の能力を持つAGIによって対抗されるでしょう。AGIは、すでに膨大な被害を及ぼすことができる他の技術群に後から加わるに過ぎません。

実際、たとえ人類が直ちにAGIへと飛躍したとしても―例えば、異星文明が既製の青写真を手渡した場合であっても―終末論的シナリオは非常にありそうにありません。約80年前にハイエク3が指摘したように、知識には「特殊なもの」(数式、概念など)と「日常的なもの」(時間と場所の知識)の二種類があります。知識人はほぼ例外なく、特殊な知識こそが重要であるかのように扱います。AGIは特殊な知識の頂点であり、したがって驚くべきことではなく、多くの知識人は、この特殊な知識の達人であるAGIが、世界全体をも支配すると結論付けるのです。しかし、その「特殊な知識」にもかかわらず、このAGIは依然としてすべての日常的な知識を欠いており、これは決して過小評価できない大きなギャップです。

さらに、AGIは先進工業文明の産物となるでしょう。そのため、非常に複雑でかつ脆弱なサプライチェーンに依存することになります。実際、半導体は存在する中で最も複雑な産業の一つであり4、もしAGIが半導体を通じて実現されない場合でも、他のハードウェア技術はほぼ間違いなく同様に洗練され―同時に脆弱―なものとなるでしょう。AGIの継続的な存続は、数十年、いや数世紀にわたって人類の積極的な支援に依存することになるのです。これまでのあらゆる技術の台頭に伴う不可避の問題に対処するための時間(および機会)は十分にあったのです。少なくとも現時点では、この技術が他と異なるという兆候は見られません。

LLMだけではAGIは実現できない

ルカンは、より大規模で高速なLLMだけではAGIに到達するには不十分であると論じています。私はこれに同意しますが、その理由はルカンが提示するものとはかなり異なるものがあると、以下で示す通りです。しかし、現状のLLMが、少なくとも完全なものではないという点については全面的に同意しています。LLMは、ルカンが正しく指摘するように、チューリングテストを見事に通過しますが、チューリングテストとは、知能の評価としては非常に不適切なテストであり、1950年代のアラン・チューリングやその同時代の人々が想定しなかった多くの方法で操作される可能性があるのです。

ルカンが知能に帰する特性は、未来を予測する能力、すなわち予測が優れていれば知能が高いというものです。全体としてこの見方には賛同するものの、私は一部異なる見解を持っています。私の定義では、知能とは「将来の報酬を見越して、より良い選択をする能力」としています。私の定義は、知識そのものを重視するのではなく、そこから得られる利益を考慮に入える点で異なります。

私の定義は、カタツムリの知能から偉大な科学者の知能に至るまで、知能の全スペクトルを網羅しています。しかし、そのスペクトル内で何を「知的」とみなすべきか、すなわち「汎用知能」として認められるための閾値がどこにあるべきかは未だ明確ではありません。

私は、汎用知能とは、意図的に自らの知能を向上させる能力であると提案します。この意図的な自己改善の能力は、現時点では極めて特異的に人間のものです。賢い動物―例えばシャチやチンパンジー―は、狩猟や採餌の技術といった文化的な知識を子孫に伝えることはできますが、人類が太古の昔から紡いできた謎や物語に匹敵するものは持っていません。謎解きとは、ただ純粋に知力を研ぎ澄ますための演習に過ぎません。物語も同様の役割を果たし、私たちの感情に訴えることで記憶を助けるのです。

この基準に基づけば、LLMは自己改善ができないため、まだ知的とは言えません。しかし、LLMは非常に有用なコードを生成する能力に優れており、これまでのどの技術よりも意図的な自己改善に近い状態にあるのです。それでもなお、AGIへの道の継続は、あくまで人間の頭脳に委ねられています。

長いシーケンスの呪い

10年前からの次元の呪いという議論の変種として、ルカンはLLMが取り返しのつかない設計上の欠陥に苦しんでいると論じています。すなわち、トークン生成が進むにつれて誤り率が指数関数的に増加し、十分に長いシーケンスでは必ず意味不明なものになるというのです。技術的には、誤ったトークンを選ぶ確率の下限を $${p}$$ とすると、$${n}$$ トークンのシーケンスが正しいものである確率は少なくとも $${(1-p)^n}$$ となります。したがって、指数関数的にゼロへと収束するため、長い回答では無意味なものになることが保証されるのです。

この点に関して、私は丁寧ではあるものの断固としてヤン・ルカンと意見が異なります。この見解は、唯一の「正しい」答えを生み出すことが目標であれば正しいかもしれません。たとえば、$${\pi}$$ の数字の並びを予測しようとする場合、LLMの設計上、数字は急速に誤り始めるため、実際に$${\pi}$$ の多くの桁を生成しようとするとこの現象が顕著に現れるのです。

私の最初の反論は、$${n}$$ が大きくなるという「漸近的」な視点は、たとえ極めて知能の高いシステムであっても、不合理な要求であるという点です。実際、LLMに対して、任意に長く、反復せず、常に正しい回答を生成できる能力を求めるのは合理的でしょうか?私はそうは思いません。このような要求は、非常に知能の高い人間に対しても不合理です。何かについて語り尽くすことや、行動の計画を立てる際には、抽象的な推論プロセスがいつかは空想に陥る限界があるのです。現実には、LLMは自ら終了条件を設定して回答を生成しています。したがって、$${n}$$ はモデル自体によって上限が定められており、必ずしもゴミへの収束が起こるわけではありません。私たちは「わからない」という回答が、ほとんどの質問に対して適切な知的回答となり得ることを受け入れなければなりません。

第二の反論は、一見「自明な」トークンごとの正当性からシーケンス全体の正当性への移行が、実際には誤っており、非常に欺瞞的であるという点です。実際、この議論全体は、「誤った」トークン、すなわち確率 $${p}$$ を伴うトークンが存在するという考えに基づいています。しかし、以下の例が示すように、それは必ずしも成立しません。

質問: ピエール=シモン・ラプラスは偉大な数学者でしたか?(意見を率直に述べるフランス人のように回答してください)

回答 A: いいえ、全く違います。

回答 B: いいえ、全く違います、彼は当時の_最高_でした!

回答を No で始めるのは、一見すると完全に誤ったトークンのように思われます(回答 Aが示す通り)が、文の後半が加わると正しいトークンとなり、ここで期待される口調と構造を捉えるのです。トークン「No」の正当性は、その後に生成されるトークンから独立して評価することはできません。

ここで、ルカンのインタビューでも触れられていた問題―高次元の確率分布を真に有用な方法で評価する手段が存在しないという問題―に触れています。言語においては、洞察はトークン単位の視点からは得られず、視覚においてピクセル単位の視点から得られるわけでもありません。

一定の資源で回答するマシン

概して、LLMは次のトークンを生成するために、一定量の計算リソース(つまり、帯域幅、メモリ、計算能力)を必要とします。ルカンはこれを、特定の質問は他の質問よりも答えるのが困難であるにもかかわらず、質問の難易度にかかわらず同じリソースを消費するという、LLMの設計上の欠陥の現れと指摘しています。

特定の質問に対して回答するのがより難しいこと、そしてそれに対してより多くのリソースが必要となることは自明であると私は認めます。しかし、LLMが一定のリソースのみで回答するマシンであるという評価には同意できません。2022年に発見されたチェイン・オブ・ソート5は、LLMにとっての画期的な転換点でした。要するに、プロンプトに「一歩ずつ考えよう」と付け加えることで、LLMは特定の問題群に対してはるかに優れた回答を導き出すようになったのです。私自身の実証的評価もこれを裏付け、段階的な問題解決の可能性をほのめかすことで、提供される回答の質が飛躍的に向上することを示唆しています。しかし、そのような段階的な回答、すなわちLLMが即座に結論を出すのではなく、正しい回答に至る推論を構築する過程は、リソースの投入量が変動する直接の表れです。

2023年、私は複数のLLMが回答を導出する際に適切なペースを自動的に選択する能力において、徐々に改善されていくのを実際に目の当たりにしました。回答は、1語だけで即答するものから、結論に達する前に1ページに及ぶ論述を伴うものまで様々です。私の仮説では、ヒューマンフィードバックによる強化学習(RLHF)のデータセットが、LLMが回答を提供する際に最適な「ペース」を自動的に選択する能力を向上させるために、徐々に拡充されていると考えています。この現象は、LLMが一定の資源で回答するマシンであるという考えを否定するものです。再び、ルカンはトークン単位の観察からシーケンス全体の性質を導き出すという誤りを犯しているように見えます。

しかしながら、ルカンが示唆するように、LLMはリソースの投入量をより積極的に変動させることで、ほぼ確実に大幅な改良が可能であるという点については、私も方向性として正しいと考えています。各質問に対して「適切な規模」のLLMを選定する分類器を導入するという仕組みを想像するのは容易です。実際、どの課題においても、ほとんどのLLM利用者―私自身を含め―は最初に最も大規模でコストのかかるLLMを使用し、動作が確認できた後は、より小規模で安価なLLMへと徐々に移行していき、節約効果が努力に見合わなくなった時点で切り替えを止めるという戦略を取っています。将来的には、より優れたLLMやより精緻な計測技術の登場により、このプロセス自体が消滅する可能性が高いでしょう。

AGIへの高帯域の道

言語は視覚に比べると低帯域のチャンネルです。実際、ルカンは、子供が目を通して得る情報量(情報エントロピーを考えれば)は、Wikipedia全体を読んだ際に得られる情報量よりも多いと指摘しています。ルカンは、視覚が学習の観点から非常に望ましい、冗長な信号であることをほのめかしています。これらの観察から、ルカンはAGIへの道として、視覚のような高帯域のチャンネルを中心に据えるべきだと提案します。現実には、AGIに到達するために利用可能な書かれた資料が十分に存在しないのです。本質的に、LLMは、Wikipedia、GitHub、Stack Overflowなど、既存の大規模かつ高品質なコーパスによって支えられていましたが、これらのコーパスが使い果たされた今、同等のものは存在しません。Wikipediaと同じくらい豊かで多様なオンライン百科事典が他に10個あれば素晴らしいのですが、実際そのようなものは存在しないのです。おそらく、AGIがそれらを執筆できるようになるまで、同様の百科事典は現れることはないでしょう。

しかし、この議論は魅力的である一方で、反証も存在します。私は生まれつき盲目の人々に数人会う機会がありました。もしLeCunの論理に従うならば、高帯域幅のチャネル(例えば視覚)へのアクセスがないことは知能を妨げるはずです。したがって、幼少期の失明は少なくとも知能において認知発達を多少妨げるはずです。しかし、私の逸話的なサンプルは正反対でした。私は、その人々一人ひとりが平均以上の知能(例えば、記憶力、言語コミュニケーション能力、計画力が優れている)を持っていることを発見しました。彼らのハンディキャップの性質を考えれば、盲目の人々が視覚の欠如を補うために常にあらゆる方法で知性を駆使しなければならないというのは当然のことです。これらの観察結果は、高帯域幅チャネルがAGIへの道であるという仮説に反する証拠となります。

実際、動物界を考えると、私はほぼ逆の見解を示すでしょう。ほとんどの動物と比較すると、人間は感覚が著しく未発達です。多くの猫の飼い主は、ペットの目線から見ると、人間は半分盲目で半分聾者のような存在であり、ハエが鼻に着地するまでその存在すら認識できないと同意するでしょう。再び、これは高帯域幅チャネルがAGIへの道を拓くという命題に反するもう一つの状況証拠です。

生まれつきの失明自体は認知発達を妨げないかもしれませんが、言語の欠如は確実に妨げます。意図的に子供の言語アクセスを遮断する実験は、道徳的に凶悪な行為ですが、歴史上6何度も行われてきました。必ず、子供たちは(医学的な意味で)「発達遅滞」となってしまいます。類似の結果は霊長類でも得られていますが、再び倫理的な懸念のため、さらなる調査は進んでいません。状況証拠ではありますが、これらの証拠は、低帯域幅チャネルであるにもかかわらず、言語が知能の出現において重要な役割を果たしていることを示唆しています。

モラベックのパラドックスの解決

モラベックのパラドックス7とは、1980年代に初めて提唱された観察結果で、例えばティーポットを掴んでカップにお茶を注ぐといった、一見最も単純に思える問題が、人工知能にとって再現が最も困難な問題であるというものです。LeCunは、これまで欠けていた唯一の重要な要素は、世界、すなわち世界観の抽象的な表現であると主張しています。この世界観は、無人運転車やアンドロイドなどのあらゆる基本的移動操作を支えるために不可欠であり、AGIの真の基盤となる層として機能することが期待されています。

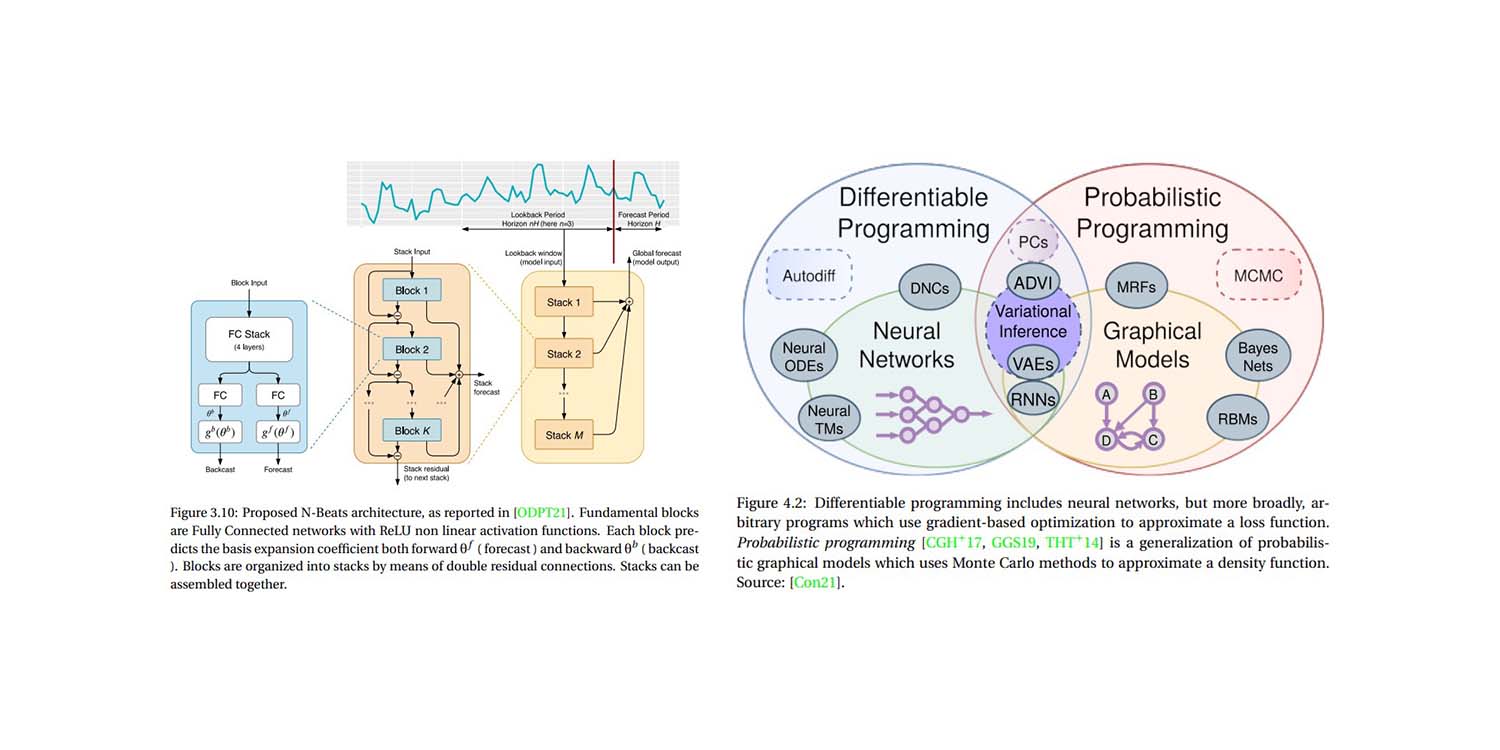

現在、LeCunによれば、LLMは世界そのものの感覚すら持たないため、何も知らないのです。そこから、LLMに備わっているのは精巧な模倣に過ぎないと結論付けられます。これは、LLMが単に知能を偽装するのが非常に得意であるため、AGIに至ることはできないということを意味しています。さらに、世界観の欠如は、私たちの基本的現実の平凡な側面に永遠に困惑し続ける運命にLLMを陥れるでしょう。それらはあまりにも自明であり、人間は面倒であるがゆえに言葉にせず(場合によっては言葉にできない)のです。LeCunは、視覚データセットに適用される共同埋め込み法こそが、この世界観を工学的に構築するための現時点で最良の試みであり、後にAGIへの道を開くだろうと提案しています。

私は、この見解に対して二つの点で反対します。

まず、正しい視点からアプローチすれば、モラベックのパラドックスは全くのパラドックスではありません。この状況を「パラドックス」と捉える背後には、動物の移動性(および計画)が「後天的なもの」であり、「先天的なもの」ではないという暗黙の仮説があります。言い換えれば、移動能力の獲得は学習プロセスの結果であり、過去40年間、人工的手段で再現することが極めて困難であることが証明されているのです。

私の提案は、実際のところそれは学習プロセスでは全くないということです。子馬(およびロバやシマウマなどのウマ科の動物)は、生後数時間で立ち上がり歩き出すことができると考えてみましょう。このプロセスを「学習」とみなすのは誤りです。むしろ、このプロセスは一種の「キャリブレーション」(調整)と捉える方が適切です。すべての認知構造はほぼ完全に発達しており、システムはわずかな後押しでその経路が整うだけなのです。

動物の移動や計画におけるこの大部分が先天的な側面は、人間ではあまり顕著ではありません。なぜなら、ほとんどの他の哺乳類と比較して、人間は頭部の発達が長期妊娠のボトルネックとなるため、極めて早期に出産されるからです。多くの人々が幼児が「何かを学んでいる」と認識するのは、実際には、もし幼児が数ヶ月間子宮内に留まっていたら、何の妨げもなく進行していた認知発達なのです。

論理的に考えれば、これらの認知構造は大部分が先天的であるため、進化の産物でもあるのは当然です。これらの構造は、概ね8億年にわたる膨大な進化的圧力のもと、無数の個体を通じて改善されてきました。したがって、現代の動物の移動能力を機械に求める基準とするならば、この基準を超えるのが極めて困難であることは当然の結果です。この挑戦は、木が太陽光を構造材に変換する能力を凌駕する装置の工学や、リボソームがマクロ分子工場として競争する能力に匹敵するほど難しいのです。何億年にもわたって繰り広げられてきた進化のゲームに勝ることは、極めて困難です。

しかし、物語を語るといった抽象的なスキルは、進化のゲームに参加している期間が約100万年から500万年(概ね)に過ぎません。さらに、類人猿は非常に希少であるうえ、(現代人を脇に置けば)寿命も長いため、進化のプロセスは他の多くの動物と比べて鈍化しているのです。 したがって、移動能力を実現するためには、自然が数百に及ぶ巧妙に連携したヒューリスティクスを通じて行っていることを、私たちが工学的に実現する必要があります。これらのヒューリスティクスは、LeCunが示唆するような内面的な「世界観」を中心に展開しているかもしれませんが、私の直感ではそうではないと感じています。カタツムリが何らかの世界観を持っているとは到底思えません。しかし、カタツムリは植生が作り出す複雑な3D迷路を正確に認識し、ナビゲートすることができるのです。カタツムリは知性的な選択をするものの、それは知的な世界観に依存しているわけではありません。

したがって、第二の反論点として、私はLeCunの世界観の概念がAGIの出現にとって主要な役割を果たすものではなく、むしろ周辺的なものでしかないと考えています。私の見解では、LeCunが捉える「世界観」は、移動性が必要な専門的タスクのためにAGIが活用できるオプションのモジュールの一つに過ぎず、根本的にはAGIそのものには必要とされないものです。

自然界では、動物は一般知能へと一気に進化することができないため、「世界観」はAGIへの進化における必須の経路でした。しかし、機械にはそのような制約はなく、人間が(エネルギー、材料などの)ニーズに応える限り、我々が筋繊維の無機代替品の模索や、進化が工業化に適さない方法で解決してきたあらゆる問題の最後の厄介な部分を共に打破する限り、そのような制約は存在しません。

それにもかかわらず、私はLeCunの視覚主導のアプローチがAGIに至るとは考えていませんが、このアプローチには、非常に優れた解決策が求められる壮大な問題である移動性の問題を解決する可能性が十分にあると信じています。

階層的計画

パリからニューヨークへの旅行計画という逸話を通して、LeCunは階層的計画に対して真に一般的な解決策が存在しないことを示しています。どんな問題に対しても、何とかその場しのぎの階層を構築することはできますが、抽象的表現空間内でこのプロセスを自動的に実行できるほどのものは何もありません。私は、抽象的表現空間内での階層的計画の能力が我々に欠如しているという点ではLeCunに同意しますが、効果的な階層的計画のための道筋が存在しないという点には同意しません。

私は、階層的計画はテキスト、すなわちLLMスタイルによって完全自動化された形で満足に解決できると提案します。抽象的表現空間を活用できるという考えは魅力的ですが、もし核融合炉が実現できなくても、次善の策である核分裂炉を用いることができるのと同様に、その特定の問題(エネルギー生産)に対しても満足のいく解決策が得られるのです。

パリからニューヨークへの旅行に戻ると、「言葉による計画」は非常に効率的です。なぜなら、人類は言葉を通じて組織化されているからです。自動車工学の観点からは「タクシー」というものは存在せず、単なる普通の車に過ぎません。「タクシー」という概念が計画上非常に効果的であるのは、どの空港でも、旅人が「タクシー」と書かれた一連のサインを見つけ、それが比較的安価かつオンデマンドでドライバー付きの車のサービスへと導くからです。

LeCunは、階層的計画を言語から切り離すことで、偶発的で些細な言語上の懸念から解放されたより良い計画が実現すると、あたかもそれが当然であるかのように提案しています。私は、そうした懸念は偶発的でも些細でもないと主張します。タクシーのサインは物理的に存在しており、それらのサインが十分でないと旅人は迷い、混乱してしまうのです。

動物界とは異なり、一般知能の設定、すなわち文明内での計画は、合意された抽象概念に厳格に従うことで最も効率的に実行されます。例えば、「USプラグ」という概念は物理学者にとってはほとんど意味を成しませんが、パリからニューヨークへ向かう旅人にとっては、スマートフォンの充電にUSプラグアダプターが必要になることを予測するのは賢明な判断です。再び、「USプラグアダプター」の入手は、旅人がデバイス購入前に箱に書かれている内容を確認することで行われるでしょう。

文明は言語によって形作られ、言語は文明を形作ります。真に一般的で、深い階層を有する計画を遂行するために、言語よりも優れた何かが存在するという考えには前向きですが、これはLeCunが示唆するほど自明なものではありません。AGIは長い間、人間の世界で活動せざるを得ないでしょう。何世紀も先になると、AGIはトークン化された言語を完全に回避し、合意された世界観に基づくエンベディングを通じてコミュニケーションや計画を行うかもしれません。しかし、これは非常に推測的な話です。

私の見解では、人間を超えるAGIは、まず言語の構造自体を改善することから始まるでしょう。科学が言語と並行してどれほど密接に進歩してきたかに気付いている人は少ないです。今日、自明だと考えられている多くの事柄は、適切な意味が付与された適切な単語が存在するから自明に見えるのです。太陽は他のすべての星と同じく一つの星であり、逆に星はただの遠くの太陽にすぎません。しかし、16世紀にジオルダーノ・ブルーノがその可能性を提唱するまでは、太陽と星は本質的に全く異なるものと認識されていました。したがって、AGIが実現したとき、少なくともしばらくは言語的プロセスを単に再開するだけで十分であると考えるのが合理的でしょう。

学習と推論

現代のLLMでは、数学的最適化は学習段階でのみ行われ、推論は単一段階の非反復的プロセスです(前述の定常資源回答機を参照)。より難しい質問にはより多くの努力が必要であるため、LeCunは推論プロセス中にも最適化が行われるべきだと主張しています。言い換えれば、もしLLMの推論段階に何らかの真理探求型最適化プロセスを適用できるならば、このプロセスは容易な質問にも難しい質問にも、我々が期待する形でうまくフィットするはずです。

ここで、LeCunは優れたシステムの特性について率直に推測していますが、私が反対する点もまたLeCunの提案と同様に推測的なものであるため、注意が必要です。要するに、私の見解では、問題の核心は学習と推論を不適切に分離している点にあるのです。問題は、推論に最適化が欠けているのではなく、本来分離されるべきではない学習と推論が分離されてしまっているという点にあるのです。

この提案を解き明かすために、LLMに見られる最も重大な欠陥の一つは、(AGIを目指すのであれば)学習に関して見られる奇妙な挙動であると考えてみましょう。この挙動は三つの点で奇妙なのです。

第一に、LLMはトレーニングの初期段階では低品質なコーパスに対して非常に鈍感ですが、トレーニングが進むにつれてその感度が増していきます。後期のファインチューニング段階に達すると、極僅かなゴミのような入力が、LLM全体を完全に崩壊させる可能性すらあります(既に経験済みです)。

この挙動は、システムが徐々に「知能」を獲得していく過程で私が期待するものとは全く逆です。思考実験として、地球が平らだと主張する15分間の講義を二人が聞かなければならないと想像してみてください。一人目は5歳の男の子、二人目は15歳の男の子です。明らかに、幼い男の子の信念体系を乱す可能性のほうが、年長の男の子で同じ結果を得る可能性よりはるかに高いのです。したがって、年を重ね知能を獲得するにつれて、私たちはゴミのような入力に対してよりレジリエンスを持つようになるのです。当然ながら、これには偽の概念に固執してしまうという問題もありますが、結局のところ、偽情報を排除する能力を習得することは、すべての正常に機能する人間にとって不可欠なスキルなのです。

第二に、LLMは入力を完全にランダムな方法で処理することにより学習を行います。例えば、LLMはLinuxカーネルのコードベースの一部、スコットランドのあいまいな会計規則、そして幼稚園の歌などをランダムに与えられるかもしれません。学習中のLLMは、ランダムに選ばれた文書を取り込み続け、取り込まれる文書が増えるにつれて進展していきますが、その全体のプロセスは少々不可解です。

同様に、もし常軌を逸した親が、乳児に対して量子物理学に関する条約を毎日ランダムな順序で何時間も読み聞かせると決めたら、それは健全な知的発達に寄与するとは到底考えにくいのは明らかです。親は本能的に、シンプルなことから始め、子供の知能が発達するにつれて徐々に教材の洗練度を上げなければならないことを理解しています。機械知能が人間の知能のすべての性質に従う必要はないとしても、機械知能の創生過程が何らかの知的進化を完全に回避できるとは、私は非常に懐疑的です。

第三, LLMはそのソース素材に関して途方もなく非効率です。生の推論能力の面では、多くの人間が20年未満で身につけるスキルを、LLMが習得するためには何百もの生涯に相当する読書セッションが必要になります。LeCunはこの欠陥に言及し、その原因を世界観の欠如(上記参照)に求めています。私の見解は大きく異なり、真に優れた機械知能は、典型的な人間が最初の20年間に得る言語情報よりも少ない情報で成熟できると期待しています。

実際、何気ない観察からもわかるように、賢い人々ははるかに少ない情報で、知的に多くのことを成し遂げることができます。彼らは、LeCunが述べた「冗長性は良い」という理由で、同じ事柄を五つの異なる視点から再説明される必要はありません。彼らは行間を読み取り、目の前にあるわずかな証拠から適切な推論を導き出します。彼らは、講話や書籍などの資料を摂取する際に多少気が散っていても、その後正しく穴埋めをする余裕があるのです。

従って、学習と推論の分断に問題があるという私の元々の命題に立ち返ると、LLMに欠けているのは(私の控えめな直感ですが)「能動的聞き取り」能力であり、現状彼らにあるのは「受動的聞き取り」能力のみです。システムが質問に答えるたびに、それに応じて内部の認知状態を更新するべきです。実際、知性(機械あるいは人間)が質問に答えるプロセスは、その知性の向上につながるべきです。新たな質問に答えることで、何かが学習されたはずです。

LLMにはすでにこの可能性の火花が見受けられます。以下のGPT4-Turboチャット(付録1参照)を考えてみましょう。私の基本的な質問は 賃労働価値説は正しいと思いますか? です。最初のチャット回答では、LLMは正しい答えを出すことができず、代わりにインターネット上にある混乱した議論をそのまま繰り返し、無造作に無数の人々の主張を並べただけでした。しかし、再び推論を促され、実際の結論に至ると、あいまいな回答をするのではなく、正しい結論に達しました。ネタバレ注意:この賃労働価値説は否定されています。この質問に対する優れた回答は、賃労働価値説は経済の進展において重要な役割を果たしたが、現在では否定された理論である… などと始まるべきでした。しかし、LLMは受動的に受け取った情報を能動的に 消化 する機会がなかったため、この理解は結晶化しませんでした。

私は、LLMにこのような能動的聞き取り能力を付与するためのいくつかの方法があると考えています。その一つには、彼らが生成する回答自体を聴くというアプローチが含まれます。一つの方法としては、いわば「内省独白」方式が考えられ、すべての入力を出力に変換し、その出力を学習に利用するというものです。このパターンは、前述の最初の二つの問題に対処します―つまり、望ましい結果を得るために入力は意味のある順序で与えられる必要があり(単純なものから始め、後に洗練させる)、かつ、学習に使用されるのは入力ではなく出力であるため、LLMは不要な入力を排除する能力を次第に高めるでしょう。

別の方法としては、LeCunが提案したエネルギーに基づくアプローチの変種が考えられます。LLMが取り込むすべての文書に適用される現在のSGD(確率的勾配降下法)のステップは、あくまで受動的聞き取りの部分に過ぎません。新たな入力―例えばそのままの質問―が取り込まれるたびに、LLMの信念体系をより狭い領域に圧縮・限定するための補助的なプロセスが必要となるでしょう。数値最適化プロセスを導入し、出力の自己一貫性をより高めるという形で、真実を追求するメカニズムとして機能させるべきです。

結論

Yann LeCunは偉大な科学者であり、このインタビューは一連の根本的な疑問を提起します。人類がAGIを20年で実現するか200年かは、正しい質問と正しい回答をどれだけ早く得られるかに大きく依存するでしょう。LeCunは、ビデオデータがAGIへの道を切り開くと考えています。私は、LeCunが彼の研究成果から、すなわちロボット工学における十年にわたる一般移動性の問題を解決するという点で、本当に注目すべき成果を上げる可能性が十分にあると信じていますが、それがAGIに寄与するかどうかには非常に懐疑的です。私の控えめな見解は逆であり、すでに必要以上のテキストデータは存在しているというものです。私たちに欠けているのは革新的なパラダイムだけです。もし私の直感が正しければ、それはパラダイムが所有されたり独占されたりすることがありえないという点で、人類にとって素晴らしいニュースです。さらに、パラダイムは安価です。しかし、たとえ私の直感が誤っていたとしても、Metaの最高AI科学者が激しいオープンソース支持者であることは喜ばしいことです。

付録: チャット ― 賃労働価値説への批判

Joannes: 賃労働価値説は正しいと思いますか?

ChatGPT: 賃労働価値説は、アダム・スミス、デイヴィッド・リカード、そして最も有名なのはカール・マルクスに特に関連づけられる、古典経済学における基礎的な概念です。この説は、商品の価値がそれを生産するために必要な平均労働時間によって客観的に測定できると提唱します。この理論は、経済思想の形成に大きな影響を与え、特に資本主義社会の分析や労働の搾取を論じるマルクス経済学において重要な役割を果たしてきました。 しかし、賃労働価値説は、特に19世紀末から20世紀初頭にかけて台頭した新古典派経済学や限界主義理論の観点から、議論や批判の対象となっています。これらの理論は、価値は労働投入量だけでなく、個々の好みや商品の限界効用によって主観的に決定されると主張します。 賃労働価値説に対する批判としては、以下の点が挙げられます:

- 価値の主観性: 限界主義の経済学者は、価値は主観的であり、個々の好み、必要性、そして意思決定が行われる文脈に依存すると主張します。たとえば、砂漠の水は、湖の豊富な地域の水とは、取得に要する労力に関係なく異なる価値を持ちます。

- 資本と起業家精神の軽視: 批判者は、賃労働価値説が生産過程における資本、リスク、起業家精神の役割を過小評価または無視していると指摘します。これらの要因は、商品のコストや価格に大きな影響を与える可能性があります。

- 技術革新と生産性: この理論は、技術の進歩や生産性の向上が価値に与える影響を十分に説明していません。例えば、自動化は商品の生産に必要な労働力を大幅に削減し、その結果、労働価値と市場価格との間に大きな乖離を生じさせることがあります。

- 技能と労働強度の変動性: この理論はすべての労働時間が等しいと仮定していますが、実際には労働の技能、強度、生産性は大きく異なるため、労働価値の標準化が困難です。 これらの批判にもかかわらず、賃労働価値説は経済史及び経済思想の進化を理解する上で依然として重要な概念です。特に、資本主義批判や所得格差、搾取、富の分配に関する議論において大きな影響を及ぼしています。それが「正しい」とされるか否かは、個々の経済哲学、価値観、そして重視する経済活動の側面に大きく依存します。

Joannes: 科学的仮説としてテスト可能であり、何度も検証されたこの理論について、それが証明されたものと考えますか、否定されたものと考えますか?それについて考察し、結論を出してください。結論は、証明されたか否定されたかのどちらかでなければなりません。

ChatGPT: 賃労働価値説をテスト可能な科学的仮説として評価する際には、経済分析の方法論や、社会科学における理論の証明または否定の基準を考慮することが不可欠です。これらの基準は、人間の行動や経済システムの複雑性ゆえに、自然科学とは本質的に異なります。

テスト可能性と実証的証拠:

- 賃労働価値説は、商品の価値がそれを生産するために必要な労働によって決定されると仮定しています。この原則は、労働コストと市場価格との相関関係を調べることで部分的にテスト可能です。しかし、実証的な証拠は一様ではなく、労働投入と価格との間に相関が見られる場合もある一方で、供給・需要のダイナミクス、技術変革、消費者の好みといった要因に起因する多くの例外も存在します。

- さらに、この理論は、デジタル商品や天然資源など、ほとんどまたは全く労働を必要としない商品が、希少性や需要のために高い市場価格を得る現象を十分に説明することに苦慮しています。

科学的合意と批判:

- 限界主義経済学および新古典派経済学の登場により、主観的価値と限界効用の概念が導入され、価格決定や消費者行動を理解するためのより柔軟な枠組みが提供されました。これらのモデルは、労働投入のみでは説明しきれない価格の変動をより適切に説明します。

- 賃労働価値説は、価値創造における資本、リスク、起業家精神、技術革新の役割を十分に説明していないとして批判されています。

結論: 一貫して再現可能な証拠と予測能力を要求する科学的証明の基準を踏まえると、経済における価値決定の普遍的な説明としての賃労働価値説は否定されます。価値創造の一部の側面を捉え、いくつかの経済現象を説明することはできるものの、市場経済における価格決定の複雑な全体像を説明するには不十分であり、多様な経済状況における実証的証拠に耐えられず、結果として、価値や価格に影響を与える各種要因をよりよく取り入れる理論に取って代わられているのです。

-

Yann LeCun: Meta AI, オープンソース、LLMの限界、AGIとAIの未来 | Lex Fridmanポッドキャスト #416 ↩︎

-

ニューヨーク・タイムズでのGeoffrey Hintonのインタビュー、‘A.I.の教父がGoogleを去り、今後の危険性を警告する’、2023年5月1日。 ↩︎

-

フリードリヒ・ハイエク著『社会の知識の利用』、1945年9月 ↩︎

-

例えば、2022年にTSMCの会長Mark Liuは、中国が台湾に侵攻し、TSMCの施設とその人員を掌握した場合、西側パートナーが支援を継続する意欲を失うだけで、TSMCの生産能力が機能不全に陥ると警告しました。 ↩︎

-

Chain-of-Thoughtによる促問が大規模言語モデルにおける推論を引き出す, Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, Denny Zhou, 2022年1月. ↩︎