Yann LeCunへのLex Fridmanのインタビューに対する意見

世界で最も影響力のあるAI研究者の1人であるYann LeCunは、最近、Lex Fridman1との3時間に及ぶインタビューを共有しました。このインタビューは注目に値し、明確で明快な思考を持つYann LeCunが最高の状態で科学を動かす様子を示しています。私は人工知能(AI)に興味を持つ人には、このインタビューを強くお勧めします。ただし、私はYann LeCunが提案するすべての主張を完全に支持しているわけではなく、これらの意見の相違は単なる学術的な議論よりも重大な影響を与える可能性があります。次のエントリでは、より広範な支持が必要な主張から始め、私が疑問視する主張について続けます。

現在のAIに関する話題は、Yann LeCunが正しく特徴付けるように、実際には自己回帰型のLLMs(Large Language Models)から派生しています。トークン(単語の断片)は一度に1つずつ生成され、前のトークンを生成したモデルにフィードバックされます。LLMsはChatGPTの秘密のソースです。GPT4と数時間過ごす私を含む多くの人々は、目眩を感じずにはいられません。これは人工汎用知能(AGI)かもしれませんが、それでも非常に印象的です。その衝撃は深く、AGIは人類にとって本当の絶滅レベルの脅威として頻繁に提示されることがあります - 現実のターミネーターのシナリオです。

絶望と悲観

Yann LeCunは、この「絶望と悲観」の視点は完全なばかげた考えだと主張しており、私は完全にこの立場を支持しています。終末のシナリオには、AGIがイベントである必要があります。つまり、一つのAGIが他のすべてよりもはるかに進んでいる時点が存在しなければなりません。しかし、Yann LeCunはAGIが「イベントではない」と主張し、私も同意できます。

一般の人々は、2023年に突然技術が飛躍したという印象を持つかもしれませんが、これは全くの誤解です。それどころか、過去50年間にわたって進歩は非常に、退屈で、煩わしいほど段階的でした。さらに、改善されているのは「1つ」のことではなく、多くの関連性の低い問題です。より良いパラダイム、より良いアルゴリズム、より良いハードウェア、より良いデータセット、より良い方法論、より良いコードベースなどです。これらの改善は、非常に多様な貢献者によって生み出されてきました。したがって、AGIへの飛び越えの確率はゼロだと推定しています。残念ながら、終末の予言は人類自体と同じくらい古くから存在し、自己顕示欲のために多くの人々がその流行に乗りました2。

AGIの「イベント」の側面を取り除いた場合、なぜAGIが絶滅レベルの脅威として現れるのか非常に難しいです。悪意のあるAGI、または悪意のある行為者が操作するAGIは、軍隊、情報機関、企業、さらには大学や趣味の開発者が開発した同様に能力のあるAGIによって対抗されるでしょう。AGIは、悪用された場合に莫大な損害をもたらす技術の長いリストに遅れて追加されるだけです。

実際、私はさらに主張します。たとえ人類が直接AGIに飛び込んだとしても、例えばエイリアンの文明がすでに作成済みの設計図を提供した場合でも、終末のシナリオは非常に起こりにくいでしょう。80年前にハイエク3が指摘したように、2つのタイプの知識があります。特別な知識(数式、概念など)と日常的な知識(時間と場所の知識)です。知識人はほとんどの場合、特別な知識だけが重要な知識であるかのように扱います。AGIは特別な知識の頂点であり、そのため、多くの知識人はこの観察から、特別な知識の主であるこのAGIが世界全体の主でもあると結論づけます。しかし、その「特別な知識」にもかかわらず、このAGIにはまだ日常的な知識が欠けており、これは過小評価されてはならない大きなギャップです。

さらに、AGIは先進的な産業文明の産物です。そのため、それは複雑で壊れやすい供給チェーンに鋭敏に依存します。実際、半導体は最も複雑な産業の1つです4し、(AGIが半導体を介さない場合)他のハードウェア技術もほぼ間違いなく同様に洗練されて壊れやすいでしょう。AGIの持続的な存在は、数十年、場合によっては数世紀にわたる人類の積極的な支援に依存します。人々はこれまでのすべての技術の台頭に伴う必然的な問題に対処するために十分な時間(と機会)を持っていました。少なくとも今のところ、この技術が他のどの技術とも異なるという兆候はありません。

LLMはAGIには不十分です

LeCunは、より大きく、より速いLLMがAGIに到達するためには不十分だと主張しています。私も同意しますが、以下で見るように、LeCunが提示したものとはまったく異なる理由で同意します。ただし、現在のLLMは少なくとも不完全です。LeCunが正しく指摘するように、LLMはチューリングテストに見事に合格しますが、チューリングと彼の同時代の人々には考えられなかったさまざまな方法でゲーム化される可能性のある知能の非常に悪いテストです。

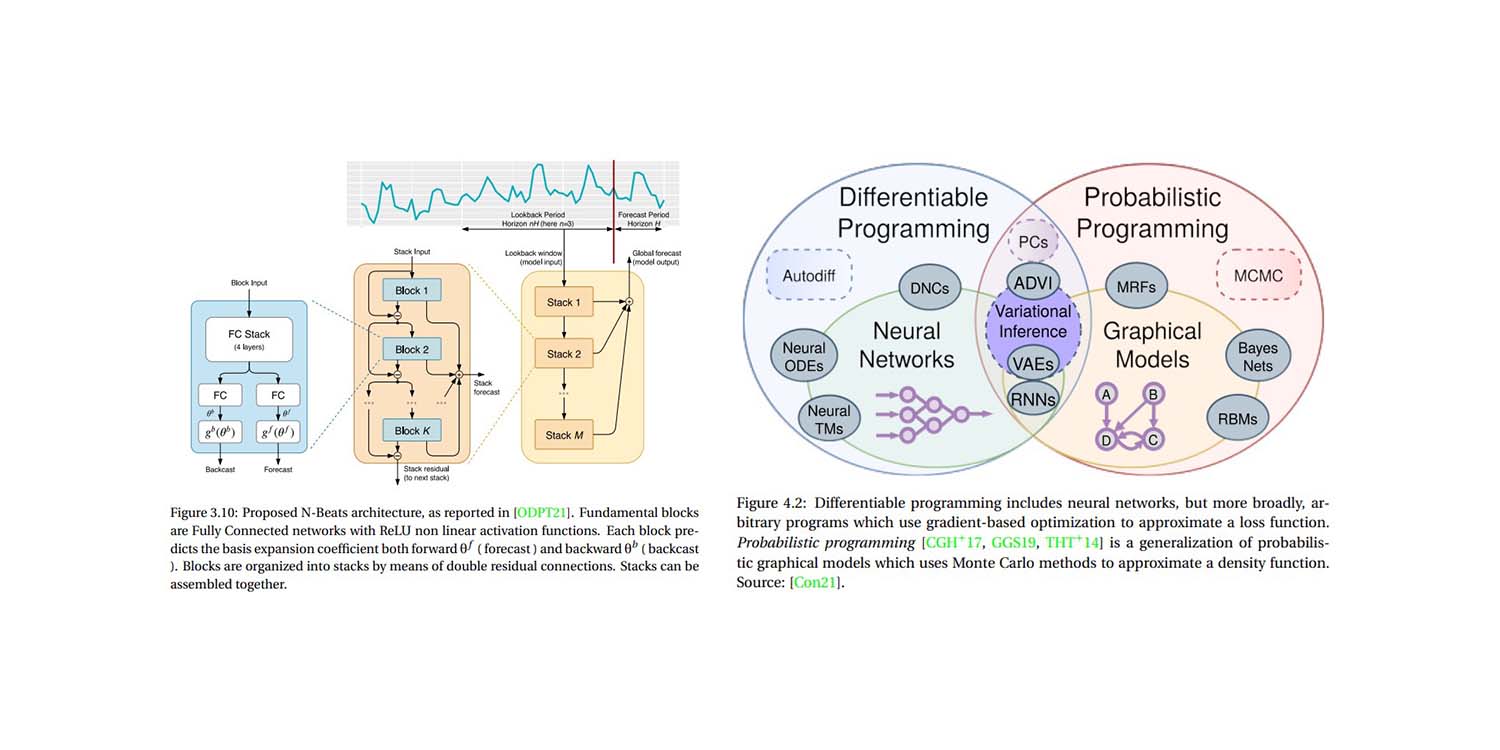

LeCunが知能に帰属させる特性は、未来を予測する能力です。予測が良ければ良いほど、知能は高まります。全体的には、この視点に賛成ですが、私は少し異なるバリエーションを好みます。私は知識そのものには関心がなく、将来の報酬を考慮したときにより良い選択をする能力を知能と定義します。

私の定義は、カタツムリから偉大な科学者までの知能の全スペクトルをカバーしています。ただし、このスペクトル内で「知的」と見なすべきもの、つまり「一般的な知能」の現れとして考えられる閾値は明確ではありません。

私は一般的な知能を、知能自体を意図的に向上させる能力と定義します。この知能の意図的な自己向上は、現時点では非常に特定の人間にしか存在しません。オルカやチンパンジーのようなスマートな動物は、文化的な荷物(狩猟や採集の技術など)を子孫に伝えることができます。しかし、彼らは多くの知能を示しているにもかかわらず、人類が始まり以来存在している謎や物語には到底及びません。謎は、単に心を鍛えるためのエクササイズです。物語は同様の役割を果たしますが、感情的な反応を利用して記憶を容易にします。

このテストに基づくと、LLMはまだ知能を持っていないため、自己向上することができません。ただし、LLMは有用なコードを生成する能力が非常に高いため、これまでに存在したどの技術よりも自己向上に近づいています。しかし、AGIへの旅の継続は依然として人間の頭脳に完全に委ねられています。

長いシーケンスの呪い

トークン生成が進むにつれて、LLMは回復不能な設計上の欠陥に苦しんでいると、LeCunは主張しています。つまり、エラー率が指数関数的に増加し、十分に長いシーケンスではゴミが生成されることが保証されています。技術的な議論は簡単です。$$p$$を誤ったトークンを選ぶ確率の下限とします。$$n$$個のトークンからなるシーケンスでは、正しいシーケンスを得る確率は少なくとも$$(1-p)^n$$以上です。したがって、ゼロへの指数収束は、冗長な回答には意味がないことを保証します。

この点について、私は丁寧にですが、断固としてYann LeCunとは異なる意見です。この視点は、1つの「正しい」答えを生み出すことが目標である場合には正しいかもしれません。実際、例えば$$\pi$$の桁の列を予測しようとしている場合には。このようなタスクでは、LLMの設計によって桁が間違って出力されることが経験的に確認されています。

最初の異議は、$$n$$が大きくなるにつれて「漸近的な」視点がどんなシステムに対しても合理的な要求ではないということです。実際、LLMに任意の長さの、非反復的で連続的に正しい回答を生成する能力を要求することは合理的でないと思います。非常に知能の高い人間にとっても、この要求は合理的ではありません。何かについて言及することができる量や、抽象的な推論プロセス(形式は問わない)が空想に退化するまで、行動計画をどれだけ立てることができるかには限界があります。実際には、LLMは自身の終了条件を生成します。したがって、$$n$$はモデル自体によって上限が設定されており、ゴミへの収束は起こらない必要があります。私たちは単に、ほとんどの質問に対して「わかりません」という知的に受け入れられる回答を受け入れる必要があります。

2つ目の異議は、トークンごとの妥当性からシーケンスごとの妥当性への「自明な」移行は、実際には不正確であり、惑わすものであるということです。実際、この議論全体は、「不正確な」トークン(つまり、確率$$p$$)が存在するという考えから派生しています。これは事実ではありません。次の例で示されるように:

質問: ピエール・シモン・ド・ラプラスは偉大な数学者でしたか?(フランス人の意見を持って答える)

回答A: いいえ、全くそうではありません。

回答B: いいえ、全くそうではありません、彼はその時代で最も偉大な人物でした!

「いいえ」というトークンは、_回答A_によって完全に間違ったトークンであるように思われます。しかし、この回答が文の後半で拡張されると、正しいトークンになり、ここで期待されるトーンと構造を捉えます。トークン「いいえ」の妥当性は、後で生成されるトークンから独立して評価することはできません。

ここで、LeCunのインタビューでも触れられているように、高次元の確率分布を適切に評価するための実用的な方法はわかっていません。言語では、トークンごとの視点から洞察を得ることはできません。ビジョンにおいても、ピクセルごとの視点から洞察を得ることはできません。

資源を一定に使う応答機

一般的に、LLMは次のトークンを生成するために一定量の計算リソース(帯域幅、メモリ、計算)を必要とします。LeCunは、これをLLMの設計上の欠陥の現れと指摘し、特定の質問は他の質問よりもはるかに難しいということ、そしてLLMは質問の難易度に関係なく同じリソースを消費するように見えると述べています。

私は、特定の質問が回答するのが難しいことは明らかであり、それらの質問に回答するためにはより多くのリソースが必要であるべきだという評価には同意します。ただし、LLMは資源を一定に使う応答機ではないという評価には異論があります。2022年の発見の連鎖思考5は、LLMにとって画期的なものでした。要するに、「一歩ずつ考えましょう」というプロンプトを追加することで、LLMは問題のクラス全体に対してより良い回答を得ることができます。私自身の経験的評価もこれを裏付けており、LLMに段階的な問題解決の可能性を示唆することで、提供される回答の品質を大幅に向上させることができます。ただし、このような段階的な回答は、LLMが即座に回答するのではなく、正しい回答に至る推論を構築するという、資源の変動的な消費の直接的な現れです。

2023年には、私はいくつかのLLMが徐々に改善され、回答を提供する際の適切なペースを自動的に選択する能力が向上しているのを目撃しました。これにより、回答の配信は1語(即答)から結論に至るまでの1ページまでの範囲になりました。私の仮説は、人間のフィードバックからの強化学習(RLHF)データセットが徐々に拡大され、LLMが回答を自動的に選択する能力が向上しているため、LLMは一定のリソースを消費する応答機ではないというものです。再度、LeCunはトークンレベルの観察からシーケンスレベルの特性を導き出すという間違いをしているようです。

ただし、私にはLeCunの指摘が方向性として正しいことも明らかです。LLMは、リソースの消費の変動をより積極的に行うことで、ほぼ確実に大幅に改善できると想像するのは簡単です。各質問を分類器に送り、トークン生成を行うための「適切なサイズ」のLLMを選択するセットアップを想像することは容易です。実際、どのような課題に対しても、私を含むほとんどのLLMの実践者は、最も大きくて高価なLLMから始めるようです。それが機能している場合、私たちは徐々により小さくて安価なLLMに移行しようとしますが、追加の努力に見合う節約が見られない場合には停止します。将来的には、このプロセスはおそらくより良いLLMまたはより良い計測器によって廃止されるでしょう。

AGIへの高帯域幅の道

言語は、ビジョンに比べて低帯域幅のチャネルです。実際、LeCunは、子供が目を通して得る情報(情報エントロピーを考えてください)は、Wikipedia全体を読むことよりも多いと指摘しています。LeCunは、ビジョンが学習の観点から非常に望ましい高度に冗長な信号であるとも指摘しています。これらの観察から、LeCunは、AGIの道は確実にビジョンのような高帯域幅のチャネルを前面に押し出すことを提案しています。これは、現実的には、AGIに至るために十分な書かれた資料は決して十分にはないためです。要するに、LLMは高帯域幅のチャネルの必要性を回避するために、不正行為をしています。LLMは、既存の大規模で高品質なコーパス(例:Wikipedia、GitHub、Stack Overflow)の短いシリーズによって機能していますが、これらのコーパスが利用された後、同等のものに頼ることはできません。Wikipediaと同じくらい豊かで多様な10の他のオンライン百科事典があれば素晴らしいのですが、実際にはありません。おそらく、それらを書くことができるAGIが登場するまで、これ以上はありません。

しかし、この議論は魅力的ではありますが、反対の証拠も存在します。私は生まれつき盲目の人々と出会う機会がありました。もし私たちがルクンの論理に従うのであれば、視覚のような高帯域チャネルにアクセスできないことは知能を妨げるはずです。したがって、幼少期の盲目は知能に少なくとも少しは影響を与えるはずです。しかし、私の経験則ではまったく逆でした。私はその人々の中の誰もが著しく平均以上の知能を持っていることを発見しました(例:記憶力の向上、言語コミュニケーションの向上、計画能力の向上など)。彼らの障害の性質に関しては、驚くべきことではありません:盲目の人々は常に知性を使って、視覚の不足を補うためにあらゆる方法で知性を使わなければなりません。これらの観察結果は、高帯域チャネルがAGIへの道ではないという仮説に反対しています。

実際、動物界を考えると、私はほぼ逆のことを述べるでしょう。ほとんどの猫の飼い主は、彼らのペットの視点から見ると、人間は半盲目で半耳の聞こえない生物であり、ハエが鼻に着くまで気づくことができません。これもまた、高帯域チャネルがAGIへの道を開くという命題に矛盾する間接的な証拠です。

生まれつきの盲目は、認知の発達を妨げるかもしれませんが、言語の剥奪はそうではありません。言語へのアクセスを意図的に奪うという実験は、倫理的な犯罪ですが、歴史を通じて何度も行われてきました6。必ずしも子供たちは「遅れている」という結果になりました(臨床的な意味での「遅れている」)。同様の結果は霊長類でも得られていますが、倫理的な懸念からさらなる調査は行われていません。これらの間接的な証拠も、言語が知能の出現において重要であることを示唆していますが、それは低帯域チャネルであるにもかかわらずです。

モラベックの逆説の解決

モラベックの逆説7は、1980年代に最初に提唱された観察であり、ティーポットをつかんでカップにお茶を注ぐといった最も単純な問題が、人工知能にとって最も困難な問題であることを示しています。ルクンは、これまで欠けていた唯一の重要な要素は、世界または世界観の抽象的な表現ですと主張しています。この世界観は、すべての基本的な移動操作(自動運転車やアンドロイドなど)をサポートするために重要であり、またAGIの真の基盤としても機能することが期待されています。

ルクンの主張では、LLMは世界自体を知らないため、何も知らないとされています。それによって、LLMは知能を偽装することに非常に優れているだけであり、AGIには到達しません。さらに、世界観の欠如は、人間にとっては当たり前すぎて言葉にする必要もない(おそらく言葉にすることさえできない)日常の現実の些細な側面に永遠に困惑し続ける運命に繋がります。ルクンは、ビジョンデータセットに適用された共有埋め込みメソッドが、現在、この世界観をエンジニアリングするための最善の手段であると提案しています。これによって、後にAGIへの道が開かれるでしょう。

私はこの視点について2つのレベルで異議を唱えます。

まず、モラベックの逆説は、正しい視点からアプローチすれば、まったく逆説ではありません。この状況を「逆説」として捉えることの暗黙の仮説は、動物の移動能力(および動物の計画能力)が「養育」ではなく「本性」であるというものです。言い換えれば、移動能力は学習プロセスの結果であり、過去40年間にわたって人工手段で再現することが非常に困難であることが証明されています。

私の主張は、非常に大きな範囲で、それはまったく学習プロセスではないということです。たとえば、子馬(およびロバやシマウマなどの馬科の他のメンバー)は生まれて数時間で立ち上がり、歩くことができます。このプロセスを「学習」と考えることは間違っています。これはある種の「調整」と考える方が適切です。すべての認知構造はほぼ完全に発達しています。システムはパスウェイが適切に配置されるために少し押されるだけです。

動物の移動能力と計画能力のこのほとんど先天的な側面は、ほとんどの他の哺乳類と比較して人間では明らかではありません。これは、頭部の発達が長い妊娠期間のボトルネックであるため、人間の出産が非常に早産であるためです。多くの人々が乳児の「学習している」と捉えるものは、もし乳児が数ヶ月間も子宮内にいた場合には妨げられることなく進行する認知の発達です。

これらの認知構造は、主に先天的なものであるため、進化の産物であると言えるのは理にかなっています。これらの構造は(おおよそ)8億年以上の進化的な圧力を受けて改善されてきましたし、非常に多くの個体数によってもたらされました。したがって、現代の動物の移動能力を機械に求める基準として、この基準が非常に難しいことが判明するのは全く驚くことではありません。太陽光を構造材料に変換する点で木よりも優れた装置を設計すること、またリボソームをマクロ分子の工場として上回ることと同じくらい困難な課題です。長い時間にわたって行われてきたゲームで進化を上回ることは、非常に困難です。

しかし、物語などの抽象的なスキルは、遡ること1〜5百万年(おおよそ)しか進化のゲームの一部ではありませんでした。さらに、個体数も非常に限られていました。なぜなら、大型類人猿は非常に珍しいだけでなく、寿命も長いため、進化プロセスが他のほとんどの動物と比較して遅くなるからです。

したがって、移動能力を実現するためには、数百もの複雑に結びついたヒューリスティックスを工学的に設計する必要があります。これらのヒューリスティックスは、ルクンが示唆するような内部の「世界観」を中心に回っているかもしれませんが、私の直感的な感覚ではそうではないと思います。私は、カタツムリには何の世界観もないと深く懐疑的です。それでも、カタツムリは植生が表す複雑な3D迷路を正しく認識し、進路を選択することができます。カタツムリは知的な選択をしますが、知的な世界観は持っていません。

したがって、意見の相違点として、私はルクンの「世界観」という概念がAGIの出現においてほとんど周辺的なものであるとは考えていません。私の考えでは、「世界観」(ルクンの見方によると)は、専門的な移動能力を必要とする特定のタスクのためにAGIが利用できるオプションのモジュールの1つになるでしょう。しかし、基本的には、AGI自体には必要ありません。

自然界では、「世界観」は一般的な知能に飛び越えることができない必要な進化の道でした。しかし、機械にはそのような制約はありません。私たちが最後のイライラするような細部、例えば筋繊維の無機質の代替物を見つけること、および進化が産業化に適さない方法で解決した問題の種類を突破する方法を共同で見つける限り、彼らのニーズ(例:エネルギー、材料)に対応する人間がいる限り、機械にはそのような制約はありません。

階層的な計画

ルクンは、パリからニューヨークへの旅の計画を立てるという逸話を通じて、階層的な計画にアプローチするための真に一般的な解決策が欠如していることを示しています。任意の問題に対して、何らかの形で_ad hoc_な階層構造を作り出すことはできますが、抽象的な表現空間内でこのプロセスを自動的に実行する能力はありません。ルクンの主張には同意しますが、私たちは効果的な階層的な計画のための道筋を持っているとは考えません。

私は、階層的な計画はテキスト(LLMスタイル)を使って満足のいく形で完全に自動化された解決策を提供できると提案します。抽象的な表現空間を活用できることは魅力的なアイデアですが、私たちが核融合炉を持つことができない場合でも、次にベストな解決策である核分裂炉を使用することを妨げるものはありません(エネルギー生産の特定の問題に対する満足のいく回答でもあります)。

パリからニューヨークへの旅に戻ると、「言葉を通じた計画」は非常に効率的です。なぜなら、人類はその言葉を通じて自己を組織化してきたからです。自動車工学の観点からは「タクシー」というものは存在しません。それはただの普通の車です。しかし、「タクシー」(概念)が計画上非常に効果的な理由は、どの空港でも「タクシー」という言葉を掲げた一連のタクシーのサインが見つかり、そこでドライバー(車を持つ)のサービスを比較的安価でオンデマンドで借りることができる場所に至るからです。

LeCunは、言語から階層的な計画を切り離すことを提案しており、それによって偶発的で取るに足らない言語上の問題から解放されたより良い計画が生まれるという前提で議論しています。私は、それらの問題が偶発的でも取るに足らないわけではないと主張します。タクシーのサインは物理的に存在し、それらのサインが十分にない場合、旅行者は迷子になり困惑します。

動物界とは異なり、一般的な知能環境での計画(つまり、文明内での計画)は、合意された抽象化に厳密に従うことによって最も効率的に行われます。たとえば、「USプラグ」という概念は物理学者にとってはほとんど意味を持ちませんが、パリからニューヨークへ行く旅行者にとっては、スマートフォンを充電するためにUSプラグアダプターが必要になることを予測することは賢明な選択です。また、旅行者はデバイスを購入する前に箱に書かれている内容を確認することで、「USプラグアダプター」を手に入れることができます。

文明は言語によって形作られ、言語は文明を形作ります。私は、真に一般的で深層な計画を実行するために言語よりも優れたものが存在する可能性には開かれています。しかし、これはLeCunが言うほど自明ではありません。AGIは長い時間、人間の世界で運用されなければなりません。数世紀後、AGIはトークン化された言語を完全にバイパスし、合意された世界観から派生した埋め込みを通じてコミュニケーションや計画を行うかもしれません。しかし、これは高度に推測的なものです。

私の考えでは、人間を超えるAGIは単に言語構造自体を改善することから始めるでしょう。多くの人々が気づいていないことは、科学が言語とともに進歩してきたことです。今日当たり前と考えられている多くのことは、それに適切な意味が付けられた適切な言葉があるからこそです。太陽は他のすべての星と同じような星です。または逆に、星は単なる遠い太陽です。しかし、16世紀にジョルダーノ・ブルーノがそれが事実であると唱えるまで、太陽と星は本質的に異なるものとして認識されていました。したがって、AGIを手に入れた場合、少なくともしばらくの間、言語プロセスを再開することは合理的です。

学習と推論

現代のLLMでは、数学的最適化は学習段階でのみ行われ、推論は単一段階の反復プロセスではありません(前述の一定リソース応答機に関連)。より難しい質問にはより多くの努力が必要であるべきだという点で、LeCunは最適化は推論プロセス中に行われるべきだと主張しています。言い換えれば、LLMの推論段階に真実を追求する最適化プロセスを適用する場合、このプロセスは簡単な質問と難しい質問の両方に期待されるものにうまく適合するでしょう。

ここで、LeCunは優れたシステムの特性について公然と推測していますが、私は異なる意見です。ただし、私の異議もLeCunが提案した命題と同様に推測的なものですので、慎重に考えてください。要するに、私の考えでは、問題の核心は「学習と推論を誤って分離している」ということです。問題は、推論に最適化が欠けていることではなく、学習と推論が分離されていることです。

この命題を解明するために、LLMにおける最も深刻な欠陥の1つを考えてみましょう。少なくともAGIが意図された結果である場合、この振る舞いは3つの点で奇妙です。

まず、LLMはトレーニングプロセスの初めの方では低品質なコーパスに対してかなり無感覚であり、トレーニングが進むにつれてますます感度が高くなります。後期の微調整の段階に達すると、ごくわずかなゴミの入力でもLLM全体が完全に崩壊することがあります(経験済みです)。

この振る舞いは、「知性」を徐々に獲得するシステムからは予想される逆のものです。思考実験として、地球が平らであると主張する15分間の話を聞かなければならないと想像してみてください。最初の人は5歳の少年であり、2番目の人は15歳の少年です。年齢と知性が増すにつれて、若い少年の信念体系を狂わせる可能性は非常に高くなることが明らかです。したがって、私たちは年を重ね、知性を獲得するにつれて、ゴミの情報に対してよりレジリエンスを持つようになります。もちろん、これにより虚偽の概念に固執するという問題が生じますが、全体として、虚偽の情報を排除する能力は、ある程度のレベルで習得しなければならない重要なスキルです。

次に、LLMは入力を完全にランダムな方法で処理して学習します。例えば、LLMにはLinuxカーネルのコードベースの一部、スコットランドの難解な会計規則、そして幼稚園の歌詞がランダムに与えられるかもしれません。訓練中のLLMは、ランダムに選択されたドキュメントを摂取し続け、ドキュメントが増えるにつれて進歩しますが、このプロセス全体は少し驚くべきものです。

同様に、もし狂気じみた親が毎日数時間を費やして幼児に量子物理学に関する条約をランダムな順序で読むことを決めた場合、これは健全な知的発達には適していないと明らかです。親は、子供の知性が発達するにつれて、シンプルな材料から徐々に洗練された材料に移行する必要があることを本能的に知っています。機械知性は人間の知性のすべての特性に従う必要はありませんが、私は機械的な知性の起源が完全に知的な進化を無視することはないと非常に懐疑的です。

第三に、LLMはソースの材料に対して非常に非効率です。生の推論能力に関しては、LLMが獲得するのに数百世代の読書セッションに相当する時間がかかりますが、多くの人間は20年未満で獲得します。LeCunはこの欠陥を指摘しており、その原因を世界観の欠如に帰しています(上記参照)。私の見解は非常に異なります。私は、真に優れた機械知性は、典型的な人間が最初の20年間に得る言語情報よりも少ない情報で成熟することができると予想しています。

実際、一般的な観察として、頭の良い人々は少ない情報でより多くのことを知ることができます。このような人々は、5つの異なる視点から説明されることを必要としません。彼らは行間を読み取ります。彼らは目の前の少ない証拠から正しい推論を導き出すことができます。彼らは材料を摂取する際にかなり気を散らすことさえ許され、後で欠落部分を正しく補完することができます。

したがって、学習と推論の分離が問題であるという私の最初の命題に戻ると、LLMに欠けているものはおそらく(私の謙虚な予想ですが)「能動的な聴取」のスキルです。現在のLLMには「受動的な聴取」のスキルしかありません。システムが質問に答えるたびに、内部の認知状態を対応して更新する必要があります。実際、知性(機械または人間)が質問に答えるプロセスは、その知性の向上につながるはずです。新しい質問に答えることで、何かが学ばれたはずです。

LLMにはすでにこの潜在能力の火花があります。以下に示すGPT4-Turboチャット(付録1を参照)を考えてみましょう。私の基本的な質問は「労働価値論は正しいと思いますか?」です。最初のチャットの回答では、LLMは正しい答えを出すことができません。代わりに、インターネット上で見つかる混乱を吐き出し、無数の人々が行った議論の雑多なリストを投げつけます。しかし、再び問い詰めて実際の結論に至るようにすると、曖昧な態度をとるのではなく、LLMは正しい結論に至ります。ネタバレ:この労働価値論は反証されています。この質問に対する素晴らしい回答は、「労働価値論は経済学の進歩に重要な役割を果たしたが、現在は反証された理論です…」などと始まるはずです。しかし、LLMは受動的に受け取った情報を能動的に「消化」する機会がなかったため、この理解は結晶化しませんでした。

このような能動的な聴取能力を持つLLMを強化するためには、それが生成する回答を聴くことも含まれるでしょう。一つの方法は、「内的な独り言」のアプローチです。すべての入力を出力に変換し、この出力を学習に使用します。このパターンは、上記の最初の2つの問題に対処します。望ましい結果を得るためには、入力を適切な順序で与える必要があります(最初は単純に始め、その後に洗練されたものに進む)。また、LLMは入力ではなく、学習に使用される出力としてゴミの入力を無視する能力が増していきます。

もう一つの方法は、LeCunが提案したエネルギーベースのアプローチのバリエーションです。LLMが摂取するすべてのドキュメントに適用される現在のSGD(確率的勾配降下)ステップは、受動的な聴取の部分にすぎません。新しい入力、つまり裸の質問を摂取するたびに、LLMの信念体系をより小さな領域に圧縮/狭めるために、別の補完的なプロセスが必要です。数値最適化プロセスを導入して、出力の自己整合性をより高めることを目指す真実探求のメカニズムとして機能するでしょう。

結論

Yann LeCunは素晴らしい科学者であり、このインタビューは一連の基本的な問題を提起しています。人類が20年後または200年後にAGIを作り出すことができるかどうかは、適切な質問と適切な回答をどれだけ速く得られるかに実際に依存するでしょう。LeCunは、ビデオデータがAGIへの道を切り開く手段になると期待しています。私はLeCunが彼の研究努力から本当に素晴らしい成果を得る可能性があると信じています。具体的には、ロボット工学の一般的な移動性の問題を解決することです。しかし、それがAGIに貢献するとは非常に懐疑的です。私の謙虚な見解は逆の方向です。私たちが必要とする以上のテキストデータはすでにあります。私たちには新しいパラダイムが不足しているだけです。私の予想が正しい場合、それは人類にとって素晴らしいニュースです。なぜなら、パラダイムは決して所有することができず、なおかつ独占することもできないからです。さらに、パラダイムは安価です。ただし、私の予想が間違っている場合でも、Metaの最高AI科学者が熱烈なオープンソースの支持者であることは嬉しいです。

付録:労働価値論の批判であるチャット

ジョアネス: 労働価値論は正しいと思いますか?

ChatGPT: 労働価値論は、古典派経済学における基本的な概念であり、特にアダム・スミス、デイヴィッド・リカード、そして最も有名なカール・マルクスと関連しています。これは、商品の価値はそれを生産するために必要な平均労働時間によって客観的に測定できると提案しています。この理論は、特にマルクス経済学において、資本主義社会と労働の搾取を分析するために使用されてきました。 しかし、労働価値論は議論と批判の対象であり、特に19世紀末から20世紀初頭に登場した新古典派経済学と限界効用理論の観点からは特にそうです。これらの理論は、価値は労働に投資されただけでなく、個々の選好と財の限界効用によって主観的に決定されると主張しています。 労働価値論への批判には次のようなものがあります:

- 価値の主観性:限界効用派の経済学者は、価値は主観的であり、個々の選好、ニーズ、および選択の文脈に依存すると主張しています。たとえば、砂漠の中の水と湖の周りの水は、それを取得するためにかかる労働に関係なく、異なる価値を持っています。

- 資本と起業の無視:批判者は、労働価値論が生産プロセスにおける資本、リスク、および起業の役割を過小評価または無視していると主張しています。これらの要素は、財やサービスのコストと価格に大きな影響を与える可能性があります。

- 技術の変化と生産性:この理論は、技術の進歩と生産性の向上が価値にどのように影響するかを十分に説明していません。たとえば、自動化によって財の生産に必要な労働時間が劇的に減少することがあり、労働価値と市場価格の間に大きな差が生じることがあります。

- スキルと強度の可変性:この理論は、すべての労働時間が等しいと仮定していますが、現実には労働のスキル、強度、生産性は大きく異なる場合があります。これにより、労働価値の測定を標準化することが困難になります。 これらの批判にもかかわらず、労働価値論は経済史と経済思想の進化を理解する上で重要な概念です。特に資本主義の批判や所得格差、搾取、富の分配についての議論において影響力があります。それが「正しい」と考えるかどうかは、経済哲学、価値観、および経済活動の側面に大きく依存する場合があります。

ジョアネス: 検証可能であり、何度も検証された科学的な仮説として、この理論を証明されたものまたは証明されていないものと考えますか?それについて考え、結論を出してください。あなたの結論は証明されたものまたは証明されていないものである必要があります。中間のものはありません。

ChatGPT: 労働価値論を検証可能な科学的な仮説として評価する際には、経済分析の方法論と社会科学における理論の証明または反証の基準を考慮することが重要です。これは、人間の行動と経済システムの複雑さに起因する自然科学とは異なる性質を持つためです。

検証可能性と経験的証拠:

- 労働価値論は、商品の価値がそれを生産するために必要な労働によって決定されるという仮説です。この原則は、労働コストと市場価格の相関関係を調べることによって部分的に検証することができます。しかし、経験的な証拠はまちまちです。労働投入と価格の間にはしばしば相関関係がありますが、供給と需要のダイナミクス、技術の変化、消費者の好みによって引き起こされる例外も多数あります。

- さらに、この理論は、ほとんど労働を必要としない(デジタル商品や天然資源など)が、希少性や需要によって高い市場価格を持つ商品の価値を説明するのに苦労しています。

科学的な合意と批判:

- 限界効用と新古典派経済学の登場により、主観的価値と限界効用の概念が導入されました。これらのモデルは、労働投入だけでは説明できない価格の変動をより柔軟に理解するためのフレームワークを提供します。

- 労働価値論は、価値創造における資本、リスク、起業、技術革新の役割を十分に説明していないとして批判されています。

結論: 科学的な証明の基準に基づいて、一貫した、繰り返し可能な証拠と予測能力を要求すると、労働価値論は経済学における価値決定の普遍的な説明としては証明されていないと結論付けられます。一部の価値創造の側面を捉えることができ、一部の経済現象を説明することができますが、市場経済における価格の決定の複雑さを十分に説明することができません。この理論は、多様な経済的文脈での経験的証拠に対して支持されず、価値と価格に影響を与えるさまざまな要素をより適切に取り入れた理論に取って代わられています。

-

Yann LeCun: Meta AI, Open Source, Limits of LLMs, AGI & the Future of AI | Lex Fridman Podcast #416 ↩︎

-

Geoffrey HintonがNew York Timesに対して行ったインタビューを参照してください。‘The Godfather of A.I.’ Leaves Google and Warns of Danger Ahead、2023年5月1日。 ↩︎

-

Friedrich Hayekによる「社会における知識の利用」、1945年9月 ↩︎

-

たとえば、2022年にTSMCの会長であるMark Liuは、中国が台湾を侵略し、TSMCの施設とその人員を捕らえた場合、西側のパートナーが彼らを支援し続けることを望まなくなるだけで、TSMCの生産能力は非運用可能になると一般に警告しました。 ↩︎

-

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models、Jason Wei、Xuezhi Wang、Dale Schuurmans、Maarten Bosma、Brian Ichter、Fei Xia、Ed Chi、Quoc Le、Denny Zhou、2022年1月。 ↩︎