Нюансированный взгляд на зазубренный технологический рубеж Гарвардской школы бизнеса

Качество субъективно; стоимость — нет.

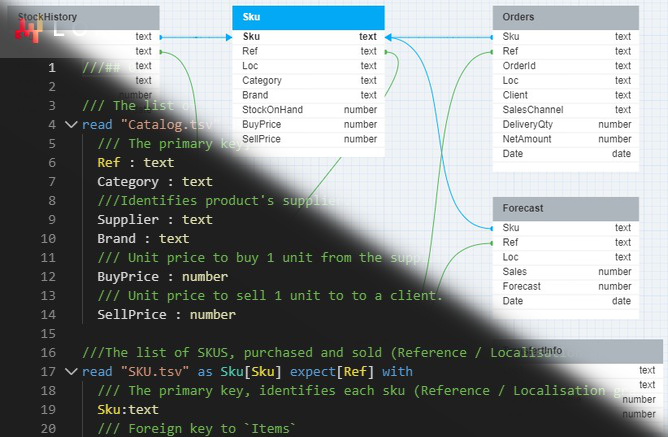

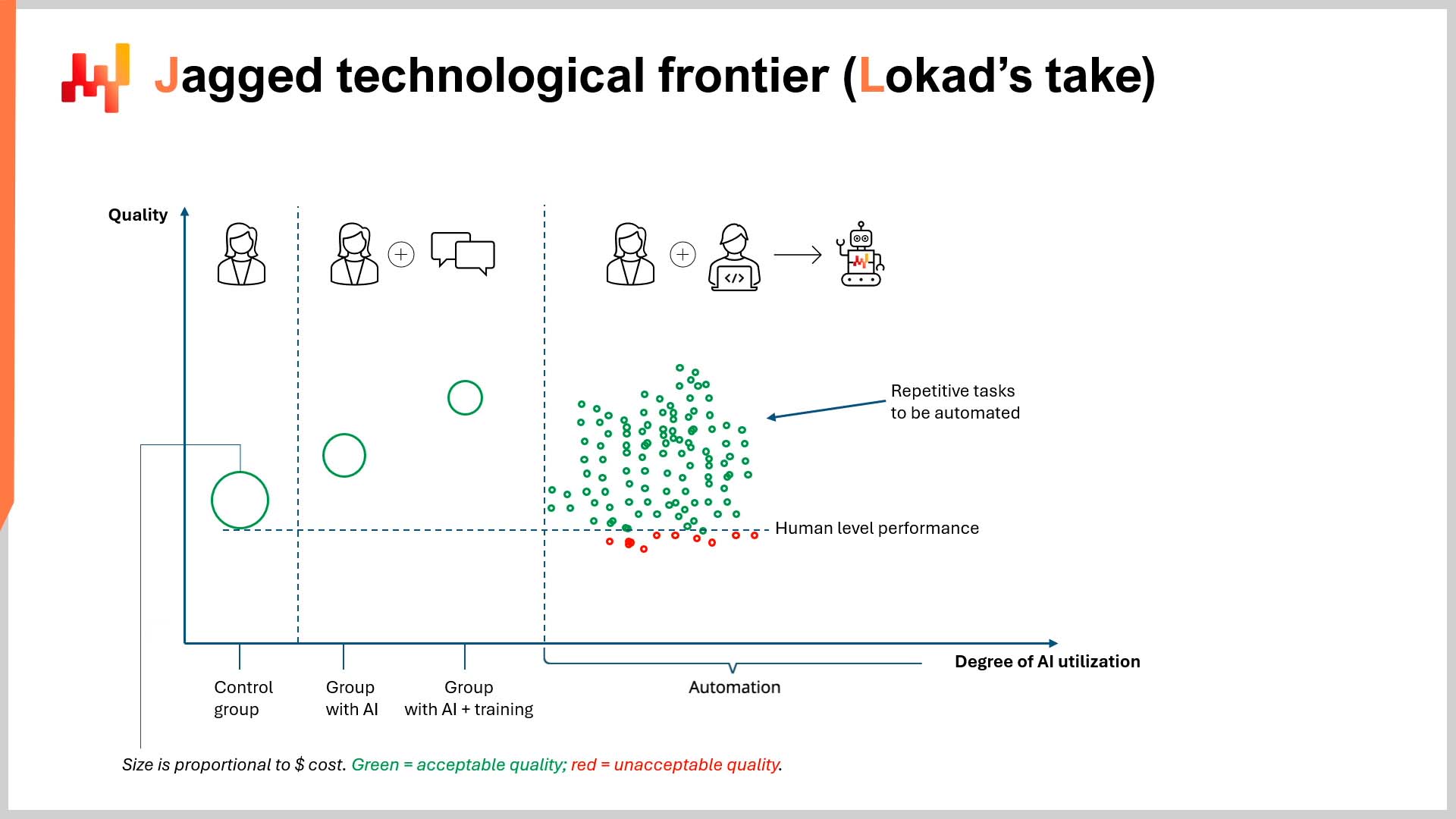

В недавнем эпизоде LokadTV, я предположил, что статья Гарвардской школы бизнеса (HBS), созданная в сотрудничестве с Boston Consulting Group (BCG), имеет серьезные недостатки и может быть опасной. Полное название статьи — Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality1. Кратко говоря, статья утверждала, что способности ИИ к выполнению сложных задач распределены неравномерно: он преуспевает в одних задачах и показывает слабые результаты в других (задачи “внутри” и “вне рубежа”, соответственно).

Контекст

По ту сторону этого “зазубренного технологического рубежа” (см. иллюстрацию на с. 27 статьи) человеческий опыт всё ещё превосходит ИИ (в данном случае, ChatGPT-4), особенно в задачах, объединяющих количественный и качественный анализ (то есть, задачи “вне рубежа”).

Это не должно удивлять тех, кто знаком с тем, для чего предназначены большие языковые модели (LLM), такие как ChatGPT (спойлер: не для математики). Кроме того, когда LLM рассматриваются как «база данных всего», они выдают правдоподобные, но иногда неточные ответы2. Однако статья всё же поднимает несколько интересных вопросов – хотя и случайно.

Надо отдать должное: статья написана очень понятно, чего часто не хватает в академической литературе. Однако можно высказать несколько замечаний относительно потенциального конфликта интересов3 и её выводов4, хотя основной интерес здесь представляет методология и подразумеваемая экономика исследования.

Критика методологии

Что касается методологии, этот вопрос уже был рассмотрен в видео, поэтому я буду краток. Исследовательская группа не изучала прирост производительности, вызванный автоматизацией. Вместо этого исследователи отобрали группы консультантов (то есть неспециалистов в области ИИ, компьютерных наук и/или инженерии) для использования ChatGPT-4. Единственным исключением была контрольная группа, работавшая, опираясь только на свой опыт. Этика оценки работы этих групп будет рассмотрена далее.

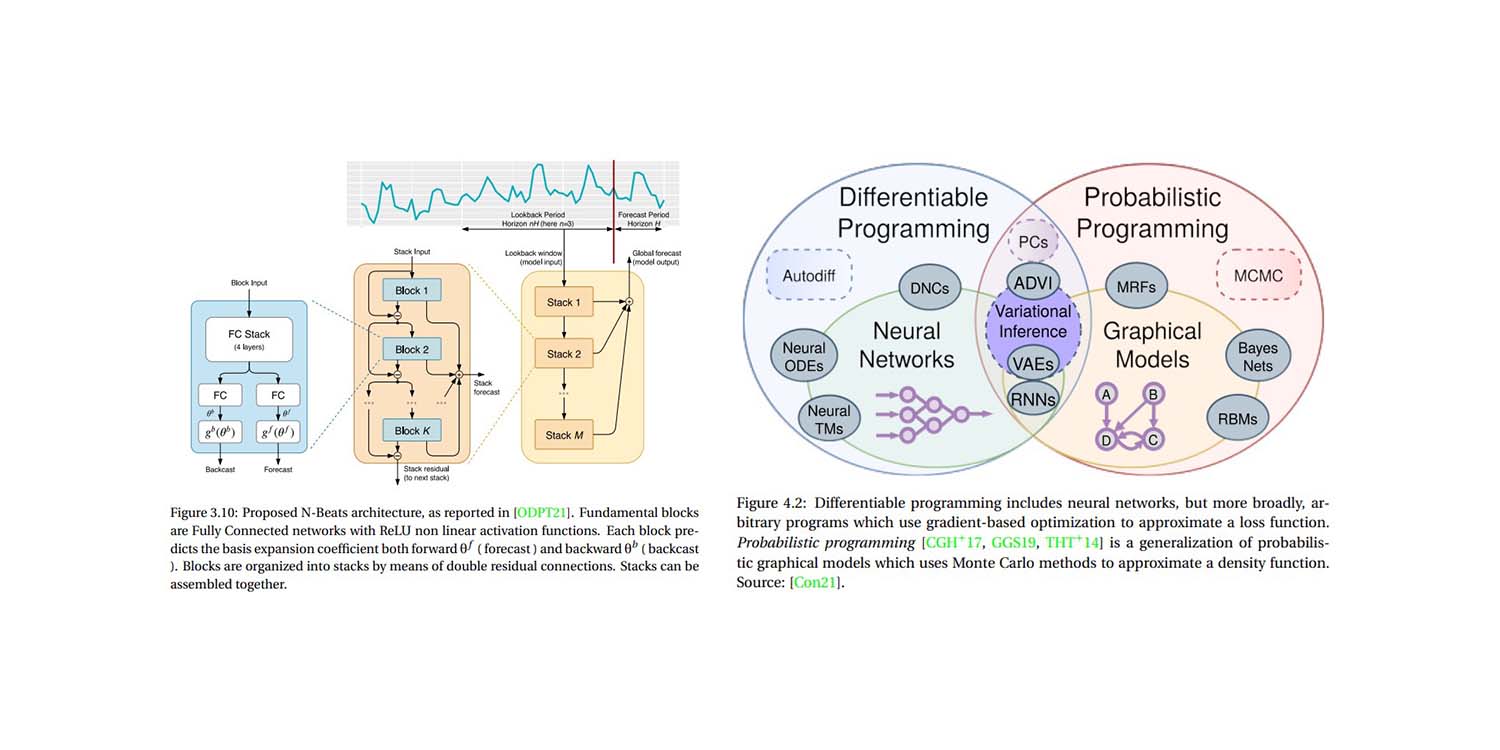

В эксперименте не участвовали внешние программисты или эксперты по ИИ. Ни одна команда разработчиков, владеющая такими техниками, как retrieval augmented generation (RAG), тонкая настройка для конкретной области или другими методами, использующими сильные стороны LLM — устойчивость к шуму и универсальное шаблонирование, не была задействована.

Этот впечатляющий робот не был запрограммирован на использование специализированных знаний, хранящихся в обширных внутренних базах данных BCG по прошлым консультационным проектам. Напротив, в эксперименте участвовали некоторые консультанты, имевшие подписку на ChatGPT-4.

Такое распределение, естественным образом, привело к разной степени качества результатов, особенно в задачах, требующих как количественного, так и качественного анализа. Иными словами, эксперимент был разработан, чтобы показать, насколько неудачно неспециалисты пытаются использовать сложную технологию в условиях нереалистично жестких ограничений.

Как я отметил в видео, игнорирование возможного прироста производительности (и экономии) за счёт автоматизации почти доходит до скандала. Особенно это актуально, когда публикация выходит от имени престижного образовательного учреждения. По моему мнению, выводы статьи придают студентам, собирающимся влезть в огромные долги для обучения в ведущей бизнес-школе, ложное чувство уверенности в завтрашнем дне. То же касается и тех, кто уже осмелился и влез в значительные долги, получив дипломы в областях, которые могут оказаться на грани полной автоматизации.

Критика с экономической точки зрения

Несмотря на значительную критику, на мой взгляд, подразумеваемая экономика статьи гораздо интереснее. Проще говоря, Гарвардская школа бизнеса оценила только $${quality}$$ результата, а не $${cost}$$ результата5.

Ни в одном случае (и, пожалуйста, проверьте факты) исследователи не измеряли затраты, связанные с результатами работы консультантов. Это не тривиальный вопрос. В статье слово «качество» упоминается 65 раз на 58 страницах (включая название статьи). Слово «стоимость» упоминается…2 раза…и только в самом последнем предложении статьи. Привожу это предложение для контекста:

«Подобно тому, как интернет и веб-браузеры кардинально снизили предельные затраты на обмен информацией, ИИ также может снижать затраты, связанные с человеческим мышлением и рассуждением, что может иметь широкие и преобразующие последствия.» (с. 19)

Даже когда Гарвардская Business School наконец признала концепцию финансовых затрат, это не было выражено в виде сниженных затрат на создание работы высокого качества без участия дорогостоящих выпускников бизнес-школы. Это может показаться очевидным, если учесть, что в названии статьи акцент делается на «производительность» и «качество», не говоря уже о том, что дорогая бизнес-школа вряд ли будет рекламировать свою потенциальную неизбежную бесполезность.

Тем не менее, я вежливо предполагаю, что измерение $${productivity}$$ и $${quality}$$ результата без надёжной финансовой перспективы практически бессмысленно, особенно в академической публикации от бизнес-школы. Это особенно вопиет, учитывая, что суть ИИ заключается в том, что он является великим уравнителем в вопросах финансовой мощи.

ИИ обеспечивает очень высокое качество результатов при очень низких затратах, особенно благодаря автоматизации. Это соотношение $${quality/cost}$$ превосходит таковое у человеческих работников на порядки6. Более того, оно открывает дверь для каждого, кто имеет подписку на ChatGPT и немного знаний в программировании. Это кардинально выравнивает условия игры в конкуренции между крупными игроками и мелкими участниками.

Вместо этого, на протяжении 58 страниц, Гарвардская Business School оценивает «качество» работы консультантов BCG отдельно. Как определялось это качество? «Человеческими оценщиками»… которые работают в BCG7. Отложив в сторону явные конфликты интересов, о которых уже упоминалось, стоит отметить ложную дихотомию, представленную в статье, и то, как она влияет на её подразумеваемую экономику. Эта ложная дихотомия выглядит примерно так:

«ИИ либо лучше, либо хуже человеческой экспертизы.»

Или, возможно, более благожелательная интерпретация такова:

«ИИ делает людей лучше или хуже в их работе.»

В любом случае, метрика, лежащая в основе ложной дихотомии статьи, — это «качество», которое измеряется субъективно и существует в академическом вакууме, независимом от других ограничений, таких как время, эффективность и затраты. Более сложная экономическая точка зрения могла бы звучать так:

Каково соотношение $${quality/cost}$$ человеческого результата по сравнению с соотношением $${quality/cost}$$ при автоматизации с использованием ИИ?

Опытные читатели поймут, что это аргумент в пользу ROI (возврата инвестиций). Ваше личное соотношение $${quality/cost}$$ можно определить, ответив на следующие вопросы:

- Насколько хорош был результат для данной задачи?

- Сколько это стоило?

- Стоило ли качество своих затрат?

- Сколько бы стоило улучшение качества и было ли бы оно финансово оправданным?

Гарвардская школа бизнеса тратит 58 страниц на обсуждение первого вопроса и никогда не выходит за его рамки. Это, надо сказать, странная точка зрения для бизнес-школы. Фактически, можно провести интересную параллель с цепочками поставок. Слепое стремление HBS к качеству удивительно похоже на изолированное стремление к точности прогнозирования (то есть попытку улучшить точность прогнозирования, не учитывая связанный с этим ROI)8.

Возможные последствия

С экономической точки зрения, «зазубренный технологический рубеж» — это не просто определение, в каких задачах большие языковые модели превосходят людей. Скорее, это определение вашего идеального соотношения $${quality/cost}$$ при использовании LLM и принятие умных, финансово обоснованных решений. Для опытных бизнесменов это будет означать автоматизацию, а не ручное вмешательство (или, по крайней мере, его минимальное количество).

Для этих бизнесменов, возможно, приемлем уровень качества, сравнимый с тем, что может обеспечить человеческий эксперт, если он при этом экономически выгоден. «Приемлемость» может означать тот же уровень, или немного лучше/хуже, чем то, что может дать эксперт. Другими словами, оплата в размере 0,07% от стоимости консультанта за более чем 90% качества может представлять собой очень выгодный компромисс, несмотря на то, что результат не будет точно таким же как у дорогостоящего эксперта9.

Числовые показатели будут различаться для каждого клиента, но что очевидно, так это то, что существует критическая точка, после которой «качество» перестаёт быть самоцелью и должно оцениваться с точки зрения его финансовой стоимости. Это, по крайней мере, касается компаний, стремящихся оставаться на плаву.

Возможно, вы считаете, что наём команды выпускников Гарвардской школы бизнеса или консультантов из BCG представляет собой идеальное соотношение $${quality/cost}$$, независимо от более дешёвых вариантов, таких как автоматизация с использованием ИИ. Если это так, желаю вам долгой и успешной жизни10.

Или, возможно, вы думаете так же, как и я: качество субъективно; стоимость — нет. Моя субъективная оценка качества — особенно в бизнесе — соотносится с его затратами. Подобно уровню сервиса первого рода (вероятность обслуживания)-определение (или точности прогнозирования) в цепочке поставок, дополнительный 1%-й прирост качества (или точности) вряд ли стоит 1000%-го увеличения затрат. Таким образом, когда речь идёт об ИИ в бизнесе, необходимо учитывать экономический компромисс между качеством и стоимостью. Крайне важно не упускать это из виду, как, судя по всему, сделала Гарвардская школа бизнеса.

В заключение, если вы ждёте, когда ИИ превзойдёт человеческое качество, прежде чем приступить к его использованию, так тому и быть, но мы остальные не собираемся ждать вместе с вами.

-

Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality, Dell’Acqua, Fabrizio и McFowland, Edward и Mollick, Ethan R. и Lifshitz-Assaf, Hila и Kellogg, Katherine и Rajendran, Saran и Krayer, Lisa и Candelon, François и Lakhani, Karim R., сентябрь 2023 ↩︎

-

В AI Pilots for Supply Chain, Joannes Vermorel сравнил этот подход, напоминающий «швейцарский армейский нож», с просьбой к очень умному профессору вспомнить детали изученной ранее статьи. С первого взгляда профессор может вспомнить суть, но не обязательно вспомнит все нюансы, если вы не зададите правильные уточняющие вопросы, чтобы пробудить его память. ↩︎

-

BCG с удовольствием рекламирует свои связи со многими ведущими бизнес-школами Америки. Не стесняйтесь изучить присутствие BCG на основных кампусах США. Либо вы можете ознакомиться с этим полезным скачиваемым Excel-файлом, который упрощает данные. В таблице указано, сколько консультантов BCG в настоящее время изучают MBA в Гарвардской школе бизнеса (74). Читатели могут сделать свои выводы. ↩︎

-

Сотрудничество между ведущей бизнес-школой и крупной консалтинговой фирмой продемонстрировало, что дорогостоящие (и дорого обученные) консультанты являются ценными активами… Простите, если я не был в восторге. Если вы в шоке, то я вежливо перенаправляю вас к скачиваемому Excel-файлу, упомянутому в предыдущей сноске. ↩︎

-

И, безусловно, не измеряла качество, разделённое на стоимость результата, как я рассмотрю далее. ↩︎

-

Трудно привести точные цифры по этому вопросу, но давайте предположим, что годовая зарплата консультанта из любой ведущей фирмы превышает 200 000 долларов (США). Эта цифра разумна, основываясь на беглом интернет-исследовании. Примерные расчёты ChatGPT показывают, что год консультационной работы будет стоить около 145 долларов (с точки зрения затрат на обработку ChatGPT). Очевидно, это не слишком научно, но даже если цифра окажется с погрешностью в три порядка величины, это всё ещё почти на 30% дешевле годовой зарплаты одного консультанта. Ознакомьтесь с рассуждениями ChatGPT здесь: https://chat.openai.com/share/d9beb4b9-2dd3-4ac2-9e95-2cd415c76431. (Благодарность Алексею Тихонову за предоставление логов переписки.) Следует отметить, что необходимо также учитывать затраты на создание самого шаблонного робота, что может быть не дешевым, но даже в сочетании с 145 долларами за ChatGPT, всё ещё будет дешевле, чем годовая зарплата одного консультанта и будет экспоненциально более продуктивным при масштабном развертывании. ↩︎

-

См. страницы 9 и 15 статьи, если у вас возникли сомнения относительно прочитанного. Если это, возможно, указывает на конфликт интересов, я вежливо перенаправляю ваше внимание на скачиваемый Excel-файл в сноске 3. ↩︎

-

Lokad уже подробно рассмотрел значение точности прогнозирования, поэтому приведу очень краткое напоминание: сосредоточьтесь на финансовом воздействии ваших решений в цепочке поставок, а не на измерении KPI (таких как точность) независимо от их финансовых последствий (то есть ROI). Другими словами, если прогноз спроса на 10% точнее, но вы зарабатываете на 20% меньше, можно считать, что повышение точности не стоило возросших затрат. ↩︎

-

Примерно год назад компания Lokad начала переводить свой веб-сайт на шесть языков с помощью LLM. До этого мы пользовались услугами профессиональных переводчиков. Текущие затраты на поддержание переводов составляли около 15 000–30 000 долларов США в год для каждого языка. Хотя мы полностью готовы признать, что профессиональные переводчики обеспечивали (относительно) более высокое качество, соотношение $${quality/cost}$$ при использовании LLM гораздо лучше. Другими словами, качество, которое мы можем получить с помощью LLM, более чем приемлемо и значительно дешевле, чем наше предыдущее соглашение. Трудно точно оценить сбережения, но компетентный перевод каждого нашего ресурса (как уже созданного, так и будущего) на шесть языков за несколько минут обходится экспоненциально дешевле и экономит больше времени по сравнению с предыдущей системой. Если вы носитель французского, немецкого, испанского, русского, итальянского или японского языков, смело переводите это эссе, расположенное в правом верхнем углу страницы, и проверьте качество самим. ↩︎

-

По крайней мере, до тех пор, пока OpenAI не выпустит ChatGPT-5. ↩︎