Überanpassung: wenn das Genauigkeitsmaß schiefgeht

Wie bereits erwähnt, besteht der ganze Sinn der Prognose darin, Modelle zu erstellen, die bei den Daten, die Sie nicht haben, genau sind. Dennoch scheint dies auf den ersten Blick wie eine weitere verrückte Idee eines Mathematikers: sowohl seltsam als auch völlig unpraktisch.

Aber nach unserer Erfahrung ist das Messen der wirklichen Prognosegenauigkeit ein echtes Geschäftsproblem. Fehler hier kosten Geld. Tatsächlich, je größer das Unternehmen, desto größer die Kosten.

Haben Sie noch keine Ahnung vom tatsächlichen Prognosefehler?

Schauen Sie sich unseren neuesten 9-minütigen Slidecast an (Skripte sind unten eingefügt).

Slidecast-Skripte:

Überanpassung: Ihre Prognosen sind möglicherweise nicht so gut, wie das Maß angibt

Die Prognosegenauigkeit ist in vielen Branchen – wie Einzelhandel, Industrie oder Dienstleistungen – von entscheidender Bedeutung. Wenn Sie die Kundennachfrage zu hoch prognostizieren, explodieren Ihre Kosten, weil Sie zu viele Mitarbeiter und zu viel Inventar haben werden. Aber wenn Sie die Kundennachfrage zu niedrig prognostizieren, werden Ihre Kunden verärgert, weil sie Ihr Produkt nicht kaufen können oder zu lange auf eine Bedienung warten müssen.

In diesem Slidecast werde ich ein wenig bekanntes Problem in der Prognose vorstellen, das Überanpassung genannt wird.

Dieses Problem ist aus zwei Gründen wenig bekannt. Erstens, weil es ein subtiler Sachverhalt ist – in vielerlei Hinsicht nicht offensichtlich und kontraintuitiv. Zweitens ist es ein Problem, das Mathematiker seit dem 19. Jahrhundert beschäftigt. Erst Ende der Neunzigerjahre, vor etwas mehr als 10 Jahren, begann die wissenschaftliche Gemeinschaft, dieses Problem sowohl auf theoretischer als auch auf praktischer Ebene wirklich zu verstehen.

Bevor wir weitermachen, lassen Sie mich zur Schlussfolgerung kommen. Überanpassung hat einen sehr starken Einfluss auf Ihre Prognosen. Überanpassung kann Sie glauben machen, dass Sie einen Prognosefehler von 10% haben, während Ihr tatsächlicher Prognosefehler 20% beträgt – und das wäre nicht einmal der schlimmste Fall.

Überanpassung ist ein sehr reales Geschäftsproblem. Überanpassung kostet Geld.

Darüber hinaus gibt es keinen Ausweg aus der Überanpassung. Moderne statistische Theorien basieren auf genau diesem Konzept. Überanpassung spielt eine zentrale Rolle in diesen Theorien – egal, welchen Ansatz man in der Statistik verfolgt, sie ist hier, um zu bleiben.

Das Kernproblem besteht darin, zu definieren, was Prognosegenauigkeit eigentlich bedeutet.

Intuitiv besteht der einfachste Weg, die Prognosegenauigkeit zu messen, darin, eine Vorhersage zu machen und auf das Eintreten des prognostizierten Ereignisses zu warten, um die Vorhersage mit dem entsprechenden Ergebnis vergleichen zu können.

Doch diese Methode hat einen großen Nachteil: Sie gibt nur Auskunft über die Genauigkeit vergangener Vorhersagen. Aus geschäftlicher Sicht ist es wenig relevant zu wissen, dass frühere Prognosen gut oder schlecht waren, da Sie sie ohnehin nicht ändern können. Was wirklich zählt, ist, sicherzustellen, dass zukünftige Vorhersagen tatsächlich genau sind.

Dann gibt es noch ein weiteres Problem: Sofern die Methode zur Erstellung der Vorhersagen nicht strikt identisch von einer Vorhersage zur nächsten ist, gibt es keinen Grund zu der Annahme, dass vergangene Genauigkeit als zuverlässiger Indikator für zukünftige Genauigkeit herangezogen werden kann.

Seit dem 18. Jahrhundert haben Mathematiker das Konzept des statistischen Modells eingeführt. Der wesentliche Aspekt statistischer Modelle besteht – entgegen der landläufigen Meinung – nicht darin, gute oder schlechte Vorhersagen zu liefern, sondern darin, reproduzierbare Vorhersagen zu ermöglichen.

Mit einem statistischen Modell erhalten Sie einen Prozess, der die Erstellung von Vorhersagen automatisiert. Es garantiert zwar nicht, dass die Vorhersagen gut sind, aber falls sie schlecht ausfallen, können Sie das Modell weiter analysieren.

Betrachten wir die folgende Beispiel-Zeitreihe. Wir werden das Überanpassungsproblem anhand aufeinanderfolgender statistischer Modelle veranschaulichen.

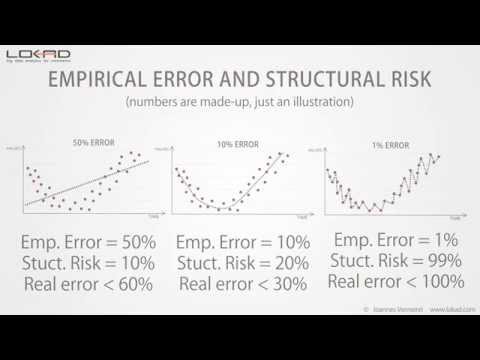

Beginnen wir mit einem einfachen linearen Modell. Wie Sie sehen können, passt die Linie nicht wirklich gut zu den Punkten der Zeitreihe. Infolgedessen haben wir einen großen Fehler von über 50%. Dieses Modell passt die Daten nicht richtig an.

Anschließend können wir die Komplexität des Modells erhöhen. Wir haben nun ein Modell, das ungefähr dem lokalen Durchschnitt der Zeitreihe folgt. Dieses neue Modell sieht wesentlich besser aus als das vorherige, und tatsächlich wurde der Fehler um den Faktor 5 reduziert, sodass er nun 10% erreicht.

Hier haben wir ein gutes Modell, aber können wir den Fehler noch weiter reduzieren? Die Antwort ist einfach: Ja, wir können ein Modell erstellen, das einen Fehler von weniger als 1% erzielt.

Wie Sie sehen, ist es ziemlich einfach; wir müssen nur ein Modell entwerfen, das nahezu alle Punkte der Zeitreihe durchläuft.

Aber können wir diesem Modell wirklich vertrauen, dass es bei zukünftigen Vorhersagen 1% Genauigkeit erreicht? Offensichtlich nicht! Dieses Modell optimiert lediglich winzige Schwankungen der Vergangenheit, die nichts anderes als zufällige Variationen sind. Intuitiv können wir echte Zufälligkeit nicht vorhersagen; wir können nur Muster wie Trends, Saisonalität etc. vorhersagen.

Vergleichen wir nun die letzten beiden Modelle, ergibt sich ein offensichtliches Problem: Nach unserem Fehlermaßstab ist das Modell rechts – das mit 1% Fehler – zehnmal besser als das Modell links.

Obwohl es offensichtlich ist, dass das beste Modell das links ist. Dieses Modell glättet die zufälligen Schwankungen der Zeitreihe.

Daher stimmt etwas nicht mit der Art und Weise, wie wir den Fehler messen. Dieser Fehler, wie in den vorherigen Grafiken veranschaulicht, ist als empirischer Fehler bekannt. Es ist der Fehler, den Sie durch Messungen an Ihren historischen Daten erhalten.

Doch woran wir tatsächlich interessiert sind, wird als der reale Fehler bezeichnet. Der reale Fehler wird definiert als der Fehler Ihres Prognosemodells bei den Daten, die Sie nicht haben, also zukünftige Daten.

Obwohl diese Definition wie ein völliges Paradoxon erscheint: Wie können Sie irgendetwas messen, wenn Sie gerade die Daten nicht haben!

Seit dem 19. Jahrhundert befassen sich Statistiker mit diesem Problem mittels eines Ansatzes, der als Bias-Varianz-Abwägung bekannt ist.

Wenn wir die drei Modelle betrachten, können wir sagen, dass das lineare Modell eine hohe Verzerrung aufweist: Unabhängig davon, welches lineare Modell wir wählen, wird es niemals wirklich dazu in der Lage sein, die Daten genau anzupassen, es sei denn, die Daten selbst sind linear verteilt; aber in den meisten Fällen wird das lineare Modell die Datenverteilung nur annähern.

Anschließend weist das lineare Modell eine geringe Varianz auf: Intuitiv wird das Hinzufügen oder Entfernen eines einzelnen Punktes in der Zeitreihe das resultierende Modell nicht wesentlich beeinflussen. Dieses Modell ist ziemlich stabil.

Am anderen Ende hat das Modell rechts eine sehr geringe Verzerrung: Es passt – oder besser überanpasst – tatsächlich die meisten Punkte der Zeitreihe. Allerdings ist die Varianz sehr hoch: Das Hinzufügen oder Entfernen eines einzelnen Punktes führt wahrscheinlich zu großen Änderungen in diesem Modell. Es fehlt jegliche Stabilität.

In der Mitte haben wir ein Modell, das sowohl Verzerrung als auch Varianz ausbalanciert; und genau das scheint der richtige Weg zu sein.

Doch das Hauptproblem beim Bias-Varianz-Ansatz ist, dass wir immer noch keine Ahnung davon haben, was tatsächlich mit dem realen Fehler passiert, das heißt, dem Fehler bei den Daten, die wir nicht haben.

Dieser Kompromiss ist häufig mehr eine Heuristik als ein echtes statistisches Kriterium.

Seit Ende der Neunzigerjahre hat das Gebiet des Statistical Learning, eine umfassendere Theorie, die statistische Prognosen umfasst, sowohl auf theoretischer als auch auf praktischer Ebene einen bedeutenden Durchbruch erzielt.

Diese Theorie ist komplex, aber eine einfache Gleichung gibt uns wesentliche Einblicke in die Ergebnisse. Sie besagt, dass der reale Fehler durch die Summe aus dem empirischen Fehler und einem weiteren Wert, dem strukturellen Risiko, nach oben beschränkt ist.

Wie bereits gesehen, ist der empirische Fehler lediglich der an den historischen Daten gemessene Fehler.

Das strukturelle Risiko ist ein theoretisches Kriterium, das für bestimmte Modellklassen explizit berechnet und für die meisten anderen Klassen geschätzt werden kann.

Zurück zu unserem anfänglichen Beispiel: Wir können erkennen, dass das strukturelle Risiko mit der Komplexität des Modells zunimmt.

Wenn wir diese strukturellen Risiken quantifizieren, erhalten wir den folgenden Ausblick.

Wir kennen den realen Fehler zwar immer noch nicht – dieser Wert kann ohnehin nicht direkt gemessen werden – aber wir sehen, dass das Modell in der Mitte die niedrigste obere Schranke für den realen Fehler aufweist.

Die Theorie des Statistical Learning liefert uns nicht den Wert des realen Fehlers, sondern vielmehr eine obere Schranke; und der entscheidende Punkt ist, das Modell auszuwählen, das die niedrigste obere Schranke erreicht.

Diese obere Schranke fungiert als Maximalwert für den realen Fehler.

Im Vergleich zur Bias-Varianz-Abwägung sehen wir, dass uns die Theorie des Statistical Learning eine quantitative Schätzung des realen Fehlers liefert.

Das strukturelle Risiko ist in der Praxis schwer zu schätzen. Trotzdem ist es derzeit immer noch die beste bekannte Lösung, um Überanpassung zu vermeiden.

Wir haben bereits gesehen, dass ein offensichtlicher Weg, in Überanpassungsprobleme zu geraten, darin bestand, die Modellkomplexität zu erhöhen.

Aber es gibt auch einen anderen, subtileren Weg, um in Überanpassungsprobleme zu geraten: Dies kann passieren, wenn die Komplexität der Daten erhöht wird.

Das Hinzufügen zusätzlicher Punkte zu den Daten verringert typischerweise Überanpassungsprobleme, aber wenn Sie beginnen, den Daten zusätzliche Dimensionen hinzuzufügen, ist es wahrscheinlich, dass es zu Überanpassungsproblemen kommt, selbst wenn die Modelle selbst unverändert bleiben.

Nach unserer Erfahrung bei Lokad begegnen Organisationen, die Jahr für Jahr ihre eigenen Prognosemodelle mit ständig zunehmenden Dateneingaben verfeinern, diese Situation häufig, ohne dabei explizit das strukturelle Risiko in ihren Modellen zu berücksichtigen.

In hohen Dimensionen sind selbst lineare Modelle Überanpassungsproblemen ausgesetzt.

Damit endet diese kurze Präsentation über Überanpassung. Wenn Sie sich an eines erinnern müssen, dann daran, dass ohne Berücksichtigung des strukturellen Risikos Ihre Messung des Prognosefehlers höchst irreführend sein kann – und je größer Ihr Unternehmen, desto mehr Geld wird es Sie kosten.

Vielen Dank für Ihr Interesse. Wir beantworten gerne Ihre Fragen in unseren Foren.

Leserkommentare (9)

Interessante Diashow

Mark (vor 3 Jahren)

Wow, was für ein großartiges Video, danke, dass Sie mir geholfen haben, Überanpassung zu verstehen.

Melford McRae (vor 4 Jahren)

Übrigens, ich habe versucht, die Diashow in mehreren Browsern anzusehen, und es hat sich nicht laden lassen. Es scheint nie zu laden. Kann jemand bei Lokad sich das anschauen und herausfinden, was das Problem sein könnte?

Shaun Snapp (vor 4 Jahren)

Ich habe gerade ein aktualisiertes Video gepostet, das funktioniert.

Joannes Vermorel (vor 4 Jahren)

Es scheint, dass SlideShare ihre Sachen über die Jahre nicht gepflegt hat :-( Hier sind die Audiodatei https://media.lokad.com/videos/2009-04-21-overfitting/overfitting.mp3 und die PowerPoint-Datei https://media.lokad.com/videos/2009-04-21-overfitting/overfitting.pptx. Ich werde diese beiden zu einem YouTube-Video zusammenführen.

Joannes Vermorel (vor 4 Jahren)

Dies ist ein ziemlich kniffliges Problem. Es gibt keinen anderen Weg, ein Prognosemodell zu messen, als es anhand seiner historischen Leistung zu prüfen, doch es besteht die Tendenz, zu überanpassen, um „die beste Genauigkeit“ zu erzielen. All dies wäre ein größeres Problem, wenn ein höherer Prozentsatz von Unternehmen tatsächlich ihr Best-Fit-Verfahren in den von ihnen gekauften Prognosesystemen verwendet oder die Modelle wirklich optimiert hätte. Ich wäre an einer Diskussion darüber interessiert, wie man Überanpassung verhindert, wenn man ein Best-Fit-Verfahren verwendet.

Shaun Snapp (vor 4 Jahren)

Ich habe eine Folgeantwort unter https://blog.lokad.com/journal/2014/5/20/how-to-mitigate-overfitting-when-forecasting-demand gepostet. Hoffentlich hilft es!

Joannes Vermorel (vor 4 Jahren)

Danke für die Diashow. Sie hat mir geholfen, Überanpassung zu verstehen, ohne auf die mathematischen Details einzugehen.

Shyam Prasad Murarka (vor 8 Jahren)

Vielen Dank für die Diashow.

Abhishek (vor 8 Jahren)