Surapprentissage: quand la mesure de précision se trompe

Comme nous l’avons déjà dit, le but même de la prévision est de construire des modèles qui sont précis sur les données que vous n’avez pas. Pourtant, à première vue, cela ressemble à une autre idée folle de mathématicien : à la fois bizarre et totalement impraticable.

Mais selon notre expérience, mesurer la vraie précision des prévisions est un véritable problème pour les entreprises. Échouer à cela coûte de l’argent. En fait, plus l’entreprise est grande, plus le coût est élevé.

Toujours sans idée de l’erreur réelle de prévision ?

Découvrez notre dernier slidecast de 9min (les scripts sont collés ci-dessous).

Scripts du slidecast :

Surapprentissage : vos prévisions pourraient ne pas être aussi bonnes que ce que la mesure vous indique

La précision des prévisions est cruciale pour de nombreux secteurs tels que le commerce de détail, la fabrication ou les services. Si vous surestimez la demande de vos clients, vos coûts explosent parce que vous aurez trop de personnel, trop de stocks. Mais si vous sous-estimez la demande de vos clients, vos clients se fâchent car ils ne peuvent pas acheter votre produit ou parce qu’ils doivent attendre trop longtemps pour être servis.

Dans ce slidecast, je vais vous présenter un problème peu connu dans la prévision appelé surapprentissage.

Ce problème est peu connu pour deux raisons. Premièrement, c’est un problème subtil – non évident et contre-intuitif à bien des égards. Deuxièmement, c’est un problème qui intrigue les mathématiciens depuis le 19e siècle. Ce n’est qu’à la fin des années 90, il y a un peu plus de 10 ans, que la communauté scientifique a commencé à vraiment comprendre ce problème, tant au niveau théorique que pratique.

Avant d’aller plus loin, laissez-moi aller directement à la conclusion. Le surapprentissage a un impact très fort sur vos prévisions. Le surapprentissage peut vous faire croire que votre erreur de prévision est de 10% alors que votre erreur réelle de prévision est de 20%, et ce ne serait pas la pire situation.

Le surapprentissage est un véritable problème pour les entreprises. Le surapprentissage coûte de l’argent.

De plus, il n’existe aucune solution miracle pour contourner le surapprentissage. Les théories statistiques modernes sont construites sur ce concept même. Le surapprentissage joue un rôle central dans ces théories, quelle que soit l’approche adoptée en statistiques, le surapprentissage est là pour rester.

Le problème clé est de définir ce que signifie réellement la précision des prévisions.

Intuitivement, la façon la plus simple de mesurer la précision des prévisions consiste à émettre une prévision et attendre que l’événement prédit se réalise, afin que nous puissions comparer la prévision avec le résultat correspondant.

Cependant, cette méthode présente un inconvénient majeur : elle ne vous renseigne que sur la précision des prévisions passées. D’un point de vue commercial, il importe peu de savoir si les prévisions passées étaient bonnes ou mauvaises, puisque vous ne pouvez de toute façon pas les modifier. Ce qui compte vraiment, c’est de s’assurer que les prévisions à venir sont réellement précises.

Ensuite, il y a un autre problème : à moins que la méthode utilisée pour produire les prévisions ne soit strictement identique d’une prévision à l’autre, il n’y a aucune raison de croire que la précision passée puisse servir d’indicateur fiable pour la précision future.

Depuis le 18e siècle, les mathématiciens ont introduit la notion de modèle statistique. L’aspect primordial des modèles statistiques n’est pas, contrairement à la croyance populaire, de fournir des prévisions bonnes ou mauvaises, mais de fournir des prévisions reproductibles.

Avec un modèle statistique, vous obtenez un processus qui automatise la production de prévisions. Il ne garantit pas que les prévisions seront bonnes, mais au moins, si elles sont médiocres, vous pouvez analyser le modèle plus en profondeur.

Considérons la suivante séries temporelles. Nous illustrerons le problème du surapprentissage en considérant des modèles statistiques successifs.

Commençons par un modèle linéaire simple. Comme vous pouvez le constater, la ligne ne correspond pas vraiment aux points des séries temporelles. Par conséquent, nous avons une erreur importante, de plus de 50 %. Ce modèle ne correspond vraiment pas aux données.

Ensuite, nous pouvons augmenter la complexité du modèle. Nous avons désormais un modèle qui suit approximativement ce qui ressemble à la moyenne locale des séries temporelles. Ce nouveau modèle semble bien meilleur que le précédent, et en effet, l’erreur a été divisée par 5, atteignant désormais 10 %.

Nous avons ici un bon modèle, mais pouvons-nous encore réduire l’erreur ? Eh bien, la réponse est simple : oui, nous pouvons produire un modèle qui atteint une erreur de moins de 1 %.

Comme vous pouvez le constater, c’est assez facile ; il suffit de concevoir un modèle qui passe par presque tous les points des séries temporelles.

Mais pouvons-nous vraiment faire confiance à ce modèle pour qu’il soit précis à 1 % sur les prévisions futures ? Évidemment, nous ne pouvons pas ! Ce modèle se contente d’optimiser à outrance de minuscules fluctuations du passé qui ne sont que des variations aléatoires. Intuitivement, nous ne pouvons pas prévoir le vrai hasard ; nous ne pouvons prévoir que des motifs tels que la tendance, la saisonnalité, etc.

Maintenant, si nous comparons les deux derniers modèles, nous avons un problème évident : selon notre mesure d’erreur, le modèle de droite - celui avec une erreur de 1 % - est dix fois meilleur que le modèle de gauche.

Bien qu’il soit évident que le meilleur modèle soit celui de gauche. Ce modèle lisse les fluctuations aléatoires des séries temporelles.

Ainsi, il y a quelque chose qui cloche dans la manière dont nous mesurons l’erreur. Cette erreur, comme illustré dans les graphiques précédents, est connue sous le nom d’erreur empirique. C’est l’erreur que l’on obtient en mesurant sur vos données historiques.

Pourtant, ce qui nous intéresse réellement est connu sous le nom d’erreur réelle. L’erreur réelle est définie comme l’erreur de votre modèle de prévision sur les données que vous ne possédez pas, c’est-à-dire : les données futures.

Bien que cette définition semble être un paradoxe complet : comment pouvez-vous mesurer quoi que ce soit si, précisément, vous n’avez pas les données !

Depuis le 19e siècle, les statisticiens abordent ce problème à travers une approche connue sous le nom de compromis biais-variance.

Si nous regardons les trois modèles que nous avons, nous pouvons dire que le modèle linéaire présente un fort biais : peu importe le modèle linéaire que nous choisissons, il ne parviendra jamais à vraiment s’ajuster aux données, à moins, bien sûr, que les données elles-mêmes ne soient distribuées linéairement ; mais dans la plupart des situations, le modèle linéaire se contentera d’approcher la distribution des données.

Ensuite, le modèle linéaire présente une faible variance : intuitivement, ajouter ou retirer un point dans les séries temporelles n’affectera pas beaucoup le modèle résultant. Ce modèle est plutôt stable.

À l’autre extrême, le modèle de droite présente un biais très faible : il s’adapte, voire suradapte, à la plupart des points des séries temporelles. Pourtant, la variance est très élevée : ajouter ou retirer un seul point est susceptible de provoquer des changements majeurs dans ce modèle. Il n’y a aucune stabilité.

Au centre, nous avons un modèle qui équilibre à la fois le biais et la variance ; et c’est exactement la voie à suivre.

Cependant, le principal problème de l’approche biais-variance est que nous n’avons toujours aucune idée de ce qui se passe réellement avec l’erreur réelle, c’est-à-dire l’erreur sur les données que nous ne possédons pas.

Ce compromis est fréquemment davantage une heuristique qu’un véritable critère statistique.

Depuis la fin des années 90, le domaine de l’apprentissage statistique, une théorie plus large qui englobe la prévision statistique, a fait une avancée significative tant au niveau théorique que pratique.

Cette théorie est complexe, mais une équation simple nous fournit des éclaircissements majeurs sur les résultats. Cette théorie nous indique que l’erreur réelle est majorée par la somme de l’erreur empirique et d’une autre valeur appelée le risque structurel.

Comme nous l’avons vu précédemment, l’erreur empirique n’est que l’erreur mesurée sur les données historiques.

Le risque structurel est un critère théorique qui peut être calculé explicitement pour certaines classes de modèles, et estimé pour la plupart des autres classes.

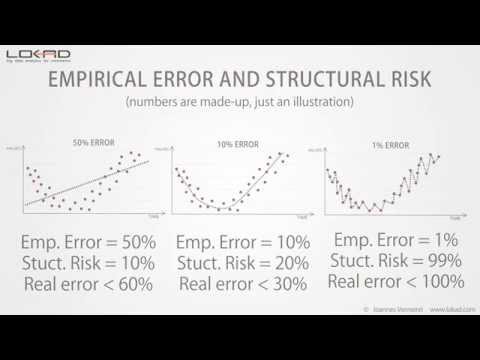

Si nous revenons à notre exemple initial, nous pouvons constater que le risque structurel augmente avec la complexité du modèle.

Maintenant, si nous quantifions ces risques structurels, cela nous donne l’aperçu suivant.

Nous ne connaissons toujours pas l’erreur réelle - cette valeur ne pouvant de toute façon être mesurée directement - mais nous voyons que le modèle central présente la borne supérieure la plus basse sur l’erreur réelle.

La théorie de l’apprentissage statistique ne nous donne pas la valeur de l’erreur réelle, mais plutôt une borne supérieure ; et l’essentiel est de choisir le modèle qui atteint la borne supérieure la plus basse.

Cette borne supérieure agit comme une valeur maximale pour l’erreur réelle.

Comparée au compromis biais-variance, nous voyons que la théorie de l’apprentissage statistique nous fournit une estimation quantitative de l’erreur réelle.

Le risque structurel est difficile à estimer dans la pratique. Pourtant, à ce jour, c’est encore la meilleure solution connue pour éviter le surapprentissage.

Nous avons vu précédemment qu’une manière évidente de se retrouver avec des problèmes de surapprentissage était d’augmenter la complexité du modèle.

Mais il existe aussi une autre manière, plus subtile, de se retrouver avec des problèmes de surapprentissage : cela peut se produire en augmentant la complexité des données.

Ajouter des points supplémentaires aux données réduit généralement les problèmes de surapprentissage, mais si vous commencez à ajouter des dimensions supplémentaires aux données, alors vous risquez fort de vous retrouver avec des problèmes de surapprentissage même si les modèles eux-mêmes restent inchangés.

D’après notre expérience chez Lokad, cette situation est fréquemment rencontrée par les organisations qui affinent, année après année, leurs propres modèles de prévision avec des apports de données toujours croissants, sans prendre explicitement en compte le risque structurel qui se cache au sein de leurs modèles.

Dans les hautes dimensions, même les modèles linéaires sont sujets aux problèmes de surapprentissage.

Cela conclut cette brève présentation sur le surapprentissage. Si vous devez retenir une chose, c’est que sans prendre en compte le risque structurel, votre mesure de l’erreur de prévision est susceptible d’être très trompeuse ; et plus votre entreprise est grande, plus cela vous coûtera cher.

Merci beaucoup pour votre intérêt. Nous serons heureux de répondre à vos questions sur nos forums.

Commentaires des lecteurs (9)

Diaporama intéressant

Mark (il y a 3 ans)

Wow quelle excellente vidéo, merci de m’avoir aidé à comprendre le surapprentissage.

Melford McRae (il y a 4 ans)

Au fait, j’ai essayé de visualiser le diaporama sur plusieurs navigateurs et je n’ai pas pu le charger. Il semble ne jamais se charger. Quelqu’un chez Lokad peut-il vérifier et voir ce qui pourrait poser problème ?

Shaun Snapp (il y a 4 ans)

Je viens de publier une vidéo mise à jour qui fonctionne.

Joannes Vermorel (il y a 4 ans)

Il semble que SlideShare n’ait pas su entretenir son contenu au fil des années :-( Voici le fichier audio https://media.lokad.com/videos/2009-04-21-overfitting/overfitting.mp3 et le fichier PowerPoint https://media.lokad.com/videos/2009-04-21-overfitting/overfitting.pptx. Je vais les remixer en une vidéo YouTube.

Joannes Vermorel (il y a 4 ans)

C’est un problème assez épineux. Il n’y a pas d’autre façon de mesurer un modèle de prévision qu’en le confrontant à ses performances historiques, mais la tendance est de suradapter pour obtenir « la meilleure précision ». Tout cela poserait un problème encore plus grand si un pourcentage plus élevé d’entreprises utilisait réellement leur procédure de meilleur ajustement dans les systèmes de prévision qu’elles ont achetés ou vraiment ajusté les modèles. Je serais intéressé par une discussion sur la manière de prévenir le surapprentissage lors de l’utilisation d’une procédure de meilleur ajustement.

Shaun Snapp (il y a 4 ans)

J’ai posté une réponse de suivi sur https://blog.lokad.com/journal/2014/5/20/how-to-mitigate-overfitting-when-forecasting-demand. J’espère que cela aidera !

Joannes Vermorel (il y a 4 ans)

Merci pour le diaporama. Il m’a aidé à comprendre le surapprentissage, sans entrer dans les détails mathématiques.

Shyam Prasad Murarka (il y a 8 ans)

Merci pour le diaporama.

Abhishek (il y a 8 ans)