Pico de Mínimo Esfuerzo: Modelos de Lenguaje a Gran Escala para Supply Chain Decisions.

“No basta con abrir puertas ya abiertas; además, hay que evitar volver a pintar la manija de azul Word.”

Si necesitas un curso intensivo en stating the obvious mientras simultáneamente publicitas Microsoft Azure, no busques más que el reciente “Large Language Models for Supply Chain Decisions.”1 El documento promete revolucionar las operaciones; en cambio, recalienta las sobras de ayer, las emplata en Times New Roman, y cobra entrada.

A continuación se presenta una autopsia desenfadada de esta hazaña de lugares comunes.

1. Una escena del crimen en la formateación

Antes de llegar al resumen, el artículo nos insulta con el Heading 1 predeterminado de Microsoft Word 97. No hay LaTeX, ningún amor por la composición tipográfica, ni siquiera un intento a medias de un pie de figura decente. Queridos autores: si TikZ resulta intimidante, al menos cambien el color del título—cualquier cosa para demostrar que un humano tocó la plantilla.

2. Abriendo puertas de par en par

La página 1 anuncia solemnemente que “Modern supply chains are complex” y que “optimization tools have been widely utilized.” Innovador. Luego revelarán que el agua está mojada y que los lunes siguen a los domingos.

A lo largo del texto, cada hecho es o bien:

- ya cubierto en cursos de OR de pregrado hace dos décadas, o

- tan genérico que podría ser copiado‑pegado en Wikipedia sin que nadie lo note.

3. LLM 101 — en 2025

La Sección 2 consume tres páginas explicando que un LLM “predicts the next word.” Imagina enviar un artículo de física que se detiene para aclarar la F = ma de Newton. Esto es peak minimal effort: el modelo de erudición en el que asumes que tu lector acaba de despertar en 1990.

4. ¿Dónde están los números?

El título promete “decisions,” sin embargo, la única ecuación a la vista es el pie de página con el número. No hay formulaciones, ni loss functions, ni KPIs, ningún benchmark comparado incluso con el Excel solver. Nos dicen que GPT‑4 alcanza “around 90% accuracy.” ¿Exactamente, la precisión de qué? ¿Estimaciones de costos? ¿Niveles de servicio? ¿Identificación de pastelería francesa? Ante la ausencia de una métrica, el 90% de evidencia nula aún redondea a cero.

5. El Cabaret del ¿Y si…?

Los autores desfilan una arquitectura maravillosa (ver Figure 1 — un diagrama de flujo digno de PowerPoint ClipArt) que traduce un simple “what if?” en “código matemático.”

Sin embargo, la magia entre bastidores se deja a la imaginación. ¿Qué solver? ¿Qué runtime? ¿Cómo se mantiene la viabilidad cuando GPT añade alegremente restricciones que rompen el modelo? Silencio. Confía en nosotros, somos los expertos.

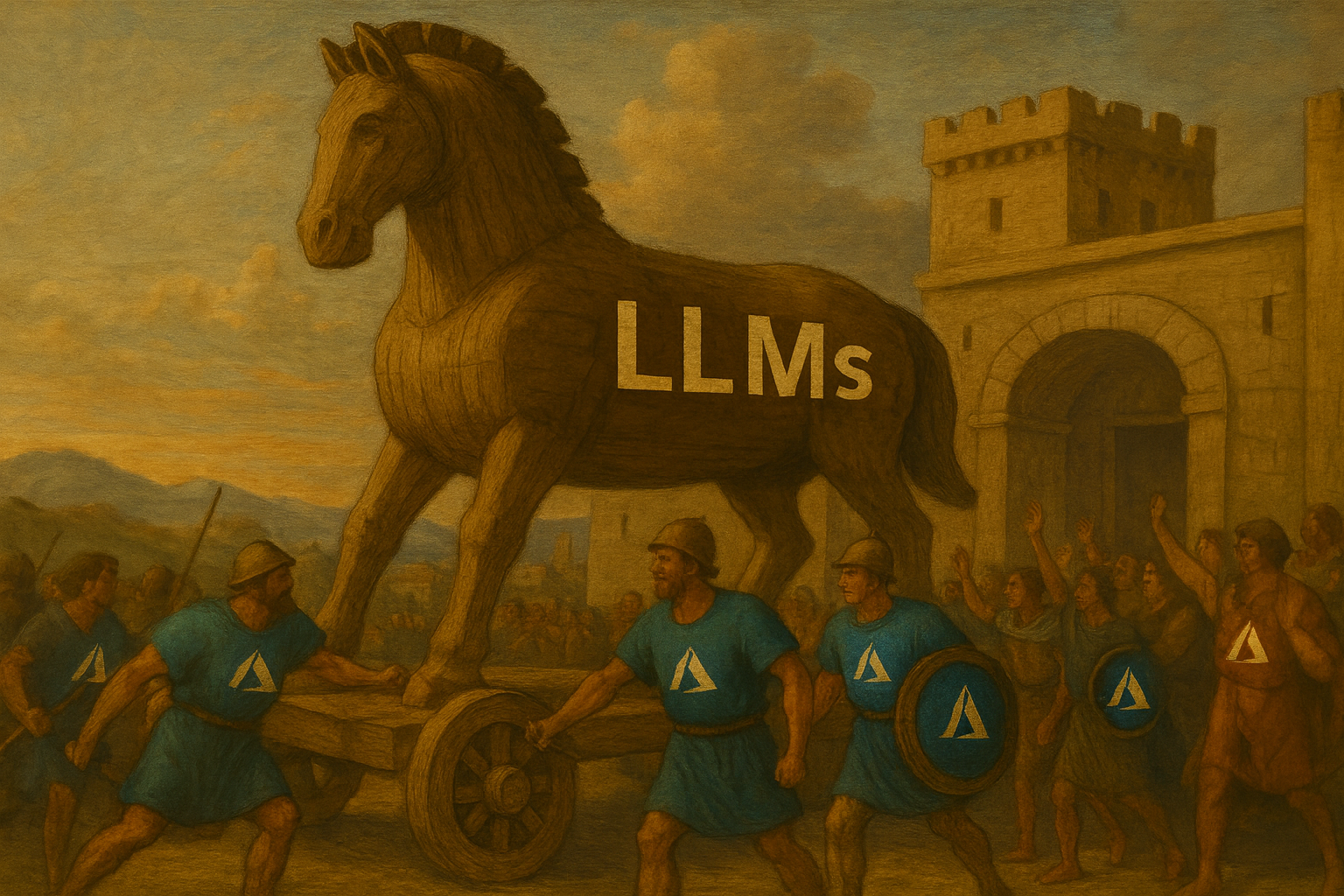

6. Contenido patrocinado, edición académica™

Aproximadamente un tercio de las páginas es un estudio de caso de planificadores de Microsoft Azure que, según aprendemos, ahora están entusiasmados porque un chatbot interno les ahorra el 23 % del tiempo de investigación.

Esa proporción es sospechosamente precisa para una métrica que nunca se definió. Más importante aún, el “experiment” es indistinguible de un comunicado de prensa. El product placement puede estar bien en Transformers 19, pero en un capítulo académico huele a infomercial.

7. ¿Riesgo? ¿Ética? No.

Los LLMs alucinan, filtran datos, inventan proveedores de la nada—nada de lo cual aparece en la discusión. Los autores sí señalan que los usuarios deben “learn to ask precise questions,” culpando efectivamente al operador si el modelo se descontrola. Eso es como enviar un automóvil sin frenos e instruir a los conductores a “planificar sus paradas cuidadosamente.”

8. Bibliografía sin biología

Cinco referencias: cinco son auto‑citas, tres son pre‑prints, una es HBR (léase: blog corporativo con notas al pie). La literatura real de supply‑chain —demand forecasting, stochastic optimization, probabilistic lead‑times— no se encuentra en ningún lado. Aparentemente, OR comenzó cuando se lanzó GPT‑3.

9. Oportunidades perdidas

- Probabilistic thinking: Las supply chain operan con uncertainty. El artículo funciona con polvo de hadas determinista.

- Causal inference & counterfactuals: Reemplazado por “ask GPT what happens if fábrica F shuts down.”

- Computational cost: Las GPUs se pasan por alto como “special hardware.” Tu factura de computación en la nube enviará sus saludos.

Reflexiones finales

Este capítulo no es erróneo; simplemente es irrelevante. Contribuye tanto a la ciencia de supply‑chain como la sabiduría estampada en parachoques a la filosofía. Si el objetivo era demostrar que los LLMs pueden write un artículo de supply‑chain, felicidades—la IA claramente lo hizo, y nadie se molestó en editarlo.

Para los lectores que buscan sustancia, puedo sugerirles que se salten el artículo y le pidan a ChatGPT “explain supply‑chain optimization like I’m five.” Recibirán contenido superior, mejor formateado, y sin los comerciales de Azure.