ハーバード・ビジネス・スクールのギザギザな技術フロンティアに関する微妙な見解

品質は主観的だが、コストはそうではない。

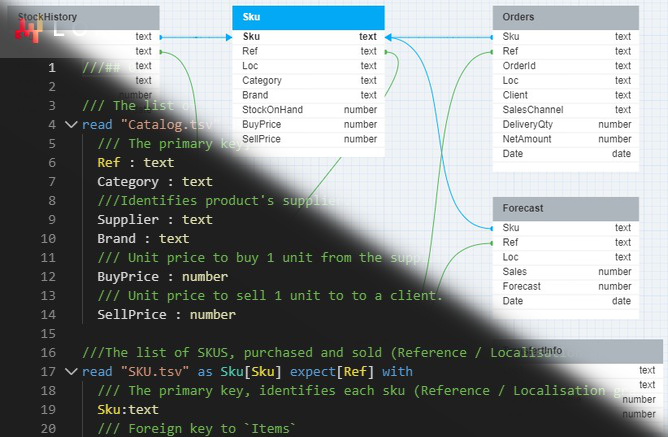

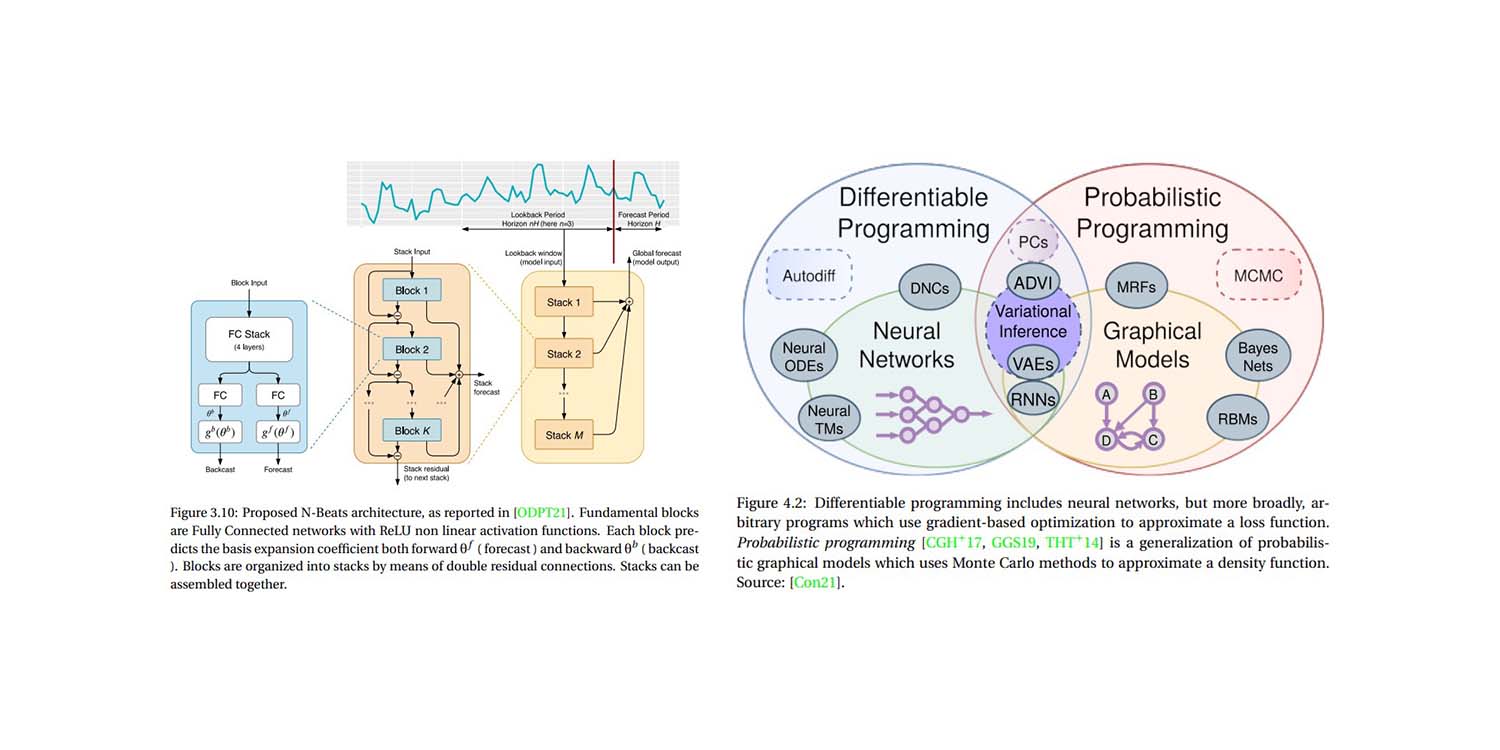

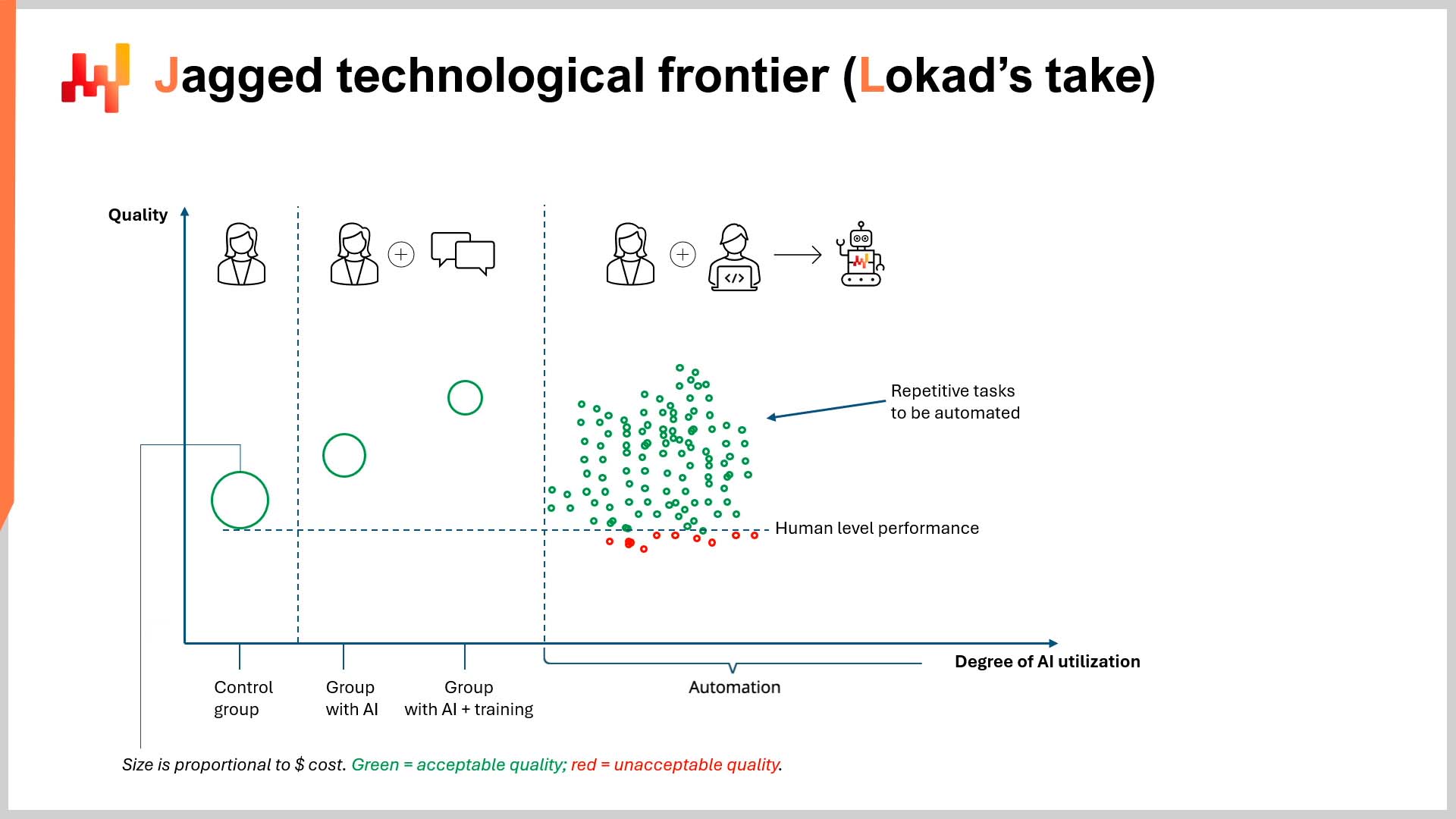

最近のLokadTVのエピソードで、私はハーバード・ビジネス・スクール(HBS)がボストン・コンサルティング・グループ(BCG)と共同で実施した論文に、重大な欠陥と潜在的な危険性があると示唆しました。その論文の正式タイトルは Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge, Worker Productivity, and Quality1 です。要するに、この論文は、AIの高度なタスク遂行能力が均一に発揮されるわけではなく、一部のタスクでは優れ、他のタスク(それぞれ「フロンティア内」と「フロンティア外」のタスク)では不十分であると述べています。

背景

この「ぎざぎざの技術フロンティア」の向こう側では(論文の27ページの図を参照)、特に定量的および定性的な分析を融合するタスク、すなわち「フロンティア外」のタスクにおいて、人間の専門知識は(この場合ChatGPT-4が)AIを上回っています。

ChatGPTのような大規模言語モデル(LLM)が何のために設計されているかに精通している人にとっては(ネタバレですが:数学ではありません)、これは驚くべきことではありません。また、LLMを「何でもありのデータベース」として扱うと、もっともらしいが時に不正確な応答を生成することがあります2。しかしながら、この論文はいくつかの興味深い点を(たまたまですが)提起しています。

評価すべき点として、この論文は非常に読みやすく、学界ではしばしば欠如している特徴を有しています。とはいえ、潜在的な利益相反3や論文の結論4についていくつか懸念を挙げることもできますが、ここでの主な関心事は、論文の方法論と暗黙の経済論にあります。

方法論の批判

方法論に関しては、この点は既にビデオで批判されているため、ここでは簡潔に述べます。研究チームは自動化によってもたらされる生産性向上を検証しませんでした。代わりに、研究者はAI、コンピューターサイエンス、または工学の専門家でないコンサルタントのグループを選び、ChatGPT-4を使用させました。この例外は、自身の専門知識のみを活用して作業した対照群だけでした。これらのグループがどのように評価されたかという倫理的側面については、後ほど言及します。

実験には外部のソフトウェアエンジニアやAI専門家は参加していませんでした。情報検索支援生成(RAG)、ドメイン固有の微調整、その他LLMの最大の強みであるノイズ耐性やユニバーサルテンプレート化といった技術に習熟した開発チームも存在しませんでした。

この印象的なロボットは、BCGの過去のコンサルティング実績に関する膨大な内部データベースに蓄積されたドメイン固有の知識を活用するようにはプログラムされていませんでした。むしろ、実験にはChatGPT-4のサブスクリプションを持つ一部のコンサルタントが参加していました。

このオーケストレーションは、特に定量的および定性的分析の両方を必要とするタスクにおいて、成果の品質にさまざまなばらつきをもたらしました。言い換えれば、非専門家が高度な技術を十分に活用できず、非現実的に厳しい条件下でどれほど失敗するかを確かめるための実験だったのです。

ビデオで結論付けたように、自動化による生産性向上(および節約)を無視するのは、スキャンダルに近い行為です。これは特に、名門教育機関の名を掲げて発表する場合に顕著です。この論文の結論は、私の見解では、トップビジネススクールで学ぶために人生を大きく変える借金を負おうとしている学生に、非常に誤った(職業上の)安心感を与えるものでもあります。すでに大きな借金を負って学位を得た人々にも同様の影響があるでしょう。

経済的視点の批判

上述の大きな批判にもかかわらず、私見ではこの論文の暗黙の経済論はさらに魅力的です。簡単に言えば、ハーバード・ビジネス・スクールは成果の$${quality}$$(品質)のみを測定し、$${cost}$$(コスト)については測定していなかったのです5.

研究者たちは、コンサルタントの成果に関連するコストを一度も測定していません(事実確認をお願いします)。これは決して些細な点ではありません。論文では「quality」という言葉が論文全体の58ページ(タイトルを含む)で65回も言及されているのに対し、「cost」という言葉は…2回…そして論文の最後の文でのみ言及されています。文脈を説明するために、その文章をここに再掲します:

“Similarly to how the internet and web browsers dramatically reduced the marginal cost of information sharing, AI may also be lowering the costs associated with human thinking and reasoning, with potentially broad and transformative effects.” (p. 19)

ハーバード・ビジネススクールが最終的に財務コストの概念を認めたとしても、それは高品質な成果を(高価なビジネススクール卒業生を要せずに)生成する際のコスト削減の視点からではありませんでした。論文タイトルが「生産性」と「品質」を研究の焦点としていること、そして高価なビジネススクールが自らの将来的な無用性を宣伝することはほとんどないという事実を考えれば、これは自明のことかもしれません。

それにもかかわらず、私は、堅実な財務的視点を欠いたまま成果の$${productivity}$$(生産性)と$${quality}$$(品質)を測定するのは実質的に無意味であると、控えめながら提案します。特に、AIが財政力において_偉大な平準化装置_であるという論点を考えればなおさらです。

AIは、特に自動化を通じて、非常に低コストで非常に高品質な成果を提供します。この$${quality/cost}$$比は、人間の労働者のそれと比べて桁違いに優れています6。さらに、ChatGPTのサブスクリプションとわずかなプログラミング知識さえあれば、_誰にでも_その恩恵をもたらします。これにより、大企業と小企業との競争条件が劇的に平等化されるのです。

その代わりに、ハーバード・ビジネススクールは58ページにわたり、BCGコンサルタントの作業の「品質」だけを個別に評価しました。この品質はどのように決定されたのでしょうか?それは、BCGに勤務する「人間の採点者」によって行われたのです7。 既に詳細に述べた明白な利益相反を脇に置くと、論文が提示する偽りの二分法と、それが暗黙の経済論にどのように影響しているかに言及する価値があります。この偽りの二分法は、次のようなものです:

“AI is either better or worse than human expertise.”

もしくは、もっと寛大な解釈としては:

“AI makes humans better or worse at their jobs.”

いずれにせよ、論文の偽りの二分法の根底にある指標は「品質」であり、これは主観的に測定され、時間、効率、コストといった他の制約とは無関係な学問的真空の中に存在します。 より洗練された経済学的視点は、次のようなものになるでしょう:

人間の成果の$${quality/cost}$$比と、AI自動化の$${quality/cost}$$比はどのように比較されるのか?

洗練された読者なら、これはROI(投資収益率)の議論であると認識するでしょう。あなた自身の$${quality/cost}$$比は、次の質問に答えることで明らかになります:

- あるタスクに対する成果はどの程度優れていたか?

- その成果にかかったコストはいくらだったか?

- その品質はコストに見合うものだったか?

- 品質を向上させるためにはどれだけの費用がかかり、その向上は経済的に見合うものか?

ハーバード・ビジネス・スクールは、58ページにわたり最初の質問について議論し、その先には決して踏み込んでいません。これはビジネススクールとしては奇妙な視点であると言わざるを得ません。実際、サプライチェーンとの興味深い類似点を引き出すことができます。HBSの品質に対する盲目的な追求は、予測-精度-定義(すなわち、ROIを考慮せずに予測精度だけを向上させようとする取り組み)を孤立して追求するのと非常に似ています8。

潜在的な影響

経済的観点から言えば、「ぎざぎざの技術フロンティア」とは、単にLLMが人間よりも得意とするタスクを明らかにするものではありません。むしろ、LLMを活用する際の理想的な$${quality/cost}$$比を特定し、知的で財務的に情報に基づいた意思決定を行うことを意味します。賢明なビジネスマンにとって、これは自動化を伴うものであり、手作業の介入(あるいは少なくとも非常に少ない介入)では済まされません。

これらのビジネスマンにとって、コスト効率が良ければ_同等の品質_が受け入れられるかもしれません。「受け入れ可能な」とは、人間の専門家が生み出す品質と同等、またはやや優れている/劣っているという意味かもしれません。言い換えれば、コンサルタントの費用の0.07%を支払い、90%以上の品質を得ることは、高額な専門家の成果物と_全く同じではなくても_、非常に良いトレードオフといえるでしょう9。

数値はクライアントごとに異なるかもしれませんが、明らかなのは、ある転換点を超えると「品質」が単独で問題とならず、その財務的コストとともに評価されなければならなくなるということです。これは、事業を継続しようとする企業にとっては少なくとも真実です。

もしかすると、ハーバード・ビジネス・スクールの卒業生やBCGのコンサルタントを雇うことが、AI自動化のような安価な選択肢にかかわらず、理想的な$${quality/cost}$$比を実現するとお考えかもしれません。その場合、どうか長生きして繁栄されますように10。

あるいは、私と同じように考えるかもしれません:品質は主観的だが、コストはそうではない。私の品質に対する主観的な評価、特にビジネスにおいては、そのコストに相対するものです。サプライチェーンにおけるサービス-レベル-定義(または予測精度)のように、品質(または精度)が1%向上しても、コストが1,000%上昇する価値はないでしょう。したがって、ビジネスにおけるAIは、品質とコストの間で経済的なトレードオフが存在することを示しています。ハーバード・ビジネス・スクールがこの点を見失っているように思われるため、これは極めて重要なことです。

結論として、もしあなたがAIが人間の品質を上回るのを待ってから導入するのであればそれで構いませんが、私たち他の者は決してあなたと一緒に待つつもりはありません。

-

Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality, Dell’Acqua, Fabrizio and McFowland, Edward and Mollick, Ethan R. and Lifshitz-Assaf, Hila and Kellogg, Katherine and Rajendran, Saran and Krayer, Lisa and Candelon, François and Lakhani, Karim R., September 2023 ↩︎

-

AI Pilots for Supply Chainにおいて、Joannes Vermorelはこの「スイスアーミーナイフ」的アプローチを、非常に賢明な教授にかつて学んだ論文の詳細を思い出すよう頼むことに例えました。頭の中で概要は思い出すものの、適切な追質問をしなければ細かいニュアンスは必ずしも思い出されないかもしれません。 ↩︎

-

BCGは、多くのアメリカのトップビジネススクールとの関係を積極的に宣伝しています。主要な米国キャンパスにおけるBCGの存在については、主要な米国キャンパスにおけるBCGの存在を調査してみてください。あるいは、データを簡素化した便利なダウンロード可能なExcelもご覧ください。この表には、現在ハーバード・ビジネス・スクールでMBAを学んでいるBCGコンサルタントの人数(74人)が記載されています。読者ご自身で結論を導いてください. ↩︎

-

大手ビジネススクールと大手コンサルティングファームとの共同作業は、高価で(かつ高額な訓練を受けた)コンサルタントが価値ある資産であることを示しました…… 驚きを隠せない方もいるかもしれませんが、その場合は前の脚注のダウンロード可能なExcelをご参照ください. ↩︎

-

そして、後述するように、論文は成果のコストに対する品質を測定してはいませんでした. ↩︎

-

この点について正確な数字を示すのは難しいですが、任意の大手企業のコンサルタントの年間給与が20万米ドルを超えると仮定しましょう。この数字は、ネット上での大雑把な調査に基づいて妥当なものです。ChatGPTの_ざっくりとした_計算によれば、1年分のコンサルティング作業は約145米ドル(ChatGPTの処理コストの観点で)かかると示唆されています。もちろんこれは非常に科学的ではありませんが、たとえその数字が三桁ずれていたとしても、単一コンサルタントの年間給与より約30%安い計算になります。ChatGPTの推論はこちら: https://chat.openai.com/share/d9beb4b9-2dd3-4ac2-9e95-2cd415c76431. (会話ログを提供してくれたAlexey Tikhonovに感謝します。) 確かに、テンプレートロボット自体の構築コストも考慮すべきですが、それが高額であっても、ChatGPTの145ドルと合わせても単一のコンサルタントの年間給与よりは安く、かつ大規模展開すれば指数関数的に生産性が向上するでしょう. ↩︎

-

お読みになった内容に疑いがあるなら、論文の9ページと15ページを参照してください。もしこれが潜在的な利益相反を示唆するなら、改めて脚注3のダウンロード可能なExcelにご注意いただくようお願いします. ↩︎

-

Lokadは以前、予測の正確さは本当に重要ですか?で予測精度の価値について詳細に論じています。要するに、KPI(例えば正確さ)を、その財務的帰結(すなわちROI)と切り離して測定するのではなく、サプライチェーンにおける意思決定がもたらす財務的影響に注目すべきだということです。別の言い方をすれば、需要予測が10%正確になっても、その結果として20%収益が減少するのであれば、精度向上は増加したコストに見合わなかったと言えるでしょう. ↩︎

-

約1年前、LokadはLLMを使用してウェブサイトを6言語に翻訳し始めました。それ以前は、プロの翻訳者のサービスを利用していました。翻訳を維持するための継続的なコストは、1言語あたり年間約15,000~30,000米ドルでした。確かにプロの翻訳者が提供する品質は(相対的に)高いですが、LLMを利用する際の$${quality/cost}$$比は_はるかに_優れています。つまり、LLMで生成できる品質は十分に受け入れられるだけでなく、従来の体制と比べて大幅に低コストです。節約効果を正確に定量化するのは困難ですが、これまで制作(そして将来制作する)する全てのリソースを、数分で6言語に有能に翻訳できることは、従来のシステムと比べて指数関数的に低コストで時間効率が良いのです。もしあなたがフランス語、ドイツ語、スペイン語、ロシア語、イタリア語、または日本語のネイティブスピーカーなら、このページ右上のエッセイの翻訳を自由に行い、その品質を実際に確かめてみてください. ↩︎

-

少なくとも OpenAI が ChatGPT-5 をリリースするまでです. ↩︎