Effort minimal de pointe : Grands Modèles de Langage pour Supply Chain Decisions.

“Il ne suffit pas d’ouvrir des portes déjà ouvertes; encore faut‑il éviter de repeindre la poignée en bleu Word.”

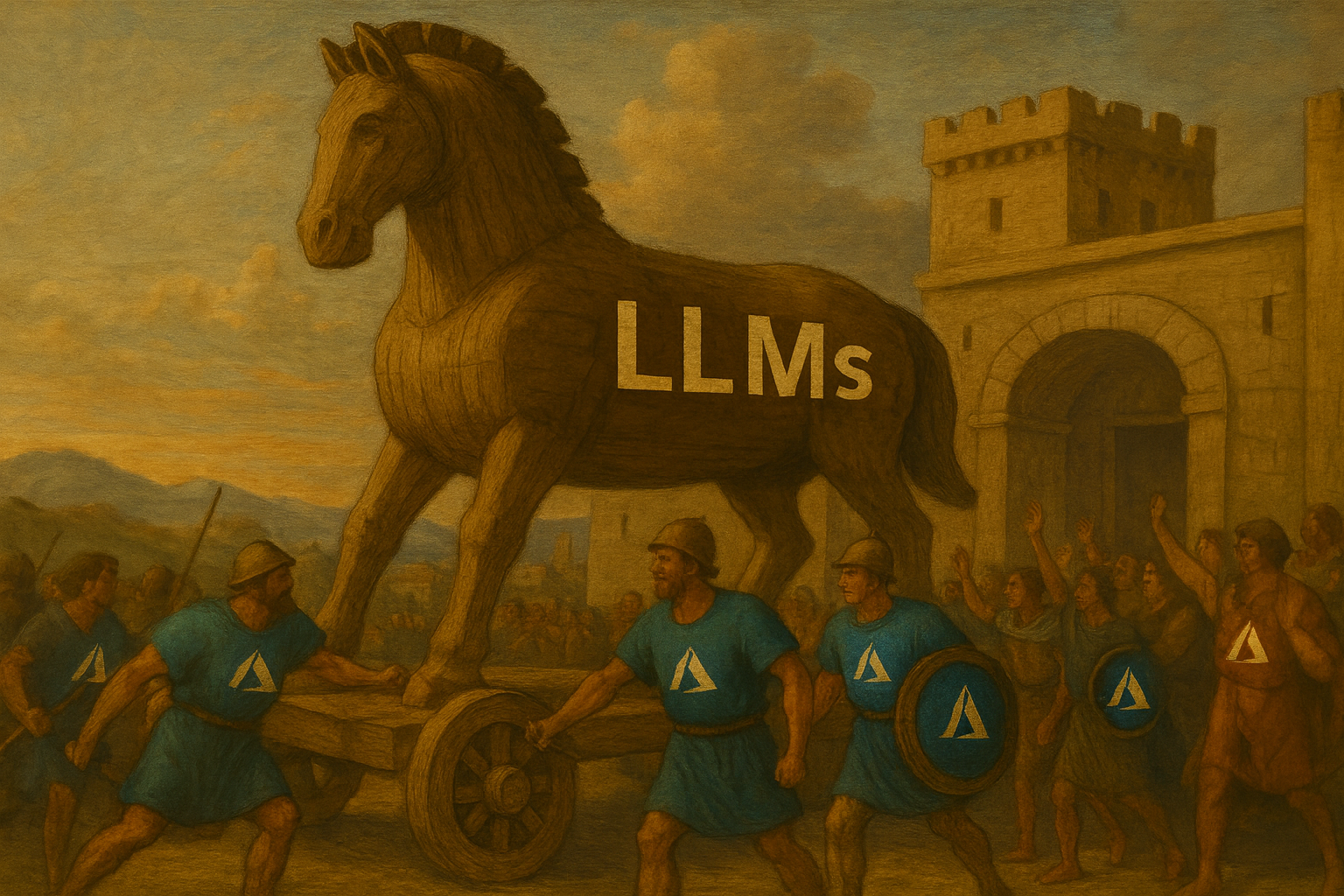

Si vous avez besoin d’une initiation éclair à l’énoncé de l’évidence tout en faisant la publicité de Microsoft Azure, ne cherchez pas plus loin que le récent “Large Language Models for Supply Chain Decisions.”1 Le document promet de révolutionner les opérations; il réchauffe plutôt les restes d’hier, les dresse sur Times New Roman, et fait payer l’admission.

Voici une autopsie légère de ce tour de force de platitudes.

1. Une scène de crime de mise en forme

Avant d’atteindre le résumé, l’article nous insulte avec le Heading 1 par défaut de Microsoft Word 97. Pas de LaTeX, pas d’amour pour la mise en page, même pas une tentative à moitié sincère d’une légende de figure décente. Chers auteurs: si TikZ vous intimide, changez au moins la couleur du titre—n’importe quoi pour prouver qu’un humain a touché au modèle.

2. Donner des coups de pied dans des portes grandes ouvertes

La page 1 annonce solennellement que “les supply chains modernes sont complexes” et que “les outils d’optimisation ont été largement utilisés.” Révolutionnaire. Ensuite, ils révéleront que l’eau est mouillée et que les lundis suivent les dimanches.

Dans tout le texte, chaque fait est soit :

- déjà couvert dans des cours d’OR de premier cycle il y a deux décennies, ou

- si générique qu’il pourrait être copié‑collé dans Wikipedia sans que personne ne s’en aperçoive.

3. LLM 101 — en 2025

La section 2 consacre trois pages à expliquer qu’un LLM “prédit le mot suivant.” Imaginez soumettre un article de physique qui s’arrête pour clarifier le F = ma de Newton. C’est le summum de l’effort minimal de pointe: le modèle de bourse où l’on suppose que votre lecteur vient de se réveiller en 1990.

4. Où sont les chiffres?

Le titre promet des “décisions”, pourtant la seule équation en vue est le numéro de page en pied de page. Aucune formulation, aucune loss functions, aucun KPI, aucune référence même avec le solveur Excel. On nous dit que GPT‑4 atteint “environ 90% accuracy”. Une précision de quoi, exactement? Des estimations de coûts? Des taux de service? L’identification de pâtisseries françaises? En l’absence d’une métrique, 90% d’aucune preuve reste égal à zéro.

5. Le Cabaret du « Et si ? »

Les auteurs défilent avec une architecture merveilleuse (voir Figure 1 — un organigramme digne des ClipArt de PowerPoint) traduisant un simple “et si?” en “code mathématique.”

Pourtant, la magie en coulisses est laissée à l’imagination. Quel solveur? Quel temps d’exécution? Comment maintenez-vous la faisabilité lorsque GPT ajoute joyeusement des contraintes qui cassent le modèle? Silence. Faites-nous confiance, nous sommes les experts.

6. Contenu sponsorisé, édition académique™

Environ un tiers des pages est une étude de cas sur Microsoft Azure planificateurs qui, nous apprenons, sont désormais ravis parce qu’un chatbot interne leur fait gagner 23 % de temps d’investigation.

Ce ratio est suspectement précis pour une métrique jamais définie. Plus important encore, “l’expérience” est indiscernable d’un communiqué de presse. Le placement de produit peut être acceptable dans Transformers 19, mais dans un chapitre académique, cela pue l’infopublicité.

7. Risque? Éthique? Non.

Les LLM hallucinent, divulguent des données, inventent des fournisseurs de nulle part—aucun de ces éléments n’apparaît dans la discussion. Les auteurs notent en effet que les utilisateurs doivent “apprendre à poser des questions précises,” imputant ainsi la faute à l’opérateur si le modèle déraille. C’est comme expédier une voiture sans freins et demander aux conducteurs de “planifier soigneusement leurs arrêts.”

8. Bibliographie sans biologie

Cinq références: cinq sont des auto‑citations, trois sont des pré‑publications, une est HBR (lisez: blog d’entreprise avec notes de bas de page). La littérature réelle sur la supply chain—prévision de la demande, optimisation stochastique, délais probabilistes—est introuvable. Apparemment, l’OR a débuté avec la sortie de GPT‑3.

9. Opportunités manquées

- Pensée probabiliste: les supply chains fonctionnent grâce à l’incertitude. L’article fonctionne grâce à de la poussière de fée déterministe.

- Inférence causale et contrefactuels: remplacés par “demandez à GPT ce qui se passe si l’usine F ferme.”

- Coût computationnel: les GPU sont présentés comme du “matériel spécial.” Votre facture cloud vous adressera ses salutations.

Réflexions finales

Ce chapitre n’est pas erroné; il est tout simplement peu pertinent. Il contribue autant à la science de la supply chain que la sagesse des autocollants de pare-chocs ne contribue à la philosophie. Si le but était de démontrer que les LLM peuvent écrire un article sur la supply chain, félicitations—l’IA l’a clairement fait, et personne n’a pris la peine de le modifier.

Pour les lecteurs en quête de substance, puis-je suggérer de passer l’article et de demander à ChatGPT “explique l’optimization de la supply chain comme si j’avais cinq ans.” Vous recevrez un contenu supérieur, mieux formaté, et sans les publicités Azure.