Eine nuancierte Perspektive auf die unebene technologische Grenze der Harvard Business School

Qualität ist subjektiv; Kosten nicht.

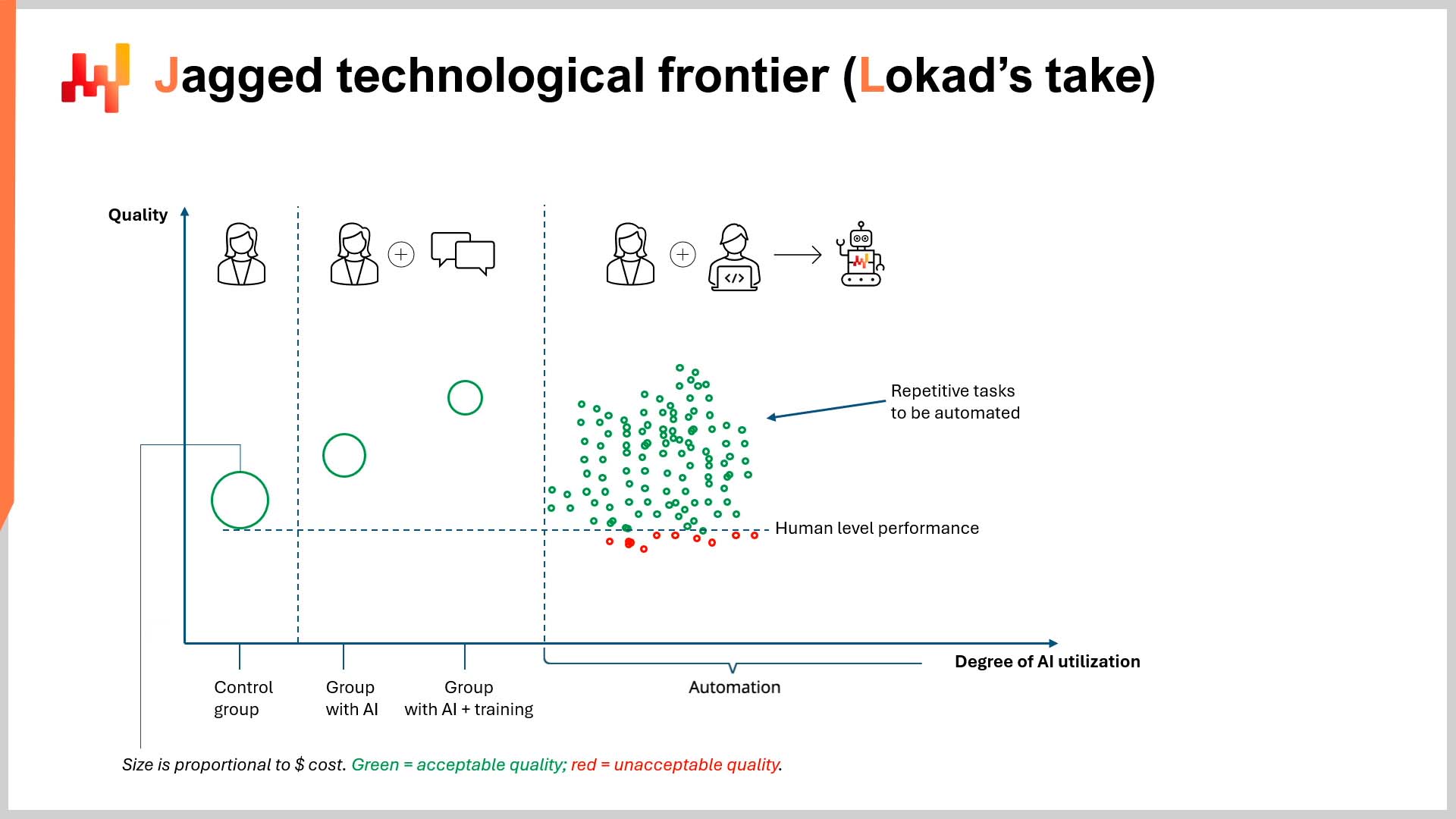

In einer kürzlich erschienenen Folge von LokadTV habe ich vorgeschlagen, dass eine Studie der Harvard Business School (HBS), in Zusammenarbeit mit der Boston Consulting Group (BCG), schwerwiegende Mängel aufweist und potenziell gefährlich ist. Der vollständige Titel der Studie lautet Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge, Worker Productivity, and Quality1. Kurz gesagt, die Studie besagt, dass die Fähigkeiten von KI bei anspruchsvollen Aufgaben ungleich verteilt sind, da sie in einigen Aufgabenbereichen herausragend ist und in anderen schlecht abschneidet („innerhalb“ und „außerhalb“ der Grenzaufgaben).

Kontext

Auf der anderen Seite dieser “unebenen technologischen Grenze” (siehe Abbildung auf S. 27 der Studie) übertrifft menschliche Expertise immer noch KI (in diesem Fall ChatGPT-4), insbesondere bei Aufgaben, die quantitative und qualitative Analysen kombinieren (d.h. “außerhalb” der Grenzaufgaben).

Dies sollte niemanden überraschen, der mit dem vertraut ist, wofür große Sprachmodelle (LLMs) wie ChatGPT entwickelt wurden (Spoiler: nicht für Mathematik). Wenn LLMs jedoch als “Datenbank für alles” behandelt werden, liefern sie plausible, aber manchmal ungenaue Antworten2. Die Studie wirft jedoch immer noch einige interessante Punkte auf - wenn auch nur versehentlich.

Zu ihrer Ehre ist die Studie sehr gut lesbar, was in der Wissenschaft oft schmerzlich fehlt. Dennoch könnte man einige Bedenken hinsichtlich möglicher Interessenkonflikte3 und ihrer Ergebnisse4 äußern, aber hier sind vor allem die Methodik und die implizite Wirtschaftlichkeit der Studie von Interesse.

Kritik an der Methodik

In Bezug auf die Methodik wurde dieser Punkt bereits im Video kritisiert, daher werde ich mich hier kurz fassen. Das Forschungsteam hat die Produktivitätsgewinne, die durch Automatisierung erzielt werden, nicht untersucht. Stattdessen wurden Gruppen von Beratern (d.h. Nicht-Spezialisten für KI, Informatik und/oder Ingenieurwesen) ausgewählt, um ChatGPT-4 zu verwenden. Die einzige Ausnahme bildete die Kontrollgruppe, die nur ihre Expertise einsetzte. Die Ethik der Art und Weise, wie diese Gruppen beurteilt wurden, wird in Kürze erwähnt.

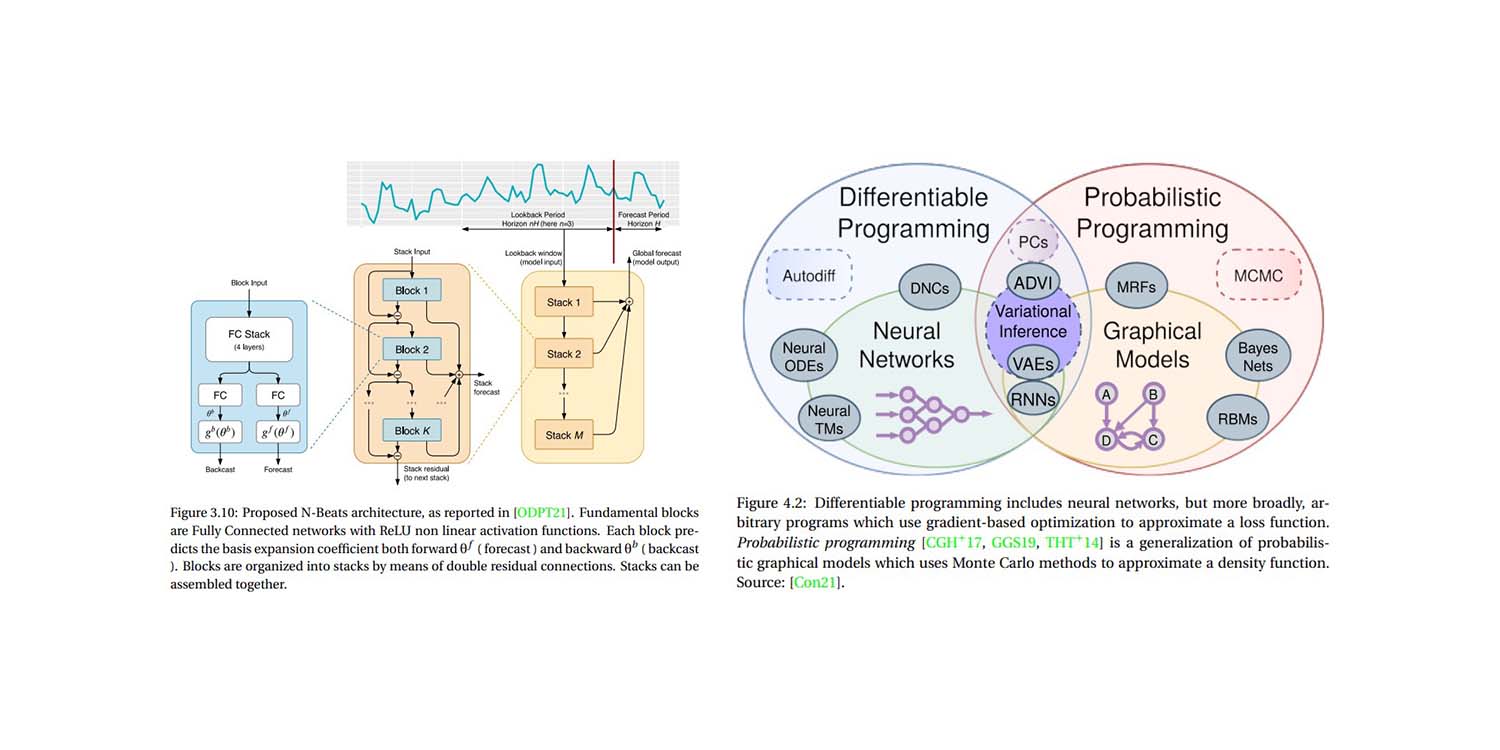

Es gab keine externen Softwareingenieure oder KI-Experten in dem Experiment. Es gab keine Teams von Entwicklern, die sich mit der erweiterten Generierung durch Abruf (RAG), domänenspezifischem Feintuning oder anderen Techniken auskannten, die die größten Stärken von LLMs nutzen: geräuschresistente, universelle Vorlagenroboter.

Dieser beeindruckende Roboter wurde nicht darauf programmiert, das in den umfangreichen internen Datenbanken von BCG gespeicherte domänenspezifische Wissen zu nutzen. Im Gegenteil, das Experiment umfasste einige Berater mit einem Abonnement für ChatGPT-4.

Diese Orchestrierung führte natürlich zu unterschiedlichen Ausgaben (in Bezug auf Qualität), insbesondere bei Aufgaben, die sowohl quantitative als auch qualitative Analysen erforderten. Mit anderen Worten: Es wurde ein Experiment entworfen, um zu sehen, wie schlecht Nicht-Experten eine anspruchsvolle Technologie nutzen können, und das unter unrealistisch restriktiven Bedingungen.

Wie ich im Video festgestellt habe, grenzt es an einen Skandal, die möglichen Produktivitätsgewinne (und Einsparungen) durch Automatisierung zu ignorieren. Dies gilt insbesondere, wenn man unter dem Namen einer renommierten Bildungseinrichtung veröffentlicht. Die Ergebnisse der Studie vermitteln meiner Meinung nach auch den Studierenden, die kurz davor stehen, sich durch ein Studium an einer Top-Business-School in eine lebensverändernde Schuldenlast zu stürzen, ein sehr falsches (Berufs-)Sicherheitsgefühl. Dies gilt auch für Menschen, die bereits den Sprung gewagt und beträchtliche Schulden für Abschlüsse in Bereichen auf sich genommen haben, die kurz vor der vollständigen Automatisierung stehen könnten.

Kritik aus wirtschaftlicher Perspektive

Trotz der oben genannten Kritik ist aus meiner Sicht die implizite Wirtschaftlichkeit des Papiers viel faszinierender. Einfach ausgedrückt hat die Harvard Business School nur die $${Qualität}$$ der Ergebnisse gemessen, nicht die $${Kosten}$$ der Ergebnisse5.

Zu keinem Zeitpunkt (und bitte überprüfen Sie mich) messen die Forscher die Kosten, die mit der Erstellung der Beratungsleistungen verbunden sind. Dies ist kein unwesentlicher Punkt. Das Wort “Qualität” wird im Papier 65 Mal in 58 Seiten erwähnt (einschließlich des Titels des Papiers). Das Wort “Kosten” wird…2 Mal…und nur im allerletzten Satz des Papiers erwähnt. Ich reproduziere diesen Satz hier für den Kontext:

“Ähnlich wie das Internet und Webbrowser die Grenzkosten für den Austausch von Informationen dramatisch reduziert haben, könnte KI auch die Kosten für menschliches Denken und Schlussfolgern senken, mit potenziell weitreichenden und transformierenden Auswirkungen.” (S. 19)

Selbst als die Harvard Business School endlich das Konzept der finanziellen Kosten anerkannte, geschah dies nicht in Bezug auf die reduzierten Kosten für die Erstellung hochwertiger Arbeit ohne die Notwendigkeit teurer Absolventen einer Business School. Dies mag offensichtlich erscheinen, wenn man bedenkt, dass der Titel des Papiers “Produktivität” und “Qualität” als Forschungsschwerpunkte nennt, ganz zu schweigen davon, dass eine teure Business School kaum ihre eigene potenzielle Nutzlosigkeit bewerben wird.

Nichtsdestotrotz schlage ich höflich vor, dass die Messung der $${Produktivität}$$ und $${Qualität}$$ der Ergebnisse ohne eine fundierte finanzielle Perspektive praktisch bedeutungslos ist, insbesondere in einem wissenschaftlichen Papier einer Business School. Dies ist besonders gravierend, wenn man bedenkt, dass der gesamte Kern der KI darin besteht, dass sie ein großer Ausgleicher ist, wenn es um finanzielle Schlagkraft geht.

KI liefert sehr hochwertige Ergebnisse zu sehr niedrigen Kosten, insbesondere durch Automatisierung. Dieses $${Qualität/Kosten}$$-Verhältnis ist um Größenordnungen höher als das von menschlichen Arbeitern6. Darüber hinaus öffnet es diese Tür für jeden, der ein ChatGPT-Abonnement und etwas Programmierkenntnisse hat. Dadurch wird das Spielfeld im Wettbewerb zwischen den Großen und den Kleinen dramatisch ausgeglichen.

Stattdessen bewertet die Harvard Business School auf 58 Seiten die “Qualität” der Arbeit der BCG-Berater isoliert. Wie wurde diese Qualität bestimmt? Durch “menschliche Bewerter”… die für BCG arbeiten7. Unabhängig von den bereits detaillierten offensichtlichen Interessenkonflikten ist es erwähnenswert, wie die falsche Dichotomie, die in dem Papier präsentiert wird, und wie dies seine implizite Wirtschaftlichkeit beeinflusst. Diese falsche Dichotomie läuft in etwa so ab:

“KI ist entweder besser oder schlechter als menschliche Expertise.”

Oder vielleicht ist eine wohlwollendere Interpretation:

“KI macht Menschen in ihrem Job besser oder schlechter.”

Wie auch immer, die Metrik, die der falschen Dichotomie im Papier zugrunde liegt, ist “Qualität”, die subjektiv gemessen wird und in einem akademischen Vakuum unabhängig von anderen Einschränkungen wie Zeit, Effizienz und Kosten existiert. Eine anspruchsvollere wirtschaftliche Perspektive wäre so etwas wie:

Was ist das $${Qualität/Kosten}$$-Verhältnis der menschlichen Ergebnisse im Vergleich zum $${Qualität/Kosten}$$-Verhältnis der KI-Automatisierung?

Anspruchsvolle Leser werden dies als ein ROI (Return on Investment)-Argument erkennen. Ihr persönliches $${Qualität/Kosten}$$-Verhältnis kann durch Beantwortung der folgenden Fragen ermittelt werden:

- Wie gut waren die Ergebnisse für eine bestimmte Aufgabe?

- Wie viel hat es gekostet?

- War die Qualität den Kosten wert?

- Wie viel würde es kosten, die Qualität zu verbessern, und wäre diese Verbesserung finanziell lohnenswert?

Die Harvard Business School widmet 58 Seiten der ersten Frage und geht nie darüber hinaus. Das ist eine bemerkenswerte Perspektive für eine Business School, muss man sagen. Tatsächlich kann man interessanterweise eine Parallele zur Supply Chain ziehen. Die blinde Verfolgung von Qualität durch die HBS ähnelt stark der isolierten Verfolgung der Prognosegenauigkeit (d.h. dem Versuch, die Prognosegenauigkeit zu verbessern, ohne den damit verbundenen ROI zu berücksichtigen)8.

Mögliche Auswirkungen

Wirtschaftlich gesehen besteht die “zerklüftete technologische Grenze” nicht einfach darin, herauszufinden, bei welchen Aufgaben LLMs besser abschneiden als Menschen. Vielmehr geht es darum, Ihr ideales $${Qualität/Kosten}$$-Verhältnis zu ermitteln, wenn Sie LLMs nutzen, und intelligente, finanziell informierte Entscheidungen zu treffen. Für clevere Geschäftsleute bedeutet dies Automatisierung, nicht manuelle Eingriffe (oder zumindest sehr wenige davon).

Für diese Geschäftsleute ist vielleicht ein vergleichbares Qualitätsniveau akzeptabel, solange es kosteneffizient ist. “Akzeptabel” kann bedeuten, dass die Qualität gleichwertig ist oder etwas besser/schlechter als das, was ein menschlicher Experte generieren kann. Mit anderen Worten, die Bezahlung von 0,07% des Preises eines Beraters für >90% der Qualität könnte ein sehr guter Kompromiss sein, obwohl sie nicht genau so gut wie die Ausgabe des teuren Experten ist9.

Die Zahlen werden für jeden Kunden unterschiedlich sein, aber was deutlich ist, ist, dass es einen Wendepunkt gibt, an dem “Qualität” nicht mehr isoliert betrachtet werden kann und in Bezug auf ihre finanziellen Kosten bewertet werden muss. Dies gilt zumindest für Unternehmen, die im Geschäft bleiben wollen.

Vielleicht sind Sie der Meinung, dass die Einstellung eines Teams von Absolventen der Harvard Business School oder Beratern von BCG ein ideales $${Qualität/Kosten}$$-Verhältnis darstellt, unabhängig von günstigeren Optionen wie KI-Automatisierung. Wenn ja, hoffe ich, dass Sie lange leben und gedeihen10.

Alternativ denken Sie vielleicht wie ich: Qualität ist subjektiv; Kosten nicht. Meine subjektive Wertschätzung von Qualität - insbesondere im Geschäftsbereich - hängt von den Kosten ab. Ähnlich wie bei Service Levels (oder Prognosegenauigkeit) in der Supply Chain ist eine zusätzliche Steigerung der Qualität (oder Genauigkeit) um 1% wahrscheinlich keine 1.000%ige Kostensteigerung wert. Daher gibt es bei KI im Geschäft einen wirtschaftlichen Kompromiss zwischen Qualität und Kosten. Es ist wichtig, dies nicht aus den Augen zu verlieren, wie es der Harvard Business School offenbar passiert ist.

Abschließend, wenn Sie darauf warten, dass KI die menschliche Qualität überschreitet, bevor Sie sie übernehmen, dann sei es so, aber der Rest von uns wird nicht mit Ihnen warten.

-

Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality, Dell’Acqua, Fabrizio and McFowland, Edward and Mollick, Ethan R. and Lifshitz-Assaf, Hila and Kellogg, Katherine and Rajendran, Saran and Krayer, Lisa and Candelon, François and Lakhani, Karim R., September 2023 ↩︎

-

In AI Pilots for Supply Chain, Joannes Vermorel verglich diesen “Schweizer Taschenmesser”-Ansatz mit der Bitte an einen sehr intelligenten Professor, sich an die Details eines Papiers zu erinnern, das er einmal studiert hat. Der Professor kann sich im Kopf an das Wesentliche erinnern, aber er erinnert sich möglicherweise nicht an alle Nuancen, es sei denn, Sie stellen die richtigen Nachfragen, um sein Gedächtnis aufzufrischen. ↩︎

-

BCG wirbt hilfreicherweise für seine Verbindungen zu vielen der besten Business Schools in Amerika. Sie können gerne die Präsenz von BCG auf den wichtigsten US-amerikanischen Universitätsgeländen untersuchen. Alternativ können Sie dieses hilfreiche herunterladbare Excel durchsehen, das die Daten vereinfacht. Die Tabelle enthält beispielsweise, wie viele BCG-Berater derzeit an der Harvard Business School einen MBA studieren (74). Die Leser können ihre eigenen Schlussfolgerungen ziehen. ↩︎

-

Eine Zusammenarbeit zwischen einer großen Business School und einer großen Unternehmensberatung hat gezeigt, dass teure (und teuer ausgebildete) Berater wertvolle Vermögenswerte sind… Verzeihen Sie mir, wenn ich weniger als schockiert bin. Wenn Sie es jedoch sind, leite ich Sie höflich an das herunterladbare Excel in der vorherigen Fußnote weiter. ↩︎

-

Und es hat mit Sicherheit nicht die Qualität geteilt durch die Kosten der Ausgabe gemessen, wie ich später erläutern werde. ↩︎

-

Es ist schwierig, genaue Zahlen zu diesem Punkt anzugeben, aber nehmen wir an, dass ein Berater von einer beliebigen Top-Firma ein Jahresgehalt von über 200.000 US-Dollar erhält. Diese Zahl ist vernünftig, basierend auf einigen oberflächlichen Internetrecherchen. Die back-of-the-napkin-Berechnungen von ChatGPT deuten darauf hin, dass die Kosten für ein Jahr Beratungsarbeit etwa 145 US-Dollar betragen würden (in Bezug auf die Verarbeitungskosten von ChatGPT). Offensichtlich ist dies nicht besonders wissenschaftlich, aber selbst wenn die Zahl um drei Größenordnungen danebenliegt, ist dies immer noch fast 30% günstiger als das Jahresgehalt eines einzelnen Beraters. Überprüfen Sie die Argumentation von ChatGPT hier: https://chat.openai.com/share/d9beb4b9-2dd3-4ac2-9e95-2cd415c76431. (Dank an Alexey Tikhonov für das Bereitstellen des Gesprächsprotokolls.) Zugegebenermaßen muss man auch die Kosten für den Bau des Vorlagenroboters selbst berücksichtigen, was möglicherweise nicht billig ist, aber selbst in Kombination mit den 145 US-Dollar für ChatGPT wäre es immer noch günstiger als das Jahresgehalt eines einzelnen Beraters und bei Skalierung exponentiell produktiver. ↩︎

-

Sehen Sie sich die Seiten 9 und 15 des Papiers an, falls Sie an dem, was Sie gerade gelesen haben, zweifeln. Wenn dies möglicherweise auf einen Interessenkonflikt hindeutet, leite ich Ihre Aufmerksamkeit höflich an das herunterladbare Excel in Fußnote 3 weiter. ↩︎

-

Lokad hat sich bereits ausführlich mit dem Wert der Prognosegenauigkeit auseinandergesetzt, daher hier eine sehr kurze Auffrischung: Konzentrieren Sie sich auf die finanziellen Auswirkungen Ihrer Supply-Chain-Entscheidungen, anstatt KPIs (wie Genauigkeit) unabhängig von ihren finanziellen Auswirkungen (d. h. ROI) zu messen. Mit anderen Worten, wenn eine Nachfrageprognose um 10% genauer ist, Sie dadurch jedoch 20% weniger Geld verdienen, kann man sagen, dass die gesteigerte Genauigkeit den gestiegenen Kosten nicht wert war. ↩︎

-

Vor etwa einem Jahr begann Lokad, seine Website mit Hilfe von LLMs in sechs Sprachen zu übersetzen. Davor hatten wir die Dienste professioneller Übersetzer in Anspruch genommen. Die laufenden Kosten für die Aufrechterhaltung der Übersetzungen betrugen etwa 15.000-30.000 US-Dollar pro Jahr und Sprache. Obwohl wir gerne einräumen, dass die professionellen Übersetzer eine (relativ) höhere Qualität geliefert haben, ist das $${quality/cost}$$-Verhältnis bei der Verwendung eines LLMs weit höher. Mit anderen Worten, die Qualität, die wir mit einem LLM erzielen können, ist mehr als akzeptabel und deutlich günstiger als unsere vorherige Vereinbarung. Es ist schwierig, die Einsparungen richtig zu quantifizieren, aber die kompetente Übersetzung jeder einzelnen Ressource, die wir jemals produziert haben (und jemals produzieren werden), in sechs Sprachen in wenigen Minuten ist exponentiell günstiger und zeiteffizienter als das vorherige System. Wenn Sie Französisch, Deutsch, Spanisch, Russisch, Italienisch oder Japanisch als Muttersprache sprechen, können Sie gerne diesen Aufsatz in der oberen rechten Ecke der Seite übersetzen und die Qualität selbst testen. ↩︎

-

Zumindest bis OpenAI ChatGPT-5 veröffentlicht. ↩︎