00:00:00 Einführung der Debattenteilnehmer und des Debattenformats

00:02:56 Joannes’ Eröffnungsbemerkungen

00:09:53 Jeffs Eröffnungsbemerkungen

00:16:56 Joannes’ Erwiderung

00:21:47 Jeffs Erwiderung

00:26:53 Joannes’ Schlussbemerkungen

00:28:56 Jeffs Schlussbemerkungen

00:31:05 Nachfolgende Fragen

00:48:36 Fragen des Publikums

01:18:57 Rückblick auf erste Perspektiven und Schlussfolgerungen

Zusammenfassung

In einer von Conor Doherty moderierten Debatte wurde das Thema „Ist Forecast Value Added (FVA) beste Praxis oder Zeitverschwendung?“ von Jeff Baker und Joannes Vermorel erörtert. Jeff Baker, mit umfassender Erfahrung in supply chain management, argumentierte für FVA, indem er dessen Nutzen bei korrekter und strukturierter Anwendung betonte, wobei er die Wichtigkeit unterstrich, Verzerrungen anzugehen und Experteninput zu nutzen. Im Gegensatz dazu argumentierte Joannes Vermorel, CEO von Lokad, dass FVA ineffizient sein kann, und sprach sich stattdessen für die finanzielle Optimierung von supply chain decisions mithilfe von probabilistischen Vorhersagen aus. Die Debatte hob die gegensätzlichen Ansichten bezüglich der Rolle von FVA im supply chain management hervor und bot Einblicke in die Verbesserung von Entscheidungsprozessen.

Erweiterte Zusammenfassung

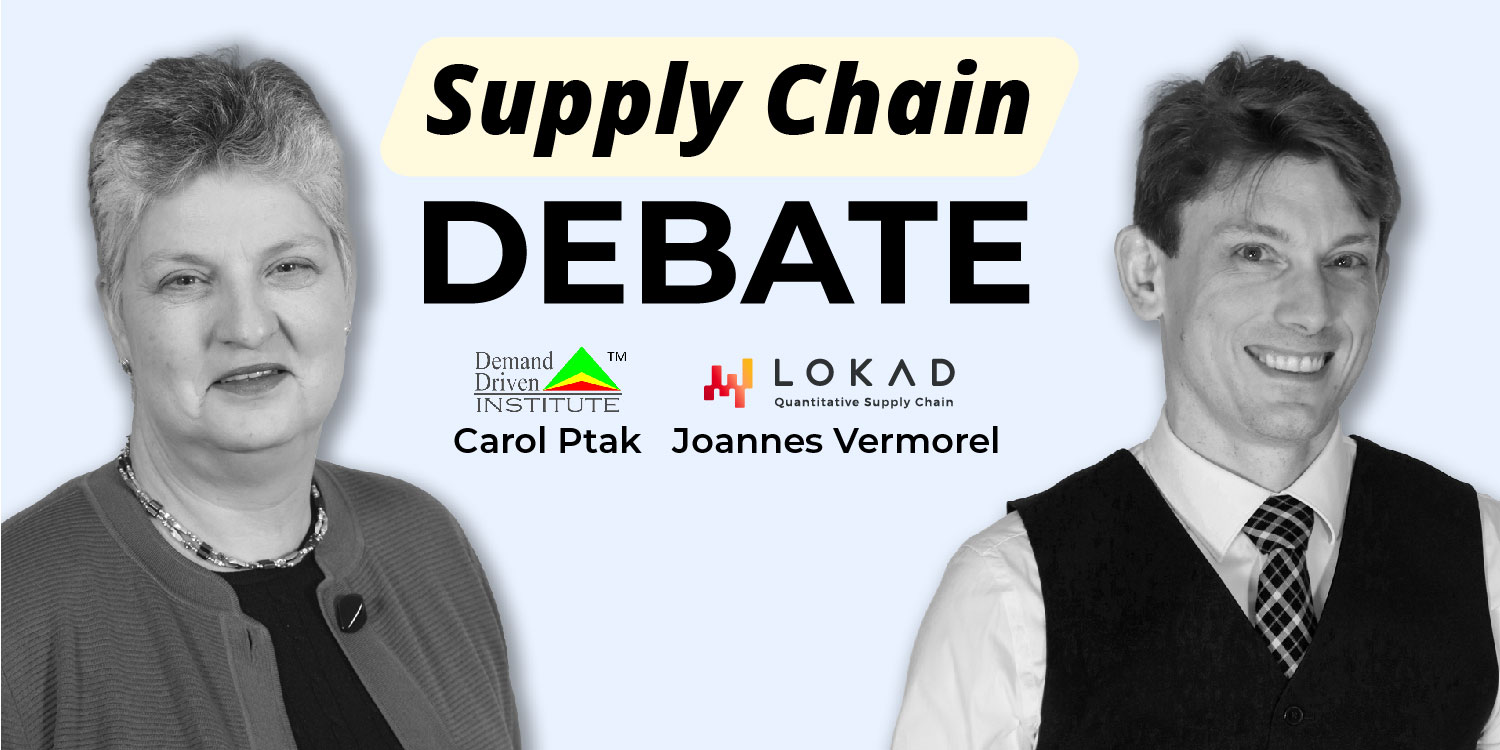

In einer aktuellen Debatte, moderiert von Conor Doherty, Kommunikationsleiter bei Lokad und Gastgeber des LokadTV YouTube-Kanals, wurde das Thema „Ist Forecast Value Added (FVA) beste Praxis oder Zeitverschwendung?“ umfassend untersucht. Die Debatte brachte zwei prominente Persönlichkeiten der supply chain Branche zusammen: Jeff Baker und Joannes Vermorel.

Jeff Baker, der den Einsatz von FVA befürwortet, ist Gründer und Geschäftsführer von Libra SCM, Kursleiter bei MITx MicroMasters in SCM und Associate Editor für Foresight, das International Journal of Applied Forecasting. Mit über 25 Jahren Erfahrung im supply chain management spricht und schreibt Jeff häufig über Sales and Operations Planning (S&OP) und FVA.

Auf der Gegenseite argumentierte Joannes Vermorel, CEO und Gründer von Lokad, einem in Paris ansässigen Softwareunternehmen, das sich der finanziellen Optimierung von supply chain decisions widmet, gegen den Einsatz von FVA. Joannes ist bekannt für seine umfangreichen Veröffentlichungen zu supply chain Themen und seine regelmäßigen öffentlichen Vorträge und Debatten mit Branchenführern.

Conor Doherty eröffnete die Debatte, indem er das Thema vorstellte und jedem Teilnehmer die Möglichkeit gab, sich selbst vorzustellen. Anschließend präsentierte jeder Teilnehmer seine Ansichten zu FVA.

Jeff Baker argumentierte, dass FVA eine wertvolle Praxis ist, wenn sie korrekt angewendet wird. Er betonte, dass Anpassungen an Prognosen geleitet und strukturiert erfolgen sollten. Laut Jeff sollten Anpassungen basierend auf der Richtung der Anpassung (nach oben oder unten), der inhärenten Prognosefähigkeit der time series und der Größe der Übersteuerung vorgenommen werden. Er hob hervor, dass man nach erheblichen Steigerungen suchen sollte, anstatt nur kleine Änderungen vorzunehmen.

Jeff hob auch die Notwendigkeit strukturierter Inputs hervor, bei denen Annahmen klar formuliert und auf neuen Daten basieren, die möglicherweise noch nicht modelliert wurden. Er sprach sich für einen proaktiven Ansatz zur Identifikation und Beseitigung von Verzerrungen aus, indem man die dahinterliegenden Motive versteht und aus vergangenen Fehlern lernt. Jeff ist der Meinung, dass gutes Urteilsvermögen auf Erfahrung beruht, die wiederum auf schlechtem Urteilsvermögen basiert. Indem man zurück zu den Annahmen geht und diese validiert, können Organisationen Probleme wie Überprognosen aufgrund mangelnden Vertrauens in die supply chain angehen.

Weiters argumentierte Jeff, dass Experten im Vertrieb und Marketing besser in der Lage seien, Informationen zu kontextualisieren als Supply Chain Scientists. Er schlug vor, dass wertvolle Inputs dieser Experten im Laufe der Zeit automatisiert werden sollten, räumte jedoch ein, dass wir nicht in einer Welt unbegrenzter, reiner Daten leben. Daher ist es wesentlich, die richtigen Daten aus verschiedenen Quellen, einschließlich Fertigung, Vertrieb und Marketing, zu sammeln.

Joannes Vermorel hingegen argumentierte gegen den Einsatz von FVA. Er vertrat die Ansicht, dass FVA Zeitverschwendung sein kann und nicht zwangsläufig zu besseren Entscheidungsprozessen führt. Joannes betonte die Wichtigkeit, sich auf die finanzielle Optimierung zu konzentrieren und probabilistische Vorhersagen zu nutzen, um fundiertere supply chain decisions automatisch zu treffen. Er argumentierte, dass eine zu starke Abhängigkeit von FVA zu Ineffizienzen führen und von kritischeren Aspekten des supply chain management ablenken könnte.

Die Debatte beinhaltete Nachfolgefragen und einen freien Austausch zwischen den Teilnehmern, der es ihnen ermöglichte, ihre Argumente weiter zu vertiefen und auf die Punkte der jeweils anderen einzugehen. Die Diskussion endete mit einer Q&A-Session, in der das Publikum die Möglichkeit hatte, live im Chat Fragen zu stellen.

Zusammenfassend hob die Debatte die unterschiedlichen Perspektiven auf den Wert von FVA im supply chain management hervor. Jeff Baker plädierte für einen geleiteten und strukturierten Ansatz bei FVA, bei dem das Lernen aus Erfahrung und das Angehen von Verzerrungen im Vordergrund stehen. Joannes Vermorel hingegen argumentierte, dass FVA Zeitverschwendung sein könne und betonte die Notwendigkeit, sich der finanziellen Optimierung von supply chain decisions zu widmen, anstatt Prognoseübersteuerungen vorzunehmen. Die Debatte lieferte wertvolle Einblicke in die Komplexität der supply chain Prognose und die verschiedenen Ansätze zur Verbesserung von Entscheidungsprozessen in diesem Bereich.

Vollständiges Transkript

Conor Doherty: Willkommen zur dritten Ausgabe der Lokad Supply Chain Debates. Heute habe ich das Vergnügen, eine mit Spannung erwartete Debatte zwischen Jeff Baker und Joannes Vermorel zu moderieren. Jeff lehrt Supply Chain Dynamics am MIT Center for Transportation and Logistics und ist Gründer sowie Geschäftsführer von Libra SCM. Währenddessen, zu meiner Linken, ist Joannes der Gründer und CEO von Lokad. Er ist Ingenieur an der École Normale Supérieure in Frankreich und hat dort sechs Jahre lang Software Engineering unterrichtet.

Nun lautet das Thema der heutigen Debatte „Forecast Value Added (FVA): A Best Practice or a Time-Waster?“. Jeff wird argumentieren, dass FVA tatsächlich eine beste Praxis ist, während Joannes darlegen wird, dass es Zeitverschwendung ist. Nun werde ich so schnell wie möglich die Rahmenbedingungen der Debatte sowie organisatorische Hinweise durchgehen, damit wir zum Wesentlichen kommen.

Zunächst wird es Eröffnungsbemerkungen geben, jeweils maximal 7 Minuten. Wie im Vorfeld vereinbart, wird Joannes zuerst sprechen. Anschließend erhält jeder Redner eine 5-minütige Erwiderung. Darauf folgen jeweils zwei Minuten Schlussbemerkungen von jedem Sprecher, woraufhin ich einige Nachfolgefragen stellen werde. Diese Fragen können während der Veranstaltung jederzeit von den Zuschauern im Live-Chat eingereicht werden.

Nun stimmten beide Redner in Vorbereitung auf die Debatte der folgenden Definition zu: Forecast Value Added (FVA) ist ein einfaches Instrument zur Bewertung der Leistung jedes Schrittes und Beitrags in einem Prognoseprozess. Ziel ist es, Verschwendung zu eliminieren, indem Prozesse und Aktivitäten jeglicher Art entfernt werden, die es nicht schaffen, die forecast accuracy zu erhöhen oder Verzerrungen zu verringern.

Diese Definition sowie vollständige Biografien beider Redner befinden sich in einem öffentlichen Google-Dokument, das ihr im Kommentarbereich oder im Chat zu diesem Video finden könnt. Während des Debattenabschnitts werde ich beide Sprecher streng timen und sie höflich daran erinnern, wenn ihnen die Zeit ausgeht – mit einem dezenten Räuspern, bestenfalls. Aber ich empfehle jedem, sich selbst die Zeit zu messen, damit ihr wisst, wann es knapp wird.

Fast geschafft. Die Sprecher sollen während der jeweiligen Redezeit vollkommen schweigen, also bitte unterbrecht euch nicht, zumindest nicht während des getimten Abschnitts. Und zuletzt etwas freche Selbstpromotion: Wenn euch diese Debatten gefallen und ihr unsere Arbeit mögt, dann abonniert bitte den YouTube-Kanal von Lokad und folgt uns auf LinkedIn. Und damit: Ist Forecast Value Added beste Praxis oder Zeitverschwendung? Joannes, bitte, deine Eröffnungsbemerkungen.

Joannes Vermorel: Zunächst möchte ich mich bei Jeff bedanken, dass er so sportlich ist und dieser Debatte zugestimmt hat. Einfach ausgedrückt ist FVA ein Instrument zur Verfolgung von Genauigkeitssteigerungen und -senkungen. Nun, ist FVA eine beste Praxis? Damit etwas als beste Praxis gilt, muss es definitionsgemäß das Verständnis der Community darüber widerspiegeln, was der effektivste Weg ist, ein bestimmtes Ziel zu erreichen. Allerdings ist Prognostizieren kein Selbstzweck und geschieht auch nicht im luftleeren Raum.

Prognostizieren ist ein Instrument, das wir nutzen, um ein bestimmtes Ziel zu erreichen. Einige mögen argumentieren, dass das Ziel der Prognose eine höhere Genauigkeit sei. Dies ist eine heftig umstrittene Position. Meiner Meinung nach ist Prognostizieren nur ein weiteres Werkzeug, das uns dabei hilft, bessere Geschäftsentscheidungen zu treffen, also Entscheidungen, die mehr Geld einbringen. Die Frage ist also, bringt uns FVA, indem es Genauigkeitssteigerungen oder -senkungen misst, näher an das Ziel, mehr Geld zu verdienen? Ich bin nicht überzeugt, und vorerst werde ich drei Kritikpunkte vorbringen, um meinen Standpunkt zu untermauern.

Erstens, auch wenn FVA ursprünglich nicht dafür entwickelt wurde, kollaboratives Forecasting zu erleichtern, bietet FVA von Natur aus einen Rahmen, um den Genauigkeitseffekt von kollaborativem Forecasting zu messen. Das ist wichtig. FVA besagt nicht, dass ihr die besten Prognosepraktiken anwenden solltet. FVA zeigt vielmehr den Genauigkeitseffekt dessen, was immer ihr auch tut. Warum ist das wichtig? Nun, was gilt in der Prognose-Community als beste Praxis?

Seit den 1980er Jahren organisiert Spyros Makridakis eine Reihe öffentlicher forecasting competitions (die M-Wettbewerbe), um diese besten Praktiken zu identifizieren. Seit dem M4 im Jahr 2018 haben diese Wettbewerbe kontinuierlich die Überlegenheit algorithmischer Methoden gezeigt. Tatsächlich schrieb vermutlich der größte lebende Experte, wenn es um menschliche Prognosefähigkeiten geht, Philip Tetlock, dass wann immer ein Prognosealgorithmus verfügbar ist, dieser Algorithmus genutzt werden muss. Der Grund? Der Algorithmus liefert stets eine überlegene Genauigkeit im Vergleich zum menschlichen Urteil. Dieser Algorithmus und natürlich der Experte, der ihn anwendet, stellen die beste Praxis dar.

Wenn also kollaboratives Forecasting und manuelle Übersteuerungen nicht die beste Praxis darstellen – und nachweislich tun sie das nicht –, dann ist es auch keine beste Praxis, wenn Unternehmen diese mit FVA messen, und ich würde sagen, es ist Zeitverschwendung. Manche könnten einwenden: Aber Joannes, FVA befürwortet nicht explizit kollaboratives Forecasting oder manuelle Übersteuerungen. Okay, aber so wird es populär genutzt, selbst in Jeffs Schriften.

Allerdings beruht meine zweite Kritik auf einem grundlegenden Aspekt von FVA, nämlich der time series Perspektive. FVA erfordert klassische time series Prognosen, auch als Punktprognosen bekannt. Mindestens befürwortet FVA die Verwendung einer naiven Prognose, nämlich einer einfachen Kopie des letzten Ist-Werts als Basis zum Vergleich der Prognoseübersteuerungen. Diese unveränderte Prognose ist eine time series. Aber ist eine time series die beste Praxis? Wiederum nein. Punktprognosen sind nicht nur unvollständige Prognosewerkzeuge; sie können gerade in Szenarien mit hoher Varianz völlig irreführend sein. Das liegt daran, dass Punktprognosen die Unsicherheit nicht berücksichtigen.

Tatsächlich beinhaltete der M5-Prognosewettbewerb eine separate Challenge, die Uncertainty Challenge, die sich auf Quantilvorhersagen konzentrierte und an der Lokad auf SKU Ebene teilnahm und gewann. In Wirklichkeit existiert bereits eine viel bessere Klasse von Prognosen, und das sind probabilistic forecasts. Im Gegensatz zu time series prognostizieren probabilistic forecasts nicht nur eine einzelne mögliche Zukunft, etwa die Nachfrage in der kommenden Woche. Stattdessen betrachten wir alle möglichen Zukünfte und ihre jeweiligen Wahrscheinlichkeiten. Warum ist das wichtig? Es ist wichtig, weil die Identifikation aller möglichen Zukunftsszenarien essenziell für die Auswahl der bestmöglichen Entscheidung ist. Dies ist insbesondere dann von Bedeutung, wenn finanzielle Risiken im Spiel sind, was im supply chain Bereich nahezu ständig der Fall ist.

FVA ist jedoch nicht kompatibel mit probabilistic forecasting. Warum? Weil probabilistic forecasting bedeutet, Wahrscheinlichkeitsverteilungen zu betrachten und nicht time series. Und mal ehrlich, Personen im Vertrieb und Marketing werden nicht manuell Wahrscheinlichkeitsverteilungen bearbeiten – mit oder ohne FVA. Das ist schlichtweg nicht gangbar. Wenn time series nicht die beste Praxis darstellen, und das gilt insbesondere im Risikomanagement, dann ist auch die Verwendung von FVA zum Vergleich von Genauigkeitsübersteuerungen nicht die beste Praxis. Ich würde sagen, es ist Zeitverschwendung.

Meine dritte Kritik besteht darin, dass Forecast Value Added nicht den Wert misst, sondern die Genauigkeit. Und fügt Genauigkeit Wert hinzu? Nicht zwangsläufig. Eine genauere Prognose bringt an sich nicht mehr Wert. In vielen realen Situationen führen eine 90% genaue Prognose und eine 60% genaue Prognose zu denselben Bestandsentscheidungen, sofern MOQs oder andere Einschränkungen vorliegen. Wenn sich das finanzielle Ergebnis der Entscheidung nicht ändert, trägt die Messung des Genauigkeitsgewinns nicht zum Geschäftswert bei. Daher ist es aus Unternehmenssicht absolut falsch zu behaupten, dass Genauigkeit an sich Wert schafft. Falls dem so wäre – und das wäre es – wie kann dann die Fokussierung auf Genauigkeit mittels FVA die beste Praxis sein? Ist sie nicht.

Auch wenn ihr FVA persönlich nicht zur Unterstützung von kollaborativem Forecasting verwendet, tun es andere. FVA basiert weiterhin auf time series Prognosen, die die Unsicherheit ignorieren, sowie auf der Annahme, dass eine gesteigerte Genauigkeit einen höheren Wert ergibt – was den Geschäftsanforderungen widerspricht. All dies sind schlechte Praktiken, und daher bin ich der Meinung, dass FVA selbst nicht die beste Praxis sein kann. Sie ist, meines Erachtens, Zeitverschwendung. Danke.

Conor Doherty: Du hast noch 15 Sekunden, Joannes.

Joannes Vermorel: Okay, danke.

Conor Doherty: Nun, vielen Dank, Joannes, für deine einleitenden Worte. Jeff, ich lade dich ein, jetzt deine Eröffnungsbemerkungen zu machen.

Jeff Baker: Ja, großartig. Vielen Dank, Conor. Vielen Dank, Joannes. Ich schätze die Gelegenheit, an diesem Gespräch teilzunehmen, wirklich sehr. Offensichtlich spreche ich mich für die Nutzung von FVA als Best Practice aus. Das kommt daher, dass alle supply chains planen müssen, oder? Wir müssen Entscheidungen weit im Voraus treffen, vielleicht zwei bis drei Monate, um einen Produktionsplan festzulegen, um mit Lieferanten zusammenzuarbeiten – vielleicht sogar sechs Monate im Voraus. Wir benötigen eine gute Prognose, um sicherzustellen, dass, falls wir kleine Kapazitätsänderungen haben, vielleicht personelle Anpassungen oder einen Co-Hersteller, den wir einbinden möchten, diese Entscheidungen über einen langen Zeitraum getroffen werden müssen, und wir kommen letztlich dazu, diese erneut zu überprüfen.

Ich habe ein paar Lieblingszitate in der supply chain. Eines lautet: “The plan is nothing, but planning is everything.” Wir müssen also diesen Plan haben, um uns in die richtige Position zu bringen. Mein zweites Lieblingszitat in der supply chain stammt von Mike Tyson: “Everyone has a plan until they get punched in the face.” Das weist darauf hin, dass wir wissen, dass wir in der supply chain einige Rückschläge einstecken werden. Das Ziel ist es, die bestmögliche Entscheidung mit der größten Erfolgschance im operativen Bereich zu treffen. Der beste Weg dazu ist, unsere fachlichen Experten einzubinden. Vertrieb und Marketing verfügen über lokale Erkenntnisse, die genutzt werden können, um die Prognose zu verbessern, und sollten daher in den Konsensprozess einbezogen werden. Die strukturierte Einbindung dieser Experten liefert uns die besseren Daten, die wir benötigen, um bessere Entscheidungen zu treffen. Und FVA ist ein effektives Werkzeug, um die Wirksamkeit dieser Inputs zu messen.

Nun, der Vorbehalt lautet, ja, man könnte potenziell die Tür für Verzerrungen öffnen, aber aus meiner Perspektive müssen wir daran arbeiten, diese Verzerrungen zu korrigieren, anstatt sie vollständig zu eliminieren. Wir müssen funktionsübergreifend arbeiten. Seit vielen, vielen Jahren predigen wir, dass funktionsübergreifendes Arbeiten der richtige Weg ist. Ich möchte nicht zurück in ein funktionales Silo kehren, in dem jeder nur für seine eigene Entscheidung verantwortlich ist und nicht für die Auswirkungen auf andere. Um dies bestmöglich zu tun, denke ich, dass man gezielte Anpassungen vornehmen muss – hier glänzt FVA. Es liefert mir jene Produkte, die von hohem Wert sind, aber einen hohen Fehler aufweisen. Das ist der fruchtbare Boden, um dort nach besseren Inputs zu suchen.

Wenn ich eine große Wirkung erwarte – sei es ein materiell negativer Effekt oder auch ein positiver Effekt – müssen wir in der Lage sein, dafür zu planen. Also, das Erste ist, dass diese Anpassungen geleitet sein sollten. Die These, die ich für meinen Master-Abschluss verfasst habe, besagte, dass wir die Richtung der Anpassung betrachten müssen: Steigt sie oder fällt sie? Wie prognosebar ist die Zeitreihe von Natur aus? Wie groß ist der Override? Und stellen wir sicher, dass, falls wir Mehrwert schaffen wollen, wir nach einer substantiellen Steigerung suchen – wir nehmen nicht nur kleine Änderungen vor.

Als Nächstes kommt die Struktur. Ich werde niemandem aus Vertrieb oder Marketing erlauben, mir einfach eine willkürliche Zahl zu nennen. Ich werde fragen: Was sind ihre Annahmen als Input? Beruht das auf neuen Daten, die wir noch nicht einmal modelliert haben? Dann werde ich tiefer bohren und fragen: Ist dies ein Best-Case-Szenario? Ein Worst-Case-Szenario? Was ist das wahrscheinlichste Szenario? Was müsste passieren? Was müsste zutreffen, damit sich dieses Szenario in der Zukunft durchsetzt? Auf diese Weise versuchen wir, proaktiv die Ursachen von Verzerrungen auszumerzen und die dahinterliegenden Motivationen zu verstehen.

Sobald wir das getan haben, überprüfen wir im nächsten Monat diese Anpassungen und fragen: “Hat es Mehrwert geschaffen oder nicht?” Was ich gerne sage, ist: Gutes Urteilsvermögen basiert auf Erfahrung. Erfahrung basiert auf schlechtem Urteilsvermögen. So lernen wir aus unseren Fehlern. Wir knüpfen zurück an die Annahmen, wir validieren, und vielleicht finden wir heraus – hey, weißt du was – dass die Vertriebler ständig überprognostizieren, weil sie kein Vertrauen in die supply chain haben. Das ist nicht nur Verzerrung, das ist ein Vertrauensproblem, und das können wir anpacken.

Außerdem sind sie diejenigen, die diese Informationen besser einordnen können als wir. Ich glaube nicht, dass wir einen Supply Chain Scientist haben werden, der in allen Nuancen des Marketings oder aller Nuancen der Prognose Experte ist. Ich werde mich auf diese Experten verlassen und sie nutzen, um mir diese Daten zu liefern. Sollte sich über die Zeit herausstellen, dass diese Inputs wertvoll sind, werde ich versuchen, sie zu automatisieren. Ich habe nichts gegen die Automatisierung, wenn es darum geht, die richtigen Daten zu sammeln. Aber das Problem ist, wir leben nicht in einer Welt mit unendlichen reinen Daten. Wenn es Produktionsdaten, Vertriebsdaten oder Marketingdaten gibt, müssen wir oft proaktiv danach suchen.

Wenn wir das gut machen, können viele dieser Entscheidungen automatisiert werden. Anpassungen sind nicht erforderlich, nur weil wir einen FVA-Prozess in einem Prognosesystem haben. Tatsächlich sollte das Nummer-eins-Mantra der Prognose lauten: “Do no harm.” Kraft Heinz, eines der größten Lebensmittel- und Getränkeunternehmen in Nordamerika, verwendet die Kennzahl “low-touch forecasting percent.” Wie stelle ich sicher, dass ich es nicht jedes Mal anfasse? Ich denke, Deming hat es am besten ausgedrückt: “Don’t just do something, stand there.” Denn er erkannte, dass die natürliche Tendenz eines Menschen darin besteht zu denken: “Sie erwarten von mir einen Input, ich sollte etwas tun, um zu zeigen, dass ich beschäftigt bin.” Nein, das ist völlig der falsche Ansatz.

Wenn wir den Nachweis erbringen wollen, dass Fehlerreduktion wertvoll ist, können wir auf das Institute for Business Forecasting and Planning verweisen. Sie führten eine Umfrage bei acht CPG-Unternehmen durch und fanden heraus, dass eine Reduktion des Prognosefehlers um 1% Unternehmen pro Milliarden-Dollar Umsatz einen Nutzen von 1,7 Millionen Dollar bringt, indem die Kosten der Prognose vermieden werden. Dazu gehört das Vermeiden von Rabatten, Transshipments, veralteten Produkten, Überschussbeständen und der Bindung von Working Capital. Unternehmen senken auch die Kosten des Unterprognostizierens um etwa 1 Million Dollar pro Milliarde Umsatz, indem sie fehlende Verkäufe, Strafgebühren für Case Fill sowie erhöhte Produktions- oder Expressversandkosten vermeiden.

IBF hat dies in ihren Untersuchungen festgestellt. Gartner hat ähnliche Vorteile ermittelt: eine Reduktion des inventory value um 2 bis 7%, ein Rückgang von veraltetem Inventar um 4 bis 9% und eine Senkung der Transportkosten um 3 bis 9%. Das Ausmaß dieser Zahlen macht es attraktiv, Wege zur Verbesserung der Prognosegenauigkeit zu verfolgen – besonders in Bereichen, in denen ein Artikel einen hohen Wert und einen hohen Fehler aufweist oder wenn wir im Voraus wissen, dass externe Ereignisse die supply chain in irgendeiner Weise beeinflussen werden. Danke.

Conor Doherty: Nun, danke, Jeff. Du hast auch noch 15 Sekunden, falls du möchtest.

Jeff Baker: Ich habe 13, aber mir geht’s gut.

Conor Doherty: Richtig. Nun, Jeff, vielen Dank für deine Eröffnungsrede. An dieser Stelle fahren wir mit der Erwiderung fort. Joannes, du hast 5 Minuten, wenn du bereit bist.

Joannes Vermorel: Danke, Jeff, für deine Eröffnungsbemerkungen. Ich denke, du vertrittst deine Position sehr gut, allerdings gibt es ein paar Punkte, die ich klarstellen möchte. Ich stelle nicht die Absicht in Frage, dass die Leute versuchen, etwas Gutes für das Unternehmen zu tun. Ich möchte die Realität des tatsächlichen Ergebnisses in Frage stellen.

Erstens, wenn wir glauben, dass Genauigkeit das Beste ist – etwas, dem es wert ist, nachzujagen –, dann war die Realität, wie ich in meiner ersten Aussage betont habe, dass FVA nicht den Best Practices der Prognose entspricht. Wenn ein Unternehmen wirklich Genauigkeit anstrebt, werden durch den Verzicht auf diese kollaborativen Prognosen tatsächlich präzisere Ergebnisse erzielt. Das ist leider empirisch nachgewiesen worden.

Zweitens, die Overrides selbst sind eine sehr bürokratische Herangehensweise an das Problem. Sobald du einen Mechanismus einführst – ja, Leute mögen sagen “do no harm” – wird ein bürokratischer Mechanismus genutzt. FVA impliziert die Einrichtung einer Mini-Bürokratie oder Mini-Technokratie, in die Softwareelemente einfließen. Es wird Leute geben, die überprüfen, ob diejenigen im Vertrieb und Marketing tatsächlich die Korrekturen vornehmen und alles weitere. Für mich ebnet das den Weg für etwas, das viel bürokratische Arbeitsbelastung erzeugt.

Denn die Realität ist, dass man, wenn man sich anschaut, wie diese Prognosen und Anpassungen aussehen, von Zehntausenden von Zeitreihen spricht, von denen jede etwa 50 Punkte oder mehr hat – beispielsweise wöchentliche Prognosen ein Jahr im Voraus. Aber das führt mich zu einer weiteren Kritik: Indem man sich isoliert auf Genauigkeit konzentriert, glaube ich, dass FVA Geld fehlzuteilt und Unternehmen für weitaus effektivere Wege blind macht, auf denen Menschen zum Prognoseprozess beitragen könnten. Und um ganz klar zu sein: Ich habe nie argumentiert, dass Mitglieder aus Vertrieb, Marketing und Finanzen nicht sinnvoll zum Prognoseprozess beitragen könnten. Mir ist durchaus bewusst, dass jedes relevante Teammitglied wertvolle Informationen im Kopf haben kann, die dem Unternehmen finanziell lohnend sein könnten.

Allerdings stimme ich nicht mit der Idee überein, dass die Leute warten sollten, bis eine Punkt-Prognose erstellt ist, um sie dann mithilfe manueller Overrides zu manipulieren, um die Genauigkeit zu erhöhen. Dies, wie ich bereits sagte, entspricht nicht den Best Practices der Prognose – und doch ist es das, was die Leute üblicherweise mit FVA machen. Es gibt jedoch eine konstruktive Art, Menschen in den Prognoseprozess einzubeziehen: Indem sie zu den Prognosealgorithmen beitragen, die die Prognose erzeugen, und später zu Algorithmen, die Entscheidungen generieren. In der Praxis bedeutet dies, den Prognoseexperten zu unterstützen. Bei Lokad wäre das ein Supply Chain Scientist, der diese Algorithmen durch Fachkenntnis und Einblicke schreibt und verfeinert. Das bedeutet nicht, dass jeder im Vertrieb und Marketing Wahrscheinlichkeitsverteilungen lesen und Skripte in Python schreiben muss. Stattdessen helfen sie, indem sie dem Prognoseexperten umsetzbare Erkenntnisse liefern, die nützlich sein könnten, und der Experte übersetzt diese Erkenntnisse in Codezeilen.

Und schließlich laufen die automatisierten Algorithmen und erstellen die Prognose. Letztlich sind diese Erkenntnisse nur Informationen, die – wie ich zustimme – überall im Unternehmen verteilt werden. Allerdings ist der Prognoseexperte die Person, die weiß, wie man all dies in eine sinnvolle Prognose und ein vernünftiges Set an supply chain Entscheidungen übersetzt. Es können Tonnen exzellenter Daten zur Verfügung stehen, aber es ist der Prognoseexperte – und nur dieser – der entscheiden sollte, wie diese Daten genutzt werden, um eine Prognose zu erstellen oder zu revidieren. Dies wird durch jahrzehntelange experimentelle Prognoseergebnisse als Best Practice unterstützt. Und leider hat FVA in diesem Zusammenhang keinen Platz. Indem Genauigkeit gemessen wird, anstatt direkt zur Verbesserung des Prognosealgorithmus beizutragen, kann man das Netteste sagen, dass FVA eine Ablenkung ist. Ich hingegen würde es als Zeitverschwendung bezeichnen.

Conor Doherty: Joannes, du hast noch 20 Sekunden.

Joannes Vermorel: Mir geht’s gut, danke.

Conor Doherty: Okay, danke. Jeff, in diesem Moment sehe ich, dass du lächelst. Fühle dich frei, mit deiner fünfminütigen Erwiderung zu antworten.

Jeff Baker: Ich glaube, du warst stummgeschaltet, übrigens.

Ja, entschuldige. Nein, interessante Perspektive. Ich möchte auf ein paar Dinge zurückkommen. Erstens, du hast den M5-Wettbewerb und Makridakis erwähnt. Eine Sache, auf die ich hinweisen möchte, ist, dass 92% dieser Leute gegen einen sehr einfachen Exponential-Smoothing-Algorithmus als Benchmark verloren haben. Also gibt es ein Argument für Einfachheit. Ich denke, es gibt einen Unterschied zwischen Best Practice und Bleeding Edge. Ich möchte sicherstellen, dass wir da eine Unterscheidung treffen, denn oft ist Einfachheit tatsächlich besser und wird von denjenigen, die sie nutzen, mehr akzeptiert. Aus der Perspektive der Erklärbarkeit ist es in einem S&OP-Meeting im Rahmen einer Demand-Review viel einfacher zu erklären, wie das zustande kommt, und so mehr Zustimmung zu erhalten.

Das andere, was du erwähnt hast, bezog sich darauf, dass man sich bei Zeitreihen nur auf einen Punkt konzentriert. Es ist jedoch Best Practice, nicht nur die Zeitreihe bereitzustellen, sondern auch anzugeben, wie die Prognoseintervalle aussehen werden, oder? Und das hängt mit der Genauigkeit zusammen. Also ja, eine Best Practice kann die Zeitreihe plus die Information für die Leute umfassen, was die Prognoseintervalle sind. Wir sind uns einig, dass eine Punktprognose ein Stück Information ist. Eine Punktprognose plus die Prognoseintervalle ist wertvoller.

Du hast erwähnt, dass probabilistische Prognosen nicht für FVA geeignet sind. Ich denke, wenn du eine der letzten Ausgaben von Foresight anschaust, wirst du einen Artikel von Stefan De Kok über probabilistische Prognosen und eine Variante davon, stochastic value added, sehen, der meiner Meinung nach den Wert dieses Rahmens unterstreicht. Ich bin etwas agnostisch bezüglich meiner forecasting method. Wie auch immer ich es mache, ich möchte eine Verbesserung erkennen, wenn ich verschiedene Inputs in meine Prognose einbringe. Wie verbessere ich sie? Und zudem sicherstellen, dass wir unsere Ressourcen effizient und effektiv nutzen. Dieser gesamte Zielkonflikt zwischen den Kosten der Ungenauigkeit und den Kosten der Prognoseerstellung ist etwas, das bereits seit 1971 bekannt ist. Es gibt einen Artikel in der Harvard Business Review darüber, wie man das Gleichgewicht zwischen zu viel Zeit für die Prognoseerstellung und der erzielten Genauigkeit findet. Anders ausgedrückt: Lohnt sich der Aufwand? Basierend auf den Zahlen, die ich erarbeite, gibt es für ein vernünftig großes Unternehmen viele Vorteile, und ich kann es mir leisten, ein paar Leute damit zu beschäftigen.

Ich glaube nicht, dass kollaborative Prognosen bürokratisch sind. Ich denke, man muss diese Leute in den Prozess einbinden, damit sie durch das System einen Mehrwert schaffen können. Diese Inputs sind großartig. Es wird immer Ereignisse geben. Supply chains werden nicht weniger komplex, sie werden komplexer, dynamischer – es tritt mehr der Butterfly-Effekt auf. Deshalb brauchen wir Leute, die in der Lage sind, diese Informationen zu kontextualisieren und in dem relevanten Zeitraum die beste Entscheidung zu treffen. Aus dieser Perspektive muss es kollaborativ sein. Wenn ich kollaborativ arbeite, bin ich immer mit Vertrieb und Marketing im Gespräch. Es bedeutet, dass ich nicht versuche, alles auf einmal zu verändern, sondern nur schaue, was sich verändert hat. So erhalte ich diese Inputs und baue eine bessere Beziehung zu ihnen auf.

Das Gegenteil wäre, wenn ich einen ad hoc Prozess hätte, in dem ich Vertrieb und Marketing nach Belieben einbeziehe, wann immer ich es möchte. Ich kann ziemlich garantieren, dass die Qualität der Inputs aus Vertrieb und Marketing erheblich sinkt, wenn sie nicht Teil eines regelmäßig geplanten Prozesses sind. Was ich ständig von Verkäufern höre, ist: “Ich bin zu sehr mit dem Verkaufen beschäftigt, lass mich in Ruhe.” Also, wenn du diesen Input erhalten möchtest, musst du sie in den Prozess einbeziehen.

Sie erwähnten die Kluft zum tatsächlichen Geschäftswert. Man kann keine guten Entscheidungen mit schlechten Daten treffen. Das Argument lautet: Ich brauche diese bessere Prognose. Es gibt kein Argument für einen Rückgang der Prognosegenauigkeit. Ich muss sicherstellen, dass ich die besten verfügbaren Daten für die Entscheidungsfindung verwende. Wird das direkt an einen ROI gekoppelt? Kann ich den ROI einer einzelnen Entscheidung isoliert für die gesamte supply chain berechnen? Das wird nicht passieren. Ich würde liebend gerne sagen, dass es so ist, aber meine Entscheidung aus prognostischer Sicht ist völlig getrennt von den funktionalen Entscheidungen, die in der Fertigung, im Einkauf, in der Lagerhaltung, im Transport usw. getroffen werden. Jegliche dieser Dinge kann zu einem schlechten ROI führen. Meine Aufgabe ist es, so genau wie möglich zu sein. Vielen Dank.

Conor Doherty: Vielen Dank, Jeff. Entschuldige, dass ich direkt ins letzte Wort geredet habe, aber ich musste dich eben daran erinnern.

Jeff Baker: Kein Problem.

Conor Doherty: An dieser Stelle, danke, Jeff. Ich wende mich nun an Joannes. Bitte, deine abschließenden Bemerkungen, zwei Minuten.

Joannes Vermorel: Meine Damen und Herren, das Thema der Debatte lautete: “Ist FVA Best Practice oder reine Zeitverschwendung?” Im Verlauf dieser Debatte haben Sie viele Informationen gehört, aber bitte beachten Sie ein paar Dinge, wenn Sie sich eine Meinung zu FVA bilden. Erstens: Wenn Sie FVA als Teil eines laufenden, kollaborativen Forecasting-Prozesses verwenden, verstanden als Mikromanagement der Forecast-Punkte, ist das keine Best Practice. Das manuelle Überschreiben der Prognose ist in der Forecasting-Community ohne Zweifel keine Best Practice, und dementsprechend ist auch die Messung mit FVA keine Best Practice.

Nummer zwei: FVA basiert auf Zeitreihenprognosen. Ich bin sicher, dass irgendwo jemand versucht, es auf probabilistische Prognosen anzuwenden, aber seien wir ehrlich. FVA funktioniert nur in großem Maßstab, falls es überhaupt in Kombination mit klassischen Zeitreihenprognosen funktioniert, bei denen die Unsicherheit völlig ignoriert wird. Diese sind keine Best Practice, und somit ist auch die Genauigkeitsmessung mit FVA keine Best Practice.

Nummer drei: Per Design geht FVA davon aus, dass eine gesteigerte Genauigkeit etwas Wertvolles ist. Dies ist jedoch nicht der Fall. Im Gegensatz zu dem, was gesagt wurde, gibt es Fälle, in denen eine höhere Genauigkeit Ihrem Geschäft tatsächlich schaden kann. Wir haben ein sehr einfaches Beispiel: Beim Forecasting seltener Zeitreihen ist null sehr häufig die genaueste Prognose, auch wenn es keinen Sinn macht, null Nachfrage zu prognostizieren. Somit ist dies – selbst wenn Sie mit all diesen Elementen des Forecastings und der supply chain nicht übereinstimmen – eines klar: FVA kann aus all diesen Gründen und mehr nicht als Best Practice betrachtet werden. Wenn doch, wäre das ein sehr trauriger Affront gegen die Forecasting-Community.

Conor Doherty: Vielen Dank, Joannes. Jeff, ich wende mich an dich. Deine abschließenden Bemerkungen bitte, zwei Minuten.

Jeff Baker: Okay, großartig, vielen Dank. Nochmals, wie ich zu Beginn sagte: Bessere Planung führt zu besseren Entscheidungen. Wir müssen lernen zu planen, wir müssen lernen neu zu planen, und wir müssen sicherstellen, dass wir eine genaue Prognose als Grundlage haben. Ich glaube nicht, dass es einen überzeugenden Business Case gibt, dass schlechte Daten immer zu besseren Entscheidungen führen. Wenn Sie schlechte Daten haben und gute Entscheidungen treffen, nenne ich das blindes Glück. Das passiert nicht sehr oft. Wo FVA glänzt – und nochmals, ich plädiere nicht für Mikromanagement, ich plädiere nicht dafür, alles zu überschreiben – gibt es Beispiele, in denen wir Artikel haben, die einen hohen Wert haben und einen hohen Fehler aufweisen. Wir wissen, dass externe Ereignisse eintreten können, die nicht auf einen ordentlichen algorithmischen Input reduziert werden können. Wir müssen diese verstehen, wir müssen auf dem notwendigen Zeithorizont dafür planen. Jegliche Kritik an FVA basiert weitgehend auf einem Missverständnis dessen, wofür FVA eigentlich gedacht ist.

Ich kenne Lokad, Sie verkaufen Softwarepakete. In früheren Tätigkeiten war ich in einem Softwareunternehmen tätig, und ich habe auch Softwarepakete implementiert. Ich weiß, dass das Werkzeug funktioniert. Oft liegt das Problem in der Implementierung. Wenn der Kunde nicht bekommt, was er will, handelt es sich in neun von zehn Fällen um ein Implementierungsproblem. Implementierung und ein Datenproblem. Jegliche Kritik an FVA rührt daher, dass man nicht weiß, wie man es korrekt implementiert, nicht versteht, wie es funktioniert und wie es Mehrwert bietet. Ich gebe Ihnen noch eine einfache Analogie: Wenn ich ein Deck auf der Rückseite meines Hauses baue und gehört habe, dass ich die Bretter in die Balken schrauben soll und ich einen Hammer benutze, um mit Holzschrauben einzuschlagen, wird es nicht funktionieren und ich werde nicht glücklich sein. Das bedeutet nicht, dass etwas mit dem Hammer falsch ist; es bedeutet, dass ich einfach nicht weiß, wie man den Hammer richtig benutzt. Ich benutze das falsche Werkzeug für die Aufgabe.

Conor Doherty: Vielen Dank. Entschuldige, dass ich Sie unterbreche, aber ich muss streng auf die Zeiten achten, um Unparteilichkeit zu wahren. Vielen Dank, meine Herren. Vielen Dank für Ihre vorbereiteten Bemerkungen, Ihre Argumentation und Ihre Leidenschaft. An dieser Stelle möchte ich zu einigen Nachfolgefragen übergehen. Einige Fragen sind bereits hereingekommen. Ich habe mir Notizen zu den angesprochenen Punkten gemacht. Bevor wir zu den Fragen aus dem Publikum übergehen, möchte ich, weil ich hier sitze und zuhöre, ein paar der angesprochenen Punkte klären.

Ich werde anfangen, ich denke, tatsächlich, ich werde Joannes ein wenig herausfordern, um Unparteilichkeit zu zeigen. Ich werde Joannes herausfordern. Also, Jeff, in deinem Widerspruch hast du das Sprichwort “simpler is better” erwähnt. Ich glaube, du hast die M5-Ergebnisse erwähnt und darauf hingewiesen, dass etwas nicht zwangsläufig besser ist, nur weil es anspruchsvoll oder hochmodern ist. Also, Joannes, was ist deine Antwort auf das Konzept, dass probabilistisches Forecasting, rein algorithmische Modellierung, einfach zu ausgefallen ist? Es sollte simpel sein.

Joannes Vermorel: Tatsache ist, dass wir auf SKU-Ebene den M5-Wettbewerb mit einem parametrischen Modell gewonnen haben, das etwa fünf Parameter hat. Das war’s. Also, nochmals: Algorithmisch bedeutet nicht automatisch besser. Tatsächlich zeigt Tetlock in seinem Buch “Superforecasting”, dass ein gleitender Durchschnitt 99 % der Menschen im Forecasting schlagen wird. Menschen sehen überall Muster; sie haben ein enormes kognitives Problem. Es ist äußerst schwierig, mit Rauschen umzugehen, sodass man überall Muster erkennt, und das ist schlichtweg schlecht für Forecasting. Übrigens ist es so, dass artificial intelligence – wie ein gleitender Durchschnitt – tatsächlich in den allermeisten Fällen das menschliche Gehirn schlägt. Das war nur ein Punkt. Insbesondere die probabilistischen Forecasting-Algorithmen von Lokad sind nicht von Natur aus sehr ausgefallen. Sie haben lediglich eine merkwürdige Form, aber sie sind nicht super fancy im Sinne von deep learning und dergleichen.

Conor Doherty: Jeff, wie klingt das für dich? Gibt es etwas, woran du etwas auszusetzen hast?

Jeff Baker: Die einzige Herausforderung, die ich hätte, und ich bin ganz dafür, die neuesten Daten und Technologien einzubringen – nochmals, ich war in einem Softwareunternehmen, wir haben Technologie verkauft – ist, dass wir Dinge manchmal nicht überkomplizieren müssen. Vielleicht ist es besser, aber wir müssen sicherstellen, dass wir den inkrementellen Mehrwert für alles, was wir tun, bekommen. Außerdem ist die Erklärbarkeit von entscheidender Bedeutung.

Für uns hier im Raum, alle, die daran interessiert sind, das anzusehen, gilt: Wir sind alle an probabilistischem Forecasting und Daten interessiert. Wenn es an die Implementierung geht und ich versuche, irgendeine algorithmische Prognose zu verkaufen, die unter Erklärbarkeitsproblemen leidet, kann es zu Rückmeldungen kommen, weil Menschen naturgemäß eine Abneigung gegenüber Algorithmen haben. Sie werden sich gegen Dinge wehren, die sie nicht verstehen. Viele dieser Forecasting-Techniken, die einfacheren, sind relativ leicht zu erklären. Daher sage ich, dass manchmal die einfacheren Ansätze, in Bezug auf die Leistung, genauso gut funktionieren. Einfache Ensemble-Prognosen schlagen 92 % derjenigen, die im M5-Wettbewerb um Ruhm und Reichtum kämpfen. Da steckt ein gewisser Wert drin.

Ich würde auch sagen, dass man keine einzelne Organisation überlasten sollte. Einige Organisationen haben ein Reifegradniveau, das wir anheben müssen. Für viele von ihnen ist es großartig, wenn ich sie dazu bringen kann, exponentielle Glättungsprognosen zu verwenden. Ensembles, großartig. Über die Vorhersageintervalle zu sprechen, fantastisch. Kein Problem mit den ausgefalleneren, anspruchsvolleren Algorithmen. Wir müssen nur sicherstellen, dass wir sie entsprechend ihrer Fähigkeit, diese Technologie zu verarbeiten und zu akzeptieren, fördern. Andernfalls laufen wir Gefahr – und dieses Problem hatte ich schon einmal – Mischformen von linearen Programmen bei Unternehmen zu verwenden, und wenn sie es nicht verstehen, würden sie es nicht akzeptieren. Darauf achte ich, wenn wir anspruchsvollere Algorithmen vorantreiben.

Conor Doherty: Joannes, möchtest du da noch etwas hinzufügen?

Joannes Vermorel: Nochmals, ich denke, es gibt hier ein leichtes Missverständnis, denn was ich sagen möchte, ist, dass, wenn wir probabilistisches Forecasting betreiben, die Methoden selbst ziemlich einfach sind. Jegliche Komplexität dient nur dazu, die Faktoren genau zu berücksichtigen. Unsere Alternative zu FVA besteht darin zu sagen, dass, wenn Leute Informationen haben und sich melden, diese als Faktoren berücksichtigt werden. Die Prognose selbst wird diese zusätzlichen Informationen als Input nutzen, nicht als Überschreibung des Outputs.

Das hat viele positive Konsequenzen, beispielsweise dass, wenn Sie die Prognose aktualisieren, die Leute die Überschreibung nicht aktualisieren müssen. Das Problem ist, dass die Leute es als eine Überschreibung, als etwas Statistisches betrachten. Aber wenn Sie die Prognose überschreiben, was machen Sie, wenn es nächste Woche neue Informationen gibt und sich Ihre Basislinie gerade verschoben hat? Was tun Sie? Wenden Sie dieselbe Überschreibung, denselben Delta im Vergleich zu dem, was Sie vorher hatten, erneut an? Es gibt eine Menge Komplikationen, die einfach daraus resultieren, dass das Marketing Informationen in Form einer Prognoseüberschreibung bereitstellt. Es ist viel einfacher zu sagen: “Marketing, sag uns, dass wir dieses Produkt mit so viel Werbeausgaben bewerben werden”, und dann berücksichtigen Sie das als Input in Ihrer Prognose. Sie können sogar einen Backtest durchführen, um zu sehen, ob es die Genauigkeit erhöht hat oder nicht. Dieser Backtest kann sofort durchgeführt werden; Sie müssen nicht drei Monate warten, um zu sehen, ob Ihre manuelle Korrektur etwas Positives erbracht hat oder nicht.

Conor Doherty: Wenn ich kurz etwas anmerken darf, da du etwas angesprochen hast, das ich auch Jeff sagen wollte. In Bezug auf “simpler is better”, aufbauend auf dem, was du gerade gesagt hast: Wäre es theoretisch nicht einfacher für einen Experten, andere Experten zu interviewen, Einsichten zu gewinnen und diese dann in eine algorithmische Entscheidung umzusetzen, als wenn alle, einschließlich Nicht-Experten, eine Prognose berühren? In puncto Einfachheit, was sind deine Gedanken dazu? Sind sie gleich einfach, oder ist das eine komplexer als das andere?

Jeff Baker: Typischerweise habe ich FVA im Sales and Operations Planning-Prozess verwendet, in der Nachfrageüberprüfung, bei der Betrachtung des Zeithorizonts von drei Monaten. Wir haben den aktuellen Monat, den aktuellen Monat plus eins, zwei. Typischerweise ist das bei vielen CPG-Unternehmen, vielen Unternehmen, sozusagen der gefrorene Zeitplan. Genau da beginnt der Übergang zwischen Planung und Ausführung, also zwischen S&OP und S&OE.

Wenn wir uns in diesem S&OP-Bereich befinden, betrachten wir einige dieser Ereignisse, einige der Treiber. Was wir dort tun, ist, wenn wir es auf aggregierter Ebene machen, sammeln wir Inputs. Wenn es um Inputs auf Ebene von Produktfamilien geht, können Sie diese übergeordneten Treiber nach unten propagieren. Sie können einige dieser Entscheidungen disaggregieren, was eine gängige Praxis ist – eine übergeordnete Zahl nehmen und sie in die Details zerlegen.

Auf der Ausführungsseite, falls ein bedeutendes Ereignis eintrifft, können Sie dies auch auf Familien- oder Unternehmensebene tun, je nach Ausmaß der Auswirkungen. Ich denke, das ist einfacher. Ich plädiere nicht unbedingt dafür, jede einzelne SKU anzupassen, da, wie Sie bereits erwähnt haben, das sehr aufwendig sein kann. Aber wenn es enorme Auswirkungen gibt, müssen wir diese Anpassungen vornehmen.

In dieser Planung, in dieser Neuprogrammierung, zurück zum Plan zu gehen, ist nichts; Planung ist alles. Dieses Konzept der Neuprogrammierung, des Überdenkens, wenn wir das im S&OP-Prozess einmal im Monat machen, haben wir alle Entscheidungsträger im Raum. Wir machen es einmal im Monat, und wir fangen auch an, uns darauf zu konzentrieren, was bereits im Modell ist, welche neuen Informationen vorliegen und wie wir diese neuen Informationen einbeziehen. Tatsächlich war einer der Momente, in denen ich bei einem Demand Review Meeting fast aufgestanden und gejubelt hätte, als der Verkaufsleiter, der VP, im Raum war und sagte: “Okay, welche neuen Informationen wissen wir darüber?” Keine neuen Informationen. “Okay, die statistische Prognose, die algorithmische Prognose bleibt bestehen”, und das war’s. Da gab es nicht viel Bürokratie.

Ich denke, das ist die ideale Vorgehensweise, sofern es nicht einige wirklich große Ereignisse gibt, von denen wir wissen. Aber wenn Sie der Supply Chain Scientist sind, müssen Sie proaktiv nach diesen Inputs suchen. Während aus meiner vorgeschlagenen Vorgehensweise der Vertrieb und das Marketing zu den Meetings kommen, in dem Wissen, dass sie mir mitteilen müssen, was neu ist, was sich geändert hat, was in den Annahmen des letzten Monats nicht enthalten war, versuchen wir, das so schnell wie möglich zu gestalten. Für ein großes CPG-Unternehmen kann man das auf Familienebene ziemlich schnell durchgehen.

Conor Doherty: Danke, Jeff. Joannes, möchtest du noch etwas hinzufügen?

Joannes Vermorel: Nicht allzu viel, aber um es kurz zu halten: Der Grund, warum wir wirklich dafür plädieren, dass der Experte die Informationen aufnimmt, anstatt die Prognose zu justieren, liegt darin, dass die Informationen fast immer in Bezug auf die Granularität nicht mit dem Geschäftsbereich des Unternehmens übereinstimmen. Man hört: “Oh, wir haben diesen Wettbewerber, der bankrottgeht.” Es gibt keine klare Überschneidung zwischen diesem Wettbewerber und genau dem, was er tut. Es ist kein Eins-zu-eins-Verhältnis. Es gibt ein umfangreiches Problem, nämlich Kategorie für Kategorie, welche Produkte betroffen sind.

Die Vorstellung, dass Informationen in den Kopf einer Person aus dem Vertrieb oder Marketing oder dergleichen gelangen und dass dann “diese Information eine passende Zeitreihe zum Überschreiben finden kann”, ist fast nie der Fall. Alleinstens herauszufinden, was genau relevant ist, ist schwierig. Was ist mit all den anderen Unsicherheitsquellen? Wenn Lokad ein Unternehmen mit prädiktiven Modellen betreibt, haben wir locker ein halbes Dutzend prädiktive Modelle – eines für die Nachfrage, ja, aber auch für die Durchlaufzeiten, Produktionsausbeuten, zukünftige Preise der Lieferanten, die Erwartung von Volatilität der Preise von Wettbewerbern usw.

Wenn Sie sagen, dass FVA auch dieses Problem der Impedanzanpassung zwischen der Granularität der Informationen, die Sie haben, und der Zeitreihe hat, dann stellt es einfach die Nachfrage auf ein Podest, während es etliche andere Unsicherheiten gibt, die prognostiziert werden müssen. Es gibt auch Informationen wie: “Okay, dieser Lieferant gerät völlig außer Kontrolle, die Durchlaufzeiten werden explodieren.” Das sollte im Algorithmus für die Durchlaufzeitsprognose berücksichtigt werden.

Jeff Baker: Ja, da hab ich keinen Einwand, was deine Aussage betrifft, dass es Dinge gibt, die wir im supply chain betrachten müssen. In keiner Weise empfehle ich, dass wir uns ausschließlich auf FVA konzentrieren und dabei vergessen, auf Lieferanten-Vorlaufzeiten oder Ähnliches zu achten. Das ist nicht korrekt. Wir müssen uns darauf konzentrieren, was die Nachfrage ist – aus effizienter Sicht: Was ist meine optimale Nachfrage, oder?

Und ich muss auch all die anderen Dinge über meine Versorgungsseite wissen. Wir müssen beides machen, richtig? Und ja, ich stimme vollkommen zu. Wir brauchen Lieferzeiten, Lieferzeitvariationen, wir müssen die Fertigung verstehen – wann diese eventuell ausfallen könnte – sowie die Lieferantenpreise; all das müssen wir ebenfalls wissen. Also habe ich da keinen Einwand. Mein einziger Einwand ist, dass ich nicht sage, man solle sich auf FVA konzentrieren und dabei diese anderen Dinge außer Acht lassen.

Conor Doherty: Nun, wir haben noch weitere Fragen aus dem Publikum, auf die ich eingehen werde. Es wurde nur noch ein letzter Punkt angesprochen, den ich zur Sprache bringen möchte. Zuerst habe ich versucht, es rechtfurchtig zusammenzufassen, Jeff – bestätige mir bitte, ob ich es fair wiedergegeben habe. Aber dann möchte ich dich, Joannes, dazu drängen. Jeff, in deinen abschließenden Bemerkungen hast du die Behauptung aufgestellt, dass es Elemente gibt, die sich nicht auf einen Algorithmus reduzieren lassen. Ist das eine faire Zusammenfassung dessen, was du gesagt hast? Es gibt gewisse Elemente – ich denke, es war die geringe Vorhersagbarkeit –, für die man nicht einfach auf eine algorithmische Lösung vertrauen kann.

Jeff Baker: Ja, und es gibt Ereignisse, die – weißt du – eher damit zusammenhängen, dass Ereignisse nicht wiederholbar sind.

Conor Doherty: Und daraus folgt, dass sie einen manuellen Override, also manuelle Eingaben, erfordern.

Jeff Baker: Es geht um eine gewisse Kontextualisierung der Tatsache, dass ein Ereignis vorliegt. Ich habe nichts, womit ich es modellieren könnte, also muss ich eine Entscheidung treffen. Ich werde einen Experten hinzuziehen, der mir dabei hilft.

Conor Doherty: Joannes, was hältst du davon? Ich war nämlich sehr gespannt darauf, deine Meinung dazu zu hören.

Joannes Vermorel: Genau dort erwähnte ich in meiner Argumentation den Experten Philip Tetlock. Er hat tatsächlich ein Buch namens “Superforecasting” geschrieben und die menschlichen Vorhersagefähigkeiten im Rahmen eines über ein Jahrzehnt laufenden Projekts, dem Good Judgment Project, bewertet. Es wurde von IARPA finanziert, dem nachrichtendienstlichen Pendant der US-DARPA.

Was sie herausfanden, war, dass die Menschen, die in dieser intuitiven Art der Vorhersage – also bei Dingen, für die man kein algorithmisches Rezept hat – gute Prognosen abgaben, sofort zu dem Schluss kamen: Wenn ein algorithmisches Rezept verfügbar ist, ist es besser. Gibt es keines, dann heißt es: Zurück zu Menschen und hochrangigen Einschätzungen. Aber was sie abschließend feststellten – und das ist eine der Schlussfolgerungen des Buches – ist, dass die Superforecaster, also Menschen, die durchweg überlegene Vorhersagegenauigkeit erzielen, in der Tat maßgeschneiderte Mikro-Algorithmen für den jeweiligen Fall entwickeln. Das ist buchstäblich alles. Und wenn Menschen dazu in der Lage sind, verbessert sich ihre Genauigkeit enorm. Wir sprechen hier von einer Genauigkeitssteigerung um etwa 30 %, selbst bei Dingen, die extrem schwer einzuschätzen sind, wie etwa die Frage, ob der ehemalige Präsident Syriens in den nächsten fünf Jahren wieder an die Macht kommen wird – eine Frage, die äußerst schwierig zu beantworten ist.

Also, das Fazit lautet: Wenn wir zu diesen Schlüssen zurückkehren, dann unterstützt es erneut die Idee, dass es nicht die Person ist, die über die Information verfügt, die gleichzeitig dafür verantwortlich sein sollte, diese Information in eine quantitative Aussage über die Prognose des Unternehmens umzusetzen. Genau das meine ich. Und deshalb glaube ich, dass FVA und die Praxis der manuellen Overrides es falsch angehen, denn unser Ansatz bei Lokad ist, dass uns jemand die Rohinformation liefert, und wenn wir ein Element haben, das plötzlich auftaucht, müssen wir sozusagen ein kleines numerisches Rezept erfinden, das es in eine Zahl umwandelt.

Und das Interessante daran ist, dass man es nicht nur erfinden muss, sondern dass man es auch dokumentieren muss. Man muss erklären, was die Logik war – selbst wenn es nur drei Sätze sind, die sagen: “Okay, ich mache dies, multipliziere das mit jenem, wende ein Verhältnis und einen Abschlag an” – also etwas ganz Einfaches wie ein Kochrezept. Nochmals: Wenn wir zu “Superforecasting” zurückkehren, dann ist das genau die Vorgehensweise der Superforecaster – also der Leute, die ohne Algorithmen überlegene Vorhersageergebnisse erzielen. Sie verfügen über ein explizites numerisches Rezept, das ihren Prozess verbesserbar macht. Es geht also nicht nur um Information, sondern man braucht einen Prozess, der wiederholbar und verbesserbar ist, wie man diese Einsichten in Zahlen umsetzt. Das sollte nicht wie Magie im Kopf der Leute sein.

Jeff Baker: Nein, ich stimme vollkommen zu. Wir haben Leute, die dokumentieren, was unsere Annahmen sind. Eine Erweiterung davon: Wenn man ein Large Language Model AI für das Sales-Team oder das Marketing einsetzen könnte, wäre das fantastisch. Denn das ist einer der Biases – man fragt die Leute, versucht, ihre Inputs zu erhalten, und manchmal erinnern sie sich an etwas, manchmal nicht. Oft gehen wir die Daten durch und fragen: “Okay, wann haben wir diese Preiserhöhung vorgenommen? Oh, es ist bald ein Jahr her – vielleicht ist der erste Schub durch die Preiserhöhung inzwischen abgeflaut.” Ich bin voll dafür, das zu automatisieren, wenn es möglich ist. Man muss dieses Gespräch mit den Leuten führen und damit anfangen, diese Informationen zu sammeln. Es muss für sie zur Lebensweise werden, denn in vielen Unternehmen gibt es gerade all diese Fälle. Also denke ich, ja, man sollte diesen Weg beschreiten.

Conor Doherty: Richtig, nun werde ich zu einigen der Fragen aus dem Publikum übergehen. Ich glaube, ich habe dich letztes Mal zuerst gefragt, Jeff – das gilt für euch beide, aber ich wende mich zunächst an dich. Das ist von Nicholas: Wie kann man eine Situation meistern, in der zu viele Informationen hereinkommen und statistische Modelle dazu zwingen, häufig verändert zu werden – selbst wenn ein S&OP vorhanden ist? Wie kann der Druck von Marketing- und Finanzteams effektiv ausbalanciert werden?

Jeff Baker: Die Frage ist also, ob es viele verschiedene Informationen aus Sales und Marketing gibt?

Conor Doherty: Ja, im Grunde: Wenn eine Welle von Informationen hereinkommt, wie handhabt man das – besonders wenn diese dazu führt, dass die statistischen Modelle ziemlich häufig geändert werden, beispielsweise mit vielen Overrides (obwohl ich diesen Einschub selbst hinzugefügt habe).

Jeff Baker: Okay, also wird das statistische Modell selbst nicht verändert. Wir sprechen also von einem statistischen Prognosemodell basierend auf Zeitreihen, und dann von Overrides aus Sales und Marketing, so wie ich das verstehe. Wir sprechen nicht von …

Conor Doherty: Entschuldigung, momentan ist Nicholas nicht bei mir.

Jeff Baker: In diesem Fall muss man eine Entscheidung abhängig vom Zeithorizont treffen. Wenn ich also beispielsweise drei Monate im Voraus planen muss, um meinen Fertigungsplan und die Auftragsreihenfolge im Rahmen der begrenzten Kapazitätsplanung festzulegen, dann müssen wir sicherstellen, dass keine neuen Informationen in letzter Minute eingehen. Ein weiterer Punkt aus der Fertigungsseite, für den ich ein großer Befürworter bin, sind Verstöße gegen die frozen time fence, um das Sales-Team zu schulen. Überraschungen im laufenden Monat und im Folgemonat sind nicht erwünscht. Und das ist eine kulturelle Sache, oder? So würde ich das angehen. Ich erinnere mich an einen Fall, in dem ein Vertriebsmitarbeiter hereinkam und sagte: “Hey, wir haben diesen riesigen Verkauf”, und er hat bis zur letzten Minute gewartet, um es der Fertigung mitzuteilen. Das ist kein guter Deal, denn das hat uns eine Menge Geld gekostet.

Also, diese Idee der frozen time fence – dass du in diesem Zeitrahmen die Entscheidung treffen musst, die deine beste Entscheidung sein muss, und dass wir auf dieser Grundlage planen und uns nicht überraschen lassen – ist der Weg, wie ich mit einer solchen Informationswelle umgehen würde. Tatsächlich ist einer der S&OP-Metriken, die ich liebe, der Verstoß gegen die frozen time fence: Wie oft müssen wir unsere Fertigungsmitarbeiter umdisponieren, nur weil jemand bis zur letzten Minute gewartet hat, um uns mitzuteilen, dass es einen neuen Verkauf gibt?

Conor Doherty: Danke, Jeff. Joannes, hast du dazu noch Anmerkungen? Fühle dich auch frei, in deine Antwort einzubringen, wie ein Experte unter deinem Konzept mit einer Flut plötzlicher Einsichten von vielen verschiedenen Personen umgehen würde.

Joannes Vermorel: Zunächst einmal ist der Ansatz von Lokad, dass wir alles automatisieren. Für uns ist es genau eine solche Situation, in der man zunächst die Kapazitäten dafür haben muss. Und sieh mal, das ist das Interessante an der vollständigen Automatisierung: Per Definition hat der Supply Chain Scientist – sobald etwas automatisiert ist – deutlich mehr Kapazitäten, um außergewöhnliche Situationen zu meistern. Das ist typischerweise nicht der Fall, wenn die Menschen bereits ihre ganze Zeit mit Routineaufgaben verplant sind. Das ist also der erste Punkt.

Der zweite Punkt ist, dass die Instabilität der Vorhersage eine Eigenschaft klassischer Zeitreihenprognosen – also Punktprognosen – ist. Wenn du also ein wenig Information hinzufügst, springt das Ergebnis einfach auf und ab, weil – basierend auf deiner Genauigkeitsmetrik – dies das ist, was du tun solltest, um super reaktiv und so genau wie möglich zu sein. Sehr häufig gibt es diesen Zielkonflikt: Willst du sehr genau sein, musst du Veränderungen sehr schnell erfassen, was die Prognose sprunghaft macht. Entscheidest du dich hingegen für probabilistische Vorhersagen, tendiert das dazu, das Sprunghafte zu eliminieren, weil du bereits eine Wahrscheinlichkeitsverteilung hast, die gewissermaßen diffus ist. Selbst wenn du einen Ausreißer beobachtest, bleibt diese diffuse Wahrscheinlichkeitsverteilung erhalten. Es gibt keinen großen Sprung in der Verteilung der Masse der Wahrscheinlichkeitsverteilung.

Außerdem besteht das Problem der Sprunghaftigkeit der Prognose – selbst wenn wir Punktprognosen verwenden, die radikal verändert werden können – darin, dass, wie ich bereits sagte, Menschen Sprünge in der Prognose nicht mögen. Der Grund dafür liegt darin, dass Vorhersagen erneut manuell bearbeitet werden – mit manuellen Overrides, manuellen Überarbeitungen und Ähnlichem. So macht Lokad das nicht. Unsere Prognose ist automatisiert, ebenso die Entscheidungen. Wenn sich also die Prognose ändert, spiegeln die Entscheidungen automatisch und sofort den neuen Zustand wider – wobei berücksichtigt wird, dass man finanziell an einen bestimmten Handlungsverlauf gebunden sein könnte. Ja, die Nachfrage hat sich geändert, aber du hast bereits Inventar produziert. Selbst wenn die Nachfrage also nicht deinen Erwartungen entspricht, musst du dieses Inventar irgendwie abbauen, verkaufen. So siehst du, Automatisierung rationalisiert und beseitigt weitgehend die Probleme, einen Rhythmus dafür festzulegen, wann Informationen hinzugefügt werden. Informationen können hinzugefügt werden, sobald sie verfügbar sind, und werden dann sofort berücksichtigt.

Jeff sprach über Kultur. Das Interessante daran ist, dass die Menschen sofort dafür belohnt werden, wenn sie Informationen einbringen – buchstäblich an dem Tag, an dem sie ihre Informationen hinzufügen, werden diese validiert. Am nächsten Tag werden sämtliche Produktionspläne gesteuert. Produktionspläne, Inventarallokation, Versand, Bestellungen – alles spiegelt augenblicklich die Information wider, die erst gestern geliefert wurde. So entsteht für die Menschen ein greifbarer Anreiz, Informationen frühzeitig einzubringen. Sie erkennen, dass, wenn sie Informationen liefern, diese fast innerhalb weniger Stunden in jeder einzelnen Entscheidung auf allen Ebenen berücksichtigt werden. Auf diese Weise wird es sehr greifbar – anstatt ihnen zu sagen: “Komm nächsten Monat wieder, dann schauen wir uns deine Angelegenheiten an.”

Conor Doherty: Danke, Joannes. Jeff, ich möchte unbedingt auch deine Gedanken zu diesem letzten Teil hören, denn ich konnte es dir ins Gesicht lesen – es hat zumindest ein wenig Resonanz gefunden.

Jeff Baker: Ja, ja. Für mich klingt das nach einem Rezept für einen bullwhip effect, oder? Du sagst, dass jede noch so kleine Information, die ich einbringe – ich schätze hierbei die Reaktionsfähigkeit und die technische Möglichkeit, sofort zu erkennen, was die beste Entscheidung ist –, die Herausforderung darin besteht, dass wir bereits viele dieser Entscheidungen getroffen haben. Wenn ich meinen Zeitplan gemacht habe und, sagen wir, Haferbrei koche – zuerst normalen Haferbrei, dann Haferbrei mit Zimt, Haferbrei mit Zimt und Apfel und schließlich Haferbrei mit Zimt, Apfel und Walnuss – dann entsteht plötzlich ein Problem, zum Beispiel, wenn ich auf eine Allergie stoße. Die Umrüstkosten zwischen den Varianten sind enorm. Wenn du jetzt eingreifst und ich diesen Zeitplan sofort unterbrechen muss, entstehen riesige – oder potenziell sehr hohe – finanzielle Kosten. Muss ich plötzlich mehr von einem Rohmaterial nachbestellen als geplant, verursacht das einen bullwhip effect bei meinem Lieferanten.

So, es gibt also einige Vorteile in der Stabilität. Tatsächlich wird viel darüber diskutiert, ob es überhaupt eine wertvolle und stabile Prognose geben kann – nicht unbedingt die genaueste, aber eine, die sowohl genau als auch stabil ist –, denn Stabilität bringt im supply chain gewisse Vorteile mit sich. Ich meine, das ist ein Forschungsbereich, in den wir gerade erst einsteigen, aber es zeigt, dass viele dieser Entscheidungen getroffen werden müssen. Wir haben sozusagen einen Pfahl in den Boden gesetzt, und alle werden lachen, wenn ich sage: “Eine frozen forecast.” Mann, sie ist eigentlich gar nicht eingefroren. Okay, wir wissen alle, dass sie nicht eingefroren ist, aber es gibt finanzielle Konsequenzen, wenn man Entscheidungen ändert.

Also, auch wenn es technisch gesehen großartig ist, wenn wir widerspiegeln können: “Hey, jetzt ist das die beste Entscheidung”, müssen wir bedenken, dass, wenn wir uns aufgrund von allem, was hereinkommt, ständig ändern, damit Kosten verbunden sein werden. Das mag für manche supply chains vollkommen in Ordnung sein. Wenn ich eine reaktionsfähige supply chain habe, passt das vielleicht. Vielleicht ist das die Welt, in der wir leben. Aber wenn wir eine effiziente supply chain haben, bei der Änderungen teuer und schwierig umzusetzen sind, dann sehe ich hier ein Problem.

Joannes Vermorel: Ich verstehe. Bei Lokad modellieren wir natürlich die Kosten von Veränderungen. Jede Ressourcenallokation, die von dem abweicht, was zuvor festgelegt wurde, berücksichtigen wir in den Kosten – das ist super basic. Die Sache gerät also nicht aus dem Ruder, wenn die Kosten der Veränderung den erwarteten Nutzen übersteigen. Für mich ist es so: Die Leute neigen dazu, sich extrem unsinnigen numerischen Rezepten zuzuwenden und zu sagen: “Oh, sieh mal, das ist ein Problem.”

Zum Beispiel haben wir eine Entscheidung, die super naiv an eine Prognose gebunden ist, ohne jegliche Berücksichtigung der aktuellen Verpflichtungen usw. Es ist unglaublich naiv. Offensichtlich benötigst du einen Teil deines numerischen Rezepts, um die Entscheidung zu treffen, die welche Änderungskosten und allerlei andere Kosten implementiert. Es gibt jede Menge davon. Und hier glänzt auch die probabilistische Prognose. Sie gibt dir noch mehr. Du berücksichtigst die Tatsache, dass wenn du diese Entscheidung jetzt triffst, du sie in Zukunft möglicherweise überarbeiten musst. Denn, nochmals, wenn du diese Punktprognose hast, gehst du definitionsgemäß davon aus, dass du die Zukunft bereits kennst. Also hindert dich dein Modell automatisch daran, in Betracht zu ziehen, dass deine Prognose falsch sein könnte. Aber bei probabilistischen Prognosen ist das selbstverständlich. Die Prognose sagt dir bereits, dass die Nachfrage irgendwo innerhalb dieses Bereichs liegen kann, und du hast die Wahrscheinlichkeiten. So berechnest du nicht nur, wenn du die Entscheidung optimierst, die Änderungskosten, falls es irgendeine Änderung gibt, sondern auch die Tatsache, dass in Zukunft möglicherweise eine Änderung notwendig ist.

Conor Doherty: Nun, meine Herren, ich bin mir der Zeit bewusst und es gibt noch mindestens vier weitere Fragen. Aber im Geiste der Gleichberechtigung werde ich diese nächste Frage an dich richten, äh, Jeff. Wäre FVA also ein guter Ansatz, um den Druck zu mindern, statistische Modelle an die Budgetvorgaben anzupassen? Im zweiten Teil, wie kann ein supply chain data scientist…

Entschuldigung, ich sollte das eigentlich stellen. Verzeihen Sie, ich sollte es eigentlich an Joannes richten. Entschuldigung. Wäre FVA also ein guter Ansatz, um den Druck zu mindern, statistische Modelle an die Budgetvorgaben anzupassen? Und wie kann ein supply chain data scientist sich in der Politik und Hierarchie zurechtfinden, wenn er vor solchen Herausforderungen steht? Und Jeff, ich werde dich um einen Kommentar bitten.

Joannes Vermorel: Nochmals, das ist das Problem mit Punktprognosen. Punktprognosen setzen voraus, dass man die Zukunft kennt. Wenn man also die Zukunft kennt, ist alles – der Plan, alles – eine Frage der Inszenierung, und deine Prognose legt das Budget fest, das du für alles benötigst. Und das ist falsch, weil erstens die Prognose Ungenauigkeiten aufweist und du die Unsicherheit völlig außer Acht lässt.

Eine Punktprognose ist starr an ein gegebenes Budget gebunden. Das ist absolut nicht Best Practice. Aber wenn wir in die Welt der probabilistischen Prognosen eintreten, verschwinden plötzlich all diese Probleme. Was du hast, sind mögliche Zukünfte, und dann kann die gesamte Budgetausgabe berücksichtigt werden. Wenn du mir sagst, dass du diese Menge an Ressourcen hast, wirst du darauf schauen, wie du diese Ressourcen so einteilen kannst, dass du das Maximum gemäß diesen Wahrscheinlichkeiten für die Zukunft herausholst.

Und übrigens, wir haben ein Beispiel dafür. Wenn Leute eine Tabelle wünschen, können sie sich auf unserer Website prioritized inventory replenishment ansehen. Es handelt sich um eine Excel-Tabelle, die demonstriert, dass du mit einer probabilistischen Prognose – egal welches Budget du hast – das Beste aus deinem Budget herausholen kannst. Nochmals, das weist darauf hin, dass Punktprognosen als Paradigma defekt sind. Klassische Zeitreihen sind als Paradigma defekt, und man stößt auf viele Probleme, die es, selbst konzeptionell, nicht gäbe, wenn man nicht an ein defektes Paradigma gebunden wäre.

Jeff Baker: Nur mal nebenbei, ein defektes Paradigma hat übrigens für viele Unternehmen seit etlichen Jahren wirklich gut funktioniert. Daher würde ich es nicht als defekt klassifizieren. Was das Budget betrifft, weißt du, Prognose und Budget sind ein riesiges Problem, da Budgets aspirativ sind, richtig? Das Beste, was wir tun können – und nochmals, aus Vertriebs- und Operationssicht – ist, dass ich meine Kunden immer für 18 Monate prognostizieren lasse. Also, rate mal? Mitte 2025 haben wir bereits begonnen, auf 2026 zu blicken. Wir können verstehen, wie die wahrscheinlichste Sichtweise von 2026 aussehen wird.

Von dort aus kannst du deine ehrgeizigen Ziele darüber schichten. Kein Problem damit, aber dann erzwingst du das Gespräch: Was müsste passieren, damit wir unseren Umsatz um so viel steigern, unsere Kosten um so viel senken, richtig? Das ist Teil des Gesprächs. Der beste Weg, dies zu erreichen, besteht darin, dein Budget auf einer soliden statistischen Prognose oder irgendeiner Konsensprognose für die Zukunft zu basieren. Leg dein Budget darauf fest. Und dann, falls es Abweichungen gibt, sollten auch Vertriebs-, Marketing- und Produktionspläne vorhanden sein, um diese Lücken zu schließen. Am schlechtesten, und ich hoffe, alle stimmen dem zu, ist der Ivory Tower-Ansatz. Das heißt, das ist unser Budget, die Finanzabteilung setzt es fest, und es erinnert mich an die alten Analysisaufgaben, bei denen die Herleitung dem Benutzer überlassen wurde, und wir denken: “Oh, wie zum Teufel sollen wir das machen?” Also, das ist eine schlechte Praxis, einfach diese Platzhalter einzusetzen.

Jeff Baker: Das ist meiner Meinung nach ein Weg, um sicherzustellen, dass dein ursprüngliches Budget in der Realität verankert ist, mit Plänen, es zu erreichen. Dann, was ich noch sage, ist, dass FVA dafür perfekt ist. Das entspricht unserer statistischen Prognose. Beim Budget gibt es aber kein FVA zum Budget, richtig? Das ist aspirativ. Aber du zeigst auf, wo diese Lücken liegen, und erzwingst das Gespräch darüber, wie man sie schließen kann. Ja, ich denke, wir alle würden zustimmen, dass eine weitere absolute Schlechtpraxis darin besteht, dass die Prognose dem Budget gleichgesetzt wird. Das würde mich verrückt machen.

Conor Doherty: Nun, danke, Jeff. Ich mache mit dem nächsten Kommentar, der nächsten Frage weiter, Entschuldigung, und diese richtet sich direkt an Joannes. Das kommt, glaube ich, von Timur. Ich finde FVA nützlich, aber manchmal in ihrem Umfang begrenzt. Würdest du Jeffs Metapher zustimmen, dass FVA wie ein Hammer ist, oder siehst du das anders?

Joannes Vermorel: Ich meine, ja. Ich bin mir nicht ganz sicher. Meine Kritik an FVA ist wirklich nicht, dass es ein Hammer wäre. Es ist vielmehr so, dass ich glaube, dass es in den falschen Paradigmen operiert. Es ist seltsam und bedingt durch die falschen Paradigmen. Wiederum, Zeitreihen, klassische Punktprognosen, die Tatsache, dass sie auf Genauigkeit beruhen und nicht auf Messungen in Prozent des Fehlers, nicht in Dollar des Fehlers. Siehst du, es gibt jede Menge paradigmatischer Probleme, und genau dann sage ich, dass diese Dinge mangelhaft sind. Ich stehe zu meinem Punkt in dieser Hinsicht. Die Art von Reibung, die Unternehmen in der Praxis ertragen, ist eher die Manifestation all dieser Probleme.

Wenn du einen anekdotischen Beweis dafür haben möchtest, dass diese Paradigmen fehlerhaft sind, so versprach die supply chain theory seit den 1970er Jahren eine vollständige Automatisierung dieser Entscheidungsprozesse. Das war übrigens das Verkaufsargument von Oracle in den 70ern: Du wirst ein vollständig algorithmisch gesteuertes Bestandsmanagement erhalten. Dies geschah nicht, und es scheiterte immer wieder. Der Punkt, den ich machen möchte, ist, dass ich glaube – und ich habe viele unterstützende Argumente – dass dies widerspiegelt, dass die Paradigmen, die mathematischen Werkzeuge, die Instrumente einfach falsch sind. So endet man mit allerlei merkwürdigen Problemen. Um auf diesen Hammer-Vergleich zurückzukommen: Ja, es fühlt sich manchmal an, als würde man einen Hammer benutzen, um Schrauben anzuziehen. Es liegt nicht daran, dass der Hammer an sich schlecht ist; es liegt daran, dass du versuchst, etwas zu tun, wofür der Hammer nicht das richtige Werkzeug ist.

Conor Doherty: Jeff, ich gebe dir hier Raum für einen Kommentar, falls du noch etwas hinzufügen möchtest.

Jeff Baker: Nein, abgesehen von der Tatsache, dass meine Analogie mit dem Hammer darin bestand, dass man das Werkzeug korrekt einsetzen muss. Also, FVA ist ein Werkzeug. Wenn du das Werkzeug nicht korrekt benutzt, wirst du keinen Nutzen daraus ziehen. Das war meine Analogie.

Conor Doherty: Danke. Ich mache weiter. Dies kommt von Marina. Es gibt keine klare Zuweisung, für wen das gedacht ist, also wende ich mich zuerst an Jeff. Angesichts des rasanten Fortschritts bei der KI und der Möglichkeit, dass in naher Zukunft alle Daten verfügbar sein werden, denkst du, dass FVA effektiver oder sogar noch essentieller wird?

Jeff Baker: Effektiver oder wesentlicher? Das ist eine interessante Frage. Meiner Meinung nach, da KI immer präsenter wird und immer mehr Daten zur Verfügung stehen, müssen wir lernen, diese zu kontextualisieren und darauf basierende Entscheidungen zu treffen. Man könnte sich nahezu eine Zukunft vorstellen, in der wir all diese Informationen kontextualisieren können, große Sprachmodelle sie einfließen lassen und – wie du schon sagst, Joannes – tatsächlich anfangen, das Zeug zu systematisieren. Das könnte potenziell dazu führen, dass FVA sagt: “Na gut, wir treffen all diese Entscheidungen, und sie sind großartige Entscheidungen.”

Vielleicht bleiben dir dann nur noch Randfälle signifikanter Ereignisse, etwa wenn ein Konkurrent pleitegeht oder gleichzeitig eine Promotion durchgeführt wird, während die Wirtschaft einen Abschwung erlebt und gleichzeitig deine Saisonalität zunimmt. Vielleicht kannst du damit beginnen, diese Fälle zu erfassen. Daher denke ich, dass es wahrscheinlich einige leicht zugängliche Bereiche geben wird, in denen KI fantastisch darin sein wird, all diese Daten aufzunehmen, Zusammenhänge zu verstehen und auch das vorhandene Rauschen zu unterscheiden, um herauszufinden, was wertvoll ist und was nicht. Deshalb könnte es in Zukunft potenziell sogar etwas weniger wertvoll sein, sobald wir anfangen zu automatisieren.

Conor Doherty: Nun, danke, Jeff. Joannes, KI und FVA, die Zukunft: ja, nein, gut, schlecht?

Joannes Vermorel: Ich denke, wir müssen noch einmal einen Schritt zurück bei der künstlichen Intelligenz machen. Betrachten wir dies mal aus Sicht der Informationsmenge: Transaktionssysteme enthalten Gigabytes an Informationen. Ich meine, Gigabytes, wenn man es besonders elegant ausdrücken möchte. Die Transaktionsdaten umfassen Gigabytes an Informationen. Die Menschen hingegen verfügen, im Vergleich, nur über Kilobytes an Informationen. Was die Menschen in ihren Köpfen haben, ist nicht allzu viel. Die Menschen sind eben nicht, wie man sagt, Mentaten – wie ich in der Dune-Reihe für diejenigen erwähnen würde, die das mögen. Das heißt, dass 99 % des Problems, die richtigen Entscheidungen zu treffen, darin bestehen, aus der schieren Masse alltäglicher Transaktionsinformationen die Entscheidungen abzuleiten. Das macht 99 % des gesamten Informationsvolumens aus.

Für diesen Teil des Problems, nämlich der Verarbeitung numerischer Daten in tabellarischer Form, sehe ich die großen Sprachmodelle nicht als besonders relevant an. Ja, sie können sehr effektive Programmierwerkzeuge sein, sodass du das Tool tatsächlich nutzen kannst, um den Code für dich zu schreiben. Das ist eines. Aber können sie mehr leisten oder andere Aufgaben übernehmen als nur Code zu schreiben? Das wird sehr unklar.

Nun, für die Kilobytes an Informationen, die die Menschen in ihren Köpfen haben, können sie diese Informationen tatsächlich dazu verwenden, die Lücke zu etwas Quantitativem zu überbrücken? Ich würde sagen ja, aber die Herausforderung besteht weiterhin darin, dieses System end-to-end zu entwickeln, diese Pipeline zu bauen, um eine automatisierte prädiktive Optimierung zu erreichen. Das ist eine echte Herausforderung, und hier stoßen wir an die Grenzen der menschlichen Intelligenz, um es richtig zu machen. Deshalb sehe ich in naher Zukunft nicht, dass die existierenden KIs in der Lage wären, das zu leisten – mehr als, sagen wir, ein KI-Unternehmen, das Microsoft ersetzt, indem eine KI eine Version von Microsoft Word umschreibt. Es ist die Art von Sache, bei der die KI dir zwar beim Schreiben des Codes helfen kann, aber sie wird dennoch viel intelligente menschliche Aufsicht erfordern, zumindest im aktuellen Paradigma, das wir mit LLMs haben. Sie sind noch nicht superintelligent.

Conor Doherty: Nun, es gibt noch zwei Fragen. Also, Jeff, wenn du möchtest, können wir direkt zur nächsten übergehen.

Jeff Baker: Perfekt.

Conor Doherty: Danke. Diese Frage ist für dich. Ich fange an. Ähm, diese stammt von Mark. Wie können Prognose-Konfidenzintervalle effektiv in eine einzelne, diskrete Zahl wie eine Bestellung oder Arbeitsanweisung übersetzt werden? Wäre eine Nach-Prognose-Analyse der beste Ansatz, um diese Zahl zu bestimmen?

Jeff Baker: Ja, also, ich habe nichts gegen probabilistische Prognosen oder die Intervalle, aber letztendlich musst du eine Zahl in dein ERP System, also in dein Planungssystem, eintragen. Du musst dich für eine Zahl entscheiden. Jetzt wird es interessant: Wie groß ist die Schwankung dieser Zahl? Ist mein System robust? Was passiert, wenn sie etwa um 20 %, 30 % oder ähnliches variiert? Doch diese werden zu Szenarien, die du untersuchen kannst, oder? Also ja, das wäre meine Antwort.

Conor Doherty: Danke. Joannes, möchtest du noch etwas hinzufügen?

Joannes Vermorel: Ja, nochmals: Wenn du glaubst, dass du das Problem aus einer paradigmatischen Perspektive angehen musst, bei der du eine Entscheidung über Bestandsmengen treffen musst und die Prognose daher eine Zahl sein muss, hast du das Problem, dass Unsicherheit nicht existiert. Sie kann schlichtweg nicht existieren. Und deshalb nähern sich die Leute – wir kehren wieder zu dieser fehlerhaften Perspektive zurück – dem Problem, indem sie fragen: “Was ist mit diesen Konfidenzintervallen? Was mache ich damit? Oh, ich muss an eine Zahl denken.” Und das ist eine paradigmatische Falle. Du bist in fehlerhaften Konzepten gefangen.

Wenn du das Problem also mit dem aktuellen Paradigma angehst, bei dem eine Nachfrageprognose dir eine konkrete Zahl für die Bestandsentscheidung liefert, besteht der einzige Weg, es zu lösen, darin, selbst in der Entscheidung zu bewahren, dass diese alle möglichen Szenarien widerspiegelt. Es geht nicht darum, einfach eine Zahl für den Bestand auszuwählen; vielmehr wählst du eine spezifische Nachfrage. Nein, deine Bestandsentscheidung sollte alle möglichen Szenarien inklusive ihrer Prioritäten widerspiegeln und die verschiedenen Risiken in monetären Werten ausdrücken. Deshalb ist es ein anderer Denkansatz. Und zurück zur Frage: Wenn du im Zeitreihen-Paradigma bleibst, weißt du nicht, was du mit deinen Konfidenzintervallen anfangen sollst. Sie passen einfach nicht in das System.

Jeff Baker: Ich würde argumentieren, dass du genau weißt, was mit diesen Konfidenzintervallen zu tun ist, denn wenn ich den Prognosefehler bei meiner Durchlaufzeit habe, fließt dieser in meine Sicherheitsbestand Berechnung ein. Ob du dem zustimmst oder nicht, es gibt sehr klar definierte Sicherheitsbestandsberechnungen, die die Nachfrageschwankungen und die Schwankungen der Durchlaufzeit berücksichtigen. Wenn wir das heranziehen, haben wir – und ich möchte hier nicht in die Inventarverwaltungstheorie abdriften – aber es gibt statistische Sicherheitsbestandsberechnungen, die perfekt damit zurechtkommen, einen Punktprognosewert zusammen mit einem Standardfehler deiner Prognose bei der Durchlaufzeit zu nehmen und dir eine Sicherheitsbestandszahl zu liefern. Wir könnten den ganzen Tag darüber diskutieren, wie diese Verteilung aussieht und ob eine Normalverteilung die richtige ist, aber so wird die Abweichung im Prognosefehler in den meisten Unternehmen behandelt, für die ich gearbeitet habe, und in den meisten Unternehmen, die ich auf Konferenzen präsentiert gesehen habe.

Conor Doherty: Ich werde bis zur letzten Frage durchhalten. Wie sollen Machine-Learning-Modelle Anpassungen für bekannte Ereignisse, wie etwa einen großen neuen Kunden, die nicht in den kausalen Faktoren der statistischen Prognose enthalten sind, handhaben? Joannes, wir wenden uns zuerst an dich.