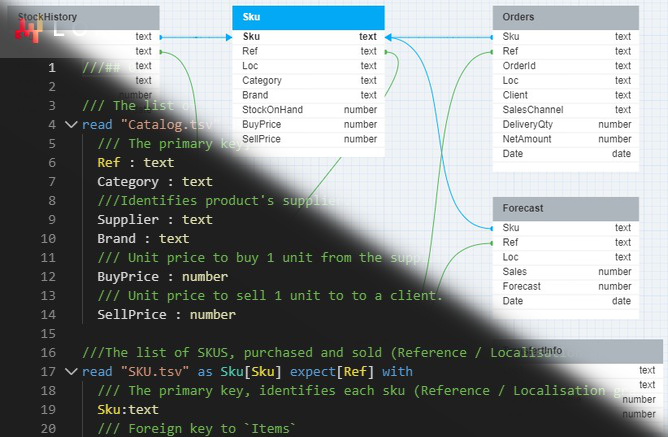

Une perspective nuancée sur la frontière technologique irrégulière de la Harvard Business School

La qualité est subjective; le coût ne l’est pas.

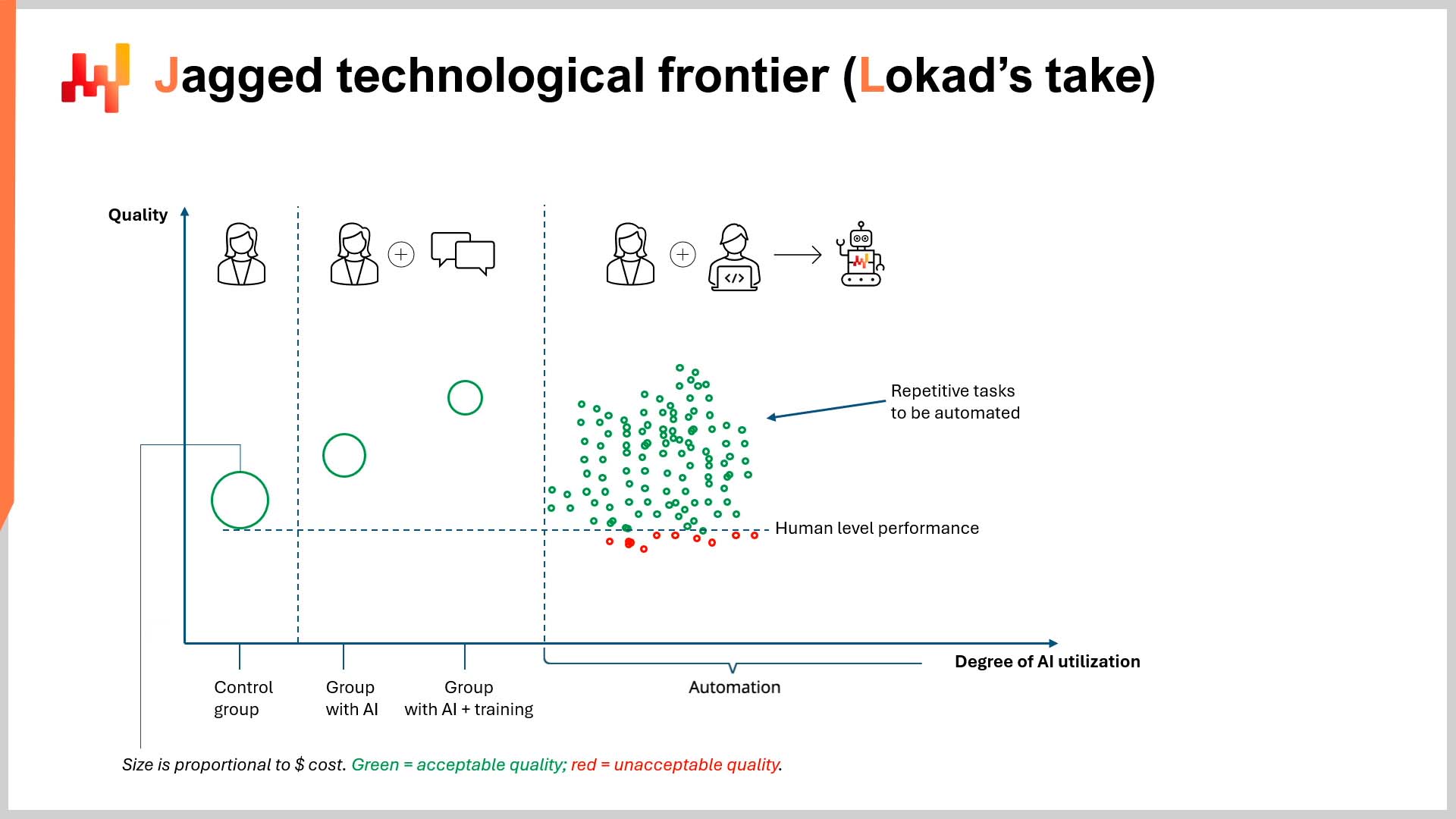

Dans un récent épisode de LokadTV, j’ai suggéré qu’un article de la Harvard Business School (HBS), réalisé en collaboration avec le Boston Consulting Group (BCG), était profondément défectueux et potentiellement dangereux. Le titre complet de l’article est Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge, Worker Productivity, and Quality1. En résumé, l’article indiquait que les capacités de l’IA dans les tâches exigeantes étaient inégalement réparties, car elle excelle dans certaines tâches et performe mal dans d’autres (les tâches “à l’intérieur” et “à l’extérieur de la frontière”, respectivement).

Contexte

De l’autre côté de cette « frontière technologique irrégulière » (voir illustration à la p. 27 de l’article), l’expertise humaine surpasse encore l’IA (dans ce cas, ChatGPT-4), en particulier dans les tâches qui combinent analyse quantitative et qualitative (c’est-à-dire, les tâches “à l’extérieur de la frontière”).

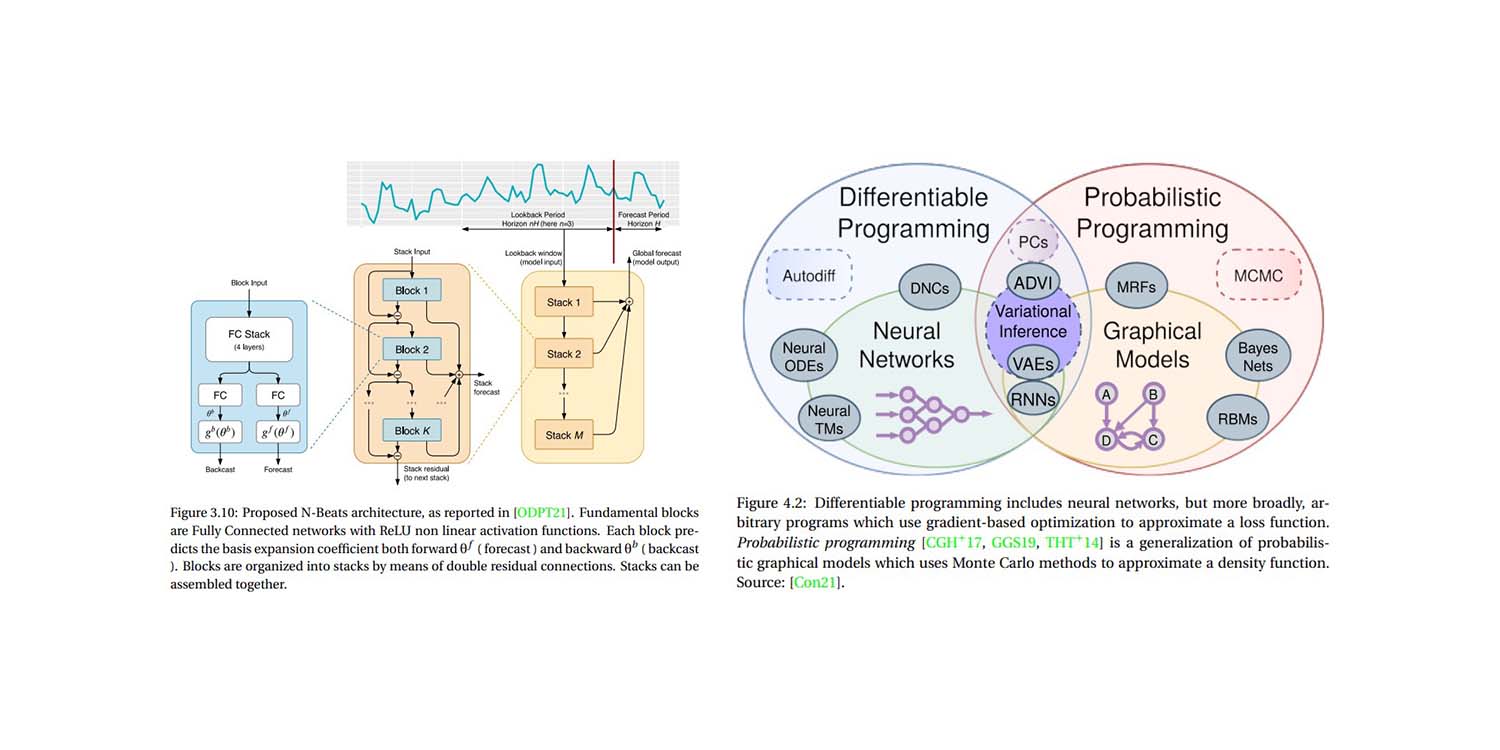

Cela ne devrait surprendre personne qui connaît ce à quoi sont destinés les modèles de langage étendu (LLMs) comme ChatGPT (spoiler : pas les maths). De plus, lorsque les LLMs sont traités comme une « base de données de tout » ils produisent des réponses plausibles mais parfois inexactes2. Cependant, l’article soulève encore quelques points intéressants - quoique par accident.

À son crédit, l’article est très lisible, ce qui manque souvent dans le milieu académique. Cela dit, on pourrait soulever quelques préoccupations concernant d’éventuels conflits d’intérêts3 et ses conclusions4, cependant c’est la méthodologie et l’économie implicite de l’article qui nous intéressent principalement.

Critique de la méthodologie

En ce qui concerne la méthodologie, ce point a déjà été critiqué dans la vidéo, donc je serai bref ici. L’équipe de recherche n’a pas exploré les gains de productivité générés par l’automatisation. Au lieu de cela, les chercheurs ont sélectionné des groupes de consultants (c’est-à-dire, des non-spécialistes en IA, informatique et/ou ingénierie) pour utiliser ChatGPT-4. La seule exception à cela fut le groupe témoin, qui a travaillé en se reposant uniquement sur son expertise. L’éthique de la manière dont ces groupes ont été évalués sera mentionnée sous peu.

Il n’y avait aucun ingénieur logiciel externe ni expert en IA dans l’expérience. Aucune équipe de développeurs experts en retrieval augmented generation (RAG), en fine-tuning spécifique au domaine, ou d’autres techniques qui exploitent les plus grandes forces des LLMs : être résilients au bruit, des robots capables de générer des modèles universels.

Ce robot impressionnant n’a pas été programmé pour exploiter les connaissances spécifiques au domaine stockées dans les vastes bases de données internes de BCG sur les initiatives de consulting passées. Au contraire, l’expérience comportait quelques consultants abonnés à ChatGPT-4.

Cette orchestration a naturellement engendré des niveaux de performance variés (en termes de qualité), en particulier concernant les tâches nécessitant à la fois une analyse quantitative et qualitative. En d’autres termes : une expérience a été conçue pour observer à quel point les non-experts échouent lamentablement à tirer profit d’une technologie sophistiquée, et ce, dans des conditions irréalistes et restrictives.

Comme je l’ai conclu dans la vidéo, ignorer les gains de productivité (et les économies) possibles générés par l’automatisation frise le scandale. Cela est particulièrement vrai lorsqu’on publie sous le nom d’un institut prestigieux d’enseignement. À mon avis, les conclusions de l’article offrent également aux étudiants sur le point de s’endetter lourdement pour étudier dans une grande école de commerce un faux sentiment de sécurité (professionnelle). Cela vaut aussi pour les personnes qui ont déjà franchi le pas et contracté d’importantes dettes pour obtenir des diplômes dans des domaines qui pourraient être au bord de l’automatisation totale.

Critique de la perspective économique

Malgré les critiques considérables ci-dessus, selon moi, l’économie implicite de l’article est bien plus fascinante. En un mot, la Harvard Business School a mesuré uniquement la $${quality}$$ de la production, et non son $${cost}$$5.

À aucun moment (et merci de vérifier mes dires) les chercheurs ne mesurent le coût associé à la production du travail des consultants. Ce n’est pas un point trivial. L’article mentionne le mot “quality” 65 fois en 58 pages (y compris dans le titre de l’article). Le mot “cost” est mentionné…2 fois…et uniquement dans la toute dernière phrase de l’article. Je reproduis cette phrase ici pour contexte :

“De la même manière que l’internet et les navigateurs web ont considérablement réduit le coût marginal du partage d’informations, l’IA pourrait également abaisser les coûts associés à la pensée et au raisonnement humains, avec des effets potentiellement vastes et transformateurs.” (p. 19)

Même lorsque la Harvard Business School a finalement reconnu le concept de coût financier, ce n’était pas en termes de réduction du coût de production d’un travail de haute qualité sans la nécessité d’avoir recours à des diplômés coûteux d’une grande école de commerce. Cela peut sembler évident compte tenu du fait que le titre de l’article identifie la “productivity” et la “quality” comme points focaux de recherche, sans oublier qu’une école de commerce coûteuse n’a guère intérêt à promouvoir sa propre inutilité potentielle.

Cela étant dit, je suggère poliment que mesurer la $${productivity}$$ et la $${quality}$$ de la production sans une perspective financière solide est pratiquement dénué de sens, particulièrement dans un article académique d’une école de commerce. Ceci est d’autant plus flagrant que l’essence même de l’IA est qu’elle constitue un grand égalisateur en matière de puissance fiscale.

L’IA offre des résultats de très haute qualité à des coûts très bas, notamment grâce à l’automatisation. Ce ratio $${quality/cost}$$ dépasse de plusieurs ordres de grandeur celui des travailleurs humains6. De plus, il ouvre la porte à n’importe qui disposant d’un abonnement ChatGPT et de quelques connaissances en programmation. Cela équilibre fortement la concurrence entre les grandes entreprises et les plus petites.

Au lieu de cela, pendant 58 pages, la Harvard Business School évalue la “quality” du travail des consultants de BCG de manière isolée. Comment cette qualité a-t-elle été déterminée ? Par des “évaluateurs humains”…qui travaillent pour BCG7.

Mettant de côté les conflits d’intérêts manifestes déjà détaillés, il est intéressant de noter la fausse dichotomie présentée par l’article, et comment cela influence son économie implicite. Cette fausse dichotomie se présente à peu près ainsi :

Ou peut-être une interprétation plus charitable est :

“L’IA rend les humains meilleurs ou pires dans leur travail.”

Quoi qu’il en soit, la métrique sous-jacente à la fausse dichotomie de l’article est la “quality”, qui est mesurée de manière subjective et existe dans un vide académique indépendant d’autres contraintes, telles que le temps, l’efficacité et le coût. Une perspective économique plus sophistiquée serait la suivante :

Quel est le ratio $${quality/cost}$$ de la production humaine comparé au ratio $${quality/cost}$$ de l’automatisation par IA ?

Les lecteurs avertis reconnaîtront cela comme un argument d’ROI (retour sur investissement). Votre ratio personnel $${quality/cost}$$ peut être déterminé en répondant aux questions suivantes :

- Quelle était la qualité de la production pour une tâche donnée ?

- Quel en a été le coût ?

- La qualité justifiait-elle le coût ?

- Combien cela coûterait-il d’améliorer la qualité, et cette amélioration serait-elle financièrement rentable ?

La Harvard Business School consacre 58 pages à discuter de la première question et ne va jamais au-delà. C’est une perspective singulière pour une école de commerce, faut-il le dire. En fait, on peut établir un parallèle intéressant avec la supply chain. La quête aveugle de quality de HBS est remarquablement similaire à la poursuite isolée de précision des prévisions (c’est-à-dire, tenter d’améliorer la précision des prévisions sans considérer le ROI associé à cette amélioration)8.

Implications potentielles

D’un point de vue économique, la “frontière technologique irrégulière” n’identifie pas simplement les tâches que les LLMs exécutent mieux que les humains. Au contraire, elle identifie votre ratio idéal $${quality/cost}$$ lors de l’utilisation des LLMs, et permet de prendre des décisions intelligentes et éclairées sur le plan financier. Pour les hommes d’affaires avisés, cela impliquera l’automatisation, et non une intervention manuelle (ou du moins très peu d’intervention manuelle).

Pour ces hommes d’affaires, un niveau de qualité comparable est peut-être acceptable, tant qu’il est rentable. “Acceptable” peut signifier une qualité équivalente, ou légèrement meilleure/pire, que celle produite par un expert humain. En d’autres termes, payer 0,07 % du prix d’un consultant pour >90 % de la qualité pourrait représenter un très bon compromis, malgré le fait que ce ne soit pas exactement aussi bon que la production de l’expert coûteux[^9].

Les chiffres varieront selon les clients, mais ce qui est démontrablement clair, c’est qu’il existe un seuil au-delà duquel la “quality” cesse d’être une préoccupation isolée et doit être évaluée par rapport à son coût financier. Cela est au moins vrai pour les entreprises déterminées à rester en activité.

Peut-être pensez-vous qu’engager une équipe de diplômés de la Harvard Business School, ou des consultants de BCG, représente un ratio idéal $${quality/cost}$$, indépendamment d’options moins coûteuses comme l’automatisation par IA. Si tel est le cas, je vous souhaite une longue vie et prospérité[^10].

Ou peut-être pensez-vous comme moi : la quality est subjective; le cost ne l’est pas. Mon appréciation subjective de la qualité - notamment dans le domaine des affaires - est relative à son coût. Semblable aux taux de service (ou à la précision des prévisions) dans la supply chain, une augmentation de 1 % de la qualité (ou de la précision) ne vaut probablement pas une hausse de 1 000 % du coût. Ainsi, en ce qui concerne l’IA dans les affaires, un compromis économique doit être trouvé entre qualité et coût. Il est crucial de ne pas perdre de vue cela, comme il semble que la Harvard Business School l’ait fait.

En conclusion, si vous attendez que l’IA dépasse la qualité humaine avant de l’adopter, tant pis, mais le reste d’entre nous n’attendra pas avec vous.

-

Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality, Dell’Acqua, Fabrizio, McFowland, Edward, Mollick, Ethan R., Lifshitz-Assaf, Hila, Kellogg, Katherine, Rajendran, Saran, Krayer, Lisa, Candelon, François, et Lakhani, Karim R., septembre 2023 ↩︎

-

Dans AI Pilots for Supply Chain, Joannes Vermorel a comparé cette approche de « couteau suisse » à celle qui consiste à demander à un professeur très intelligent de se souvenir des détails d’un article qu’il a étudié. De mémoire, le professeur se souviendra de l’essentiel, mais il ne rappellera pas nécessairement toutes les nuances à moins que vous ne posiez les bonnes questions de suivi pour rafraîchir sa mémoire. ↩︎

-

BCG fait la publicité de ses liens avec de nombreuses grandes écoles de commerce américaines. N’hésitez pas à enquêter sur la présence de BCG sur les principaux campus américains. Alternativement, vous pouvez consulter ce fichier Excel téléchargeable qui simplifie les données. Le tableau indique le nombre de consultants de BCG actuellement inscrits en MBA à la Harvard Business School (74). Les lecteurs tireront leurs propres conclusions. ↩︎

-

Une collaboration entre une grande école de commerce et un grand cabinet de conseil a démontré que des consultants coûteux (et coûteusement formés) sont des atouts précieux… Pardonnez-moi de ne pas être moins choqué. Si vous l’êtes, je vous renvoie poliment au fichier Excel téléchargeable mentionné dans la note de bas de page précédente. ↩︎

-

Et il n’a très certainement pas mesuré la quality divisée par le cost de la production, comme je l’aborderai plus tard. ↩︎

-

Il est difficile de fournir des chiffres précis à ce sujet, mais supposons un salaire annuel de plus de 200 000 $ (US) pour un consultant d’une grande firme. Ce chiffre est raisonnable d’après quelques recherches rapides sur Internet. Les calculs sur le vif de ChatGPT suggèrent qu’une année de travail de conseil coûterait environ 145 $ (en termes de coûts de traitement par ChatGPT). Évidemment, ce n’est pas très scientifique, mais même si ce chiffre avait une marge d’erreur de trois ordres de grandeur, cela reste presque 30 % moins cher que le salaire annuel d’un seul consultant. Consultez le raisonnement de ChatGPT ici : https://chat.openai.com/share/d9beb4b9-2dd3-4ac2-9e95-2cd415c76431. (Crédit à Alexey Tikhonov pour avoir fourni le journal de conversation.) ↩︎

-

Voir les pages 9 et 15 de l’article, au cas où vous douteriez de ce que vous venez de lire. Si cela suggère peut-être un conflit d’intérêts, je vous redirige poliment vers le fichier Excel téléchargeable mentionné dans la note de bas de page 3. ↩︎

-

Lokad a déjà abordé la valeur de la précision des prévisions en détail, voici donc un rappel très bref : concentrez-vous sur l’impact financier de vos décisions en supply chain, plutôt que de mesurer des KPI (tels que la précision) indépendamment de leurs implications financières (i.e., ROI). Autrement dit, si une prévision de la demande est 10 % plus précise mais que vous gagnez 20 % moins d’argent en conséquence, il est juste de dire que l’augmentation de la précision n’a pas valu l’augmentation du coût. Il y a environ un an, Lokad a commencé à traduire son site web en six langues à l’aide des LLMs. Avant cela, nous avions fait appel aux services de traducteurs professionnels. Le coût annuel pour simplement maintenir les traductions était d’environ 15 000-30 000 (US) par langue. Bien que nous soyons parfaitement prêts à reconnaître que les traducteurs professionnels fournissaient une qualité (relativement) supérieure, le ratio $${quality/cost}$$ de l’utilisation d’un LLM est bien supérieur. Autrement dit, la qualité que nous pouvons obtenir en utilisant un LLM est plus que satisfaisante et nettement moins coûteuse que notre précédente solution. Il est difficile de quantifier précisément les économies réalisées, mais traduire de manière compétente chaque ressource que nous avons jamais produite (et que nous produirons) en six langues en quelques minutes est exponentiellement moins cher et bien plus efficace en termes de temps que le système précédent. Si vous êtes de langue maternelle française, allemande, espagnole, russe, italienne ou japonaise, n’hésitez pas à traduire cet essai en haut à droite de la page et à tester vous-même la qualité. Au moins jusqu’à ce que OpenAI publie ChatGPT-5. ↩︎