Montrez-moi l'argent : Réflexions sur ISF 2024

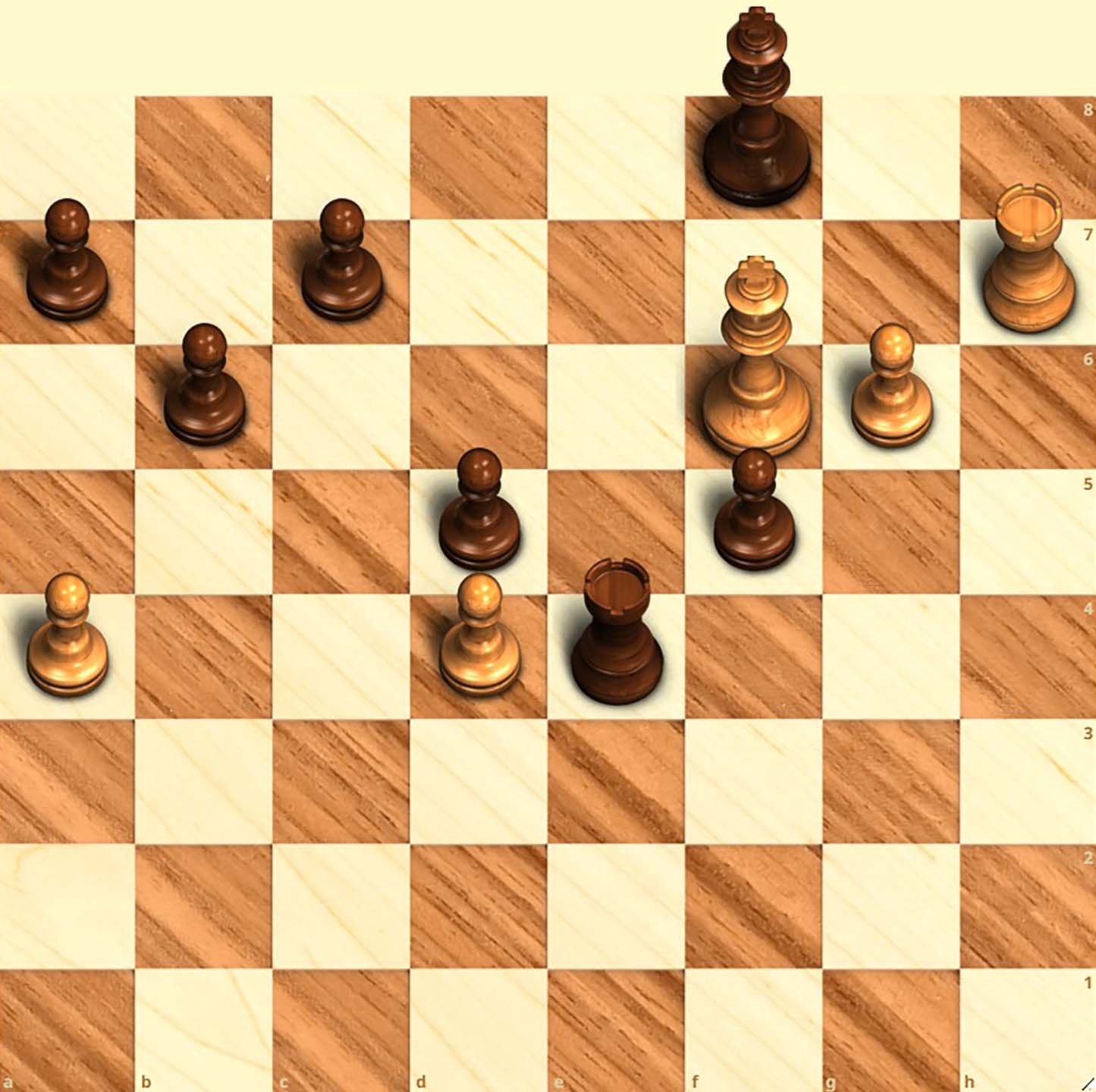

“Pour améliorer votre jeu, vous devez étudier le jeu final avant toute chose ; car, alors que les finales peuvent être étudiées et maîtrisées pour elles-mêmes, le milieu de jeu et l’ouverture doivent être étudiés en relation avec le jeu final.” Source: Les Derniers Cours d’Échecs de Capablanca (1966), p. 23

Il y a quelques semaines, j’ai participé à une table ronde lors du 44e Symposium International sur la Prévision à Dijon, France. Le sujet de la table ronde était la planification de la demande et le rôle du jugement dans le Nouveau Monde de AI/ML.

En tant qu’ambassadeur de Lokad, vous pouvez imaginer quelle était ma perspective :

-

la prévision et la prise de décision devraient être complètement automatisées;

-

la qualité des prévisions devrait être évaluée du point de vue de meilleures décisions;

-

le jugement humain devrait être utilisé pour améliorer l’automatisation (et non pour ajuster les prévisions ou les décisions).

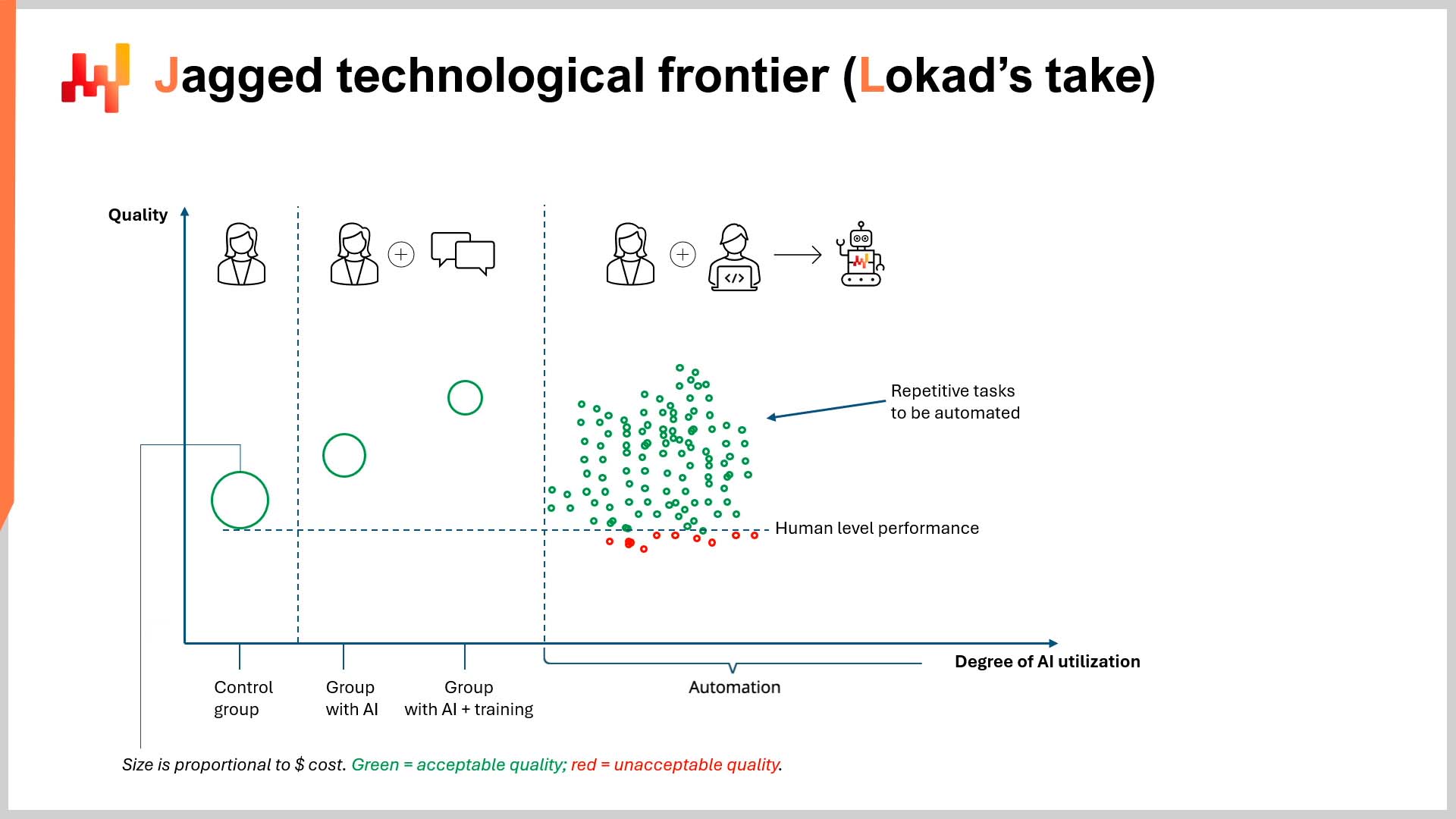

Étonnamment, ma position sur l’automatisation n’a pas suscité autant de désaccords que vous pourriez le penser. Le président (Responsable de la communication chez Lokad, Conor Doherty) et les autres intervenants (Sven Crone d’iqast et Nicolas Vandeput de SupChains) étaient presque unanimes pour affirmer que c’était l’avenir de la prévision. Le seul désaccord portait sur la rapidité avec laquelle nous pourrions atteindre cet état (note : je crois que nous y sommes déjà).

Ce qui a provoqué pas mal de désaccords, et peut-être même de la confusion, était mon argument selon lequel la précision des prévisions n’est pas aussi importante que prendre de meilleures décisions. Ce désaccord ne se limitait pas aux autres intervenants, mais concernait également les membres du public. Je pense qu’il y a deux raisons majeures à cela :

-

Lorsque je suis intervenu sur scène, je n’avais pas de support visuel pour étayer ce point. Il y a plusieurs éléments en jeu dans l’explication, donc un support visuel aurait sans aucun doute aidé à la compréhension.

-

L’idée que la précision des prévisions est moins importante que les décisions contredit la formation, l’éducation et l’expérience de la plupart des professionnels.

À la fin de cet essai, j’espère avoir abordé les deux points mentionnés ci-dessus. En ce qui concerne le premier point, j’ai inclus une explication courte mais systématique ainsi qu’un support visuel intuitif. Pour le second point, je ne peux qu’inviter le lecteur à garder l’esprit ouvert pendant les 5 à 10 prochaines minutes et à aborder ces mots comme si vous n’aviez aucune formation préalable en prévision de la supply chain.

Questions directrices

Il me semble qu’il existe cinq questions fondamentales auxquelles il faut répondre pour clarifier ma position. Dans cette section, je ferai de mon mieux pour fournir des réponses relativement courtes à chacune d’elles - l’essentiel, en quelque sorte. Soyez assuré que Lokad dispose d’une multitude de ressources supplémentaires pour expliquer les aspects techniques, auxquelles je renverrai à la fin de cet essai.

Q1 : Qu’est-ce que cela signifie qu’une prévision ajoute de la valeur ?

Je vais commencer immédiatement par un exemple. Supposons qu’il existe un mécanisme par défaut pour produire des décisions dans une entreprise (par exemple, une prévision statistique automatisée + une politique de stocks automatisée).

Pour qu’une prévision modifiée ajoute de la valeur, elle doit modifier une décision par défaut (générée à l’aide du processus par défaut de l’entreprise) d’une manière qui affecte directement et positivement les retours financiers de l’entreprise (c’est-à-dire, des dollars, des livres ou des euros de retour).

Si une prévision est plus précise (en termes de prévision de la demande réelle) mais ne conduit pas à une décision différente et meilleure, alors elle n’a pas ajouté de valeur.

De nombreuses entreprises utilisent encore des modèles de prévision basés sur les séries temporelles, alors que Lokad préfère les prévisions probabilistes pour aider à générer des décisions ajustées aux risques. Cependant, la même norme s’applique aux deux paradigmes de prévision. Pour que l’un ou l’autre type de prévision ajoute de la valeur, il doit modifier une décision par défaut de manière à affecter directement et positivement les retours financiers d’une entreprise.

Par exemple, une nouvelle décision (ou « modifiée ») pourrait éliminer directement une rupture de stock future que la décision par défaut aurait entraînée.

« Directement » est essentiel ici. En termes très simples, la prévision n’ajoute de la valeur que si vous pouvez identifier le changement exact de décision qui a influencé les retours financiers supplémentaires ou qui a empêché des pertes financières (par rapport à la décision par défaut).

Pensez causalité, pas corrélation.

Q2 : Une prévision plus précise ajoute-t-elle toujours de la valeur ?

Techniquement, non. Une prévision plus précise, à elle seule, n’« ajoute » pas nécessairement de la valeur. Cela s’explique par le fait que, comme mentionné précédemment, pour que quelque chose (dans ce cas une prévision) ajoute de la valeur, elle doit affecter directement et positivement les retours financiers d’une entreprise grâce à une meilleure décision.

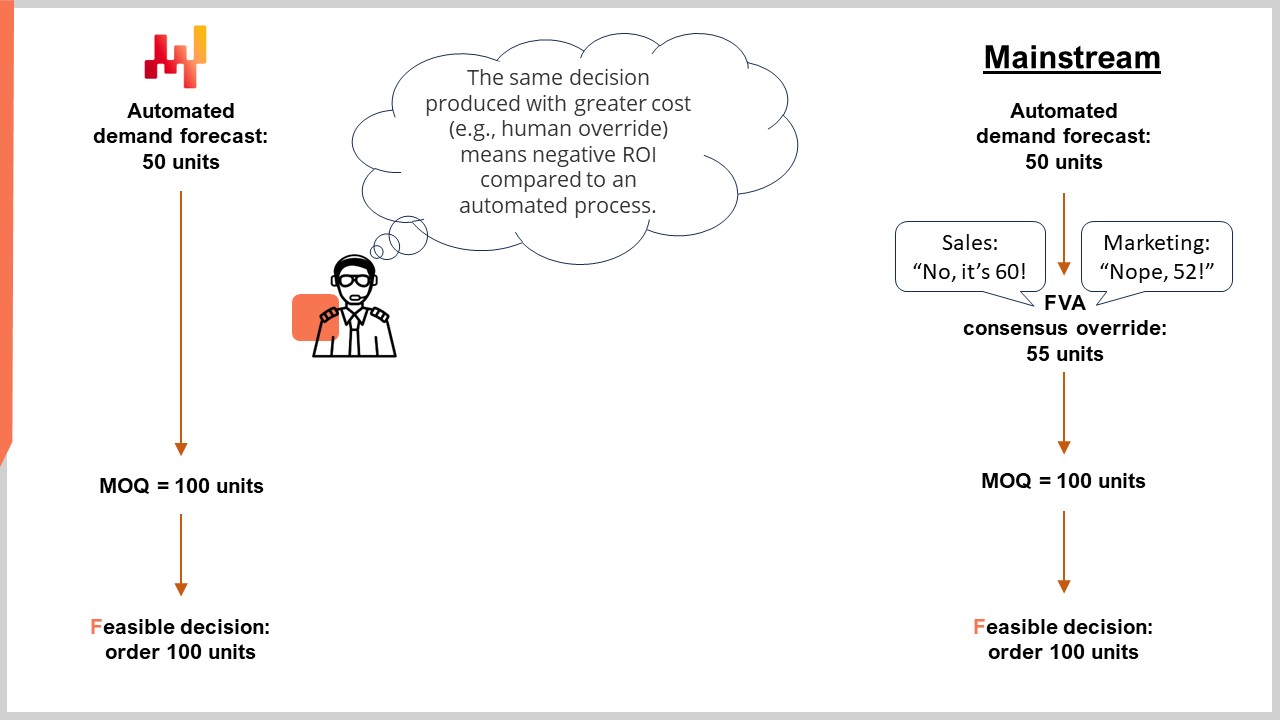

Contrairement aux prévisions, les décisions en supply chain sont soumises à des contraintes de faisabilité (par exemple, les MOQ, multiplicateurs de lot, tailles de lots, etc.) et à des incitations financières (par exemple, remises sur les prix, conditions de paiement, etc.). Il peut y avoir bien plus de prévisions qu’il n’y a de décisions réalisables.

Cela signifie que les décisions en supply chain peuvent parfois (et très souvent) être insensibles aux changements de précision des prévisions. Cela est vrai tant pour les prévisions basées sur les séries temporelles que pour les prévisions probabilistes.

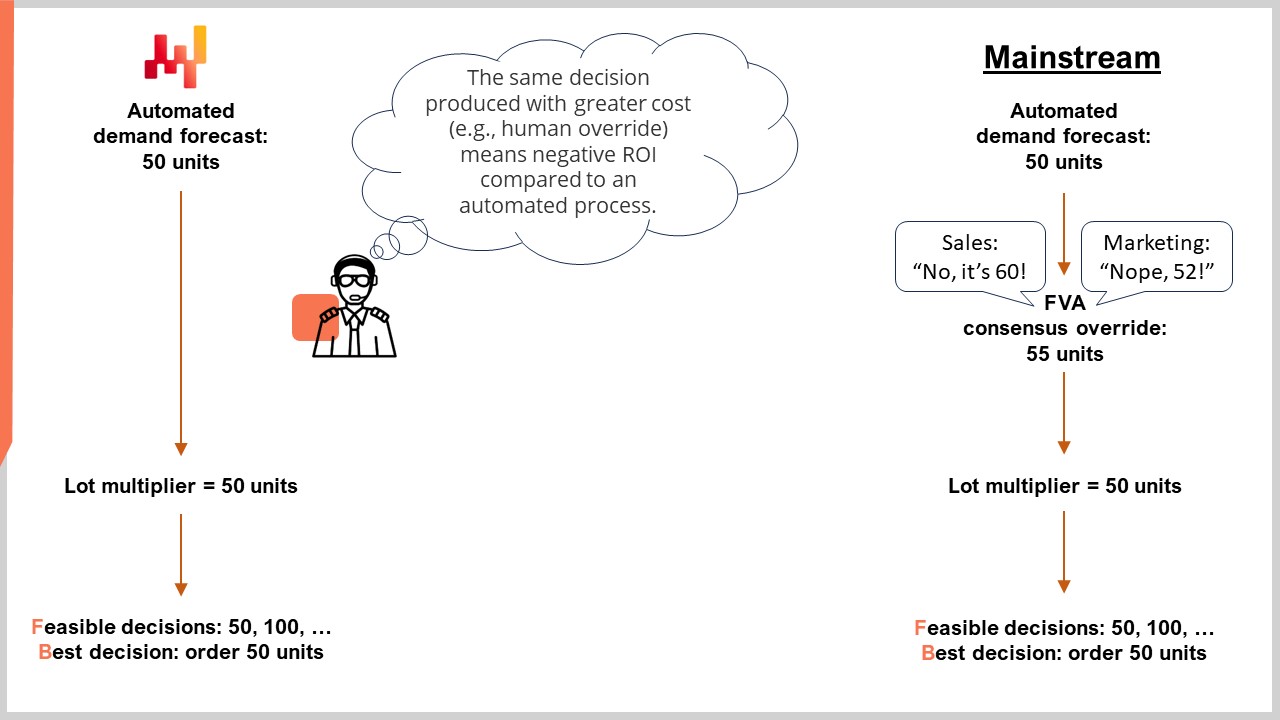

La raison de cette insensibilité réside dans les contraintes de prise de décision (par exemple, les MOQ). Il est tout à fait possible qu’une prévision plus précise (par exemple, 10 % plus précise) aboutisse à la même décision précise qu’une prévision moins précise. Le graphique ci-dessous illustre ce point.

Dans l’exemple ci-dessus, supposons que la prévision consensuelle de 55 unités était plus précise que la prévision automatisée de 50 unités. D’un point de vue financier, l’amélioration de la précision n’a pas entraîné de décision différente (en raison de la présence d’une MOQ). Ainsi, la prévision plus précise n’a pas ajouté de valeur.

En fait, on peut soutenir avec force que la prévision consensuelle plus précise a entraîné une valeur ajoutée négative. En effet, les étapes supplémentaires de révision (conformément à un processus standard de Forecast Value Added) coûtent de l’argent (temps et effort supplémentaires) à l’entreprise, sans pour autant aboutir à une meilleure décision. D’un point de vue purement financier, ces étapes de révision manuelles ont constitué un bilan négatif.

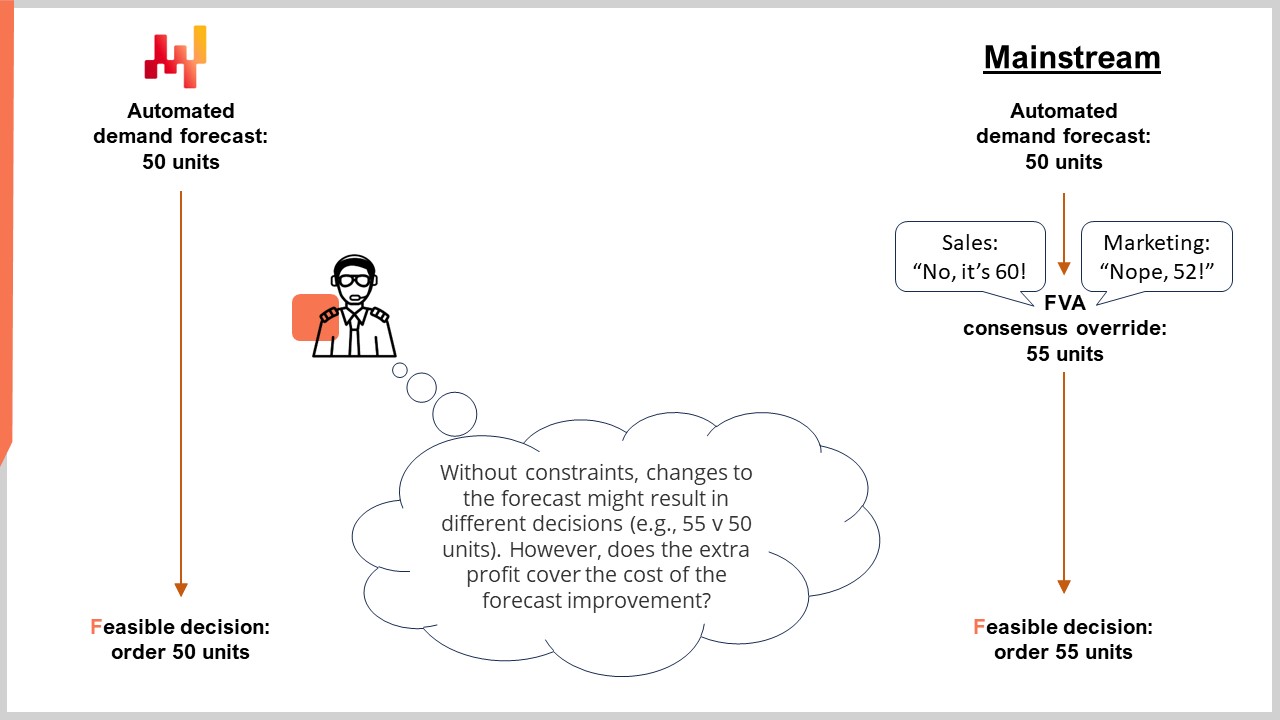

Considérons également un cas où il n’y a pas de contrainte de MOQ.

Imaginez le même scénario global, mais avec un multiplicateur de lot au lieu d’une MOQ. Les décisions réalisables se font par incréments de 50 unités (par exemple, 50 unités dans une boîte ou sur une palette). Dans cette situation, il faudrait acheter soit 50, soit 100 unités (1 ou 2 boîtes ou palettes).

En réalité, il pourrait être moins rentable d’acheter 100 unités (pour couvrir la suggestion de 55 unités de la prévision consensuelle) que d’acheter 50 unités (un peu moins que ce que suggère la prévision « plus précise »). On pourrait essayer de combler la demande restante avec des commandes en souffrance ou simplement perdre des ventes (par exemple, en cas de vente de produits périssables comme des denrées fraîches).

D’un point de vue économique, la meilleure décision financière pourrait ne pas être de suivre la prévision « plus précise ». Dans ce scénario, la prévision automatisée (50 unités de demande) et la prévision consensuelle (55 unités de demande) conduisent à la même décision (commander 50 unités). Ainsi, la prévision « plus précise » n’a pas entraîné une valeur financière accrue.

Certes, toutes les situations ne sont pas soumises aux mêmes contraintes strictes, cependant la supply chain regorge de ce type de scénarios. Bien sûr, je reconnais que différentes prévisions conduiront à des décisions différentes, mais la question de la valeur reste ouverte. Il faut toujours se demander si le rendement supplémentaire attendu de l’achat d’unités supplémentaires est supérieur aux ressources additionnelles consommées pour améliorer la précision des prévisions.

Peut-être que l’extra précision en vaut la peine dans certaines situations. Toutefois, les prévisionnistes et les professionnels de la supply chain semblent supposer instinctivement que cela l’est en termes absolus, malgré le fait qu’il existe des scénarios évidents où ce n’est pas le cas.

Si vous avez imaginé un scénario qui ne correspond pas parfaitement aux exemples décrits ici, ce n’est pas grave. Rappelez-vous, l’objectif aujourd’hui est de démontrer un point général (à savoir qu’il existe des situations où une précision supplémentaire des prévisions ne mérite pas d’être recherchée), et non d’analyser en profondeur chaque scénario possible de prise de décision en supply chain.

Q3 : Comment pouvons-nous nous assurer que la valeur obtenue justifie le coût de l’intervention du jugement ?

Un élément central de la table ronde à Dijon portait sur la valeur (ou non) de l’intervention du jugement (ou « interventions humaines ») dans le processus de prévision. Pour paraphraser l’autre camp, « nous devons avoir des personnes dans la chaîne pour corriger lorsque la prévision automatisée a manqué quelque chose ».

C’est une perspective très intéressante pour moi, car elle présuppose que l’intervention humaine ajoute de la valeur - sinon, pourquoi diable quelqu’un le ferait-il ?

Pour cette section, je vais mettre de côté la discussion sur la capacité ou non des humains à (occasionnellement voire souvent) surpasser une prévision automatisée (en termes de précision). En fait, je suis prêt à reconnaître que, pour n’importe quel SKU, un humain peut être aussi performant, voire même meilleur, qu’une prévision automatisée en termes de précision.

Note : je ne pense pas que cela soit vrai si nous considérons la prévision de dizaines de milliers de SKUs pour des centaines de magasins chaque jour, comme c’est le cas pour une supply chain de grande envergure1. Dans ce dernier scénario, une prévision automatisée surpasse de manière significative des équipes entières de prévisionnistes et autres experts fonctionnels de grand talent, tout simplement parce que la vaste majorité des SKUs ne peut pas être revue manuellement en raison des contraintes de temps.

J’accorde cette concession que le jugement humain peut parfois égaler ou surpasser la prévision automatisée pour deux raisons :

-

À mon avis, cela rend l’essai plus intéressant, et ;

-

La force de mon argument ne repose sur aucune discussion concernant la « précision ».

Ma position est, comme vous pouvez probablement le deviner à présent, que les interventions humaines n’« ajoutent de la valeur » que si elles… ajoutent une valeur financière - une valeur qui perdure au-delà d’un seul cycle de réapprovisionnement. Cela est complètement indépendant de tout bénéfice en termes de précision.

Cette valeur peut être comprise comme « produisant directement de meilleures décisions que celles initialement générées - en prenant en compte les profits supplémentaires issus de la meilleure décision et en soustrayant le coût de l’intervention ».

En termes simples, les interventions du jugement (les interventions humaines) sont coûteuses, et une entreprise devrait donc souhaiter obtenir un retour sur investissement significatif. C’est pourquoi je soutiens que la précision des prévisions est une mesure arbitraire (lorsqu’elle est évaluée en isolation des décisions), et que les entreprises devraient se concentrer sur des actions qui augmentent les retours financiers.

L’intervention humaine peut très bien améliorer la précision des prévisions (encore une fois, je fais cette concession dans un esprit de discussion), mais elle n’augmente pas nécessairement le retour financier. Cela ne devrait vraiment pas être une proposition radicale, de la même manière que quelqu’un peut être à la fois la personne la plus grande dans une pièce et la plus petite dans une autre.

Veuillez noter qu’il n’incombe pas à moi de fournir des preuves que l’augmentation de la précision ne se traduit pas par une hausse des profits. C’est, par définition, la responsabilité de ceux qui soutiennent que l’augmentation de la précision est en soi profitable de fournir des preuves concrètes, directes et incontestables à l’appui de cette affirmation.

Encore une fois, cela ne devrait pas être une position radicale ou anticonformiste. À mon avis, cela devrait être la position par défaut de toute personne investie dans le projet.

Gardez à l’esprit que, pour que les interventions humaines soient rentables, il faut prendre en compte la totalité des interventions. Autrement dit, il convient de comparer la valeur financière générée par tous les ‘succès’ et de soustraire toutes les pertes financières causées par les ‘échecs’.

Cet experiment devrait également être réalisé à grande échelle, pour un réseau énorme de magasins (clients entreprise dans le cas du B2B) et l’ensemble de leur catalogue de SKUs, chaque jour, pendant une période considérable.

« Combien de temps cet experiment devrait-il durer, Alexey ? » À ce sujet, je suis ambivalent. Disons un an, mais je suis très ouvert à la discussion sur ce point. Cela dépend de nombreux facteurs, dont le nombre de cycles de décision par an, ainsi que des délais d’approvisionnement, naturellement.

Cela dit, toute cette discussion soulève la question de savoir quel est le seuil d’erreur acceptable pour l’intervention humaine.

- Si les succès l’emportent légèrement sur les échecs, est-ce acceptable ?

- Qu’en est-il du coût des interventions humaines elles-mêmes ?

- Comment intégrer ces coûts directs et indirects dans le calcul ?

Ce ne sont pas des questions anodines, d’ailleurs. Ce sont le type de questions qu’un étudiant de première année poserait dans n’importe quel cours d’introduction dans un domaine STEM (ou adjacent aux STEM).

Jusqu’à ce que quelqu’un fournisse la preuve définitive que l’intervention humaine, déployée à grande échelle, est financièrement rentable, la position la plus économiquement intelligente est de présumer que ce n’est pas le cas et de continuer à s’appuyer sur les prévisions automatisées et la prise de décision automatisée.

Q4 : Comment déterminer quand une prévision plus précise doit remplacer la prévision actuelle pour la prise de décision ?

En résumé, le moyen le plus simple de le savoir est de se poser la question suivante : la nouvelle prévision conduit-elle à de meilleures décisions ? La métrique d’évaluation, dans ce cas, devrait être le retour sur investissement (ROI).

Pour être un peu plus précis, le remplacement doit être effectué en se basant sur l’utilité comparative globale du nouveau modèle (par exemple, ROI, applicabilité, maintenabilité, etc.), et pas seulement sur son gain d’exactitude actuel. Le ROI est ce qui oriente l’entreprise vers le succès. L’applicabilité, comme je vais le démontrer ci-dessous, est conçue en tenant compte du ROI. N’oubliez pas : l’exactitude est, si elle est poursuivie isolément, un KPI.

Par exemple, imaginez que nous avons deux modèles : l’un qui peut gérer explicitement l’historique des ruptures de stock et un autre qui ignore les ruptures de stock (en utilisant quelques astuces de prétraitement des données). Il se pourrait que les ruptures de stock ne se soient pas produites très souvent, et d’un point de vue décisionnel, les deux modèles performent presque de manière égale. Cependant, il serait quand même plus prudent de privilégier le modèle qui peut gérer les ruptures de stock. Ceci est dû au fait que, si les ruptures de stock commencent à se produire plus fréquemment, ce modèle sera plus fiable.

Cela démontre un autre aspect de la philosophie de Lokad : l’exactitude par conception. Cela signifie qu’au niveau de la conception, nous visons à concevoir un modèle qui prend en compte de manière proactive – et est capable de répondre à – à la fois aux événements probables et improbables. C’est d’une importance capitale car les plus grosses pénalités financières se situent souvent aux extrêmes – c’est-à-dire aux événements improbables.

Q5: Comment passons-nous d’un modèle de prévision à un autre en production ?

Il est important de se rappeler que la prévision n’est qu’une partie de l’ensemble du moteur de prise de décision. En tant que tel, la mise à jour de certaines parties peut avoir des impacts mineurs ou majeurs sur la performance globale du moteur. La transition d’un ancien modèle à un nouveau peut être problématique, même si le nouveau modèle génèrera en fin de compte de meilleures décisions (et donc procurera plus de profits).

Cela s’explique par le fait que, en théorie, les décisions améliorées peuvent faire face à des contraintes inédites en pratique si elles sont mises en œuvre trop rapidement.

Par exemple, un nouveau modèle de prévision pourrait aider à générer des bons de commande (POs) nettement améliorés, mais l’espace requis pour stocker les stocks supplémentaires n’existe peut-être pas encore ou les fournisseurs ne peuvent pas ajuster immédiatement leur supply chain pour satisfaire la demande accrue. Se précipiter pour passer les bons de commande dès maintenant, en quête de profits immédiats, peut entraîner des pertes ailleurs, telles que des stocks endommagés ou se détériorant plus rapidement en raison d’un manque d’espace warehouse adéquat (ou des limites de capacité de la main-d’œuvre).

Dans un tel scénario, il pourrait être judicieux de faire une transition progressive entre les modèles. En pratique, cela pourrait impliquer de passer quelques bons de commande consécutifs légèrement plus importants pour corriger progressivement les positions de stocks, plutôt que de passer immédiatement un seul énorme.

Les personnes ayant une expérience pratique dans la lutte contre le bullwhip effect (y compris les défenseurs du DDMRP) devraient immédiatement comprendre pourquoi il s’agit d’une tactique judicieuse.

Réflexion finale

Si vous êtes arrivé jusque-là, j’apprécie votre attention. Si vous avez été en désaccord en cours de route, j’apprécie encore plus votre attention.

Pour ceux qui ne sont pas d’accord, permettez-moi un dernier argument : la valeur signifie plus d’argent, et plus d’argent vient de meilleures décisions. Quant à moi, rien ne peut remplacer de bonnes (ou meilleures) décisions. Pas une prévision plus précise. Ni un processus S&OP plus efficace.

Si nous ne sommes toujours pas d’accord, tant pis, mais au moins nous savons où nous en sommes tous les deux.

Merci de votre lecture.

Avant de partir

Voici quelques ressources supplémentaires qui pourraient vous être utiles (surtout si vous n’êtes pas d’accord avec moi) :

-

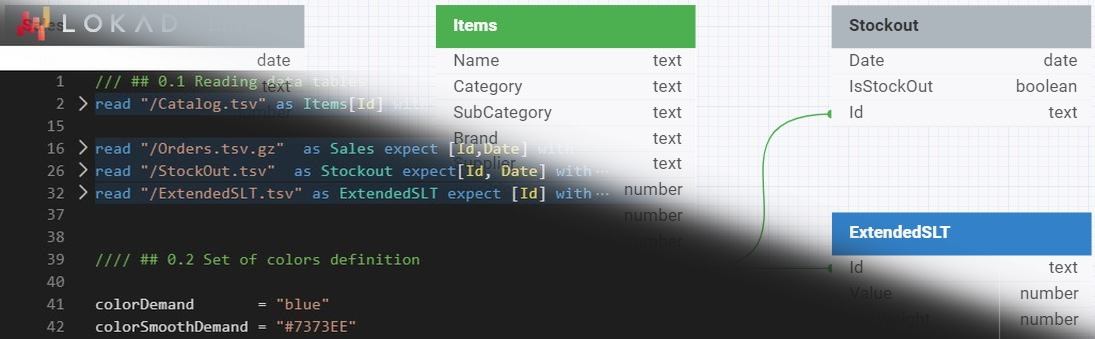

Concernant la manière dont Lokad prévoit en réalité toutes les sources d’incertitude (par exemple, la demande, les délais, les taux de retour, etc.), consultez nos cours vidéo sur la prévision probabiliste et la prévision du délai de livraison.

-

Concernant la manière dont Lokad prend réellement des décisions ajustées au risque, consultez notre tutoriel pédagogique sur l’optimisation des achats et notre cours vidéo sur l’allocation de stocks chez un distributeur.

-

Concernant la manière dont Lokad conçoit la demande et optimise les stratégies de tarification, consultez notre cours vidéo sur l’optimisation des prix.

Notes

-

Les plus grandes supply chain représentent des nombres encore plus importants – des dizaines de milliers de magasins dans plus d’une centaine de pays avec plusieurs centaines de centres de distribution. Les catalogues de ces géants contiennent souvent des centaines de milliers (voire des millions) de produits différents. ↩︎