00:00:08 Einführung und Rob Hyndmans Hintergrund in der Prognose.

00:01:31 Nachhaltigkeit realer Prognosetechniken und Software.

00:04:08 Anwendung von Prognosetechniken in verschiedenen Bereichen mit reichlich Daten.

00:05:43 Herausforderungen, unterschiedlichen Industrien in der supply chain gerecht zu werden.

00:07:30 Navigation durch die Komplexität von Unternehmenssoftware und Datenerfassung.

00:08:00 Zeitreihenprognose und alternative Ansätze.

00:09:05 Herausforderungen, denen Lokad in der prädiktiven Analyse gegenübersteht.

00:11:29 Langlebigkeit und Motivation in der Entwicklung akademischer Software.

00:13:12 Wechsel von Punktprognosen zu probabilistischen Prognosen.

00:15:00 Fehler in akademischen Methoden und deren Umsetzung in der Praxis.

00:16:01 Leistung eines einfachen Modells in einem Wettbewerb.

00:16:56 Die Bedeutung eleganter und prägnanter Methoden.

00:18:48 Ausgewogenheit zwischen Genauigkeit, Komplexität und Kosten in Modellen.

00:19:25 Robustheit und Geschwindigkeit in R-Paketen für die Prognose.

00:20:31 Ausgewogenheit von Robustheit, Genauigkeit und Implementierungskosten im Geschäftsbereich.

00:21:35 Bedeutung problem-spezifischer Methoden in der Prognose.

00:23:00 Vorhersage der Langlebigkeit von Prognosetechniken und Bibliotheken.

00:25:29 Robs Engagement für die Pflege seiner Prognosebibliotheken.

00:26:12 Vorstellung von Fable und dessen Anwendung in der Zeitreihenprognose.

00:27:03 Würdigung der Open-Source-Welt und deren Einfluss auf Prognosewerkzeuge.

Zusammenfassung

In einem Interview mit Kieran Chandler diskutieren Joannes Vermorel, Gründer von Lokad, und Rob Hyndman, Professor für Statistik an der Monash University, die Nachhaltigkeit realer Prognosetechniken. Hyndmans Open-Source-Prognose-Software, die von Millionen Nutzer*innen heruntergeladen wurde, hat die Zeit überdauert und ist in der Lage, etwa 90 % der Prognoseprobleme von Unternehmen zu lösen. Die Gäste heben die Herausforderungen bei der Betreuung eines breiten Publikums mit unterschiedlichen Bedürfnissen in der supply chain industry hervor und betonen die Bedeutung der Entwicklung benutzerfreundlicher Software, die effektiv und zugänglich ist. Sie unterstreichen auch die Bedeutung von Open-Source-Software und Zusammenarbeit bei der Entwicklung hochwertiger forecasting methods.

Erweiterte Zusammenfassung

In diesem Interview diskutiert Kieran Chandler die Nachhaltigkeit realer Prognosetechniken mit Joannes Vermorel, Gründer von Lokad, und Rob Hyndman, Professor für Statistik an der Monash University. Hyndmans Open-Source-Prognose-Software wurde von Millionen Nutzer*innen heruntergeladen und hat sich als langlebig erwiesen – im Gegensatz zu vielen anderen Software-Tools.

Vermorel schätzt Hyndmans Arbeit, da sie über typische akademische Software hinausgeht, indem er einen umfassenden Satz von Bibliotheken erstellt hat, embedding viele seiner eigenen Ergebnisse einbettet und einen konsistenten Rahmen basierend auf der populären Programmiersprache R für statistische Analysen bereitstellt. Vermorel ist der Ansicht, dass es nur wenige Beispiele wissenschaftlicher Software gibt, die so beständig sind und ein so großes Publikum erreichen.

Hyndmans akademische Forschung beschränkt sich nicht nur auf die Prognose in der supply chain; er ist daran interessiert, Prognosetechniken in jedem Bereich anzuwenden, in dem große Mengen an Daten vorhanden sind. Seine Arbeiten umfassen die Prognose des Stromverbrauchs, der Sterblichkeitsraten, der Bevölkerungsentwicklung, der Touristenzahlen und jüngst auch der COVID-19-Fälle für die australische Regierung. Zusätzlich zur Prognose arbeitet er auch an der Anomalieerkennung und explorativen Datenanalyse.

Im Gespräch über die Herausforderungen, ein breites Publikum mit unterschiedlichen Bedürfnissen in der supply chain zu bedienen, erklärt Vermorel, dass die Art und Weise, wie Daten von enterprise software (ERPs, MRPs, WMS) wahrgenommen und erfasst werden, oft halb zufällig erfolgt.

Sie sprechen die Schwierigkeiten an, die sich aus der Nutzung von Daten ergeben, die nicht primär für Prognosezwecke erhoben wurden, und den Übergang von einem enterprise resource planning (ERP)-System zu einem anderen.

Vermorel hebt die Bedeutung von Prognosen in Kontexten hervor, die sich nicht der time series Analyse eignen, wie zum Beispiel in der Mode, wo Demand Engineering und die Einführung von new products die Prognoseproblematik beeinflussen. Er betont die Notwendigkeit, prädiktive Modelle so zu gestalten, dass sie Feedback-Loops und auf Prognosen basierende Maßnahmen berücksichtigen, ebenso wie die Kontrolle verschiedener Faktoren wie Produktauswahl und promotion. Dieser vielschichtige Ansatz ist entscheidend für Lokad, um die komplexen Herausforderungen in der prädiktiven Analyse zu bewältigen.

Hyndman erklärt, dass seine Zeitreihen-Software in der Lage ist, etwa 90 % der Prognoseprobleme von Unternehmen zu lösen, während die verbleibenden 10 % andere Ansätze erfordern. Er spricht auch das Problem kurzlebiger akademischer Software an, das er auf den Fokus auf Publikationen und den Mangel an Anreizen zur langfristigen Pflege von Software zurückführt. Dies führt zu einem Mangel an Zusammenarbeit mit Praktikern und dazu, dass Methoden nicht ausreichend dokumentiert und nachhaltig sind.

Das Interview hebt die Herausforderungen und Komplexitäten der Optimierung und Prognose in der supply chain hervor, einschließlich der Notwendigkeit anpassungsfähiger Techniken, der Bedeutung, kontextbezogene (nicht-Zeitreihen-) Szenarien zu berücksichtigen, und dem Einfluss von Feedback-Loops und decision-making auf prädiktive Modelle. Zusätzlich unterstreicht es die Kluft zwischen akademischer Forschung und praktischer Anwendung im Bereich der Prognose.

Beide Gäste betonen die Bedeutung der Entwicklung benutzerfreundlicher Software, die effektiv und zugänglich ist, um einen Unterschied in der Welt zu machen.

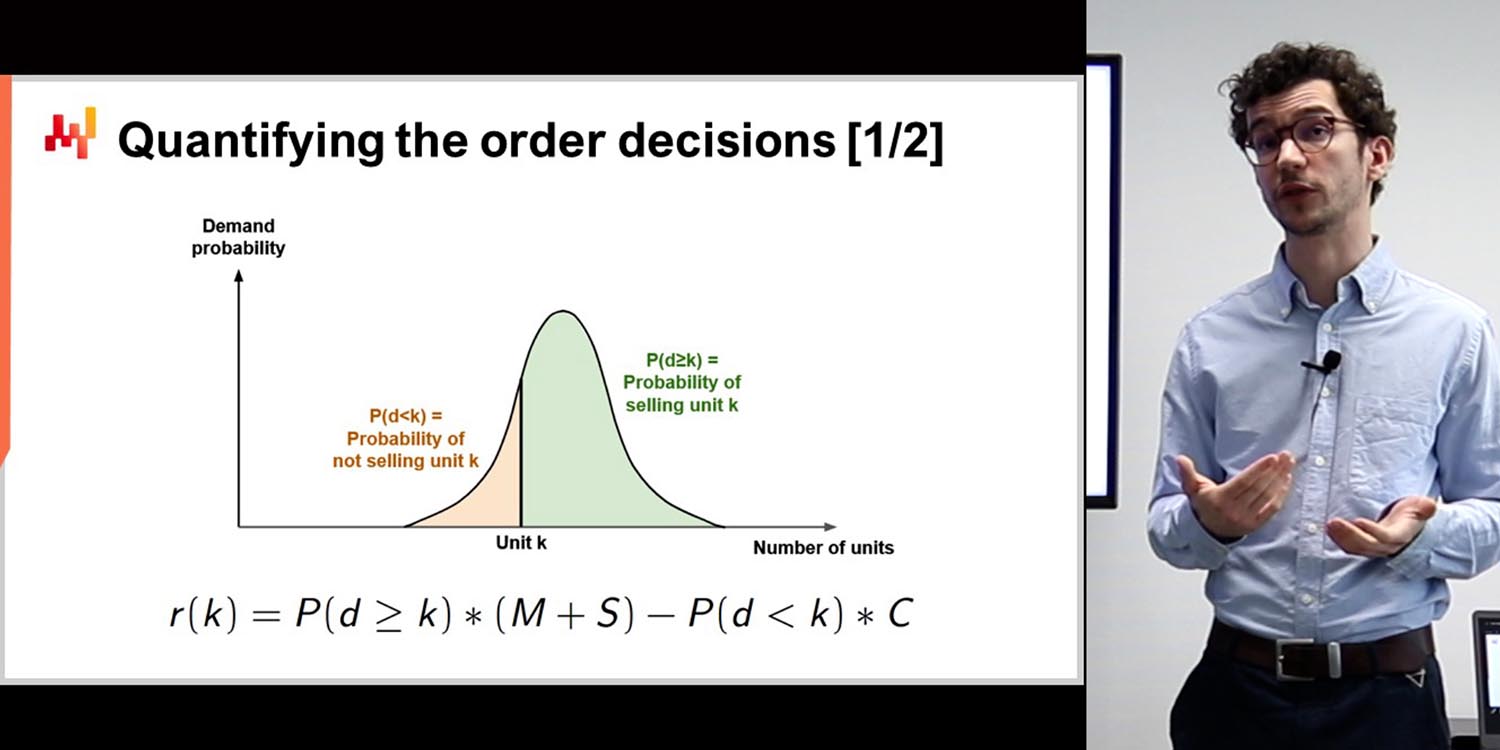

Hyndman erwähnt den Wechsel von Punktprognosen zu probabilistic forecasting in der akademischen Literatur der letzten 15 Jahre. Lokad war eines der ersten Unternehmen im Bereich supply chain Prognose, das diese Veränderung in seine Software integriert hat. Da sich Hyndmans ursprüngliche Software auf Punktprognosen konzentrierte, legen seine neueren Pakete den Schwerpunkt auf probabilistische Prognosen.

Vermorel weist auf die versteckten Schwächen vieler akademischer Publikationen hin, wie numerische Instabilität, übermäßige Rechenzeit oder komplexe Implementierungen. Er betont außerdem die Bedeutung, eine Balance zwischen accuracy und Einfachheit zu finden, da zu komplizierte Modelle möglicherweise nicht praktikabel oder notwendig sind. Vermorel führt ein Beispiel aus dem M5-Wettbewerb an, bei dem Lokad mit einem relativ einfachen Modell eine hohe Genauigkeit erreichte.

Hyndman stimmt zu, dass es wesentlich ist, die Kosten für Softwareentwicklung, Rechenaufwand und Genauigkeit in Einklang zu bringen. Beide Gäste schätzen prägnante, elegante Prognosemethoden mit breiter Anwendbarkeit, wie sie in Hyndmans Bibliotheken zu finden sind.

Das Gespräch wirft Fragen zu den trade-offs zwischen Genauigkeit und Komplexität in Prognosemodellen auf. Vermorel hinterfragt die Weisheit, einen geringen Genauigkeitsgewinn auf Kosten einer viel höheren Komplexität anzustreben, wie es bei Deep-Learning-Modellen der Fall ist. Sowohl Vermorel als auch Hyndman betonen die Bedeutung, sich auf das Wesentliche guter Prognosen zu konzentrieren, ohne sich in marginalen Verbesserungen zu verlieren, die die zusätzliche Komplexität nicht rechtfertigen.

Hyndman betont, wie wichtig es ist, sowohl die Genauigkeit als auch die Rechenkosten bei der Entwicklung von Prognosemethoden zu berücksichtigen. Er schreibt die Robustheit seiner Prognosepakete deren Ursprüngen in Beratungsprojekten zu, in denen sie schnell, zuverlässig und in verschiedenen Kontexten einsetzbar sein mussten.

Vermorel unterstreicht die Bedeutung, den Mehrwert zu berücksichtigen, den eine Prognosemethode für ein Problem bringt. Er stellt einfache parametrische Modelle komplexeren Methoden wie Gradient-Boosting-Bäumen gegenüber und weist darauf hin, dass in manchen Fällen einfachere Modelle ausreichend sein können. Vermorel diskutiert auch die spezifischen Herausforderungen der Prognose in Branchen wie Mode und dem automobilen Aftermarket, in denen Substitution und Kompatibilitätsfaktoren eine bedeutende Rolle spielen.

Die Gesprächspartner betonen, dass man sich nicht von ausgefeilter Technik ablenken lassen sollte, da diese nicht zwangsläufig zu besseren wissenschaftlichen oder genaueren Ergebnissen führt. Vermorel prognostiziert, dass grundlegende Techniken der Zeitreihenprognose auch in 20 Jahren noch relevant sein werden, während komplexe Methoden, die auf aktueller Hardware basieren, veraltet sein könnten.

Rob Hyndman spricht über seine Arbeit im Bereich der Prognose, insbesondere über die Entwicklung des Open-Source-Softwarepakets “Fable”, das den Prognoseprozess für Tausende von Zeitreihen gleichzeitig vereinfacht. Er betont sein Engagement, das Paket mindestens 10 Jahre lang zu pflegen, und hebt die Vorteile von Open-Source-Software hervor, darunter Zusammenarbeit und Zugänglichkeit.

Sowohl Vermorel als auch Hyndman betonen die Bedeutung von Open-Source-Software in ihrer Arbeit und das Potenzial zur Zusammenarbeit bei der Entwicklung hochwertiger Prognosemethoden. Hyndman erwähnt außerdem sein Engagement für die Pflege öffentlicher Bibliotheken, die es bereits seit 2005 gibt, und die Rolle, die sie dabei spielen, Datenanalysen der Öffentlichkeit zugänglich zu machen.

Insgesamt unterstreicht das Interview die Herausforderungen der Prognose in einer komplexen und sich schnell verändernden Welt sowie die Bedeutung von Software und Zusammenarbeit bei der Entwicklung effektiver Lösungen. Der Fokus auf Open-Source-Software und öffentlichen Zugang unterstreicht den Wert, Datenanalyse und Prognosen einem breiteren Publikum zugänglich zu machen.

Beide Interviewpartner schätzen den Open-Source-Charakter ihrer Arbeit, der einen breiten Zugang und Zusammenarbeit bei der Entwicklung hochwertiger Prognosemethoden ermöglicht.

Vollständiges Transkript

Kieran Chandler: Prognose ist eine uralte Praxis, die sich ständig wandelt, und dementsprechend bleiben viele Softwarelösungen nicht dauerhaft bestehen. Eine Person, die diesem Trend entgegengewirkt hat, ist unser heutiger Gast, Rob Hyndman, der Open-Source-Software implementiert hat, die von Millionen Nutzer*innen heruntergeladen wurde. Heute werden wir mit ihm die Nachhaltigkeit realer Prognosetechniken diskutieren. Also, Rob, vielen Dank, dass du dich live aus Australien zugeschaltet hast. Ich weiß, dass es bei dir etwas spät am Tag ist. Wie immer beginnen wir gerne damit, ein wenig über unsere Gäste zu erfahren, also erzähle uns vielleicht zunächst etwas über dich.

Rob Hyndman: Danke, Kieran, es ist schön, hier zu sein. Ja, es ist hier in Australien 20 Uhr, also gar nicht so spät. Ich bin Professor für Statistik und Leiter der Abteilung für Ökonometrie und Wirtschaftsstatisik an der Monash University. Ich bin seit 26 Jahren dort. Während der meisten dieser Zeit war ich außerdem Chefredakteur der International Journal of Forecasting und von 2005 bis 2018 Direktor des International Institute of Forecasters. Ich bin Akademiker; ich schreibe viele Artikel und habe mehrere Bücher geschrieben, darunter drei über Prognosen. Wenn ich das nicht tue, spiele ich meistens Tennis.

Kieran Chandler: Schön, ich spiele selbst im Sommer gern Tennis. Vielleicht sehen wir uns eines Tages zu einem Spiel. Joannes, heute geht es um die Nachhaltigkeit realer Prognosetechniken und die Idee, dass eine piece of software nachhaltig sein und lange Bestand haben kann. Was steckt dahinter?

Joannes Vermorel: Die meisten Softwarelösungen verfallen im Laufe der Zeit aus verschiedenen Gründen. Gerade bei wissenschaftlicher Software muss man bedenken, wie diese entsteht. Meistens wird sie zur Unterstützung der Veröffentlichung eines Artikels entwickelt und ist somit eigentlich Wegwerfsoftware. Was ich an Professor Hyndmans Arbeit besonders bemerkenswert finde, ist, dass er über das hinausgegangen ist, was in akademischen Kreisen üblich ist – nämlich Wegwerfsoftware zu erstellen, den Artikel zu veröffentlichen und danach zum nächsten überzugehen. Er hat tatsächlich eine umfangreiche Sammlung von Bibliotheken entwickelt, die nicht nur viele seiner eigenen Ergebnisse und die Ergebnisse seiner Kollegen integriert, sondern auch einen sehr konsistenten Rahmen basierend auf einer Sprache bereitstellt, die äußerst populär wurde, nämlich R, für statistische Analysen. Dies hat sich über mehrere Jahrzehnte bewährt und ist eine beachtliche Leistung. Die meiste Software, die wir heute sehen, ist alt und beruht oft auf wenigen Grundlagen, die aus Unix und ähnlichen Systemen stammen. Im Bereich der data science gibt es nur wenige Beispiele von Software, die den Test der Zeit bestanden hat, abgesehen von grundlegenden Bausteinen der linearen Algebra und ähnlichen Disziplinen.

Kieran Chandler: … Analyse, aber wenn man wirklich darüber nachdenkt, könnte ich wahrscheinlich ein Dutzend Beispiele für Software nennen, die es geschafft haben, ein so großes Publikum zu erreichen und dauerhaft zu bestehen. Allerdings gibt es tatsächlich nicht allzu viele. Ich glaube, dass hier etwas sehr Bemerkenswertes vorliegt, das über das hinausgeht, was in der akademischen Forschung üblich ist. Rob, lass uns etwas mehr über deine akademische Forschung sprechen. Du konzentrierst dich offensichtlich nicht nur auf die Welt der supply chain, wie wir es hier tun. Für welche anderen Bereiche interessierst du dich, um Prognosetechniken anzuwenden?

Rob Hyndman: Ich interessiere mich für alles, wo ich viele Daten erhalten kann. Ich mache beispielsweise Prognosen zum Stromverbrauch, wo es seit Jahrzehnten sehr gute Daten gibt. Ich prognostiziere Sterberaten, Bevölkerungszahlen und in letzter Zeit habe ich an Touristenzahlen gearbeitet, was mitten in einer Pandemie ziemlich schwierig vorherzusagen ist. Ich habe der australischen Regierung dabei geholfen, sich Gedanken darüber zu machen, wie das funktioniert. Eine weitere Aufgabe, die ich für die australische Regierung übernehme, ist die Vorhersage von COVID-19-Fällen. Es ist mein erster Versuch, etwas im epidemiologischen Bereich zu unternehmen, und ich musste einiges über den epidemiologischen Modellierungsansatz lernen und in einige Prognose-Ensembles einbauen. Das war interessant. Im Wesentlichen, wenn es reichlich Daten gibt, interessiere ich mich dafür, sie zu modellieren. Ich mache auch Dinge wie Anomalieerkennung und explorative Datenanalyse, wo große Datensammlungen vorhanden sind. Ich habe mit vielen Unternehmen und Regierungsorganisationen zusammengearbeitet, und wenn sie mit einem Problem auf mich zukommen, das sehr viele Daten beinhaltet, überlege ich, wie man bessere Prognosen erzielen kann als das, was derzeit geschieht.

Kieran Chandler: Großartig, ich kann mir vorstellen, dass die Tourismusbranche im Moment ziemlich interessant ist. Sie ist aus der Prognoseperspektive eine echte Anomalie. Johannes, unser Fokus liegt offensichtlich auf der supply chain Branche, aber die Idee ist, dass wir uns nicht nur auf eine einzige Branche darin konzentrieren. Wir bedienen ein sehr breites Publikum – mit welchen Herausforderungen kannst du rechnen, wenn du versuchst, so vielen verschiedenen Menschen mit so unterschiedlichen Bedürfnissen gerecht zu werden?

Joannes Vermorel: Zunächst einmal ist es einfach die Art und Weise, wie wir die Welt wahrnehmen. Wir verfügen nicht über etwas, das einer wissenschaftlichen Messung gleichkäme, wie beispielsweise festgelegte Statistiken zu Sterblichkeitsraten oder Ähnlichem. Was vorhanden ist, ist Unternehmenssoftware, wie ERPs, MRPs und WMS, die Daten fast zufällig erzeugt oder aufzeichnet. Die Datenerfassung war nicht der Grund, warum all diese Software implementiert wurde, weswegen man am Ende Aufzeichnungen hat, die jedoch nicht als Werkzeuge konzipiert wurden, um Messungen im Zeitverlauf durchzuführen, die man prognostizieren könnte. Es handelt sich dabei beinahe um ein zufälliges Nebenprodukt, und das schafft jede Menge Komplikationen. Eine der Herausforderungen besteht darin, ob man im Hinblick auf Prognosetechniken und fokussierte Forschung etwas entwickeln kann, das den Wechsel von einem ERP zum nächsten übersteht. Wenn du das System änderst – was sehr chaotisch und zufällig erfolgt – musst du berücksichtigen, wie sich das auf den Prognoseprozess auswirkt.

Kieran Chandler: Das nächste Thema, das ich besprechen möchte, ist die unterschiedliche IT-Landschaft und die historischen Zufälle beim Einsatz verschiedener Unternehmenssoftware-Tools. Wenn du die Methode komplett ändern musst, baust du offensichtlich kein Fundament an Wissen oder Techniken auf. Eine der Herausforderungen ist, ob man in diesem Bereich überhaupt etwas bewirken kann. Und aus unserer Perspektive bei Lokad sind die Prognosen, die uns am meisten interessieren, typischerweise Dinge, die sich nicht natürlich als Zeitreihen darstellen. Was machst du, wenn du ein Problem hast, das sich nicht bequem als Zeitreihe formulieren lässt? Du brauchst trotzdem etwas, das einer Prognose ähnelt, aber es zeigt sich auf ganz andere Weise. Rob, was hältst du von Alternativen zu Zeitreihen-Prognosen?

Rob Hyndman: Nun, es hängt – wie Joannes schon sagte – sehr stark von den Daten ab, um zu bestimmen, welche Art von Modell für dieses spezielle Problem erforderlich ist. Meine Zeitreihen-Software bewältigt viele Probleme, aber nicht alle. Einige Unternehmen haben Datensätze so eingerichtet oder aufgezeichnet, dass sie diese modifizieren oder mit einer anderen Lösung arbeiten müssen. Die von mir entwickelte, am meisten genutzte Software löst 90 % der Prognoseprobleme von Unternehmen; bei den restlichen 10 % musst du andere Ansätze verfolgen.

Kieran Chandler: Wie oft würdest du sagen, dass es in deiner Erfahrung diesen 10%-Fall gibt, Joannes?

Joannes Vermorel: Es ist ein sehr subtiles Problem. Meine eigene Reise durch die Welt der Prognosen bei Lokad brachte mir die Erkenntnis, wie tiefgehend das Thema ist. Zunächst gingen wir von punktuellen Prognosen zu probabilistischen Prognosen über, was die Art und Weise, wie wir das Problem betrachten, veränderte. Aber es ist noch viel fundamentaler. Nehmen wir zum Beispiel die Mode: Das Problem besteht darin, die Nachfrage zu prognostizieren, damit du weißt, was produziert werden soll. Wenn du jedoch entscheidest, was du produzieren willst, hast du die Flexibilität, mehr oder weniger Produkte in dein Sortiment aufzunehmen. Das bloße Vorhandensein von Zeitreihen, die du prognostizieren könntest, hängt also von deinen Entscheidungen ab. In der Mode ist es beispielsweise so, dass die Einführung eines zusätzlichen Produkts in deinem Sortiment Teil des Prognoseproblems ist. Du willst nicht nur die Nachfrage vorhersagen, sondern sie auch beeinflussen. Auf unserer Reise erkannten wir, dass es irreduzible Unsicherheiten gab, die uns eine Perspektive bieten, die völlig orthogonal zur klassischen punktuellen Prognose ist. Gleichzeitig müssen wir aber auch mit all den Rückkopplungsschleifen zurechtkommen.

Kieran Chandler: Also, Joannes, kannst du uns sagen, wie sich prädiktive Modelle auf die Optimierung der supply chain auswirken?

Joannes Vermorel: Wenn wir eine Prognose erstellen, treffen wir eine fundiertere Entscheidung. Das hat tiefgreifende Auswirkungen darauf, wie wir unsere prädiktiven Modelle aufbauen. Dann können wir zusätzliche Variablen hinzufügen, wie etwa die Steuerung des Sortimentsumfangs, Preisniveaus, Botschaften und sogar die Promotion von Produkten. Nehmen wir das Beispiel Mode: Du prognostizierst die Mengen, die du haben möchtest, und entscheidest dann, dass in deinen Geschäften manche Produkte deutlich permanenter platziert werden als andere. Das hat tiefgreifende Auswirkungen auf das, was du beobachten wirst. Die Herausforderung, der sich Lokad im Bereich prädiktiver Analysen stellen musste, bestand darin, Probleme aus den zahlreichen Blickwinkeln zu betrachten, die sich darstellen und die die reine Zeitreihenperspektive verkomplizieren.

Kieran Chandler: Okay, Rob, lass uns nun das Gespräch aus akademischer Sicht fortsetzen. Viele entwickeln Software rein für ein Paper, und dann wird sie fast weggeworfen. Warum denkst du, dass es bei manchen dieser Softwareprodukte an Langlebigkeit mangelt?

Rob Hyndman: Nun, man muss an die Motivation der meisten Akademiker denken. Sie werden dafür bezahlt, Papers zu schreiben und Vorlesungen zu halten. Sobald das Paper verfasst ist, gibt es vielleicht einen Anreiz, etwas Software herauszugeben, um es zu implementieren. Aber für die meisten Akademiker gibt es dafür keinen wirklichen Anreiz, und ganz zu schweigen davon, die Software über lange Zeiträume zu pflegen. Wer es tut, tut es aus Leidenschaft oder weil es ein Herzensprojekt ist. Es ist nicht wirklich das, wofür sie bezahlt werden – es ist nicht ihr Kerngeschäft. Ich glaube, das ist ein Problem in der akademischen Welt. Es wird so sehr darauf geachtet, neue Methoden zu entwickeln und zu veröffentlichen, dass die Verbindung zur praktischen Anwendung und die Gewährleistung, dass deine Methoden gut dokumentiert und als benutzerfreundliche Software langfristig verfügbar sind, zu kurz kommt. Es ist ein Motivationsproblem in der akademischen Welt. Meine Motivation ist, dass ich, wenn ich eine neue Methodik entwickle, möchte, dass sie von den Menschen genutzt wird. Ich will nicht einfach nur ein Paper veröffentlichen, das – wenn ich Glück habe – von einem Dutzend oder vielleicht 100 Leuten gelesen wird. Ich möchte, dass meine Methoden tatsächlich einen Unterschied in der Welt machen. Ganz abgesehen davon, wofür ich bezahlt werde, tue ich das, weil es mir große Zufriedenheit bereitet, wenn ich sehe, dass meine Methoden in der Praxis Anwendung finden.

Joannes Vermorel: Prädiktive Modelle sind immer komplizierter geworden, und es ist nicht einfach, sie robust zu gestalten. Bei Lokad müssen wir eine Menge alten Codes pflegen, um unsere Modelle am Laufen zu halten. Die Herausforderung besteht darin, dass man nicht einfach ein ausgeklügeltes Modell entwickeln und es dann dabei belassen kann. Man muss erklären können, was das Modell tut und warum es das tut. Es muss gut dokumentiert sein, und die Anwender müssen es in der Praxis nutzen können. Das ist nicht einfach, aber es ist wichtig, wenn du möchtest, dass deine Modelle übernommen werden.

Rob Hyndman: Ich finde es auch interessant, dass sich im Laufe der Zeit – wenn sich die Gegebenheiten ändern – neue Methoden entwickeln, sodass man neue Software oder Werkzeuge bereitstellen muss, die diese Entwicklungen in der Prognose berücksichtigen. Eine davon, die Joannes erwähnt hat, ist der Übergang von punktuellen zu probabilistischen Prognosen, der in den letzten etwa 15 Jahren in der akademischen Literatur vollzogen wurde, und Lokad war sehr schnell dabei, das aufzugreifen und probabilistische Prognosen zu liefern. Ich denke, wir waren wahrscheinlich eines der ersten Unternehmen im Bereich der supply chain Prognosen weltweit, das das getan hat. Meine ursprüngliche Software, obwohl sie probabilistische Prognosen erzeugte, legte stets den Schwerpunkt auf die punktuellen Prognosen,

Kieran Chandler: In den letzten Jahren hat sich der Schwerpunkt umgekehrt. Zuerst kommen probabilistische Prognosen, und punktuelle Prognosen folgen als Zweites.

Joannes Vermorel: Eine meiner eigenen Kritiken an vielen akademischen Veröffentlichungen ist, dass man meist mit einer Menge versteckter Fehler in den Methoden endet. Du hast eine Methode, von der du weißt, dass sie bei einem Benchmark übertrifft, aber wenn du sie in einer tatsächlichen Implementierung einsetzen willst, merkst du beispielsweise, dass sie numerisch extrem instabil ist oder dass die Berechnungszeiten derart absurd lang sind, dass bereits ein Toy-Datensatz Tage an Rechenzeit benötigt. Und wenn du einen realen Datensatz verwenden willst, könnte das buchstäblich Jahre an Rechenzeit bedeuten.

Und es können alle möglichen Probleme auftreten, etwa dass die Methode teuflisch kompliziert zu implementieren ist und selbst wenn du sie theoretisch richtig hinbekommst, in der Praxis immer ein dummer Fehler auftaucht, der dich daran hindert, etwas zu erreichen. Oder vielleicht hat die Methode unglaublich subtile Abhängigkeiten von einer langen Reihe von Meta-Parametern, sodass es fast wie eine dunkle Kunst erscheint, sie zum Laufen zu bringen, weil du etwa 20 obskure Parameter hast, die du in völlig undokumentierter Weise anpassen musst – und das nur im Kopf der Forscher, die die Methode entwickelt haben.

Rob Hyndman: Das ist sehr interessant, denn wenn ich mir Methoden ansehe, die dem Test der Zeit standhalten, liefern viele super klassische Ansätze, wie beispielsweise von dir, Hyndman, entwickelte Methoden, überraschend gute Ergebnisse im Vergleich zu sehr ausgeklügelten Verfahren. Beim M5-Wettbewerb im letzten Jahr belegte Lokad den sechsten Platz unter 909 Teams, was die Prognosegenauigkeit der punktuellen Prognose betrifft. Und das haben wir mit einem Modell erreicht, das super einfach war – fast das klassische parametrische Prognosemodell aus dem Lehrbuch – und wir haben einen kleinen Trick des ETS-Modellings darauf angewandt, um im Grunde den „Shotgun-Effekt“ sowie die probabilistische Verteilung zu erzielen. Aber alles in allem war es wahrscheinlich ein Modell, das wir auf einer einzigen Seite mit ein paar Koeffizienten für die Saisonalitäten, den Wochentag, die Woche des Monats, die Woche des Jahres zusammenfassen konnten – und das war’s. Also waren wir buchstäblich nur einen Prozentpunkt entfernt vom genauesten Modell, das Gradient Booster Trees einsetzte, und ich vermute, dass wir hinsichtlich Code-Komplexität, Modellkomplexität und allgemeiner Undurchsichtigkeit von etwas sprechen, das um zwei, wenn nicht sogar drei Größenordnungen komplexer ist.

Joannes Vermorel: Das ist etwas, woran ich den Erfolg eurer Bibliotheken glaube. Was mir an den Methoden wirklich gefällt, ist, dass die meisten von ihnen elegant implementiert und prägnant sind. So gibt es – was die Anwendbarkeit betrifft – etwas zutiefst Wahres daran, dass man Genauigkeit mit minimalem Aufwand und minimalem Aufhebens erzielt, im Gegensatz – würde ich sagen – zum anderen Lager, dem Deep Learning Lager. Ich habe nichts gegen Deep Learning, wenn du unglaublich schwierige Probleme angehen willst, wie zum Beispiel…

Kieran Chandler: Willkommen zur Episode. Heute haben wir Joannes Vermorel, den Gründer von Lokad, und Rob Hyndman, Professor für Statistik und Leiter der Abteilung für Ökonometrie und Business Statistics an der Monash University. Lassen Sie uns über maschinelle Übersetzung und Modellgenauigkeit diskutieren.

Joannes Vermorel: Ich hinterfrage die Weisheit, ein Modell zu haben, das um einen Prozentpunkt genauer ist, aber Millionen von Parametern nutzt und unglaublich komplex sowie undurchsichtig ist. Ist es aus wissenschaftlicher Sicht wirklich besser? Vielleicht sollten wir uns nicht so sehr ablenken lassen, einen Prozentpunkt mehr Genauigkeit zu erreichen – um den Preis von etwas, das tausendmal komplexer ist. Es besteht die Gefahr, völlig den Überblick zu verlieren. Gute Wissenschaft, besonders in der Prognose, sollte sich auf das Wesentliche konzentrieren, was eine gute Vorhersage ausmacht, und Ablenkungen beiseite lassen, die zwar ein klein wenig zusätzliche Genauigkeit bringen, aber möglicherweise um den Preis enormer zusätzlicher Verwirrung.

Rob Hyndman: Man muss die beiden Kosten abwägen: die Kosten für die Entwicklung der Software und die tatsächlichen Rechenkosten sowie die Kosten für Genauigkeit. In der akademischen Welt liegt der Fokus üblicherweise auf Genauigkeit, ohne die Kosten für Rechenleistung oder Code-Entwicklung zu berücksichtigen. Ich stimme dir zu, Joannes, dass wir beides in Betracht ziehen müssen. Manchmal möchte man nicht unbedingt die genaueste Methode, wenn es zu viel Zeit in Anspruch nimmt, sie sowohl zu warten als auch zu berechnen. Meine Prognosepakete sind robust, weil sie in Beratungsprojekten entwickelt wurden. Diese Funktionen kamen in unterschiedlichen Kontexten zum Einsatz und mussten daher relativ robust sein. Ich wollte nicht, dass Unternehmen zu mir zurückkommen und sagen, es ist kaputt oder es funktioniert mit ihrem Datensatz nicht. Die Tatsache, dass ich viel Beratung gemacht habe, bedeutet, dass diese Funktionen bereits in vielen Datensätzen erprobt wurden, bevor sie der Öffentlichkeit zugänglich gemacht wurden. Außerdem müssen sie relativ schnell sein, denn die meisten Unternehmen wollen nicht Tage warten, bis beispielsweise eine MCMC-Berechnung in einem ausgeklügelten Bayesschen Modell abgeschlossen ist – sie wünschen sich die Prognose in angemessener Zeit.

Kieran Chandler: Wie balancierst du aus geschäftlicher Sicht Robustheit, Genauigkeit und die Kosten für die Implementierung des Modells, Joannes?

Joannes Vermorel: Letztendlich läuft es darauf hinaus, was du beisteuerst. Zum Beispiel: Wenn wir ein super einfaches parametrisches Modell wie dasjenige haben, das wir für den M5-Wettbewerb genutzt haben, und damit nur 1 % der Genauigkeit einer sehr ausgeklügelten Gradient Booster Tree-Methode erreichen – der Gewinner des Wettbewerbs –, lohnt sich dann die zusätzliche Komplexität? Die siegreiche Methode verwendete Gradient Booster Trees mit einem sehr ausgeklügelten Data-Augmentation-Schema, das im Grunde eine Möglichkeit war, deinen Datensatz enorm aufzublähen.

Kieran Chandler: Das ist ziemlich enorm, und am Ende hast du einen Datensatz, der etwa zwanzigmal größer ist. Und dann wendest du darauf ein super schweres und komplexes Modell an. Die Frage ist also: Bringst du etwas grundlegend Neues und Tiefgründiges ein? Und wie balancierst du das?

Joannes Vermorel: Meine Herangehensweise, das auszugleichen, besteht darin, darüber nachzudenken, ob ich einen Elefanten im Raum übersehe, den ich wirklich berücksichtigen muss. Zum Beispiel, wenn ich über Mode spreche, sind Kannibalisierung und Substitution offensichtlich sehr ausgeprägt. Menschen betreten kein Modegeschäft in dem Gedanken, dass sie genau diesen Barcode wollen. Das ist nicht einmal die richtige Art, über das Problem nachzudenken. Kannibalisierung und Substitution finden sich überall, und man braucht etwas, das diese Sichtweise einbezieht. Wenn ich zum Beispiel den Automobilbereich betrachte und mir Automotive-Aftermarkets ansehe, besteht das Problem darin, dass Menschen Autoteile nicht kaufen, weil sie Autoteile mögen. Sie kaufen Autoteile, weil ihr Fahrzeug ein Problem hat und sie es reparieren möchten – so einfach ist das. Es stellt sich heraus, dass es eine superkomplexe Kompatibilitätsmatrix zwischen Fahrzeugen und Autoteilen gibt. In Europa gibt es über 1 Million verschiedene Autoteile und über 100.000 unterschiedliche Fahrzeuge. Und normalerweise gibt es für jedes auftretende Problem etwa ein Dutzend verschiedene kompatible Autoteile, sodass eine Substitution möglich ist, aber im Gegensatz zur Mode tritt dies in einer völlig deterministischen Weise auf. Die Substitutionen sind nahezu perfekt bekannt und strukturiert, und man möchte eine Methode haben, die den Umstand ausnutzt, dass darüber keinerlei Unsicherheit besteht.

Also, Problem für Problem besteht mein Ansatz darin, sicherzustellen, dass, wenn wir für zusätzliche Raffinesse bezahlen möchten, es sich wirklich lohnt. Zum Beispiel, wenn ich die Bibliotheken von Professor Hyndman mit – sagen wir – TensorFlow vergleiche, um eine Idee zu geben: Bei den meisten Modellen sprechen wir wahrscheinlich von Kilobytes an Code. Betrachtet man TensorFlow, so ist schon eine einzelne kompilierte Bibliothek 800 Megabyte groß, und sobald man TensorFlow Version One hinzufügt, umfasst man fast Milliarden von Codezeilen.

Manchmal denken die Leute vielleicht, dass wir über etwas streiten, das nur eine Frage von Graustufen ist, und es gibt keine eindeutig richtige oder falsche Antwort. Es ist lediglich eine Frage des Geschmacks, ob man es etwas einfacher oder etwas komplizierter haben möchte. Doch die Realität, die ich beobachtet habe, zeigt, dass es meist nicht nur Graustufen sind. Wir sprechen hier von Methoden mit mehreren Größenordnungen an Komplexität. Und so, wenn ich zum Beispiel eine eigene Prognose erstellen möchte, wie stehen die Chancen, dass die Bibliotheken von Professor Hyndman in 20 Jahren noch existieren, und wie stehen die Chancen, dass TensorFlow Version One in 20 Jahren noch existiert? Ich würde eine Menge Geld darauf wetten, dass fundamentale Zeitreihenmethoden auch in Zukunft relevant sein werden.

Kieran Chandler: Glaubst du, dass die Prognosetechnik in 20 Jahren noch existieren wird?

Joannes Vermorel: Dinge, die buchstäblich Milliarden von Zeilen an zufälliger Komplexität in Bezug auf die Spezifikationen der in den letzten fünf Jahren produzierten Grafikkarten einbetten, werden verschwunden sein. Ich bestreite nicht, dass es einige absolut beeindruckende Durchbrüche im Deep Learning gegeben hat. Was ich sagen möchte, ist, dass wir den Mehrwert wirklich verstehen müssen, der je nach betrachteten Problemstellungen stark variiert. Wir sollten uns nicht von Raffinesse ablenken lassen. Es ist nicht so, dass etwas allein aufgrund seiner Komplexität von Natur aus wissenschaftlicher, genauer oder gültiger ist. Es mag beeindruckender und TED-Talk-artiger wirken, aber wir müssen damit äußerst vorsichtig sein.

Kieran Chandler: Rob, ich überlasse dir die letzte Frage. Im Hinblick darauf, was Joannes erwähnt hat – dass Dinge in 10 bis 20 Jahren noch existieren – siehst du deine Bibliotheken auch in Zukunft noch vor? Woran arbeitest du heute, von dem du denkst, dass es in den kommenden Jahren nützlich sein wird?

Rob Hyndman: Meine erste öffentliche Bibliothek wurde etwa 2005 veröffentlicht, sodass sie bisher 15 Jahre bestand hat. Ich habe mich auf jeden Fall dazu verpflichtet, alle zu pflegen – selbst diejenigen, die ich als von anderen abgelöst betrachte. Es erfordert keinen enormen Aufwand. Die neueren Pakete, an denen ich arbeite, umfassen ein Paket namens Fable, das die meisten der gleichen Techniken implementiert, jedoch auf eine andere Weise, um es den Nutzern zu erleichtern, tausende Zeitreihen gleichzeitig zu prognostizieren. Fable und einige zugehörige Pakete gibt es seit ein paar Jahren, und mein neuestes Lehrbuch nutzt sie. Ich erwarte, dass sie noch mindestens 10 Jahre weit verbreitet eingesetzt werden, und solange ich dazu in der Lage bin, werde ich sie pflegen und sicherstellen, dass sie erhalten bleiben. Ich habe das Glück, einen sehr guten Assistenten zu haben, der mir bei der Paketwartung hilft. Er engagiert sich auch für die Open-Source-Welt und dafür, hochwertige Software im Open-Source-Bereich herauszubringen.

Kieran Chandler: Das ist großartig, und die Open-Source-Welt ermöglicht es jedem, darauf zuzugreifen. Vielen Dank an euch beide für eure Zeit. Wir müssen es hier belassen, und danke, dass ihr eingeschaltet habt. Wir sehen uns in der nächsten Folge wieder.