00:00:08 Introducción y antecedentes de Rob Hyndman en pronósticos.

00:01:31 Sostenibilidad de las técnicas de pronóstico del mundo real y el software.

00:04:08 Aplicación de técnicas de pronóstico en diversos campos con abundante datos.

00:05:43 Desafíos de atender a diversas industrias en la cadena de suministro.

00:07:30 Navegando por las complejidades del software empresarial y la recopilación de datos.

00:08:00 Pronóstico de series temporales y enfoques alternativos.

00:09:05 Desafíos enfrentados por Lokad en análisis predictivo.

00:11:29 Longevidad y motivación en el desarrollo de software académico.

00:13:12 Cambio del pronóstico puntual al pronóstico probabilístico.

00:15:00 Defectos en los métodos académicos y su implementación en el mundo real.

00:16:01 Rendimiento de un modelo simple en una competencia.

00:16:56 La importancia de métodos elegantes y concisos.

00:18:48 Equilibrar precisión, complejidad y costo en los modelos.

00:19:25 Robustez y velocidad en paquetes R para pronósticos.

00:20:31 Equilibrar robustez, precisión y costos de implementación en los negocios.

00:21:35 Importancia de métodos específicos del problema en pronósticos.

00:23:00 Predecir la longevidad de las técnicas y bibliotecas de pronóstico.

00:25:29 Compromiso de Rob para mantener sus bibliotecas de pronóstico.

00:26:12 Introducción de Fable y su aplicación en pronóstico de series temporales.

00:27:03 Apreciando el mundo de código abierto y su impacto en las herramientas de pronóstico.

Resumen

En una entrevista con Kieran Chandler, Joannes Vermorel, fundador de Lokad, y Rob Hyndman, profesor de Estadística en la Universidad de Monash, discuten la sostenibilidad de las técnicas de pronóstico del mundo real. El software de pronóstico de código abierto de Hyndman, que ha sido descargado por millones de usuarios, resiste el paso del tiempo y es capaz de resolver alrededor del 90% de los problemas de pronóstico de las empresas. Los invitados destacan los desafíos de atender a una amplia audiencia con diversas necesidades en la industria de la cadena de suministro y la importancia de crear software fácil de usar que sea efectivo y accesible. También enfatizan la importancia del software de código abierto y la colaboración en el desarrollo de métodos de pronóstico de alta calidad.

Resumen Extendido

En esta entrevista, Kieran Chandler discute la sostenibilidad de las técnicas de pronóstico del mundo real con Joannes Vermorel, fundador de Lokad, y Rob Hyndman, profesor de Estadística en la Universidad de Monash. El software de pronóstico de código abierto de Hyndman ha sido descargado por millones de usuarios y resiste el paso del tiempo, a diferencia de muchas otras herramientas de software.

Vermorel aprecia el trabajo de Hyndman por ir más allá del típico software académico al crear un conjunto completo de bibliotecas, incorporando muchos de sus propios resultados y proporcionando un marco consistente basado en el popular lenguaje R para el análisis estadístico. Vermorel cree que hay pocos ejemplos de software científico que hayan tenido tanta durabilidad y audiencia.

La investigación académica de Hyndman no se limita al pronóstico de la cadena de suministro; está interesado en aplicar técnicas de pronóstico a cualquier área con grandes cantidades de datos. Su trabajo incluye el pronóstico del consumo de electricidad, las tasas de mortalidad, la población, el número de turistas y, recientemente, los casos de COVID-19 para el gobierno australiano. Además del pronóstico, también trabaja en la detección de anomalías y el análisis exploratorio de datos.

Al discutir los desafíos de atender a una amplia audiencia con diversas necesidades en la industria de la cadena de suministro, Vermorel explica que la forma en que los datos son percibidos y registrados por el software empresarial (ERPs, MRPs, WMS) a menudo es semi-accidental.

Abordan las complicaciones que surgen al utilizar datos que no se recopilan principalmente con fines de pronóstico y la transición de un sistema de planificación de recursos empresariales (ERP) a otro. También discuten la necesidad de técnicas de pronóstico que puedan adaptarse a diferentes paisajes de TI y accidentes históricos en la implementación de software empresarial.

Vermorel destaca la importancia de los pronósticos en contextos que no se prestan al análisis de series de tiempo, como la moda, donde la ingeniería de la demanda y la introducción de nuevos productos influyen en el problema de pronóstico. Él enfatiza la necesidad de que los modelos predictivos tengan en cuenta los bucles de retroalimentación y las acciones tomadas en función de los pronósticos, así como el control de diversos factores como la variedad de productos y las estrategias de promoción. Este enfoque multifacético es vital para que Lokad aborde los complejos desafíos de análisis predictivo que enfrenta.

Hyndman explica que su software de series de tiempo es capaz de resolver alrededor del 90% de los problemas de pronóstico de las empresas, pero el 10% restante requiere enfoques diferentes. También aborda el problema del software académico de corta duración, atribuyéndolo al enfoque en la publicación de artículos y la falta de recompensa por mantener el software a largo plazo. Esto resulta en una falta de enfoque en la colaboración con los profesionales y en asegurarse de que los métodos estén bien documentados y tengan longevidad.

La entrevista destaca los desafíos y complejidades de la optimización y el pronóstico de la cadena de suministro, incluida la necesidad de técnicas adaptables, la importancia de considerar contextos que no son de series de tiempo y la influencia de los bucles de retroalimentación y la toma de decisiones en los modelos predictivos. Además, subraya la desconexión entre la investigación académica y la aplicación práctica en el campo del pronóstico.

Ambos invitados enfatizan la importancia de crear software fácil de usar que sea efectivo y accesible para marcar la diferencia en el mundo.

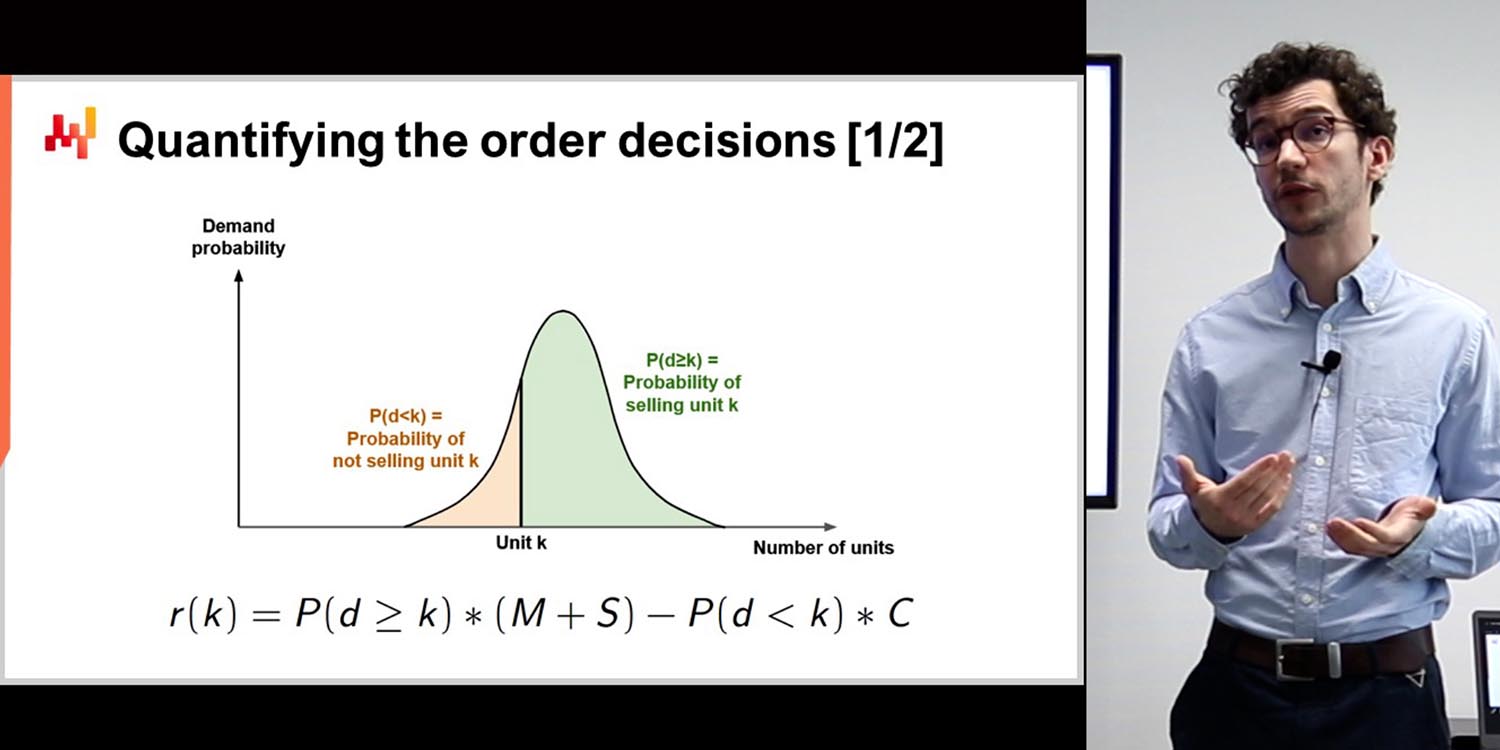

Hyndman menciona el cambio del pronóstico puntual al pronóstico probabilístico en la literatura académica en los últimos 15 años. Lokad fue una de las primeras empresas de pronóstico de la cadena de suministro en incorporar este cambio en su software. Como el software inicial de Hyndman se centraba en los pronósticos puntuales, sus paquetes más nuevos priorizan los pronósticos probabilísticos.

Vermorel señala las fallas ocultas en muchas publicaciones académicas, como la inestabilidad numérica, el tiempo computacional excesivo o la implementación compleja. También destaca la importancia de equilibrar la precisión con la simplicidad, ya que los modelos demasiado complicados pueden no ser prácticos o necesarios. Vermorel proporciona un ejemplo de la competencia M5, donde Lokad logró una alta precisión utilizando un modelo relativamente simple.

Hyndman está de acuerdo en que equilibrar los costos de producción de software, computación y precisión es esencial. Ambos invitados aprecian métodos de pronóstico concisos y elegantes con amplia aplicabilidad, como los de las bibliotecas de Hyndman.

La conversación plantea preguntas sobre los compromisos entre precisión y complejidad en los modelos de pronóstico. Vermorel cuestiona la sabiduría de buscar una ligera mejora en la precisión a expensas de una complejidad mucho mayor, como se ve en los modelos de deep learning. Tanto Vermorel como Hyndman enfatizan la importancia de centrarse en la esencia de los buenos pronósticos sin perderse en mejoras mínimas que pueden no justificar la complejidad añadida.

Hyndman enfatiza la importancia de considerar tanto la precisión como el costo de la computación al desarrollar métodos de pronóstico. Atribuye la robustez de sus paquetes de pronóstico a sus orígenes en proyectos de consultoría, donde necesitaban ser rápidos, confiables y aplicables a diversos contextos.

Vermorel destaca la importancia de considerar el valor agregado que aporta un método de pronóstico a un problema. Contrasta modelos paramétricos simples con métodos más complejos como los árboles de aumento de gradiente, señalando que en algunos casos, los modelos más simples pueden ser suficientes. Vermorel también discute los desafíos únicos de pronosticar en industrias como la moda y el mercado de accesorios para automóviles, donde los factores de sustitución y compatibilidad juegan un papel importante.

Los entrevistados enfatizan la importancia de no distraerse con la sofisticación, ya que no necesariamente se traduce en mejores resultados científicos o precisos. Vermorel predice que las técnicas fundamentales de pronóstico de series de tiempo seguirán siendo relevantes en 20 años, mientras que los métodos complejos que dependen del hardware actual pueden volverse obsoletos.

Rob Hyndman habla sobre su trabajo en pronósticos, en particular sobre el desarrollo del paquete de software de código abierto “Fable”, que simplifica el proceso de pronóstico para miles de series de tiempo simultáneamente. Él enfatiza su compromiso de mantener el paquete durante al menos 10 años y destaca los beneficios del software de código abierto, incluida la colaboración y la accesibilidad.

Tanto Vermorel como Hyndman destacan la importancia del software de código abierto en su trabajo y el potencial de colaboración en el desarrollo de métodos de pronóstico de alta calidad. Hyndman también menciona su dedicación a mantener bibliotecas públicas, que existen desde 2005, y el papel que desempeñan en hacer que el análisis de datos sea accesible al público.

En general, la entrevista destaca los desafíos de pronosticar en un mundo complejo y en constante cambio, así como la importancia del software y la colaboración en el desarrollo de soluciones efectivas. El enfoque en el software de código abierto y el acceso público subraya el valor de poner el análisis de datos y el pronóstico a disposición de un público más amplio.

Ambos entrevistados aprecian la naturaleza de código abierto de su trabajo, que permite un acceso y colaboración generalizados en el desarrollo de métodos de pronóstico de alta calidad.

Transcripción completa

Kieran Chandler: El pronóstico es una práctica antigua que está en constante evolución, y como tal, muchas piezas de software no resisten la prueba del tiempo. Una persona que ha desafiado esta tendencia es nuestro invitado de hoy, Rob Hyndman, quien ha implementado software de código abierto que ha sido descargado por millones de usuarios. Por lo tanto, hoy vamos a discutir con él la sostenibilidad de las técnicas de pronóstico del mundo real. Entonces, Rob, muchas gracias por unirte a nosotros en vivo desde Australia. Sé que es un poco tarde en tu zona horaria. Como siempre, nos gusta comenzar aprendiendo un poco sobre nuestros invitados, así que tal vez puedas empezar contándonos un poco sobre ti.

Rob Hyndman: Gracias, Kieran, y encantado de unirme a ustedes. Sí, son las 8 de la noche aquí en Australia, así que no es tan tarde. Soy profesor de Estadística y Jefe del Departamento de Econometría y Estadística Empresarial de la Universidad de Monash. He estado allí durante 26 años. Durante la mayor parte de ese período, también fui Editor en Jefe de la Revista Internacional de Pronóstico y Director del Instituto Internacional de Pronóstico, desde 2005 hasta 2018. Soy académico; escribo muchos artículos y he escrito algunos libros, incluidos tres sobre pronóstico. Si no estoy haciendo eso, generalmente estoy jugando al tenis.

Kieran Chandler: Genial, yo también disfruto un poco de tenis en los meses de verano. Tal vez algún día podamos jugar un partido contigo. Joannes, hoy nuestro tema es la sostenibilidad de las técnicas de pronóstico del mundo real y la idea de que un software sea sostenible y dure mucho tiempo. ¿Cuál es la idea detrás de eso?

Joannes Vermorel: La mayoría del software tiende a deteriorarse con el tiempo por diversas razones. Cuando se trata de software científico, hay que pensar en cómo se produce este software. Por lo general, se crea para respaldar la publicación de un artículo, por lo que es básicamente un software desechable. Lo que encontré bastante notable en el trabajo del profesor Hyndman es que fue más allá de lo que se hace habitualmente en los círculos académicos, que es producir software desechable, publicar el artículo, terminar y pasar al siguiente artículo. En realidad, construyó un vasto conjunto de bibliotecas que no solo incorporaban muchos de sus propios resultados y muchos resultados de sus colegas, sino que también proporcionaban un marco muy consistente basado en un lenguaje que se volvió muy popular, que es R, un entorno para el análisis estadístico. Esto ha demostrado su valor a lo largo de varias décadas, y eso es todo un logro. La mayoría del software que vemos hoy en día es antiguo, con muy pocas bases que surgen de Unix y cosas más sofisticadas. En términos de ciencia de datos, no hay muchos ejemplos de cosas que resisten la prueba del tiempo, aparte de los bloques de construcción básicos para el álgebra lineal y campos similares.

Kieran Chandler: … análisis, pero cuando realmente lo piensas, probablemente podría mencionar una docena de ejemplos de software que lograron tener tal audiencia y durabilidad. Sin embargo, en realidad no hay tantos. Creo que hay algo bastante notable aquí que va más allá de lo que se hace habitualmente en la investigación académica. Rob, hablemos un poco más sobre tu investigación académica entonces. Obviamente, no te enfocas solo en el mundo de la cadena de suministro como nosotros en este extremo. Entonces, ¿en qué otras áreas estás interesado en aplicar técnicas de pronóstico?

Rob Hyndman: Estoy interesado en cualquier cosa donde pueda obtener muchos datos. Por ejemplo, hago pronósticos sobre el consumo de electricidad, donde hay muchos datos realmente buenos que se remontan décadas atrás. Pronostico tasas de mortalidad, población y últimamente, he estado trabajando en números de turistas, lo cual es algo bastante difícil de pronosticar en medio de una pandemia. He estado ayudando al gobierno australiano a pensar cómo funciona eso. Otro trabajo que estoy haciendo para el gobierno australiano es pronosticar casos de COVID-19. Es mi primer intento de hacer algo en el mundo epidemiológico, y he tenido que aprender bastante sobre el enfoque epidemiológico para modelar y construir eso en algunos conjuntos de pronóstico. Eso ha sido interesante. Básicamente, si hay muchos datos, estoy interesado en tratar de modelarlos. También hago cosas como detección de anomalías y análisis exploratorio de datos donde hay grandes colecciones de datos. He trabajado con muchas empresas y organizaciones gubernamentales, y si vienen a mí con un problema que involucra bastante datos, estoy interesado en pensar cómo hacer mejores pronósticos que lo que está sucediendo actualmente.

Kieran Chandler: Genial, puedo imaginar que la industria turística es bastante interesante en este momento. Es una verdadera anomalía desde una perspectiva de pronóstico. Johannes, nuestro enfoque está obviamente en la industria de la cadena de suministro, pero la idea es que no nos enfocamos en una sola industria dentro de eso. Nos dirigimos a una audiencia muy amplia, así que ¿qué tipo de desafíos puedes encontrar cuando intentas atender a tantas personas diferentes con tantas necesidades diferentes?

Joannes Vermorel: Primero, es la forma en que percibimos el mundo. No tenemos algo similar a una medición científica, como estadísticas establecidas para mortalidades u otras cosas. Lo que tienes son software empresariales, como ERPs, MRPs y WMS, que producen o registran datos casi de manera semi-accidental. La recopilación de datos no fue la razón por la cual se implementaron todos esos software, por lo que terminas con registros, pero no fueron diseñados como herramientas para realizar mediciones a lo largo del tiempo que se puedan pronosticar. Es casi un subproducto accidental, y eso crea toneladas de complicaciones. Uno de los desafíos que tienes es si puedes hacer, en términos de técnicas de pronóstico e investigación enfocada, algo que sobreviva al pasar de un ERP al siguiente. Si cambias el sistema, que es muy desordenado y accidental, debes considerar cómo eso afectará el proceso de pronóstico.

Kieran Chandler: Entonces, el próximo tema que me gustaría discutir es el diferente panorama de TI y los accidentes históricos en términos de implementación de varias herramientas de software empresarial. Si tienes que cambiar completamente el método, obviamente no estás construyendo ningún conjunto de conocimientos o técnicas. Uno de los desafíos es, ¿puedes hacer algo en esta área? Y desde nuestra perspectiva en Lokad, los pronósticos que más nos interesan son típicamente cosas que no se presentan naturalmente como series de tiempo. ¿Qué pasa si tienes un problema que no se presta convenientemente para ser enmarcado como una serie de tiempo? Aún necesitas algo que se asemeje a un pronóstico, pero se presenta de manera muy diferente. Rob, ¿qué piensas sobre el uso de alternativas a los pronósticos de series de tiempo?

Rob Hyndman: Bueno, depende mucho de los datos, como dijo Joannes, determinar qué tipo de modelo será necesario construir para ese problema en particular. Mi software de series de tiempo maneja muchos problemas, pero no todos. Algunas empresas tendrán un conjunto de datos configurado de tal manera, o registrado de tal manera, que tendrán que modificarlo o encontrar una solución diferente. El software que he escrito y que es más popular resuelve el 90% de los problemas de pronóstico de las empresas; es el otro 10% en el que tienes que hacer cosas diferentes.

Kieran Chandler: ¿Con qué frecuencia dirías que hay ese tipo de 10% en tu experiencia, Joannes?

Joannes Vermorel: Es un problema muy sutil. Mi propio viaje a través del mundo del pronóstico en Lokad fue darme cuenta de cuánta profundidad hay. Primero, pasamos de pronósticos puntuales a pronósticos probabilísticos, lo que cambió la forma en que vemos el problema. Pero es aún más profundo que eso. Por ejemplo, si miramos la moda, el problema es que quieres pronosticar la demanda para saber qué producir. Sin embargo, cuando decides lo que estás a punto de producir, tienes la flexibilidad de introducir más o menos productos. Entonces, la idea misma de que tienes series de tiempo que podrías pronosticar depende de tus decisiones. En la moda, por ejemplo, el hecho de que introduzcas un producto más en tu surtido es parte de tu problema predictivo. No solo quieres pronosticar la demanda, sino también diseñar la demanda. En nuestro viaje, nos dimos cuenta de que teníamos incertidumbres irreducibles que nos dan un ángulo que es completamente ortogonal a la perspectiva clásica de pronóstico puntual. Pero también tenemos que lidiar con todos los bucles de retroalimentación.

Kieran Chandler: Entonces, Joannes, ¿puedes decirnos cómo los modelos predictivos impactan en la optimización de la cadena de suministro?

Joannes Vermorel: Cuando hacemos un pronóstico, tomamos una acción mejor informada. Eso tiene una influencia profunda en la forma en que queremos construir nuestros modelos predictivos. Luego podemos agregar más variables, como controlar el grado de productos, puntos de precio, mensaje e incluso promoción de productos. Si sigo con el ejemplo de la moda, pronosticas las cantidades que deseas tener y luego decides que en tus tiendas, algunos productos se colocarán de manera mucho más permanente que otros. Eso tiene un impacto profundo en lo que vas a observar. El desafío que Lokad ha enfrentado en términos de análisis predictivo fue poder abordar problemas mirando los numerosos ángulos que se presentan y que complican la perspectiva pura de series de tiempo.

Kieran Chandler: Bueno, Rob, tal vez ahora hablemos desde un punto de vista académico. Muchas personas crean piezas de software solo para un artículo y luego casi se desechan. ¿Por qué crees que no hay suficiente longevidad en algunas de las piezas de software que las personas están creando?

Rob Hyndman: Bueno, hay que pensar en la motivación de la mayoría de los académicos. Se les paga para escribir artículos y dar clases. Una vez que se escribe el artículo, puede haber algún estímulo para publicar algún software para implementarlo. Pero no hay una recompensa real para la mayoría de los académicos en hacer eso, y ciertamente no hay una recompensa en mantener ese software durante mucho tiempo. Cualquiera que lo haga lo hace porque le importa o porque es un trabajo de amor. No es realmente lo que se les paga por hacer. No es su negocio principal. Creo que eso es un problema en el mundo académico. Hay tanto enfoque en sacar nuevos métodos y publicarlos y no hay suficiente enfoque en la relación con la comunidad de profesionales y asegurarse de que sus métodos estén bien documentados y tengan software fácil de usar disponible a largo plazo. Es un problema de motivación en el mundo académico. Mi motivación es que cuando desarrollo una nueva metodología, quiero que la gente la use. No quiero simplemente publicar un artículo y que lo lean una docena de personas o tal vez 100 personas, si tengo suerte. En realidad, quiero que mis métodos hagan una diferencia en el mundo. Aparte de lo que se me paga por hacer, eso es lo que hago porque obtengo mucha satisfacción al ver que mis métodos realmente se utilizan en la práctica.

Joannes Vermorel: Los modelos predictivos se han vuelto más complicados y no es fácil hacerlos robustos. En Lokad, tenemos que mantener mucho código antiguo para que nuestros modelos funcionen. El desafío es que no puedes simplemente crear un modelo sofisticado y dejarlo así. Necesitas tener una forma de explicar qué hace el modelo y por qué lo hace. Necesitas asegurarte de que el modelo esté bien documentado y que las personas puedan usarlo en la práctica. Eso no es algo fácil de hacer, pero es importante si quieres que tus modelos sean adoptados.

Rob Hyndman: También creo que es interesante que a medida que las cosas han cambiado con el tiempo, se desarrollan nuevos métodos y, por lo tanto, necesitas proporcionar nuevo software o nuevas herramientas que tengan en cuenta los avances en pronósticos. Uno de los que Joannes mencionó es el cambio de pronóstico puntual a pronóstico probabilístico, que ocurrió en la literatura académica en los últimos 15 años, tal vez, y Lokad fue muy rápido en adoptar eso y ofrecer pronósticos probabilísticos. Creo que probablemente una de las primeras empresas de pronóstico de la cadena de suministro en el mundo en hacer eso. Mi software inicial, aunque producía pronósticos probabilísticos, siempre se enfocaba en los pronósticos puntuales,

Kieran Chandler: En los últimos años, el énfasis se ha invertido. Primero obtienen pronósticos probabilísticos y luego pronósticos puntuales.

Joannes Vermorel: Una de mis críticas personales con muchas publicaciones académicas es que generalmente terminas con toneladas de fallas ocultas en los métodos. Entonces tienes un método que sabes que superará en rendimiento en la prueba, pero cuando quieres implementarlo en una implementación real, verás que, por ejemplo, es numéricamente muy inestable o que los tiempos de cálculo son ridículamente largos hasta el punto de que si usas un conjunto de datos de juguete, ya llevará días de cálculo. Y si quieres tener algún tipo de conjunto de datos del mundo real, eso contaría como años de cálculo.

Y puedes tener todo tipo de problemas, como que el método sea diabólicamente complicado de implementar y, por lo tanto, incluso si en teoría puedes hacerlo bien, en la práctica siempre tendrás algún error estúpido que te impedirá lograr algo. O tal vez el método pueda tener dependencias increíblemente sutiles en una larga serie de meta-parámetros, por lo que es un poco como un arte oscuro hacer que funcione porque tienes como 20 parámetros oscuros que necesitas ajustar de formas que están completamente sin documentar y generalmente solo en la mente de los investigadores que produjeron el método.

Rob Hyndman: Eso es muy interesante porque cuando veo métodos que resisten la prueba del tiempo, muchos métodos súper clásicos que produjiste para Hyndman, por ejemplo, están dando resultados sorprendentemente buenos frente a métodos muy sofisticados. Durante la competencia M5 del año pasado, Lokad quedó en el sexto lugar entre 909 equipos en términos de precisión de pronóstico para el pronóstico puntual. Pero lo hicimos con un modelo que era súper simple, casi el modelo de pronóstico paramétrico de libro de texto, y usamos un pequeño truco de modelado ETS encima de eso para básicamente obtener el efecto de escopeta y la distribución probabilística.

Pero en general, probablemente era un modelo que podríamos haber resumido en una página con unos pocos coeficientes para las estacionalidades, el día de la semana, la semana del mes, la semana del año, y eso fue todo. Entonces, literalmente, llegamos a un uno por ciento del modelo más preciso que estaba utilizando árboles potenciados por gradientes, y sospecho que en términos de complejidad del código, complejidad del modelo y opacidad general, estamos hablando de algo que es como dos órdenes de magnitud, si no tres, más complejo.

Joannes Vermorel: Eso es algo en lo que creo en el éxito de tus bibliotecas. Lo que realmente me gusta de los métodos es que la mayoría de ellos tienen una implementación elegante y son concisos. Entonces, de hecho, en términos de aplicabilidad, hay algo que es profundamente verdadero y válido al respecto, donde obtienes la precisión con la cantidad mínima de esfuerzo y problemas, a diferencia, diría yo, del otro lado del campo, el campo del deep learning. No tengo nada en contra del deep learning cuando quieres abordar problemas increíblemente difíciles como, digamos, por ejemplo…

Kieran Chandler: Bienvenidos al episodio. Hoy tenemos a Joannes Vermorel, el fundador de Lokad, y a Rob Hyndman, profesor de estadística y jefe del Departamento de Econometría y Estadísticas Empresariales de la Universidad de Monash. Discutamos sobre la traducción automática y la precisión del modelo.

Joannes Vermorel: Cuestiono la sabiduría de tener un modelo que sea un uno por ciento más preciso, pero que tenga millones de parámetros, y que sea increíblemente complejo y opaco. ¿Es realmente mejor desde una perspectiva científica? Tal vez no deberíamos distraernos logrando un uno por ciento más de precisión a expensas de algo 1000 veces más complejo. Existe el peligro de perderse por completo. La buena ciencia, especialmente en el pronóstico, debería centrarse en la esencia de lo que hace un buen pronóstico, dejando de lado las distracciones que aportan un poco más de precisión pero tal vez a expensas de mucha confusión adicional.

Rob Hyndman: Hay que equilibrar los dos costos: el costo de producir el software y realizar el cálculo real, y el costo de la precisión. En el mundo académico, el enfoque suele ser la precisión sin tener en cuenta el costo del cálculo o el desarrollo del código. Estoy de acuerdo contigo, Joannes, en que debemos tener en cuenta ambos. A veces no necesariamente quieres el método más preciso si va a llevar demasiado tiempo mantener el código y realizar el cálculo. Mis paquetes de pronóstico son robustos porque se desarrollaron a través de proyectos de consultoría. Estas funciones se aplicaron en diversos contextos, por lo que tenían que ser relativamente robustas. No quería que las empresas volvieran a mí diciendo que estaban rotas o que no funcionaban en sus conjuntos de datos. El hecho de que haya hecho mucha consultoría significa que esas funciones han visto muchos datos antes de ser lanzadas al público en general. También tienen que ser relativamente rápidas porque la mayoría de las empresas no quieren esperar días para que ocurra algún cálculo MCMC en un modelo bayesiano sofisticado; quieren el pronóstico en un tiempo razonable.

Kieran Chandler: ¿Cómo equilibras la robustez, la precisión y el costo de implementar el modelo desde una perspectiva empresarial, Joannes?

Joannes Vermorel: Realmente se reduce a lo que estás aportando. Por ejemplo, si tenemos un modelo paramétrico súper simplista como el que usamos para la competencia M5 y llegamos al uno por ciento de la precisión de un método de árbol de refuerzo de gradiente muy sofisticado, que fue el ganador, ¿vale la pena la complejidad añadida? El método ganador utilizó árboles de refuerzo de gradiente con un esquema de aumento de datos muy sofisticado, que básicamente era una forma de inflar enormemente tu conjunto de datos.

Kieran Chandler: Eso es bastante grande y ahora terminas con un conjunto de datos que es como 20 veces más grande. Y luego aplicas un modelo súper pesado y complejo sobre eso. Entonces la pregunta es, ¿estás aportando algo fundamentalmente nuevo y profundo? ¿Y cómo equilibras eso?

Joannes Vermorel: La forma en que equilibro eso es pensando si me estoy perdiendo un elefante en la habitación que realmente necesito tener en cuenta. Por ejemplo, si hablo de moda, obviamente la canibalización y la sustitución son muy fuertes. Las personas no entran en una tienda de moda pensando que quieren este código de barras exacto. Esa ni siquiera es la forma correcta de pensar en el problema. La canibalización y la sustitución están por todas partes, y necesitas algo que abrace esa visión. Si hablo de automoción, por ejemplo, y miro los mercados de accesorios de automóviles, el problema es que las personas no compran piezas de automóviles porque les gusten las piezas de automóviles. Compran piezas de automóviles porque su vehículo tiene un problema y quieren repararlo, fin de la historia. Resulta que tienes una matriz de compatibilidad súper compleja entre vehículos y piezas de automóviles. En Europa, tienes más de 1 millón de piezas de automóviles distintas y más de 100,000 vehículos distintos. Y generalmente, para cualquier problema que tengas, hay como una docena de piezas de automóviles compatibles diferentes, por lo que tienes sustitución, pero a diferencia de la moda, se presenta de una manera completamente determinista. Las sustituciones son casi perfectamente conocidas y perfectamente estructuradas, y quieres tener un método que realmente aproveche el hecho de que no hay incertidumbre al respecto.

Entonces, problema por problema, la forma en que equilibro eso es asegurándome de que si queremos pagar por una mayor sofisticación, realmente valga la pena. Por ejemplo, si tomo las bibliotecas del profesor Hyndman versus, digamos, TensorFlow, solo para dar una idea, para la mayoría de sus modelos, estamos hablando probablemente de kilobytes de código. Si miramos TensorFlow, solo una biblioteca compilada tiene un tamaño de 800 megabytes, y tan pronto como incluyas la versión uno de TensorFlow, estás incluyendo casi miles de millones de líneas de código.

A veces, la gente puede pensar que estamos discutiendo sobre algo que es solo una cuestión de tonos de gris, y que no hay una respuesta correcta o incorrecta. Es solo una cuestión de gusto, si lo prefieres un poco más simple o un poco más complicado. Pero la realidad de lo que he observado es que generalmente no son solo tonos de gris. Estamos hablando de métodos con varios órdenes de magnitud de complejidad. Y así, si quiero hacer una predicción por mi cuenta, por ejemplo, ¿cuáles son las probabilidades de que las bibliotecas del profesor Hyndman sigan existiendo dentro de 20 años, y cuáles son las probabilidades de que la versión uno de TensorFlow siga existiendo dentro de 20 años? Apostaría bastante dinero a la idea de que los métodos fundamentales de series temporales seguirán siendo relevantes.

Kieran Chandler: ¿Crees que la técnica de pronóstico seguirá existiendo dentro de 20 años?

Joannes Vermorel: Las cosas que incorporan literalmente miles de millones de líneas de complejidad accidental sobre las especificidades de las tarjetas gráficas que se han producido en los últimos cinco años desaparecerán. No estoy negando el hecho de que ha habido avances absolutamente impresionantes en el deep learning. Lo que estoy diciendo es que realmente necesitamos entender el valor agregado, que varía mucho dependiendo de los problemas que estamos analizando. No debemos distraernos con la sofisticación. No es porque sea sofisticado que es inherentemente más científico, preciso o válido. Puede ser más impresionante y estilo TED talk, pero tenemos que tener mucho cuidado al respecto.

Kieran Chandler: Rob, te dejo la pregunta final a ti. En términos de lo que Joannes habló, que las cosas sigan existiendo en 10 o 20 años, ¿puedes ver que tus bibliotecas sigan estando allí? ¿En qué estás trabajando hoy en día que crees que será útil en los próximos años?

Rob Hyndman: Mi primera biblioteca pública fue alrededor de 2005, por lo que han durado 15 años hasta ahora. Ciertamente estoy comprometido a mantener todas ellas, incluso las que considero que han sido reemplazadas por otras. No requiere un gran esfuerzo hacer eso. Los paquetes más nuevos en los que estoy trabajando son este paquete llamado Fable, que implementa la mayoría de las mismas técnicas pero de una manera diferente para facilitar a los usuarios el pronóstico de miles de series de tiempo simultáneamente. Fable y algunos paquetes asociados han estado disponibles durante un par de años, y mi libro de texto más nuevo los utiliza. Espero que se utilicen ampliamente durante al menos 10 años, y mientras sea capaz, los mantendré y me aseguraré de que estén disponibles. Tengo la suerte de contar con un asistente muy bueno que me ayuda con el mantenimiento de los paquetes. También está comprometido con el mundo del código abierto y con ofrecer software de alta calidad en el desarrollo de código abierto.

Kieran Chandler: Eso es genial, y el mundo del código abierto permite que todos tengan acceso a él. Muchas gracias a ambos por su tiempo. Tendremos que dejarlo aquí, y gracias por sintonizar. Nos vemos en el próximo episodio.