ディープ・インベントリ・マネジメントの主観的レビュー

2022年後半に、Amazonのチームがサプライチェーン関連の研究「Deep Inventory Management」1を発表しました。この論文は、以降DIMと呼ばれる在庫最適化手法を提示しており、強化学習および深層学習を取り入れています。同論文は、この手法が実際の現場で10,000以上のSKUに対して成功裏に利用されたと主張しています。本論文は多角的な観点から非常に興味深く、Lokadが2018年以降に取り組んできた事例といくぶん類似しています。以下では、ここ数年Lokadが類似の領域を探求してきた具体的な視点から、DIM手法の長所と短所について論じます。

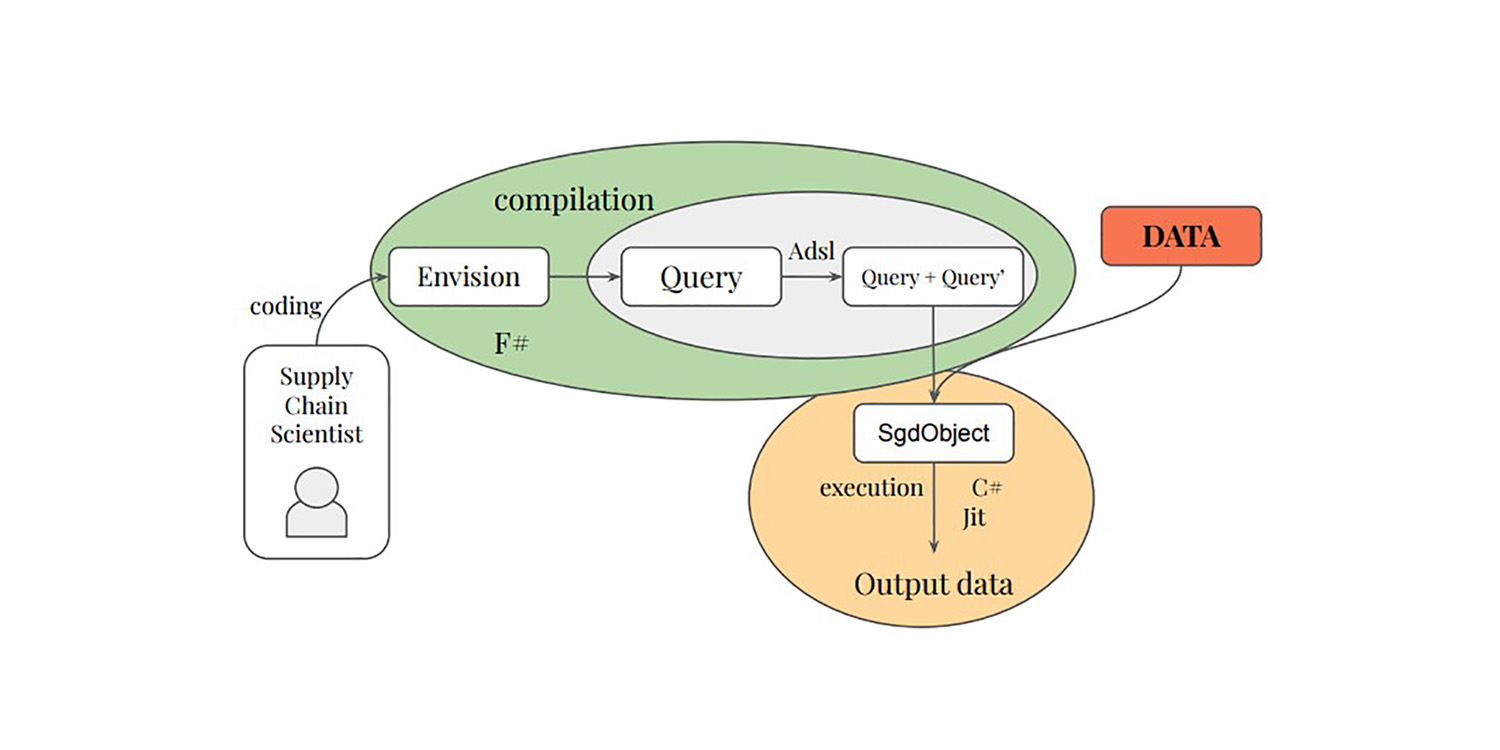

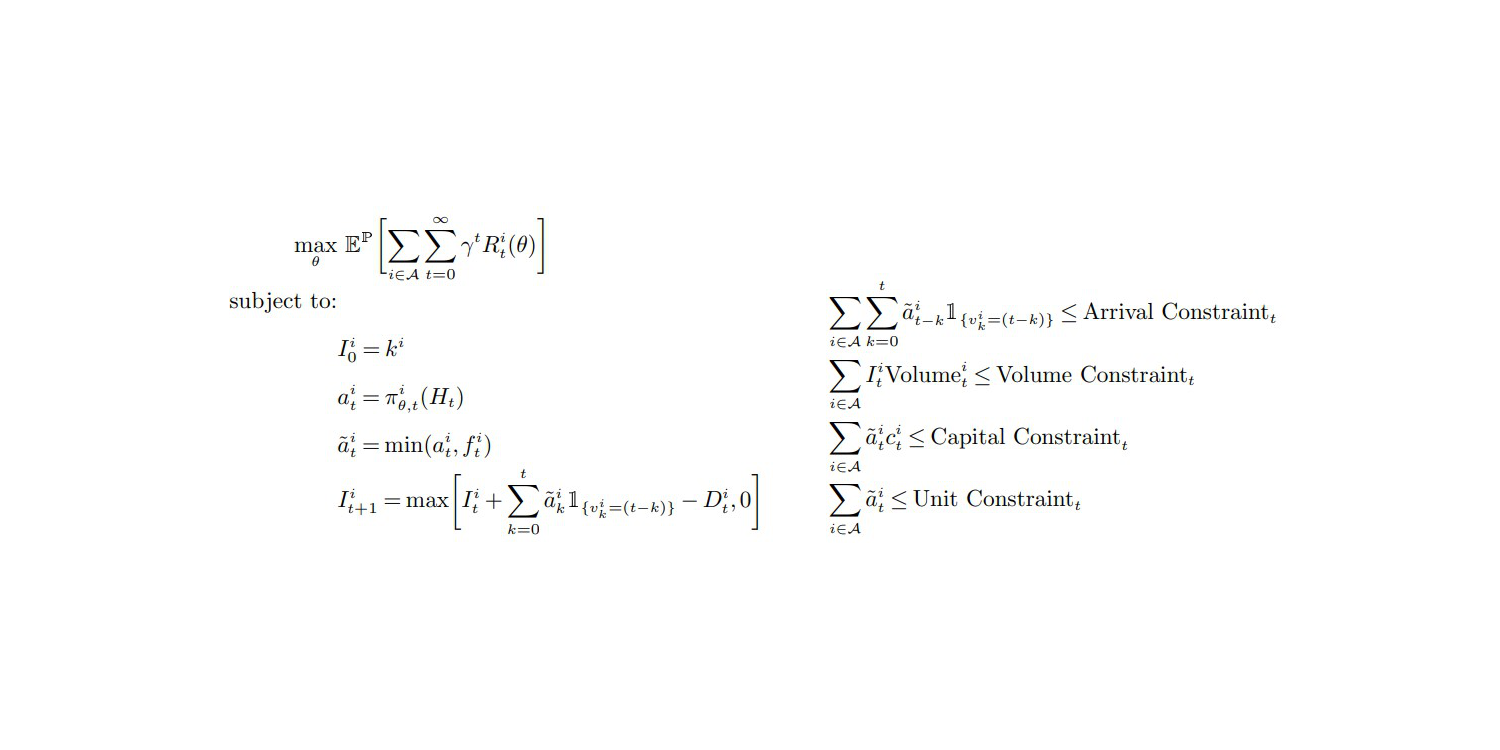

目的関数と制約 (付録A, p.27)、『Deep Inventory Management』, 2022年11月

私の最初の所感は、本論文が真実を突いていると感じる点にあり、そのためその成果を支持する傾向にあるということです。全体の設定は、私自身の実験や観察と非常に共鳴しています。実際、サプライチェーンに関するほとんどの論文は何らかの理由で誤りであり、サプライチェーンは重大な認識の破綻2に直面しています。いかなる「より良い」供給チェーン問題へのアプローチに対しても、根底には深い懐疑心を持つべきです。

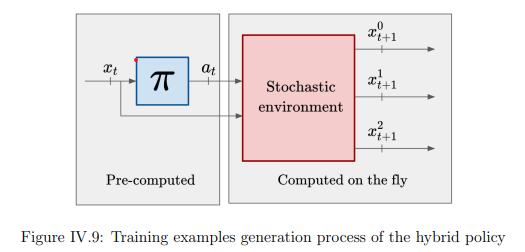

DIM手法の最も顕著な貢献は、需要予測段階を完全に省略し、直接在庫最適化に取り組む点にあります。従来の在庫最適化アプローチは、まず需要を予測し、次に在庫の意思決定を最適化するという二段階プロセスを踏みます。Lokadは依然としてこの段階的プロセスを採用しています(十分な理由があり、action reward 3を参照)。しかし、DIMは「微分可能なシミュレーター」と呼ばれる手法で、これら二つの段階を統合しています。

「学習」と「最適化」の段階を統合することは、サプライチェーンだけでなく、コンピューターサイエンス全体にとっても有望な方向性です。過去20年にわたり、アルゴリズム的な観点から「学習」と「最適化」は徐々に収束してきました。実際、Lokadが利用する主要な「学習」手法の中核には「最適化」アルゴリズムが存在しています。逆に、Lokadが最近達成した(未発表の)確率的最適化に関するブレークスルーは、「学習」アルゴリズムを中心としています。

私は、単独の需要予測が、全く新しい手法に取って代わられる未来を想定しています。その手法は「学習」と「最適化」の視点を完全に融合させたものです。Lokadはすでにこの道を進んでおり、実際、2015年に確率的予測へ移行して以降、Lokadから生の予測を出力することは実用的でないと判断され、クライアントの視点では事実上プロセスが一段階に縮小されています。しかし、統合には未だ解決すべき深刻な問題があるため、Lokad内では二段階プロセスが依然として採用されています。

さて、DIM手法の欠点について私の見解を論じましょう。

私の最初の批判は、DIMが採用している**_ディープラーニング_の利用が期待外れである**という点です。

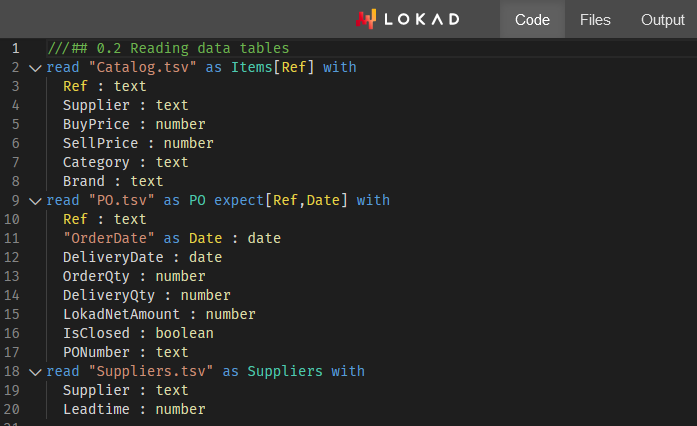

Featurization(付録B)のセクションから明らかなように、この「ディープ」モデルが何よりもまず学習しているのは、将来のリードデマンド、すなわち変動するリードタイムにわたる需要の積分値を予測することです。

リードデマンドの(暗黙のうちに確率的な)推定は、少なくとも本Amazonチームが提示した状況下では、ディープラーニングを必要とする「困難な」問題ではありません。実際、私の見解では、全体の実証的改善はより良いリードデマンド評価の結果であると考えています。さらに、M5コンペティション4で行われたように、基本的なパラメトリック確率モデルを用いれば、同等もしくはそれ以上のリードデマンド評価が得られると予想します。これにより、解決策からディープラーニングを完全に排除し、「浅い」差分可能プログラミング部分のみが残ることになります。

リードデマンドの推定を除けば、DIMには大した提供価値がありません。実際、本論文で提示されるサプライチェーンの設定では、全SKUが事実上孤立して処理され、企業全体に及ぶ制約は総ボリューム、総資本、総単位数の上限といった非常に緩やかなものです。これらの上限に対応するのは、再注文対象の単位を5ドルオン・ドルのリターン(または場合によってはドルオン・ユニットのリターン)の降順に並べ替えるだけで、非常に容易です ― もし、Amazonが利用する混沌としたストレージのキャパシティが真のボトルネックであれば。

制約に関しては、企業全体の上限は取り扱いが容易な制約であり、高度な技術を必要としません。もし、著者らがサプライチェーンに溢れる厄介な制約に対応できれば、ディープラーニングは真価を発揮するでしょう。例えば、仕入先レベルで定義される最小発注量(MOQ)、トラック一杯のトラック積み、仕入先の価格割引、傷みやすい製品などは、前述の優先順位付けのような素朴な手法では解決できない問題です。そのような厄介な制約に対しては、ディープラーニングは多用途な確率的最適化手法として非常に優れているはずですが(実現できればの話ですが)。しかし、DIMはこれらの問題を完全に回避しており、これらの問題に対処するためにDIMを拡張できるかどうかは全く不明です。私の見解では、拡張は不可能でしょう。

著者への評価として、結論の最終行で_cross-product constraints_(製品横断的制約)が_エキサイティングな研究の方向性_として言及されている点は挙げられます。私もその趣旨には賛同しますが、これは控えめな表現に過ぎません。これら遍在するサプライチェーンの制約に対処しないことは即座に実用性を損なうものであり、サプライチェーンの担当者は1か月も経たずにスプレッドシートに戻ってしまうでしょう。大体正しいことは、完全に誤ったことよりもましです。

さらに、DIMが生成する実数値のアクション、すなわち小数の注文数量という全く別の問題もあります ― 方程式(1)および前提1(p.12)を参照。実際、サプライチェーンにおいては、0.123単位の在庫補充は不可能で、0か1のどちらかでなければなりません。しかし、著者らはこの問題を完全に回避しています。DIM手法は小数の数量を出力し、報酬関数が「適切に振る舞う」ことを要求しています。現実的には、報酬関数が注文数量に関して厳密に単調でなければ、このアプローチはうまく機能しないことは明らかです。

このように、望ましくない特徴(小数注文)と望ましくない要件(報酬関数の単調性)が組み合わさって、提案された微分可能シミュレーターの根幹を形成しています。しかしながら、サプライチェーンは小数の法則6に支配されており、現代の在庫問題はその離散的な性質によって支配されています。少なくとも、この点はDIMの重大な制限として著者らに明示されるべきであり、今後の研究課題として追求されるべきです。

勾配と離散的な政策の融合は、提案された微分可能シミュレーターに限らず、確率的最適化全般における根本的な問題です。実際、確率的勾配降下法(SGD)は実数値のパラメータ上で動作するため、本質的に離散的な意思決定を支配する政策を最適化する方法は明らかではありません。

本質的に離散的な空間を勾配駆動プロセスで扱うことは、LLM(大規模言語モデル)が見事に示しているように可能ですが、それにはさまざまな工夫が必要です。サプライチェーンが直面する状況に対して同等の工夫が発見されるまでは、微分可能シミュレーターは有望なアイディアに過ぎず、本番環境で利用できる選択肢とは言えません。

私の第二の批判は、DIMの著者が多数のエッジケースについて全く触れていないという点です。

特に、著者らはどのようにしてその10,000のSKUを選定(いわばチョイス)したのかについて極めて曖昧です。実際、私が2018年および2019年にLokadで実験を行っていた際、Lokadが使用するディープラーニングモデルには、非常に類似した特徴抽出戦略(付録B)が用いられていました。

これらの実験から、私は以下のことを提案します:

- 新製品や最近発売された製品はうまく機能しないでしょう。なぜなら、式(13)、(30)および(31)で示唆される再スケーリングが、過去データが乏しい場合に不規則な挙動を示すためです。

- 販売が緩やかな製品は、過去のストックアウトが適切に補正されることを前提としているため(実際にはそうでないことが多い)、不適切な補正により問題が生じるでしょう。

- 断続的な製品(未公開または長期間(例:2ヶ月以上)供給されないもの)も、仮に補正されたとされる需要に対して問題が生じるでしょう。

- 競合他社のSKUは、顧客が最安値を積極的に選ぶため、SKUが価格面で競合相手を凌駕する際の劇的な影響をモデルが反映できず、過小評価されるでしょう。

こうしたエッジケースこそが、実際のサプライチェーン課題の大部分を占めています。論文では、あまり新しくなく、販売が遅すぎず、乱れず、断続的でない、好調なSKUを選び抜く誘惑があります。しかし、洗練された技術に頼らざるを得ないのであれば、容易なSKUに焦点を当てること自体が無意味です。たとえそれらのSKUで経済的改善が達成されたとしても、得られる利益は僅か(せいぜい控えめ)である ― それは、もともとこれらのSKUが好調であるからに他なりません。サプライチェーンの非効率性の大半は、中間層ではなく極端なケースに起因しています。

問題を抱えるSKUに真正面から対処することこそ、ディープラーニングが救済に寄与すべき領域です。しかし残念ながら、DIMはその逆を行い、極端な高度な技術を必要としない好調なSKUに着手することで、リスクをほとんど伴わない選択をしています。

私の第三の批判は、DIMの技術設定がやや複雑過ぎるという点です。

これはおそらく、data scienceコミュニティにおいて最も過小評価されている問題の1つでしょう。複雑さは信頼性と効率性の敵です。ディープラーニングは素晴らしい技術ですが、このようなDIMの設定を運用するために必要なエンジニアを抱えられる企業はほとんどありません。これは、ChatGPTのように、ソフトウェアベンダーの全顧客間でエンジニアリングの手間が相互化されているものとは異なります。ここでは、DIMに含まれる数多くの特有要素を考慮すると、各クライアント企業が自社専用のインスタンスに関する全運用コストを負担しなければならないのです。

ハードウェア面では、現在、AWS上で月額17,000USDの価格がつけられているEC2 p3.16xlarge7仮想マシンを使用しています。10,000SKUに対しては、それは…非常に高額です。

Lokadには、それぞれが数百万のSKUを運用している多くのクライアントが存在し、彼らのほとんどは売上高が10億USD未満です。このVMの規模を多少縮小し、使用していない時に停止することが可能かもしれませんが、Lokadではそのような選択肢は本番稼働にはほとんど適用できないと学びました。

例えば、クラウドコンピューティングプラットフォーム自体にも供給不足が生じることがあり、オンデマンドで利用可能なはずのVMがオンラインになるまでに数時間かかる場合もあります。また、これらのモデルが単に「事前学習」できると決して想定してはならず、例えば次の火曜日のように、何らかの不可避な理由で全体を最初から再学習する必要が生じる日が必ず訪れるでしょう8。さらに、本番グレードの設定には冗長性だけでなく、テスト環境、ステージング環境などの追加環境も要求されます。

ソフトウェア面では、Plasma Object Storeのようなものが必要となるのは、ディープラーニングに伴う偶発的な複雑性の典型例です。例えば、80,000SKUを週ごとに集計して104週間分としたトレーニングデータセットは、(データが適切に表現されていれば)100MB未満であるべきです。

DIMの著者は巧妙に曖昧な表現をし、(32ページで)「大量のデータ」と述べていますが、特徴抽出戦略によって元のデータフットプリントが約3桁(約1000倍)に膨張することは明らかです。なお、EC2 p3.16xlargeは少なくとも488GBのRAMを搭載しており、100MBのデータセット(膨張後は約100GB)を処理するには十分であるはずですが… 実際、私自身も同様の問題に直面した経験があります。

例えば、現実的な規模のサプライチェーンデータセットは、DIM手法によるデータ膨張後、通常1テラバイトを超えるでしょう。この場合、一般的なデータサイエンティストは、ワークステーションが64GBのRAMしか持たないため、ローカルでバグを再現することができません。それに加え、PythonとPlasmaの連携部分でさらに問題が発生する可能性があります。

上記の主要な批判に加え、二次的な懸念も存在します。例えば、序論と結論でベースラインおよびDIMの競合手法として言及されている動的計画法9は、単に劣ったベースラインに過ぎません。動的計画法は1950年代にさかのぼる古典的手法であり、最適化と学習の融合という観点からは最新の技術水準を反映していません。

確かに、サプライチェーン分野の文献はこの点で不足しているため、著者らは自らの研究分野の外から関連するベースラインを探さざるを得ません。例えば、AlphaGo Zero10は、最適化のためのディープラーニングの卓越した応用例として、ほぼ80年前の動的計画法と比べても、はるかに優れた知的ベースラインとなります。

結論として、私の批評が示唆するような厳しい評価にもかかわらず、本論文は他の多くの論文よりも優れており、批評に値するものです。微分可能プログラミングはサプライチェーンにとって非常に有用な手法であり、Lokadは何年も前からこれを活用してきましたが、その可能性はまだ尽くされていません。

DIMが示すように、探求すべきことはまだ多く存在します。微分可能シミュレーターは魅力的なアイディアであり、Amazonのようなテックジャイアントが主流のサプライチェーン理論の核心を挑戦することで、我々もまた孤立感が薄れるのを実感します。Lokadでは、何らかの方法で_montecarlo_と_autodiff_11を融合し、これらの微分可能シミュレーターにうまく適合する仕組みを構築するプロジェクトが進行中です。

今後の展開にご注目ください!

-

深層在庫管理, Dhruv Madeka, Kari Torkkola, Carson Eisenach, Anna Luo, Dean P. Foster, Sham M. Kakade, 2022年11月. ↩︎

-

エンタープライズソフトウェアのための対抗市場調査, Joannes Vermorel の講義, 2021年3月. ↩︎

-

アクション・リワード:在庫最適化のためのフレームワーク, Gaëtan Delétoile, 2021年3月. ↩︎

-

M5予測競争におけるSKUレベルでのNo1, Joannes Vermorel の講義, 2022年1月. ↩︎

-

確率的予測による小売在庫割当, Joannes Vermorel の講義, 2022年5月. ↩︎

-

供給チェーンのための定量的原則, Joannes Vermorel の講義, 2021年1月. ↩︎

-

Amazonからオンラインでレンタルされた強力なサーバーで、通常のハイエンドデスクトップワークステーションの約15倍のRAMと8基の高性能プロフェッショナルGPUを搭載している. ↩︎

-

“SCOは決して普通のソフトウェア製品ではない” in 供給チェーンのための製品指向配信, Joannes Vermorel の講義, 2020年12月. ↩︎

-

動的計画法は「構造化メモ化」と呼ばれるべきだった。低レベルのアルゴリズム技法としては依然として非常に有用であるが、この技法は強化学習と同じ領域に属するものではない。「構造化メモ化」という技法は、平衡木や疎行列といった、基本的/根本的なアルゴリズムのテクニックの領域に属する. ↩︎

-

自己対戦による汎用強化学習アルゴリズムでチェスと将棋を極める, David Silver, Thomas Hubert, Julian Schrittwieser, Ioannis Antonoglou, Matthew Lai, Arthur Guez, Marc Lanctot, Laurent Sifre, Dharshan Kumaran, Thore Graepel, Timothy Lillicrap, Karen Simonyan, Demis Hassabis, 2017年12月. ↩︎

-

montecarlo と autodiff は、Envisionにおける特別なプログラムブロックであり、それぞれランダム化プロセスと微分可能なプロセスをサポートしている。両者を組み合わせると、基本的には 微分可能シミュレーター が必要とする構成要素に非常に近いものが得られる. ↩︎